数据同步canal客户端

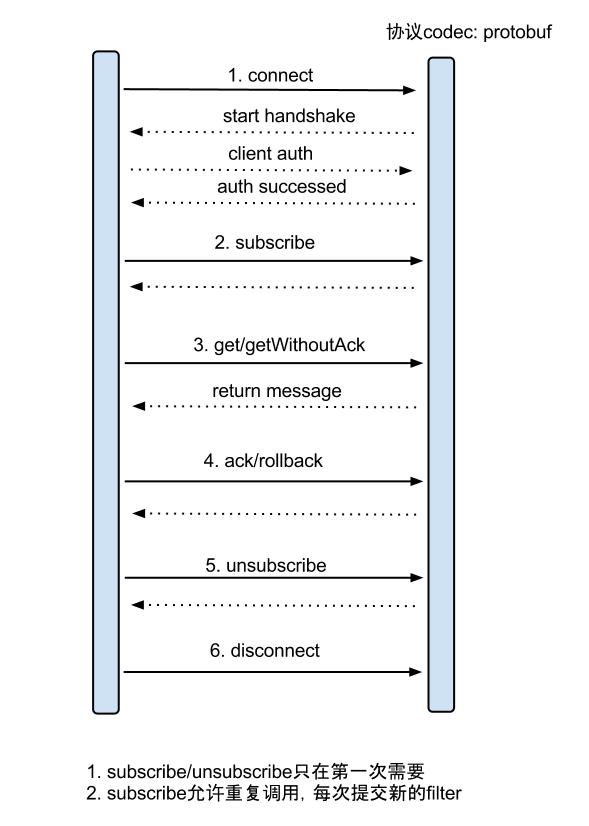

1、增量订阅、消费设计

get/ack/rollback协议介绍:

① Message getWithoutAck(int batchSize),允许指定batchSize,一次可以获取多条,每次返回的对象为Message,包含的内容为:

a. batch id 唯一标识

b. entries 具体的数据对象,对应的数据对象格式:EntryProtocol.proto

② void rollback(long batchId),顾命思议,回滚上次的get请求,重新获取数据。基于get获取的batchId进行提交,避免误操作

③ void ack(long batchId),顾命思议,确认已经消费成功,通知server删除数据。基于get获取的batchId进行提交,避免误操作

2、数据对象格式:EntryProtocol.proto

Entry

Header

logfileName [binlog文件名]

logfileOffset [binlog position]

executeTime [binlog里记录变更发生的时间戳]

schemaName [数据库实例]

tableName [表名]

eventType [insert/update/delete类型]

entryType [事务头BEGIN/事务尾END/数据ROWDATA]

storeValue [byte数据,可展开,对应的类型为RowChange]

RowChange

isDdl [是否是ddl变更操作,比如create table/drop table]

sql [具体的ddl sql]

rowDatas [具体insert/update/delete的变更数据,可为多条,1个binlog event事件可对应多条变更,比如批处理]

beforeColumns [Column类型的数组]

afterColumns [Column类型的数组] Column

index [column序号]

sqlType [jdbc type]

name [column name]

isKey [是否为主键]

updated [是否发生过变更]

isNull [值是否为null]

value [具体的内容,注意为文本]

insert只有after columns, delete只有before columns,而update则会有before / after columns数据.

3、client使用例子

3.1 创建Connector

a. 创建SimpleCanalConnector (直连ip,不支持server/client的failover机制)

CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress(AddressUtils.getHostIp(),11111), destination, "", "");

b. 创建ClusterCanalConnector (基于zookeeper获取canal server ip,支持server/client的failover机制)

CanalConnector connector = CanalConnectors.newClusterConnector("10.20.144.51:2181", destination, "", "");

c. 创建ClusterCanalConnector (基于固定canal server的地址,支持固定的server ip的failover机制,不支持client的failover机制

CanalConnector connector = CanalConnectors.newClusterConnector(Arrays.asList(new InetSocketAddress(AddressUtils.getHostIp(),11111)), destination,"", "");

如上可见,创建client connector的时候需要指定destination,即对应于一个instance,一个数据库。所以canal client和数据库是一一对应的关系。

3.2 get/ack/rollback使用

// 创建链接

CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress(canal_ip, 11111), destination, canal_username, canal_password); try { // 连接canal,获取数据

connector.connect();

connector.subscribe();

connector.rollback();

log.info("数据同步工程启动成功,开始获取数据");

while (true) { // 获取指定数量的数据

Message message = connector.getWithoutAck(1000); // 数据批号

long batchId = message.getId(); // 获取该批次数据的数量

int size = message.getEntries().size(); // 无数据

if (batchId == -1 || size == 0) { // 等待1秒后重新获取

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

log.error(e);

Thread.currentThread().interrupt();

} // 提交确认

connector.ack(batchId); // 数据存在,执行方法

} else {

try { // 处理数据

HandleData.handleEntry(message.getEntries()); // 提交确认

connector.ack(batchId);

} catch (KafkaException e) {

log.error(e); // 处理失败, 回滚数据

connector.rollback(batchId);

} catch (Exception e1) {

log.error(e1); // 提交确认

connector.ack(batchId);

}

}

}

} catch (Exception e) { log.error(e);

} finally { // 断开连接

connector.disconnect();

}

处理数据的方法封装到HandleData类中,且看handleEntry如何处理

// 获取日志行

RowChange rowChage = null;

try {

rowChage = RowChange.parseFrom(entry.getStoreValue());

} catch (Exception e) {

log.error(e);

} // 获取执行事件类型

EventType eventType = rowChage.getEventType(); // 日志打印,数据明细

log.info(String.format("================> binlog[%s:%s] , name[%s,%s] , eventType : %s", entry

.getHeader().getLogfileName(), entry.getHeader().getLogfileOffset(), entry.getHeader()

.getSchemaName(), entry.getHeader().getTableName(), eventType)); // 获取表名

String tableName = entry.getHeader().getTableName(); // 遍历日志行,执行任务

for (RowData rowData : rowChage.getRowDatasList()) {

Map<String, Object> data; // 删除操作

if (eventType == EventType.DELETE) { // 解析数据

data = DataUtils.parseData(tableName, "delete", rowData.getBeforeColumnsList()); // 插入操作

} else if (eventType == EventType.INSERT) { // 解析数据

data = DataUtils.parseData(tableName, "insert", rowData.getAfterColumnsList()); // 更新操作

} else { // 解析数据

data = DataUtils.parseData(tableName, "update", rowData.getAfterColumnsList());

} // 数据解析成功

if (data != null && data.size() > 0) { // 内容转接json格式发送

JSONObject json = JSONObject.fromObject(data);

try {

Productor.send("canal_" + tableName = "_topic", json.toString(), tableName + "|" + data.get("canal_kafka_key"));

} catch (Exception e) {

throw new KafkaException("kafka发送异常:" + e);

} log.info("数据成功发送kafka");

}

}

Entry数据被解析成Map格式数据,然后转为json字符串,发到kafka。为什么要借用消息中间件kafka呢,不用kafka可以吗?当然可以,直接写数据同步的逻辑没有问题。但是如果一个数据用到多个业务场景,势必导致一个类中有多套同步逻辑,对于后期的维护很不利,多套业务掺杂在一起势必会互相影响。合理的做法应该是业务隔离,每套业务都能接受到数据变更的消息,然后做自己需要的同步,这样就需要在数据接受和数据处理形成1对n的关系。消息中间件的消息接受和消费模型正好可以完成这个功能。

一个canal client的消息分发给多个kafka消费者消费。每个kafka消费者代表一种业务场景,架构清晰、利于维护,同时一个kafka消费者可以消费多个canal client的topic。

上面的解析数据逻辑比较简单,将list解析成map

Map<String, Object> result = new HashMap<String, Object>();

try {

int index = 0;

for (Column column : columns) {

String value = column.getIsNull() ? null : column.getValue(); // kafka在消息为10K时吞吐量达到最大

if (value != null && value.length() > 10240) {

value = value.substring(0, 10240);

}

if (index == 0) {

result.put("canal_kafka_key", value);

}

result.put(column.getName(), value);

index++;

}

result.put("operate_type", "delete"||"insert"||"update");

} catch (Exception e) {

log.error(e);

}

if (logStr.lastIndexOf(",") == logStr.length() - 1) {

logStr = logStr.substring(0, logStr.length() - 1);

}

return result;

数据同步canal客户端的更多相关文章

- 数据同步canal服务端介绍

1.下载安装包 canal&github的地址,最权威的学习canal相关知识的地方 https://github.com/alibaba/canal 在下面的wiki列表中找到AdminGu ...

- 数据同步canal服务端HA配置

canal服务端HA模式,本人并未使用过,为保证文章的完整性,从以下地址摘抄该部分内容,待以后验证及使用 https://github.com/alibaba/canal/wiki/AdminGuid ...

- 数据同步canal服务端配置mysql多主

canal服务端HA模式,本人并未使用过,为保证文章的完整性,从以下地址摘抄该部分内容,待以后验证及使用 https://github.com/alibaba/canal/wiki/AdminGuid ...

- CentOS7下rsync服务端与Windows下cwRsync客户端实现数据同步配置方法

最近需求想定期备份服务器d盘的数据到Linux服务器上面,做个笔记顺便写下遇到的问题 以前整过一个win下的cwrsync(客户端)+rsync(服务端:存储)的bat脚本 和整过一个Linux下的r ...

- Linux-非结构化数据同步-Linux下Rsync+Rsync实现非结构化增量差异数据的同步2

说明: 操作系统:CentOS 5.X 源服务器:192.168.21.129 目标服务器:192.168.21.127,192.168.21.128 目的:把源服务器上/home/www.osyun ...

- canal数据同步 客户端代码实现

1.引入相关依赖 <dependencies> <dependency> <groupId>org.springframework.boot</groupId ...

- canal数据同步目录

我们公司对于数据同步有以下需求 1.多个mysql库中有一些基础表需要数据统一,mysql跨库同步 2.mysql热数据加载到redis 3.全文检索需要mysql同步到es 4.数据变更是附属的其它 ...

- 阿里Canal框架(数据同步中间件)初步实践

最近在工作中需要处理一些大数据量同步的场景,正好运用到了canal这款数据库中间件,因此特意花了点时间来进行该中间件的的学习和总结. 背景介绍 早期,阿里巴巴B2B公司因为存在杭州和美国双机房部署,存 ...

- 基于canal的client-adapter数据同步必读指南

本文将介绍canal项目中client-adapter的使用,以及落地生产中需要考虑的可靠性.高可用与监控报警.(基于canal 1.1.4版本) canal作为mysql的实时数据订阅组件,实现了对 ...

随机推荐

- 主键(primary key)和唯一索引(unique index)区别

主键一定是唯一性索引,唯一性索引并不一定就是主键. 所谓主键就是能够唯一标识表中某一行的属性或属性组,一个表只能有一个主键,但可以有多个候选索引.因为主键可以唯一标识某一行记录,所以可以确保执行数据 ...

- 杭电acm习题分类

专注于C语言编程 C Programming Practice Problems (Programming Challenges) 杭电ACM题目分类 基础题:1000.1001.1004.1005. ...

- RabbitMQ安装教程

最近几天在学习Spring Cloud,在学习Spring Cloud Config配置刷新使用Spring Cloud Bus时,其中用到消息代理组件RabbitMQ,在安装RabbitMQ的过程查 ...

- 《Inside Solid State Device》读书笔记

这周我看了<Inside Solid State Device>一书,了解了解SSD作为软件的补充. 固态硬盘区别于将数据以磁形式存储的机械硬盘,使用了一种名为NAND的闪存颗粒,以电信号 ...

- 大数据java基础day01

day01笔记 1.==操作符和equals方法 equals方法存在于Object类中,所有类的equals方法都继承于Object 2.String类的常用方法 ①.replace()替换字符串 ...

- python中matplotlib.pyplot中cm的属性

https://matplotlib.org/gallery/color/colormap_reference.html

- Expo大作战(十四)--expo中消息推送的实现

简要:本系列文章讲会对expo进行全面的介绍,本人从2017年6月份接触expo以来,对expo的研究断断续续,一路走来将近10个月,废话不多说,接下来你看到内容,讲全部来与官网 我猜去全部机翻+个人 ...

- 前端需要掌握的后台基础:HTTP协议

什么是HTTP? 以下来自度娘最为专业的解释: 超文本传输协议(HTTP,HyperText Transfer Protocol)是互联网上应用最为广泛的一种网络协议.所有的WWW文件都必须遵守这个标 ...

- 使用SQL Server Management Studio操作replication时,要用机器名登录,不要用IP地址

如果你在使用SSMS(SQL Server Management Studio)登录SQL Server时,使用的是IP地址,如下图所示: 当你操作replication时,会报错: 从上面的错误提示 ...

- Bitlocker驱动器加密使用

前言 Bitlocker驱动器加密可以将磁盘加密,确保数据的安全.如果被加密保护的磁盘是Windows Server 2012操作系统磁盘,即使他被拿到另外一台计算机启动,除非已解锁,否则无法启动 ...