[python]沪深龙虎榜数据进一步处理,计算日后5日的涨跌幅

沪深龙虎榜数据进一步处理,计算日后5日的涨跌幅

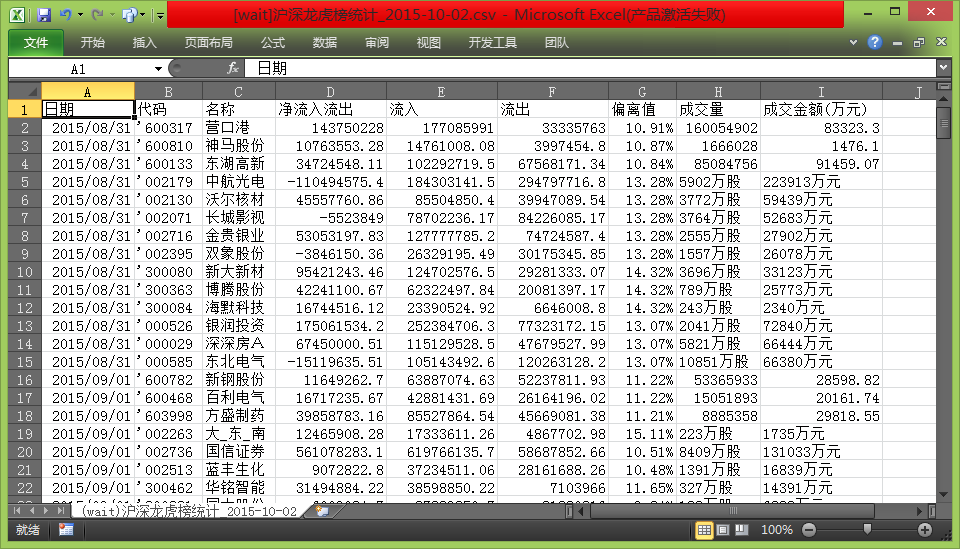

事前数据:

前面处理得到的csv文件

文件名前加入“[wait]”等待程序处理

python代码从雅虎股票历史数据api获取数据,计算后面5日的涨跌幅

雅虎数据api格式:

priceUrl = 'http://table.finance.yahoo.com/table.csv?s={%1}&d={%2}&e={%3}&f={%4}&g=d&a={%5}&b={%6}&c={%7}&ignore=.csv'

# %1:000001.sz

# END: %2:月-1 %3:日 %4:年

# STRAT: %5:月-1 %6:日 %7:年

事前数据截图:

计算后,再用excel的条件格式并另存为excel文件后截图:

代码:

#coding=utf-8 #读取'[wait]'开头的csv文件

#copyright @ WangXinsheng

#http://www.cnblogs.com/wangxinsheng/

import os

import gzip

import re

import http.cookiejar

import urllib.request

import urllib.parse

import time

import datetime def getOpener(head):

# deal with the Cookies

cj = http.cookiejar.CookieJar()

pro = urllib.request.HTTPCookieProcessor(cj)

opener = urllib.request.build_opener(pro)

header = []

for key, value in head.items():

elem = (key, value)

header.append(elem)

opener.addheaders = header

return opener def ungzip(data):

try: # 尝试解压

print('正在解压.....')

data = gzip.decompress(data)

print('解压完毕!')

except:

print('未经压缩, 无需解压')

return data #常量

header = {

#'Connection': 'Keep-Alive',

'Accept': '*/*',

'Accept-Language': 'zh-CN,zh;q=0.8',

'User-Agent': 'Mozilla/5.0 (Windows NT 6.2) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/40.0.2214.111 Safari/537.36',

'Accept-Encoding': 'gzip, deflate',

'Host': 'yahoo.com',

'Referer' : 'http://www.yahoo.com'

}

priceUrl = 'http://table.finance.yahoo.com/table.csv?\

s={%1}&d={%2}&e={%3}\

&f={%4}&g=d&a={%5}&b={%6}&c={%7}&ignore=.csv'

# %1:000001.sz

# END: %2:月-1 %3:日-1 %4:年

# STRAT: %5:月-1 %6:日 %7:年 path=r'.'

files = os.listdir(path)

files.sort()

out=[] for f in files:

if(f.startswith('[wait]') and

f.endswith('.csv')):

#读取文件

print('读取文件:'+path+'/'+f) f=open(path+'/'+f,'rt')

infos = f.readlines()

f.close() i = 0

add = False

for info in infos:

if(i==0):

i=i+1

info = info.replace('\n','')+',"一天后","二天后","三天后","四天后","五天后"\n'

out.append(info)

continue

elif(len(info.split(','))>9):

out.append(info)

continue

else:

#确认需要取的数据范围

tmp = info.split(',')

try:

timeArray = time.strptime(tmp[0], "%Y-%m-%d")

except:

timeArray = time.strptime(tmp[0], "%Y/%m/%d")

timeStamp = int(time.mktime(timeArray))

fromDay = datetime.datetime.utcfromtimestamp(timeStamp)

fromDay = fromDay + datetime.timedelta(days = 1)

endDay = fromDay + datetime.timedelta(days = 15)

code = tmp[1].replace('"','').replace("'","")

if(code.startswith('')):

code = code +'.ss'

else:

code = code +'.sz'

url = priceUrl.replace('{%1}',code).replace('{%2}',str(endDay.month-1))

url = url.replace('{%3}',str(endDay.day)).replace('{%4}',str(endDay.year))

url = url.replace('{%5}',str(fromDay.month-1)).replace('{%6}',str(fromDay.day))

url = url.replace('{%7}',str(fromDay.year))

print('抓取URL: '+url) #通过雅虎获取价格

dd = ''

try:

opener = getOpener(header)

op = opener.open(url)

data = op.read()

data = ungzip(data)

dd = data.decode()

except:

print('网络抓取失败')

out.append(info)

continue

#计算涨跌幅百分比

if(dd!=''):

dataInfo = dd.split('\n')

j=0

dayCount = 0

startPrice = 0

for x in range(len(dataInfo)-1,0,-1):

#处理数据

if(dataInfo[x]==''):

continue

#print(dataInfo[x])

if(dayCount>5):

break

di = dataInfo[x]

if(dayCount==0):

startPrice = float(di.split(',')[4])

elif(int(di.split(',')[5])!=0):

add = True

closeP = float(di.split(',')[4])

info = info.replace('\n','')+',"'+str(round((closeP-startPrice)/startPrice*100,2))+'%['+str(closeP)+']"'

#print(info)

if(dayCount==0 or int(di.split(',')[5])!=0):

dayCount=dayCount+1 if(add):

out.append(info+'\n')

#print(out)

continue

#输出

ff = open(path+'/'+f.name.replace('[wait]','[处理完了]'),'w')

for o in out:

ff.write(o)

ff.close()

print('处理完了\n文件地址:'+path+'/'+f.name.replace('[wait]','[处理完了]'))

else:

continue

[python]沪深龙虎榜数据进一步处理,计算日后5日的涨跌幅的更多相关文章

- [python]沪深龙虎榜数据导入通达信的自选板块,并标注于K线图上

将沪深龙虎榜数据导入通达信的自选板块,并标注于K线图上 原理:python读取前一次处理完的计算5日后涨跌幅输出的csv文件 文件名前加"[paint]" 安照通达信的画图文件和板 ...

- [python]数据整理,将取得的众多的沪深龙虎榜数据整一整

将昨日取得的众多的沪深龙虎榜数据整一整 提取文件夹内所有抓取下来的沪深龙虎榜数据,整理出沪深两市(含中小创)涨幅榜股票及前5大买入卖出资金净值,保存到csv文件 再手动使用数据透视表进行统计 原始数据 ...

- [python]初试页面抓取——抓取沪深股市交易龙虎榜数据

[python]抓取沪深股市交易龙虎榜数据 python 3.5.0下运行 没做自动建立files文件夹,需要手动在py文件目录下建立files文件夹后运行 #coding=utf-8 import ...

- python调用tushare获取沪深A股票资金流向数据

接口:moneyflow 描述:获取沪深A股票资金流向数据,分析大单小单成交情况,用于判别资金动向 限量:单次最大提取4000行记录,总量不限制 积分:用户需要至少1500积分才可以调取,基础积分有流 ...

- python量化之路:获取历史某一时刻沪深上市公司股票代码及上市时间

最近开始玩股票量化,由于想要做完整的股票回测,因此股票的上市和退市信息就必不可少.因为我们回测的时候必须要知道某一日期沪深股票的成分包含哪些对吧.所以我们要把沪深全部股票的上市时间.退市时间全部都爬下 ...

- python学习--大数据与科学计算第三方库简介

大数据与科学计算 库名称 简介 pycuda/opencl GPU高性能并发计算 Pandas python实现的类似R语言的数据统计.分析平台.基于NumPy和Matplotlib开发的,主要用于 ...

- python+tushare获取沪深港股通持股明细

接口:hk_hold 描述:获取沪深港股通持股明细,数据来源港交所. 限量:单次最多提取3800条记录,可循环调取,总量不限制 积分:用户积120积分可调取试用,2000积分可正常使用,单位分钟有流控 ...

- 毕设之Python爬取天气数据及可视化分析

写在前面的一些P话:(https://jq.qq.com/?_wv=1027&k=RFkfeU8j) 天气预报我们每天都会关注,我们可以根据未来的天气增减衣物.安排出行,每天的气温.风速风向. ...

- python爬取拉勾网数据并进行数据可视化

爬取拉勾网关于python职位相关的数据信息,并将爬取的数据已csv各式存入文件,然后对csv文件相关字段的数据进行清洗,并对数据可视化展示,包括柱状图展示.直方图展示.词云展示等并根据可视化的数据做 ...

随机推荐

- C++构造函数和析构函数

构造函数简介 在上一个章节我们在创建好类的对象之后,首先对它的每一个成员属性赋值之后再对它们进行输出操作,如果不赋值就输出,这些值就会是垃圾值.而为了代码的简介,一次性为所有成员属性初始化,C++的类 ...

- C#设计模式系列:状态模式(State)

1.状态模式简介 1.1>.定义 状态模式的核心思想是允许一个对象在它的内部状态改变时改变它的行为,即不同的状态对应不同的行为. 状态模式的针对性很强,当有状态变化的时候可以选择状态模式. 1. ...

- OpenCASCADE Camera

OpenCASCADE Camera eryar@163.com Abstract. OpenCASCADE introduce a new class Graphic3d_Camera for th ...

- 【转】C#语言之“string格式的日期时间字符串转为DateTime类型”的方法

方法一:Convert.ToDateTime(string) string格式有要求,必须是yyyy-MM-dd hh:mm:ss ================================== ...

- MVC5 网站开发实践 概述

目录 MVC5 网站开发实践 概述 MVC5 网站开发实践 1.建立项目 MVC5 网站开发实践 2.后台管理 MVC5 网站开发实践 2.1.管理员登陆 MVC5 网站开发实践 2.2.管理 ...

- supportRequestWindowFeature与requestWindowFeature

在Activity中去掉标题栏只需要在onCreate()中在setContentView前使用requestWindowFeature(). 在AppCompatActivity中去掉标题栏只需要在 ...

- Android动画学习(一)——Android动画系统框架简介

2015-11-09补充:Drawable Animation极有可能是Frame Animation 这几天在找工作,面试的时候被问到了Android动画,之前完全没接触过这部分,直接给懵了,当然其 ...

- 从零开始构建 Wijmo & Angular 2 小应用

中秋之际,Angular 团队发布 Angular 2 正式版,一款不错的图表控件Wijmo当天宣布支持 . Angular 2移除和替代了 Angular 1.X 中的 directives, co ...

- java中的list时间排序

最初设想使用:时间long型 private void testTimes() throws InterruptedException{ Calendar cal=Calendar.getInstan ...

- struts2学习笔记--总结获取servletAPI的几种方式

struts2的Action放弃了request,response等ServletAPI,使得在业务层上更加独立,在有时候使用struts2进行Web开发的时候,不可避免的要在action中使用ser ...