java爬虫系列第二讲-爬取最新动作电影《海王》迅雷下载地址

1. 目标

使用webmagic爬取动作电影列表信息

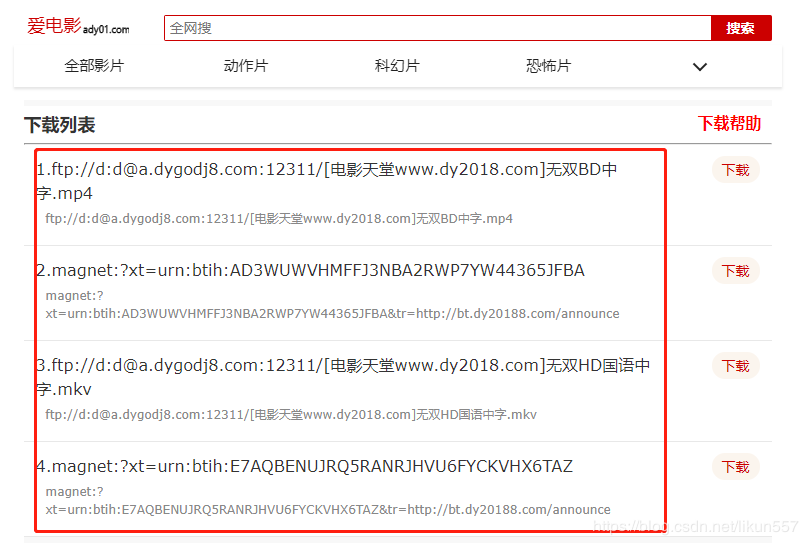

爬取电影《海王》详细信息【电影名称、电影迅雷下载地址列表】

2. 爬取最新动作片列表

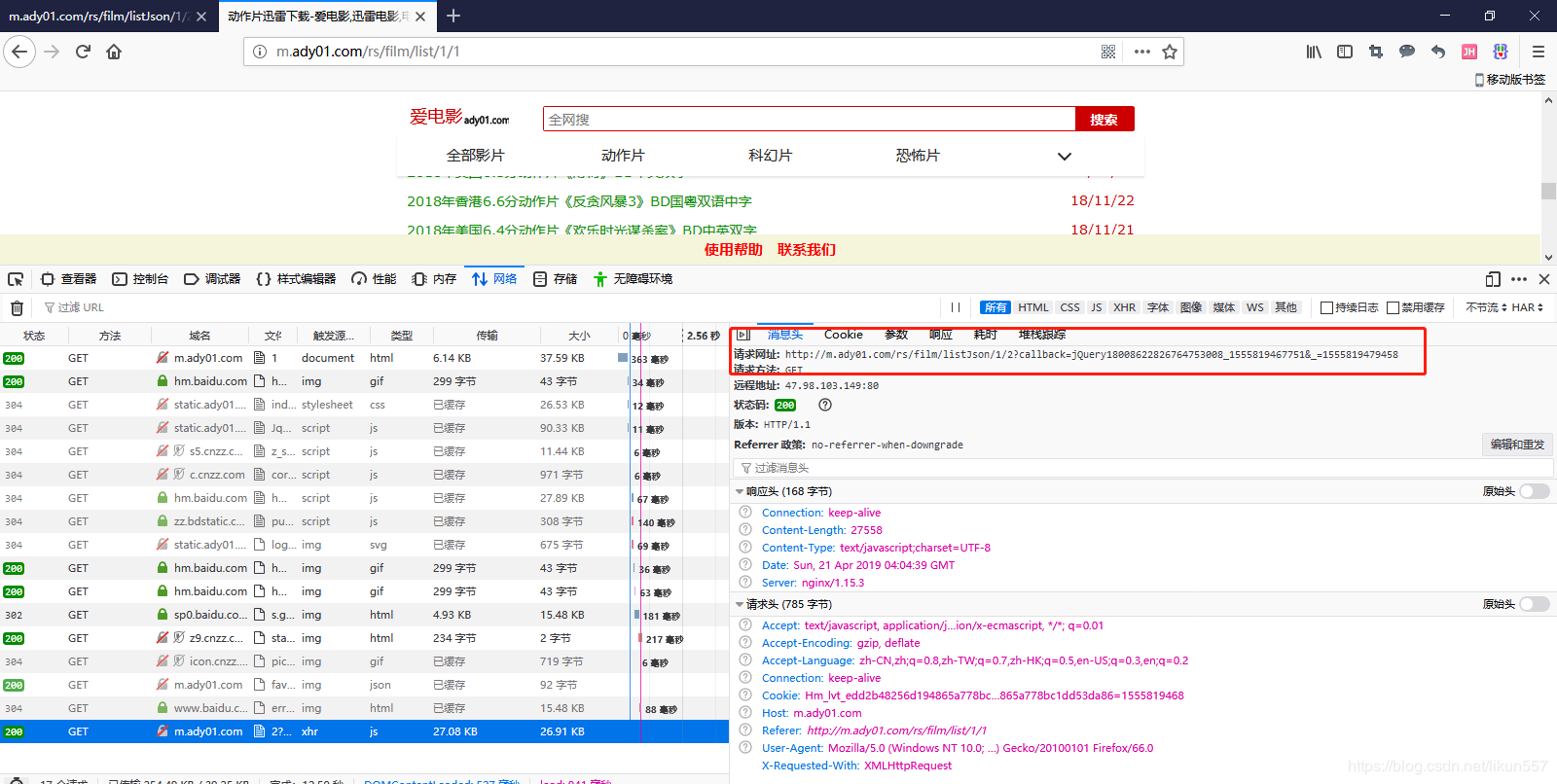

获取电影列表页面数据来源地址

访问http://m.ady01.com/rs/film/list/1/1,F12开发者模式中找到页面数据来源地址

地址是:http://m.ady01.com/rs/film/listJson/1/1

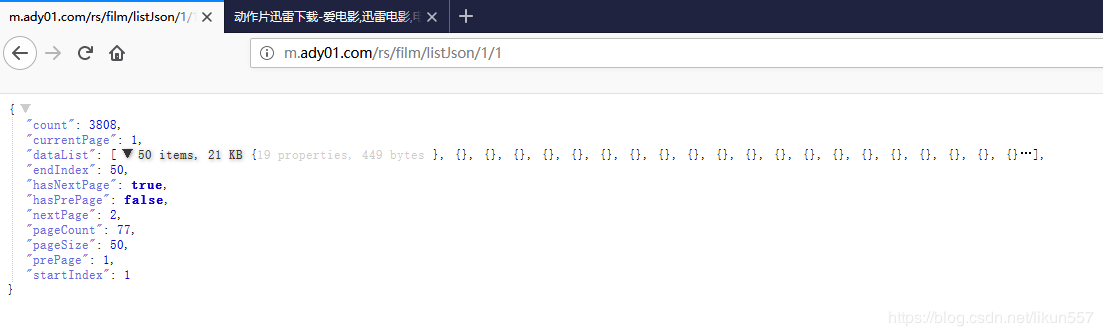

访问:http://m.ady01.com/rs/film/listJson/1/1

抓取列表信息

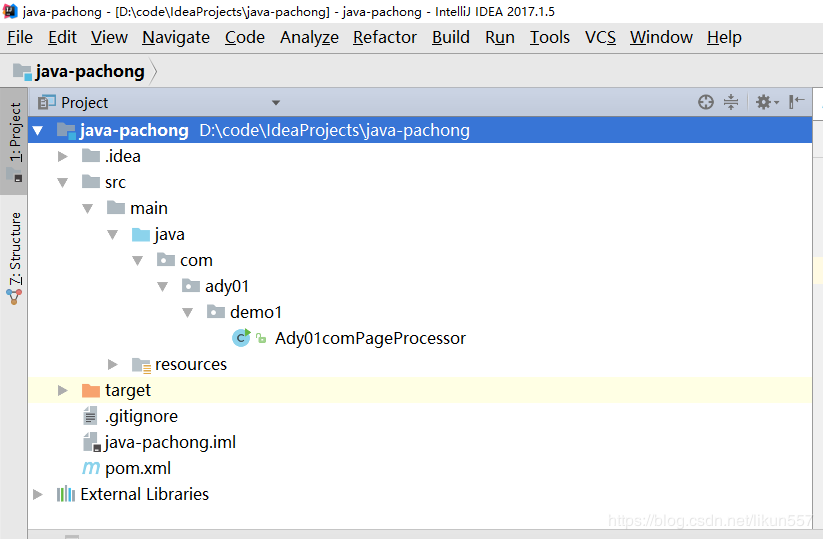

使用git拉取代码:https://gitee.com/likun_557/java-pachong 这个代码是在第一讲中创建的,需要了解的朋友可以查看第一讲的内容"《java爬虫系列第一讲-爬虫入门》"

将代码导入idea中

新建包com.ady01.demo2.filmlist,本次示例代码全部放在该包中

列表页面数据来源http://m.ady01.com/rs/film/listJson/1/1,是一个json数据

根据http://m.ady01.com/rs/film/listJson/1/1中的数据格式,我们先分析一下

- 最外层是一个分页的类

- dataList是一个集合,内部每项是一个电影资源的信息

创建com.ady01.demo2.filmlist.PageModel类,用于保存分页电影信息

package com.ady01.demo2.filmlist; import lombok.*; import java.io.Serializable;

import java.util.List; /**

* <b>description</b>:分页对象 <br>

* <b>time</b>:2019-04-21 13:46 <br>

* <b>author</b>: 微信公众号:路人甲Java,专注于java技术分享(爬虫、分布式事务、异步消息服务、任务调度、分库分表、大数据等),喜欢请关注!

*/

@Getter

@Setter

@NoArgsConstructor

@ToString

public class PageModel implements Serializable {

private static final long serialVersionUID = 1L;

/**

* 每页显示数量

*/

private long pageSize;

/**

* 当前页行的开始行的索引,如1,2,3....

*/

private long startIndex;

/**

* 当前页行的结束索引

*/

private long endIndex;

/**

* 当前页

*/

private long currentPage; /**

* 上一页索引

*/

private long prePage; /**

* 下一页索引

*/

private long nextPage; /**

* 总记录数

*/

private long count; /**

* 是否有上一页

*/

private boolean hasPrePage; /**

* 是否有下一页

*/

private boolean hasNextPage; /**

* 总页数

*/

private long pageCount; /**

* 数据集合

*/

private List<FilmModel> dataList;

}

创建com.ady01.demo2.filmlist.FilmModel类,用于保存电影信息

package com.ady01.demo2.filmlist; import lombok.Getter;

import lombok.NoArgsConstructor;

import lombok.Setter;

import lombok.ToString; import java.io.Serializable;

import java.util.Map; /**

* <b>description</b>:电影信息 <br>

* <b>time</b>:2019/4/21 12:35 <br>

* <b>author</b>:微信公众号:路人甲Java,专注于java技术分享(爬虫、分布式事务、异步消息服务、任务调度、分库分表、大数据等),喜欢请关注!

*/

@Setter

@Getter

@NoArgsConstructor

@ToString

public class FilmModel implements Serializable{

private static final long serialVersionUID = 1L;

/**

* 编号

*/

private java.lang.Long id;

/**

* 片名,完整名称,不包含无关文字

*/

private java.lang.String name;

/**

* 片名全拼音(小写),如英雄:yingxiong

*/

private java.lang.String full_spell;

/**

* 片名简拼(小写),如英雄:yx

*/

private java.lang.String short_spell;

/**

* 标题,可能和片名不同,里面有可能包含推广相关文字

*/

private java.lang.String title;

/**

* 关键词,多个之间用逗号隔开

*/

private java.lang.String keywords;

/**

* 描述

*/

private java.lang.String description;

/**

* 1:电影,2:自定义专辑系列

*/

private java.lang.Integer type;

/**

* 来源站点

*/

private java.lang.Long site_id;

/**

* 来源页面

*/

private java.lang.String source_url;

/**

* 简介,关联t_content_id

*/

private java.lang.Long content_id;

/**

* 评分

*/

private java.lang.String score;

/**

* 来源页面中资源唯一标志,用于去重使用

*/

private java.lang.String source_uid;

/**

* 创建时间

*/

private java.lang.Long create_time;

/**

* 发布时间

*/

private java.lang.Long pub_time;

/**

* 最后更新时间

*/

private java.lang.Long update_time;

/**

* 状态信息

*/

private java.lang.Integer status;

/**

* 版本号

*/

private java.lang.Long version;

/**

* 扩展数据

*/

private Map<Object, Object> extData;

}

创建列表数据采集器com.ady01.demo2.filmlist.FilmListPageProcessor

package com.ady01.demo2.filmlist; import com.ady01.demo2.filmdetail.FilmDetailModel;

import com.ady01.demo2.filmdetail.FilmDetailPageProcessor;

import com.alibaba.fastjson.JSON;

import lombok.extern.slf4j.Slf4j;

import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.Request;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.Spider;

import us.codecraft.webmagic.processor.PageProcessor; /**

* <b>description</b>:电影列表页面数据采集器 <br>

* <b>time</b>:2019/4/21 12:40 <br>

* <b>author</b>:微信公众号:路人甲Java,专注于java技术分享(爬虫、分布式事务、异步消息服务、任务调度、分库分表、大数据等),喜欢请关注!

*/

@Slf4j

public class FilmListPageProcessor implements PageProcessor { public static PageModel collector(String url) {

return new FilmListPageProcessor(url).collect().getPageModel();

} private Site site = Site.me().setRetryTimes(3).setSleepTime(100).setTimeOut(10000);

//需要采集的页面

private String url; //采集的数据

private PageModel pageModel; public FilmListPageProcessor(String url) {

this.url = url;

} public FilmListPageProcessor collect() {

Request request = new Request(url);

Spider.create(this).thread(1).addRequest(request).run();

return this;

} @Override

public void process(Page page) {

String text = page.getRawText();

log.info("列表页面数据:{}", text);

this.pageModel = JSON.parseObject(text, PageModel.class);

} @Override

public Site getSite() {

return this.site;

} public PageModel getPageModel() {

return pageModel;

} public void setPageModel(PageModel pageModel) {

this.pageModel = pageModel;

}

}

测试用例com.ady01.demo2.filmlist.FilmListPageProcessorTest

package com.ady01.demo2.filmlist; import lombok.extern.slf4j.Slf4j;

import org.junit.Test; /**

* <b>description</b>: <br>

* <b>time</b>:2019/4/21 13:59 <br>

* <b>author</b>:微信微信公众号:路人甲Java,专注于java技术分享(爬虫、分布式事务、异步消息服务、任务调度、分库分表、大数据等),喜欢请关注!,专注于java技术分享(爬虫、分布式事务、异步消息服务、任务调度、分库分表、大数据)

*/

@Slf4j

public class FilmListPageProcessorTest { @Test

public void collect() {

String url = "http://m.ady01.com/rs/film/listJson/1/1";

PageModel collector = FilmListPageProcessor.collector(url);

log.info("\n\n\n列表页面数:{}", collector);

}

}

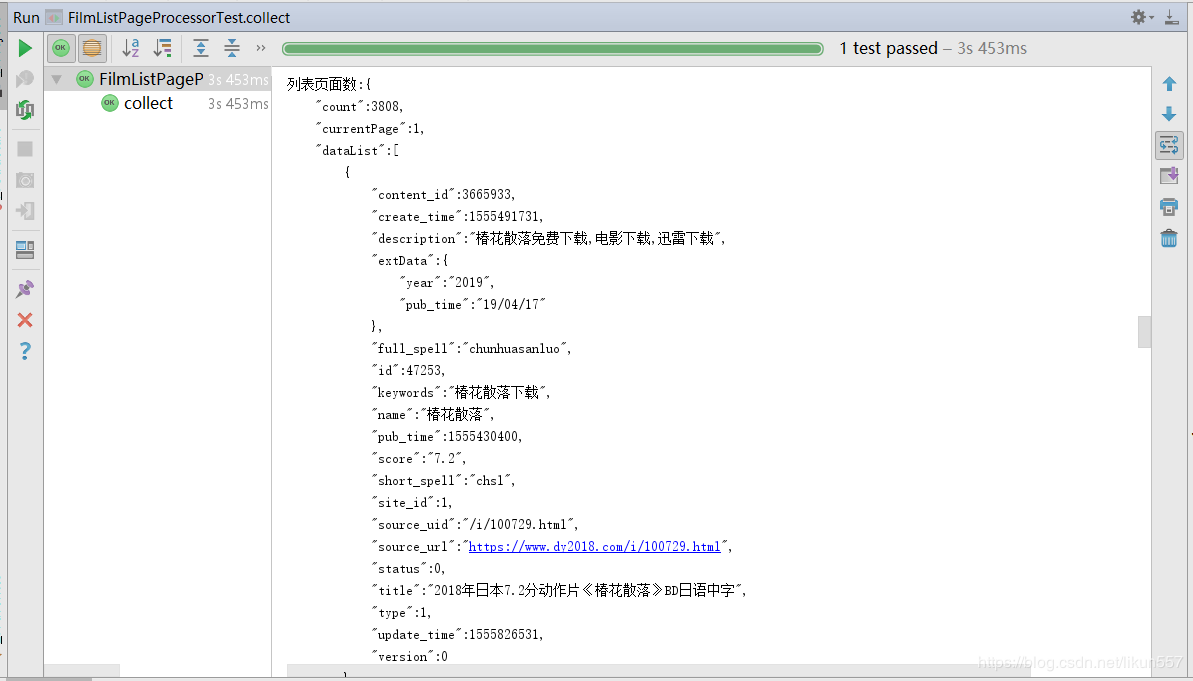

运行 com.ady01.demo2.filmlist.FilmListPageProcessorTest#collect() 方法,结果如下:

3. 爬取电影《海王》迅雷地址

我们以《海王》页面(http://m.ady01.com/rs/film/detail/46612)为例,来采集详情页的信息

需要采集的信息有:电影名称、描述信息、电影下载地址列表

创建com.ady01.demo2.filmdetail.FilmDetailModel类,用于封装电影详细信息

package com.ady01.demo2.filmdetail; import lombok.Getter;

import lombok.Setter;

import lombok.ToString; import java.io.Serializable;

import java.util.List; /**

* <b>description</b>:电影详细信息 <br>

* <b>time</b>:2019/4/21 13:18 <br>

* <b>author</b>:微信公众号:路人甲Java,专注于java技术分享(爬虫、分布式事务、异步消息服务、任务调度、分库分表、大数据等),喜欢请关注!

*/

@Setter

@Getter

@ToString

public class FilmDetailModel implements Serializable {

private static final long serialVersionUID = 1L;

/**

* 编号

*/

private java.lang.Long id;

/**

* 片名,完整名称,不包含无关文字

*/

private java.lang.String title; /**

* 下载地址列表

*/

private List<String> downList;

}

创建详情页采集器com.ady01.demo2.filmdetail.FilmDetailPageProcessor

package com.ady01.demo2.filmdetail; import lombok.extern.slf4j.Slf4j;

import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.Request;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.Spider;

import us.codecraft.webmagic.processor.PageProcessor;

import us.codecraft.webmagic.selector.Selectable; import java.util.List;

import java.util.Objects;

import java.util.stream.Collectors; /**

* <b>description</b>:电影详情页采集器,采集电影详细信息 <br>

* <b>time</b>:2019/4/21 12:40 <br>

* <b>author</b>:微信公众号:路人甲Java,专注于java技术分享(爬虫、分布式事务、异步消息服务、任务调度、分库分表、大数据等),喜欢请关注!

*/

@Slf4j

public class FilmDetailPageProcessor implements PageProcessor {

public static FilmDetailModel collector(long film_id) {

return new FilmDetailPageProcessor(film_id).collect().getFilmDetailModel();

} private Site site = Site.me().setRetryTimes(3).setSleepTime(100).setTimeOut(10000);

//电影资源id

private long film_id; //采集的数据

private FilmDetailModel filmDetailModel; public FilmDetailPageProcessor(long film_id) {

this.film_id = film_id;

} public FilmDetailPageProcessor collect() {

Request request = new Request(String.format("http://m.ady01.com/rs/film/detail/%s", this.film_id));

Spider.create(this).thread(1).addRequest(request).run();

return this;

} @Override

public void process(Page page) {

String text = page.getRawText();

log.info("列表页面数据:{}", text);

this.filmDetailModel = new FilmDetailModel();

//电影标题

String title = page.getHtml().$("span[class='film_title']","text").get();

this.filmDetailModel.setId(this.film_id);

this.filmDetailModel.setTitle(title);

//电影下载地址downList

List<Selectable> downNodes = page.getHtml().$("div.film_downurl_txt").nodes();

if (Objects.nonNull(downNodes)) {

List<String> downList = downNodes.stream().map(item -> item.$("div", "text").get()).collect(Collectors.toList());

this.filmDetailModel.setDownList(downList);

}

} @Override

public Site getSite() {

return this.site;

} public FilmDetailModel getFilmDetailModel() {

return filmDetailModel;

} public void setFilmDetailModel(FilmDetailModel filmDetailModel) {

this.filmDetailModel = filmDetailModel;

}

}

创建测试用例com.ady01.demo2.filmdetail.FilmDetailPageProcessorTest

package com.ady01.demo2.filmdetail; import com.ady01.demo2.filmlist.FilmListPageProcessor;

import com.ady01.demo2.filmlist.PageModel;

import com.ady01.util.FrameUtil;

import lombok.extern.slf4j.Slf4j;

import org.junit.Test; @Slf4j

public class FilmDetailPageProcessorTest {

@Test

public void collect() {

long film_id = 46612L;

FilmDetailModel filmDetailModel = FilmDetailPageProcessor.collector(46612L);

log.info("\n\n\n电影《海王》详情:{}", FrameUtil.json(filmDetailModel, true));

} }

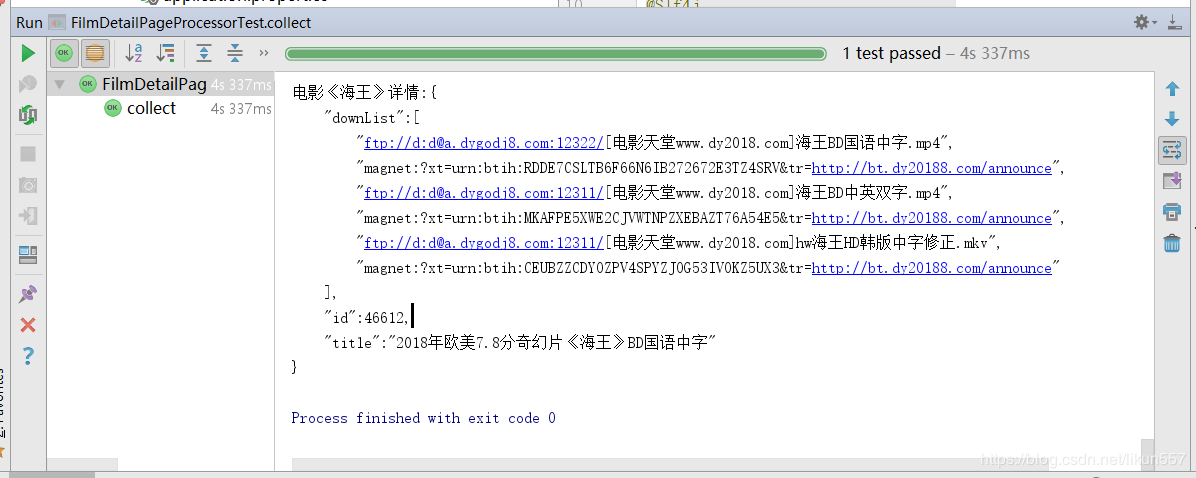

运行测试用例com.ady01.demo2.filmdetail.FilmDetailPageProcessorTest#collect()

4. 总结

- webmagic中支持xpath、$选择器的方式获取页面中的元素信息,使用非常方便,如果你们对jquery比较熟悉,可以直接使用类似于jquery选择器的语法来解析整个页面的内容;还有xpath的语法,后期会有专门讲解xpath的语法,敬请关注。

- 有问题的可以留言。

- 下期咱们一起来抓取极客时间上面的课程信息

- 爱电影这个网站就是用webmagic做的,内部包含自动采集功能,每天自动采集大量大于资源,爬虫系列完结之后,将把整个网站的源码风险给大家,资源会在公众号中发布,可以提前关注一下公众号【路人甲Java】

可以关注公众号:路人甲Java,获取年薪50万课程,获取最新文章。

java爬虫系列第二讲-爬取最新动作电影《海王》迅雷下载地址的更多相关文章

- java爬虫系列第一讲-爬虫入门

1. 概述 java爬虫系列包含哪些内容? java爬虫框架webmgic入门 使用webmgic爬取 http://ady01.com 中的电影资源(动作电影列表页.电影下载地址等信息) 使用web ...

- Java爬虫_资源网站爬取实战

对 http://bestcbooks.com/ 这个网站的书籍进行爬取 (爬取资源分享在结尾) 下面是通过一个URL获得其对应网页源码的方法 传入一个 url 返回其源码 (获得源码后,对源码进 ...

- Python爬虫系列 - 初探:爬取旅游评论

Python爬虫目前是基于requests包,下面是该包的文档,查一些资料还是比较方便. http://docs.python-requests.org/en/master/ POST发送内容格式 爬 ...

- Java爬虫——B站弹幕爬取

如何通过B站视频AV号找到弹幕对应的xml文件号 首先爬取视频网页,将对应视频网页源码获得 就可以找到该视频的av号aid=8678034 还有弹幕序号,cid=14295428 弹幕存放位置为 h ...

- java爬虫入门--用jsoup爬取汽车之家的新闻

概述 使用jsoup来进行网页数据爬取.jsoup 是一款Java 的HTML解析器,可直接解析某个URL地址.HTML文本内容.它提供了一套非常省力的API,可通过DOM,CSS以及类似于jQuer ...

- 小伙子自从学会用Python爬取岛国“动作”电影,身体一天不如一天

在互联网的世界里,正确的使用VPN看看外面的世界,多了解了解世界的发展.肉身翻墙后,感受一下外面的肮脏世界.墙内的朋友叫苦不迭,由于某些原因,VPN能用的越来越少.上周我的好朋友狗子和我哭诉说自己常用 ...

- Java爬虫框架WebMagic入门——爬取列表类网站文章

初学爬虫,WebMagic作为一个Java开发的爬虫框架很容易上手,下面就通过一个简单的小例子来看一下. WebMagic框架简介 WebMagic框架包含四个组件,PageProcessor.Sch ...

- Python爬虫系列 - 初探:爬取新闻推送

Get发送内容格式 Get方式主要需要发送headers.url.cookies.params等部分的内容. t = requests.get(url, headers = header, param ...

- java爬虫系列目录

1. java爬虫系列第一讲-爬虫入门(爬取动作片列表) 2. java爬虫系列第二讲-爬取最新动作电影<海王>迅雷下载地址 3. java爬虫系列第三讲-获取页面中绝对路径的各种方法 4 ...

随机推荐

- 微信小程序保存图片到相册

先来看小程序中的保存图片到相册的api wx.saveImageToPhotosAlbum({ filePath : "./test.png", //这个只是测试路径,没有效果 s ...

- Failed to fetch URL http://dl-ssl.google.com/android/repository/addons_list-2.xml, reason:

http://blog.csdn.net/gyming/article/details/8168166/ 最近接受的这个项目需要Android SDK Tools revision 22.6.2 or ...

- [区块链] 拜占庭将军问题 [BFT]

背景: 拜占庭将军问题很多人可能听过,但不知道具体是什么意思.那么究竟什么是拜占庭将军问题呢? 本文从最通俗的故事讲起,并对该问题进行抽象,并告诉大家拜占庭将军问题为什么在区块链领域作为一个重点研究问 ...

- 【view绘制流程】理解

一.概述 View的绘制是从上往下一层层迭代下来的.DecorView-->ViewGroup(--->ViewGroup)-->View ,按照这个流程从上往下,依次measure ...

- android渠道打包怎样实现最方便

我们都知道,Android 市场被分割成几十个应用商店渠道,程序员给渠道打包.更新是一件异常繁杂又不得不做的工作,但现在有一种快捷灵活的免费多渠道统计方式,能最大程度的提高打包效率和数据安全性. 首先 ...

- spring boot整合mybatis方式一

方式一: 导入maven依赖: <!--web依赖配置--> <dependency> <groupId>org.springframework.boot</ ...

- 设计模式 | 工厂方法模式(factory method)

定义: 定义一个用于创建对象的接口,让子类决定实例化哪一个类.工厂方法使一个类的实例化延迟到其子类. 结构:(书中图,侵删) 一个工厂的抽象接口 若干个具体的工厂类 一个需要创建对象的抽象接口 若干个 ...

- Git思维导图

EBay全程问了我关于Git的原理, 各种命令行:平常依赖Idea的图形化太严重了,今天仔细总结一下常用的工具: Git学习的链接: https://book.git-scm.com/ http: ...

- (四)图数据neo4j用户管理

1.用户管理 neo4j可通过内置函数,进行用户的创建.查看.删除. (1)用户创建; CALL dbms.security.createUser(name,password,requridchang ...

- 【原】Java学习笔记034 - 网络

package cn.temptation; import java.net.InetAddress; public class Sample01 { public static void main( ...