爬虫(十八):scrapy分布式部署

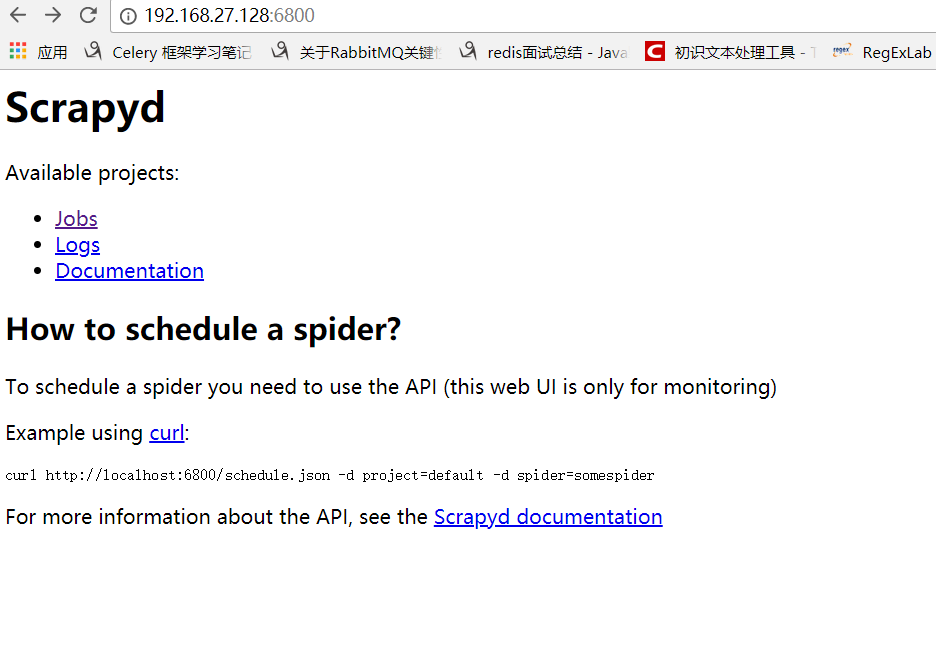

scrapy部署神器-scrapyd --》GitHub地址 --》官方文档

一:安装scrapyd

安装:pip3 install scrapyd

这里我在另外一台ubuntu linux虚拟机中同样安装scrapy以及scrapyd等包,保证所要运行的爬虫需要的包都完成安装.

在这里有个小问题需要注意,默认scrapyd启动是通过scrapyd就可以直接启动,这里bind绑定的ip地址是127.0.0.1端口是:6800,这里为了其他虚拟机访问讲ip地址设置为0.0.0.0

修改scrapyd的配置文件:sudo vim /usr/local/lib/python3.5/dist-packages/scrapyd/default_scrapyd.conf

这样配置好之后就可以在windows下访问了

二:关于部署

通过scrapyd-client进行部署操作:--》官方文档

这里的scrapyd-client主要实现以下内容:

- 把我们本地代码打包生成egg文件

- 根据我们配置的url上传到远程服务器上

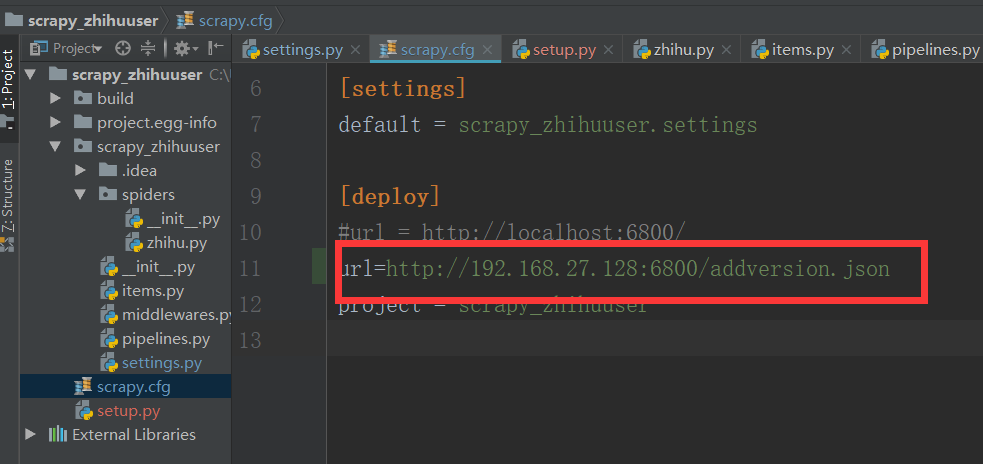

我们将我们本地的scrapy项目中scrapy.cfg配置文件进行配置:

我们其实还可以设置用户名和密码,不过这里没什么必要,只设置了url

这里设置url一定要注意:url = http://192.168.27.128:6800/addversion.json

最后的addversion.json不能少

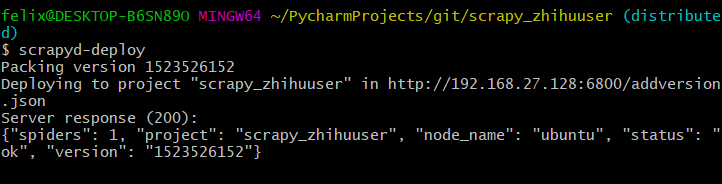

我们在本地安装pip3 install scrapyd_client,安装完成后执行:scrapyd-deploy(我是在git下执行的) 先从github下载项目

看到status:200表示已经成功看到status:200表示已经成功

三:常用API

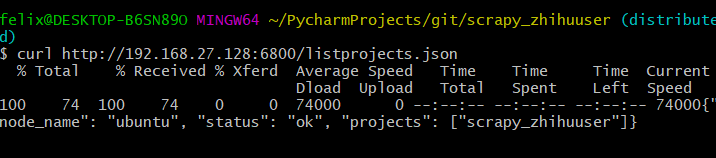

listprojects.json列出上传的项目列表

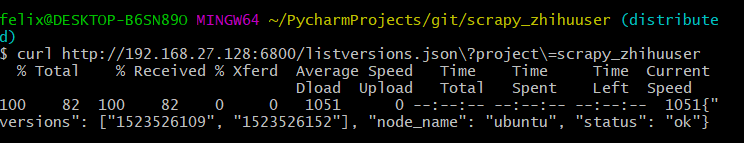

listversions.json列出有某个上传项目的版本

schedule.json远程任务的启动

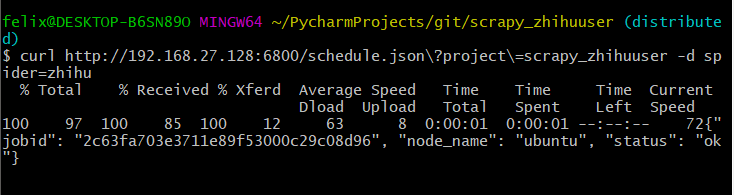

下面我们启动的三次就表示我们启动了三个任务,也就是三个调度任务来运行zhihu这个爬虫

启动后就可以在界面中看到启动的任务了:

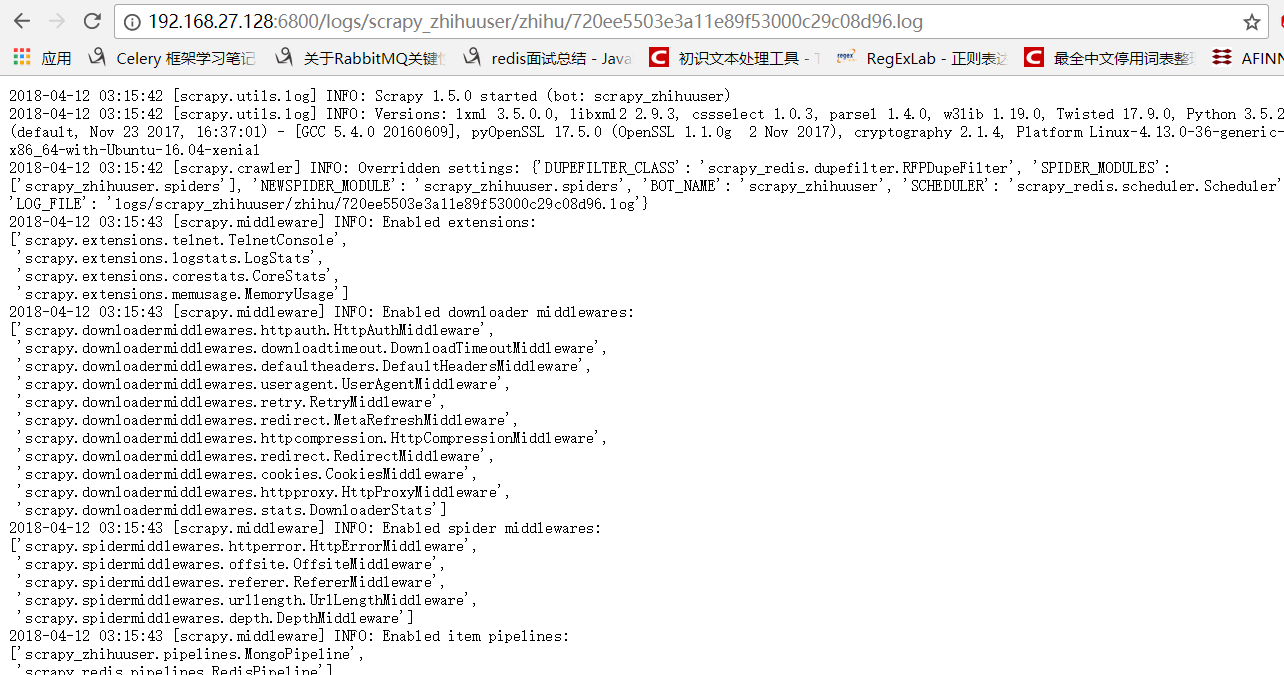

也可以看到日志:

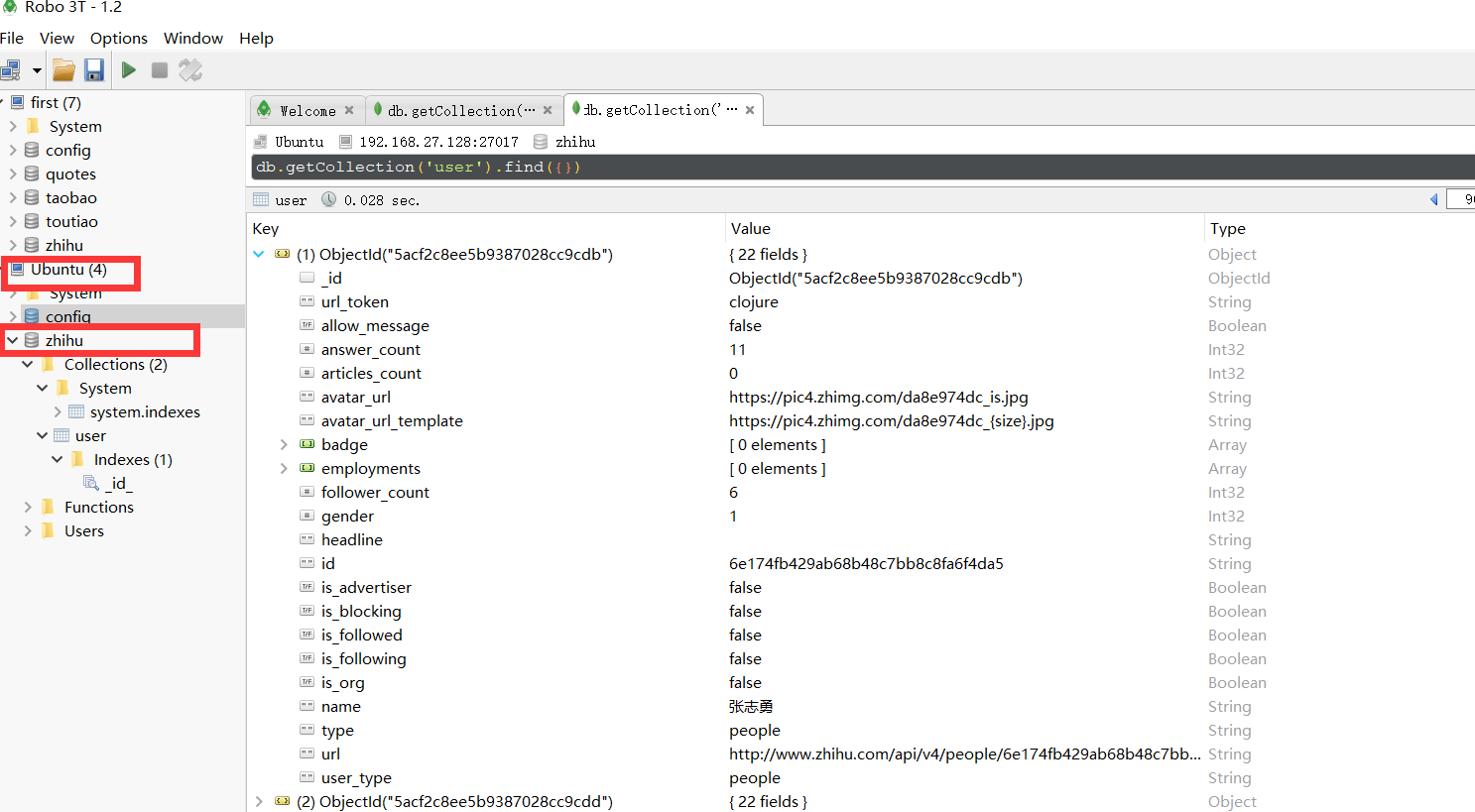

MongoDB中存入了刚才爬取的数据。

listjobs.json列出所有的jobs任务

上面是通过页面显示所有的任务,这里是通过命令获取结果

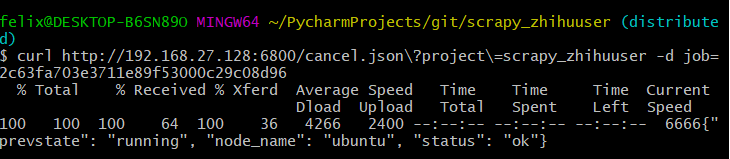

cancel.json取消所有运行的任务

这里可以将上面启动的所有jobs都可以取消:

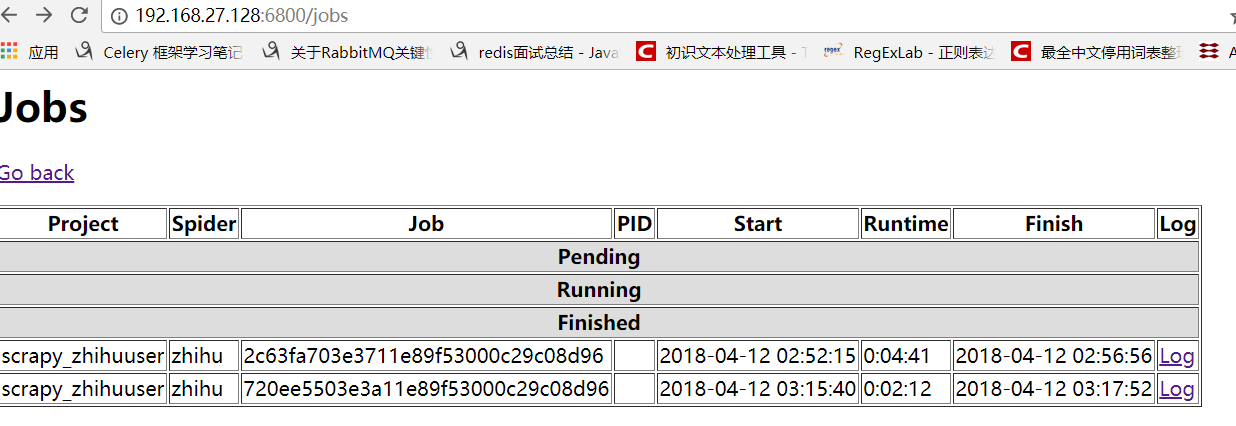

这样当我们再次通过页面查看,就可以看到所有的任务都是finshed状态:

我相信看了上面这几个方法你一定会觉得真不方便还需要输入那么长,所以有人替你干了件好事把这些API进行的再次封装:

--》GitHub地址

四:关于python-scrapyd-api

该模块可以让我们直接在python代码中进行上述那些api的操作

首先先安装该模块:pip install python-scrapyd-api

使用方法如下,这里只演示了简单的例子,其他方法其实使用很简单按照规则写就行:

from scrapyd_api import ScrapydAPI

scrapyd = ScrapydAPI('http://192.168.1.9:6800')

res = scrapyd.list_projects()

res2 = scrapyd.list_jobs('zhihu_user')

print(res)

print(res2)

Cancel a scheduled job

scrapyd.cancel('project_name', '14a6599ef67111e38a0e080027880ca6')

Delete a project and all sibling versions

scrapyd.delete_project('project_name')

Delete a version of a project

scrapyd.delete_version('project_name', 'version_name')

Request status of a job

scrapyd.job_status('project_name', '14a6599ef67111e38a0e080027880ca6')

List all jobs registered

scrapyd.list_jobs('project_name')

List all projects registered

scrapyd.list_projects()

List all spiders available to a given project

scrapyd.list_spiders('project_name')

List all versions registered to a given project

scrapyd.list_versions('project_name')

Schedule a job to run with a specific spider

scrapyd.schedule('project_name', 'spider_name')

Schedule a job to run while passing override settings

settings = {'DOWNLOAD_DELAY': 2}

Schedule a job to run while passing extra attributes to spider initialisation

scrapyd.schedule('project_name', 'spider_name', extra_attribute='value')

爬虫(十八):scrapy分布式部署的更多相关文章

- 二十八 Python分布式爬虫打造搜索引擎Scrapy精讲—cookie禁用、自动限速、自定义spider的settings,对抗反爬机制

cookie禁用 就是在Scrapy的配置文件settings.py里禁用掉cookie禁用,可以防止被通过cookie禁用识别到是爬虫,注意,只适用于不需要登录的网页,cookie禁用后是无法登录的 ...

- 十八 Python分布式爬虫打造搜索引擎Scrapy精讲—Scrapy启动文件的配置—xpath表达式

我们自定义一个main.py来作为启动文件 main.py #!/usr/bin/env python # -*- coding:utf8 -*- from scrapy.cmdline import ...

- 三十八 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)介绍以及安装

elasticsearch(搜索引擎)介绍 ElasticSearch是一个基于Lucene的搜索服务器.它提供了一个分布式多用户能力的全文搜索引擎,基于RESTful web接口.Elasticse ...

- 四十八 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能

Django实现搜索功能 1.在Django配置搜索结果页的路由映射 """pachong URL Configuration The `urlpatterns` lis ...

- Python爬虫从入门到放弃(二十一)之 Scrapy分布式部署

按照上一篇文章中我们将代码放到远程主机是通过拷贝或者git的方式,但是如果考虑到我们又多台远程主机的情况,这种方式就比较麻烦,那有没有好用的方法呢?这里其实可以通过scrapyd,下面是这个scrap ...

- Python之 爬虫(二十三)Scrapy分布式部署

按照上一篇文章中我们将代码放到远程主机是通过拷贝或者git的方式,但是如果考虑到我们又多台远程主机的情况,这种方式就比较麻烦,那有没有好用的方法呢?这里其实可以通过scrapyd,下面是这个scrap ...

- 爬虫(十八):Scrapy框架(五) Scrapy通用爬虫

1. Scrapy通用爬虫 通过Scrapy,我们可以轻松地完成一个站点爬虫的编写.但如果抓取的站点量非常大,比如爬取各大媒体的新闻信息,多个Spider则可能包含很多重复代码. 如果我们将各个站点的 ...

- 性能测试二十八:环境部署之Dubbo部署

Zookeeper部署 ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件.它是一个为分布式应用提供一 ...

- 爬虫笔记八——Scrapy实战项目

(案例一)手机App抓包爬虫 1. items.py import scrapy class DouyuspiderItem(scrapy.Item): # 存储照片的名字 nickName = sc ...

随机推荐

- SRID (空间引用识别号, 坐标系)【转】

SRID (空间引用识别号, 坐标系)-云栖社区-阿里云 Spatial Reference List -- Spatial Reference Chapter 8. PostGIS Referenc ...

- High load average analyze

https://www.tummy.com/articles/isolating-heavy-load/ https://www.tecmint.com/understand-linux-load-a ...

- 以前我对你不够好,我也很难受——CSS篇

1)文字下划线.删除线.定划线 Text-decoration:underline /*下划线*/ Text-decoration:overline /*顶划线*/ Text-decorati ...

- C++ 去掉字符串的首尾空格和全部空格

#include <iostream>#include <string>using namespace std; //去掉收尾空格string& ClearHeadTa ...

- hdu 3265 第一类斯特林数

先和第二类做一个对比 第一类Stirling数是有正负的,其绝对值是包含n个元素的集合分作k个环排列的方法数目.递推公式为, S(n,0) = 0, S(1,1) = 1. S(n+1,k) = S( ...

- 淘宝API总结

1. 淘宝客API https://open.alimama.com/?spm=a219t.11816995.1998910419.d8546b700.2a8f75a5C0NajI#!/documen ...

- Spark机器学习基础-特征工程

对连续值处理 0.binarizer/二值化 from __future__ import print_function from pyspark.sql import SparkSession fr ...

- Python基本数据类型及实例详解

Python 中的变量不需要声明.每个变量在使用前都必须赋值,变量赋值以后该变量才会被创建. 在 Python 中,变量就是变量,它没有类型,我们所说的"类型"是变量所指的内存中对 ...

- 从 ASP.NET Core 2.1 迁移到 2.2 踩坑总结

官方迁移文档:https://docs.microsoft.com/zh-cn/aspnet/core/migration/21-to-22?view=aspnetcore-2.2&tabs= ...

- 【转载】C#中使用OrderBy和ThenBy等方法对List集合进行排序

在C#的List操作中,针对List对象集合的排序我们可以使用OrderBy.OrderByDescending.ThenBy.ThenByDescending等方法按照特定的对象属性进行排序,其中O ...