Pyspark笔记一

1. pyspark读csv文件后无法显示中文

#pyspark读取csv格式时,不能显示中文

df = spark.read.csv(r"hdfs://mymaster:8020/user/root/data_spark.csv", schema=schema) #解决方法,加入encoding='gbk',即

df = spark.read.csv(r"hdfs://mymaster:8020/user/root/data_spark.csv", schema=schema, encoding='gbk')

2. 查看和修改默认编码格式

import sys

#查看默认编码格式

print(sys.getdefaultencoding()) #修改编码格式

sys.setdefaultencoding('utf8') #参考:https://blog.csdn.net/abc_321a/article/details/81945577

3. pyspark导入spark

原因:python中没有默认的sparksession,需要导入

#方法

from pyspark import SparkContext

from pyspark.sql.session import SparkSession sc = SparkContext('local', 'test')

spark = SparkSession(sc)

#之后即可以使用spark

#参考:https://blog.csdn.net/zt7524/article/details/98173650

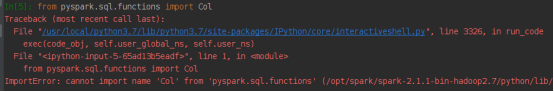

4. Pyspark引入col函数出错,ImportError: cannot import name 'Col' from 'pyspark.sql.functions'

#有人建议的是,不过我用的时候会报错

from pyspark.sql.functions import col #后来测试了一种方式可以用

from pyspark.sql import Row, column #也试过另一个参考,不过要更新pyspark包之类的,于是暂时没有用该方法,也就是安装pyspark-stubs包:pip install pyspark-stubs

#参考:http://isunix.github.io/blog/2019/06/04/pysparkzhong-yin-ru-colhan-shu-de-fang-shi/

#参考:https://stackoverflow.com/questions/40163106/cannot-find-col-function-in-pyspark

#参考:https://pypi.org/project/pyspark-stubs/

5. Exception: Python in worker has different version 2.6 than that in driver 3.7, PySpark cannot run with different minor versions.

#我是在Red hat环境下,装了两个python版本,于是报错

# 解决方案:在环境中加入想用的python版本

import os

os.environ["PYSPARK_PYTHON"]="/usr/bin/python3"

#参考:https://blog.csdn.net/wmh13262227870/article/details/77992608

6. 在Red hat上使用pip3 安装pandas的时候出错:pip is configured with locations that require TLS/SSL, however the ssl module in Python is not available.

原因:python 3.7版本会出现这个问题,是因为openssl的版本比较低

方法:必须先升级openssl,然后重新编译或者安装python,顺序要注意

升级openssl和编译python可参考:https://www.cnblogs.com/jasonLiu2018/articles/10730605.html

注意:./configure --prefix=/usr/local/python3 --with-openssl=/usr/local/openssl 是先cd到python解压后的目录,再使用的,例如解压目录是当前目录的:Python-3.7.0,则先在命令行执行 cd Python-3.7.0,进入该目录,执行上述./configure代码,/usr/local/python3是python将要安装的目录,/usr/local/openssl是openssl已安装的目录;然后直接依次:make, make install重装python。

升级openssl可参考:

https://www.cnblogs.com/caibao666/p/9698842.html

https://www.cnblogs.com/mqxs/p/9103031.html

Pyspark笔记一的更多相关文章

- PySpark笔记

spark源码位置:https://github.com/apache/spark Spark Core核心RDD及编程 什么是RDD:1.是一个抽象类不能直接使用,在子类中实现抽象方法是一个抽象类不 ...

- Spark调研笔记第4篇 - PySpark Internals

事实上.有两个名为PySpark的概念.一个是指Sparkclient内置的pyspark脚本.而还有一个是指Spark Python API中的名为pyspark的package. 本文仅仅对第1个 ...

- pyspark学习笔记

记录一些pyspark常用的用法,用到的就会加进来 pyspark指定分区个数 通过spark指定最终存储文件的个数,以解决例如小文件的问题,比hive方便,直观 有两种方法,repartition, ...

- pyspark 学习笔记

from pyspark.sql import SparkSession spark = SparkSession \ .builder \ .appName("Python Spark S ...

- 【原】Learning Spark (Python版) 学习笔记(三)----工作原理、调优与Spark SQL

周末的任务是更新Learning Spark系列第三篇,以为自己写不完了,但为了改正拖延症,还是得完成给自己定的任务啊 = =.这三章主要讲Spark的运行过程(本地+集群),性能调优以及Spark ...

- Spark.ML之PipeLine学习笔记

地址: http://spark.apache.org/docs/2.0.0/ml-pipeline.html Spark PipeLine 是基于DataFrames的高层的API,可以方便用户 ...

- Spark调研笔记第2篇 - 怎样通过Sparkclient向Spark提交任务

在上篇笔记的基础上,本文介绍Sparkclient的基本配置及Spark任务提交方式. 1. Sparkclient及基本配置 从Spark官网下载的pre-built包中集成了Sparkclient ...

- Spark 基本函数学习笔记一

Spark 基本函数学习笔记一¶ spark的函数主要分两类,Transformations和Actions. Transformations为一些数据转换类函数,actions为一些行动类函数: ...

- 大数据学习——spark笔记

变量的定义 val a: Int = 1 var b = 2 方法和函数 区别:函数可以作为参数传递给方法 方法: def test(arg: Int): Int=>Int ={ 方法体 } v ...

随机推荐

- new (std::nothrow) 与 new

普通new一个异常的类型std::bad_alloc.这个是标准适应性态. 在早期C++的舞台上,这个性态和现在的非常不同:new将返回0来指出一个失败,和malloc()非常相似. 在内存不足时,n ...

- js中的eval方法

eval(string) eval函数接收一个参数string,如果string不是字符串,则直接返回string.否则执行string语句.如果string语句执行结果是一个值,则返回此值,否则返回 ...

- JS扩展Array.prototype引发的问题及解决方法

遇到的问题 一上班收到个bug,写的表单联动插件在ie里面会出现js源码,当时有点意外,从没出现过这问题. 问题的原由 为什么会出现一个function呢?其它调用的插件的页面为什么没有这问题? 控制 ...

- DB2 索引(2)

最近研究了一点DB2索引相关的东西,做一个总结: (1)在作为主键的列上,强制该列的唯一性和组织表中数据的排列结构: (2)在经常用连接的列(join)上建索引,这些列主要是一些外键,可以加快连接的速 ...

- C++标准模板库STL算法与自适应容器(栈和队列)

参考<21天学通C++>第23与第24章节,对STL算法与自适应容器进行介绍. 实际上在前面的STL顺序容器.关联容器进行介绍时或多或少引用到了一些STL算法中的模板函数.而自适应容器是在 ...

- 微信小程序中的事件绑定

前言: 微信小程序中的事件绑定和Vue中的事件绑定其实有很多的相似之处,所以如果有过Vue相关的经验,学起来的话还是比较容易的. js代码: // 页面级的js文件必须调用Page函数来注册页面, / ...

- QuickTime专业版 pro 注册码

打开QuickTime Player下拉编辑菜单--选偏好设置--注册 Name: Dawn M Fredette Key: 4UJ2-5NLF-HFFA-9JW3-X2KV 重新启动 QuickTi ...

- pytorch1.0进行Optimizer 优化器对比

pytorch1.0进行Optimizer 优化器对比 import torch import torch.utils.data as Data # Torch 中提供了一种帮助整理数据结构的工具, ...

- WUSTOJ 1336: Lucky Boy(Java)博弈

题目链接:1336: Lucky Boy 参考博客:LUCKY BOY 博弈--HandsomeHow Description Recently, Lur have a good luck. He i ...

- hadoop 节点退役和服役

节点的服役和退役(hdfs)---------------------- 黑白名单的组合情况-------------------------include //dfs.includeexclude ...