scrapy操作mysql/批量下载图片

1.操作mysql

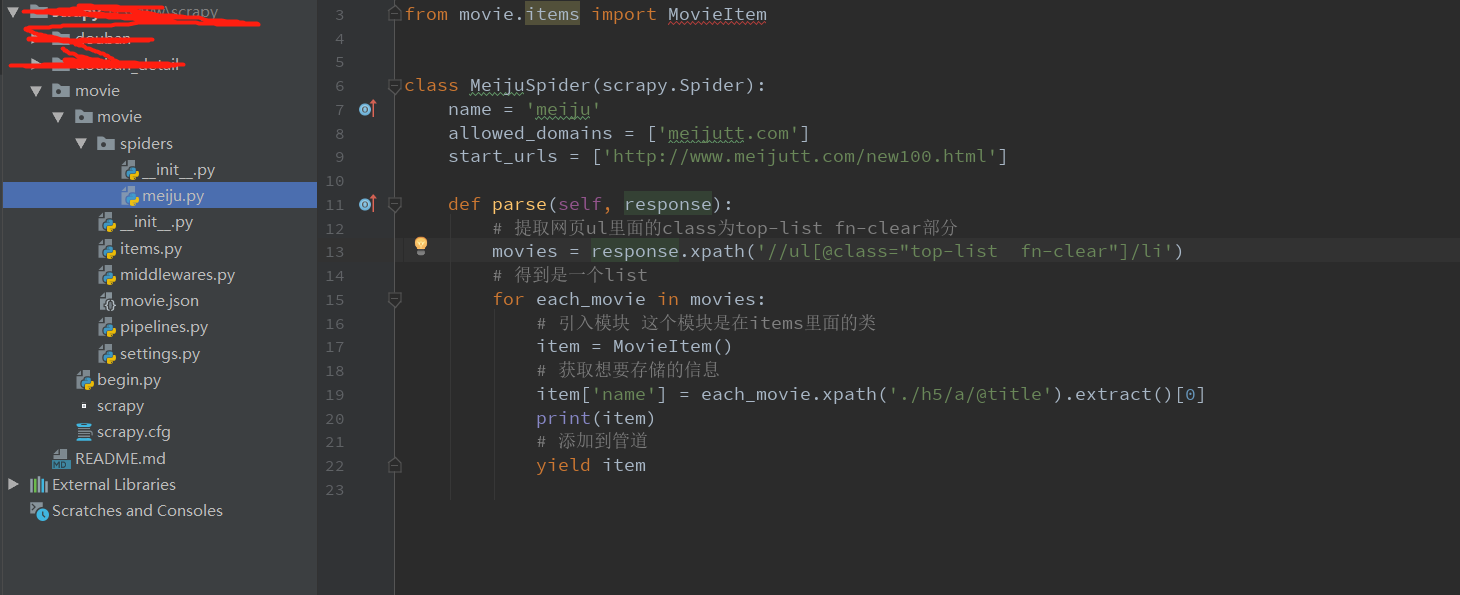

items.py

meiju.py

3.piplines.py

4.settings.py

--------------------------------------------------------------------------------------------------------------------------

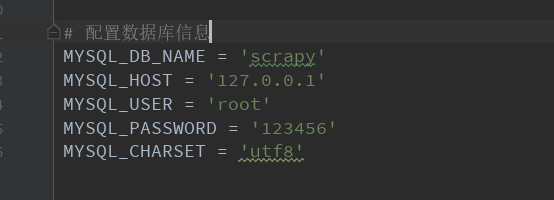

批量下载图片。分类

网站:https://movie.douban.com/top250

需求:按电影分类,获取里面的演职员图片。并存入各自的分类当中

效果:

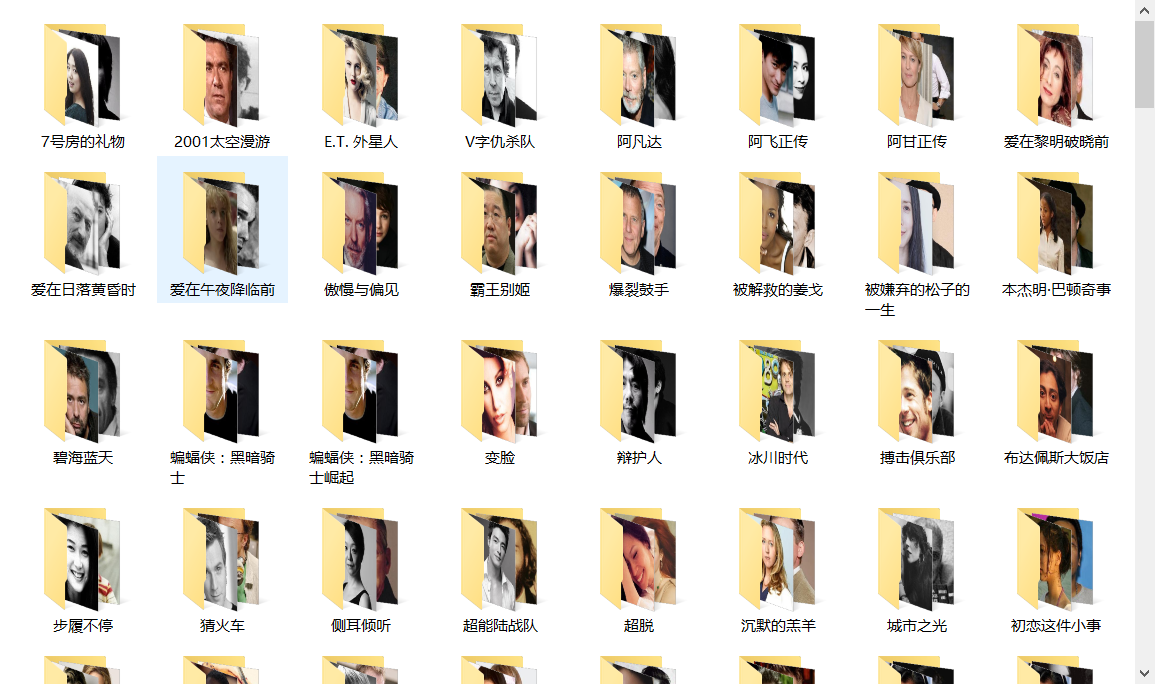

代码

因为我们主要工作是下载。不存入数据库。存入数据库的话可以参考上面部分。

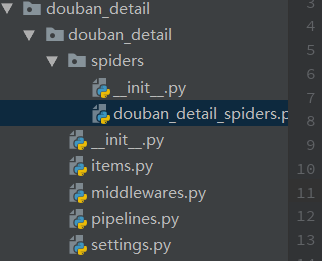

现在只需要修改spiders/xxx_spiders.py文件。就是开启项目适合生成的文件

我的是这个

以下是这个文件夹的代码。

# -*- coding: utf-8 -*-

import scrapy

import os

import urllib.request

import re class DoubanDetailSpidersSpider(scrapy.Spider):

name = 'douban_detail_spiders'

allowed_domains = ['movie.douban.com']

start_urls = ['https://movie.douban.com/top250'] file_path = "D:\\www\\scrapy\\douban_detail\\image\\" def parse(self, response):

movie_list = response.xpath("//div[@class='article']//ol[@class='grid_view']/li") for i_item in movie_list:

# 封面图

master_pic_path = i_item.xpath(".//div[@class='pic']//a//img/@src").extract_first()

# 文件名

name = i_item.xpath(".//div[@class='info']//a/span[1]/text()").extract_first()

# 创建文件夹

self.fileIsBeing(name)

# 详情连接

detail_url = i_item.xpath(".//div[@class='hd']//a/@href").extract_first()

# 获取详情里面内容

# detail_link = response.xpath(".//div[@class='hd']//a/@href").extract()

# for link in detail_link:

# 这里是进入二级页面操作,在for循环里面。

yield scrapy.Request(detail_url, meta={'name': name}, callback=self.detail_parse, dont_filter=True) # 解析下一页

next_link = response.xpath("//div[@class='article']//div[@class='paginator']//span[@class='next']/link/@href").extract()

print(next_link)

if next_link:

next_link = next_link[0]

yield scrapy.Request("https://movie.douban.com/top250" + next_link, callback=self.parse) # 判断文件是否存在

# 不存在则创建

def fileIsBeing(self, name):

path = self.file_path + name

bool = os.path.exists(path)

if not(bool):

os.mkdir(path)

return path # 解析详情里面的数据 获取二级页面内容操作。主要获取图片

def detail_parse(self, response):

name = response.meta['name']

print(name)

movie_prople_list = response.xpath("//div[@id='celebrities']//ul[@class='celebrities-list from-subject __oneline']//li")

for i_mov_item in movie_prople_list:

background_img = i_mov_item.xpath(".//div[@class='avatar']/@style").extract_first()

user_name = i_mov_item.xpath(".//div[@class='info']//a/@title").extract_first()

img_file_name = "%s.jpg" % user_name # 工作人员

img_url = self.txt_wrap_by('(', ')', background_img) # 图片地址

print(img_file_name)

file_path = os.path.join(self.file_path+name, img_file_name)

urllib.request.urlretrieve(img_url, file_path)

# print(img_file_name) # 截取字符串中间部分

def txt_wrap_by(self, start_str, end, html):

start = html.find(start_str)

if start >= 0:

start += len(start_str)

end = html.find(end, start)

if end >= 0:

return html[start:end].strip()

码云:https://gitee.com/chenrunxuan/scrapy

scrapy操作mysql/批量下载图片的更多相关文章

- scrapy批量下载图片

# -*- coding: utf-8 -*- import scrapy from rihan.items import RihanItem class RihanspiderSpider(scra ...

- 第三百二十五节,web爬虫,scrapy模块标签选择器下载图片,以及正则匹配标签

第三百二十五节,web爬虫,scrapy模块标签选择器下载图片,以及正则匹配标签 标签选择器对象 HtmlXPathSelector()创建标签选择器对象,参数接收response回调的html对象需 ...

- 【Python】nvshens按目录批量下载图片爬虫1.00(单线程版)

# nvshens按目录批量下载图片爬虫1.00(单线程版) from bs4 import BeautifulSoup import requests import datetime import ...

- javaWeb 批量下载图片

批量下载网页图片 CreateTime--2017年9月26日15:40:43 Author:Marydon 所用技术:javascript.java 测试浏览器:chrome 开发工具:Ecli ...

- C++ 根据图片url 批量 下载图片

最近需要用到根据图片URL批量下载到本地的操作.查找了相关资料,记录在这儿. 1.首先在CSV文件中提取出url ifstream fin("C:\\Users\\lenovo\\Deskt ...

- 用python批量下载图片

一 写爬虫注意事项 网络上有不少有用的资源, 如果需要合理的用爬虫去爬取资源是合法的,但是注意不要越界,前一阶段有个公司因为一个程序员写了个爬虫,导致公司200多个人被抓,所以先进入正题之前了解下什么 ...

- python——批量下载图片

前言 批量下载网页上的图片需要三个步骤: 获取网页的URL 获取网页上图片的URL 下载图片 例子 from html.parser import HTMLParser import urllib.r ...

- 利用Node 搭配uglify-js压缩js文件,批量下载图片到本地

Node的便民技巧-- 压缩代码 下载图片 压缩代码 相信很多前端的同学都会在上线前压缩JS代码,现在的Gulp Webpack Grunt......都能轻松实现.但问题来了,这些都不会,难道就要面 ...

- scrapy中的ImagePipeline下载图片到本地、并提取本地的保存地址

通过scrapy内置到ImagePipeline下载图片到本地 在settings中打开 ITEM_PIPELINES的注释,并在这里面加入 'scrapy.pipelines.images.Imag ...

随机推荐

- 虚拟DOM解析及其在框架里的应用

虚拟DOM解析及其在框架里的应用 浏览器是怎样解析HTML并且绘出整个页面的 上图为webkit引擎浏览器的处理流程,如上图大致分为4大步: 第一步,HTML解析器分析html,构建一颗DOM树: 第 ...

- rcu的学习记录

crash> p rcu_sched_state.node[0] $13 = { lock = { raw_lock = { slock = 748760225 } }, gpnum = 211 ...

- linux centos7开启防火墙端口

firewall-cmd --zone=public --add-port=3306/tcp --permanent firewall-cmd --reload

- ORA-01950: no privileges on tablespace 'USERS'-- 解决办法

ORA-01950: no privileges on tablespace 'USERS' 原因: 在表空间 "USERS" 无权限 解决办法: 用户登录,查看当前用户所 ...

- 记一次 .NET 某金融企业 WPF 程序卡死分析

一:背景 1. 讲故事 前段时间遇到了一个难度比较高的 dump,经过几个小时的探索,终于给找出来了,在这里做一下整理,希望对大家有所帮助,对自己也是一个总结,好了,老规矩,上 WinDBG 说话. ...

- KingbaseES 如何把一个schema下的所有对象访问权限授权给其他用户

用户需求:新建一个用户 B,需要能够查询A用户的所有表,并且对以后新建的表也要有select权限. 问题分析:对于现有的表可以通过动态sql批量进行授权,但是未来新建的表要如何进行授权呢? 查询了帮助 ...

- 如何使用Arthas定位问题

在我们日常的工作中,经常会遇到一些线上才会遇到的问题.Arthas无疑是我们在工作中,定位线上问题的神奇.下面,我将介绍一下我们在工作中经常用到的一些功能. dashboard 首先我们可以通过das ...

- Stream流式计算

Stream流式计算 集合/数据库用来进行数据的存储 而计算则交给流 /** * 现有5个用户,用一行代码 ,一分钟按以下条件筛选出指定用户 *1.ID必须是偶数 *2.年龄必须大于22 *3.用户名 ...

- 学习完nio的一个小笔记吧

这是一个nio网络通信服务端的demo,主要就学习了selector的一些用法,以及它里面的事件类型 selector是对nio的一个优化,它能保证既能高效处理线程中的事件,又能保证线程不会一直占用c ...

- Nginx相关模块学习使用实践指南

转载自:https://www.bilibili.com/read/cv16150654?spm_id_from=333.999.0.0 0x01 Nginx 常用模块使用实践 官方模块使用手册:ht ...