使用LabVIEW实现基于pytorch的DeepLabv3图像语义分割

前言

今天我们一起来看一下如何使用LabVIEW实现语义分割。

一、什么是语义分割

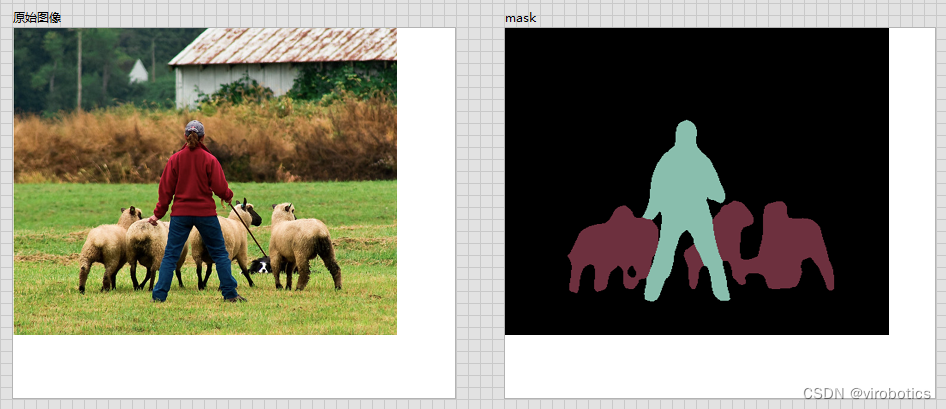

图像语义分割(semantic segmentation),从字面意思上理解就是让计算机根据图像的语义来进行分割,例如让计算机在输入下面左图的情况下,能够输出右图。语义在语音识别中指的是语音的意思,在图像领域,语义指的是图像的内容,对图片意思的理解,比如下图的语义就是一个人牵着四只羊;分割的意思是从像素的角度分割出图片中的不同对象,对原图中的每个像素都进行标注,比如下图中浅黄色代表人,蓝绿色代表羊。语义分割任务就是将图片中的不同类别,用不同的颜色标记出来,每一个类别使用一种颜色。常用于医学图像,卫星图像,无人车驾驶,机器人等领域。

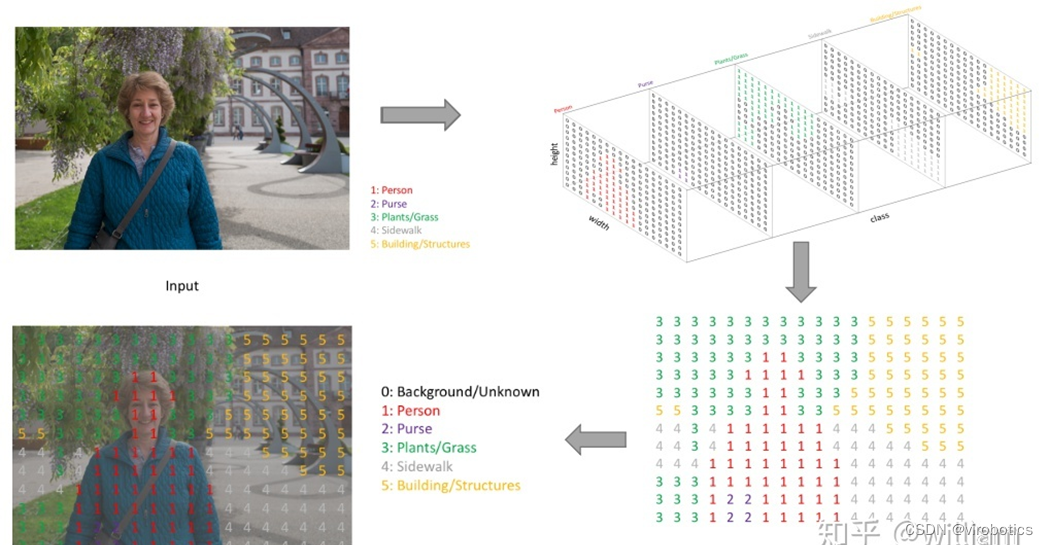

如何做到将像素点上色呢?

语义分割的输出和图像分类网络类似,图像分类类别数是一个一维的one hot 矩阵。例如:三分类的[0,1,0]。语义分割任务最后的输出特征图是一个三维结构,大小与原图类似,其中通道数是类别数,每个通道所标记的像素点,是该类别在图像中的位置,最后通过argmax 取每个通道有用像素 合成一张图像,用不同颜色表示其类别位置。 语义分割任务其实也是分类任务中的一种,他不过是对每一个像素点进行细分,找到每一个像素点所述的类别。 这就是语义分割任务啦~

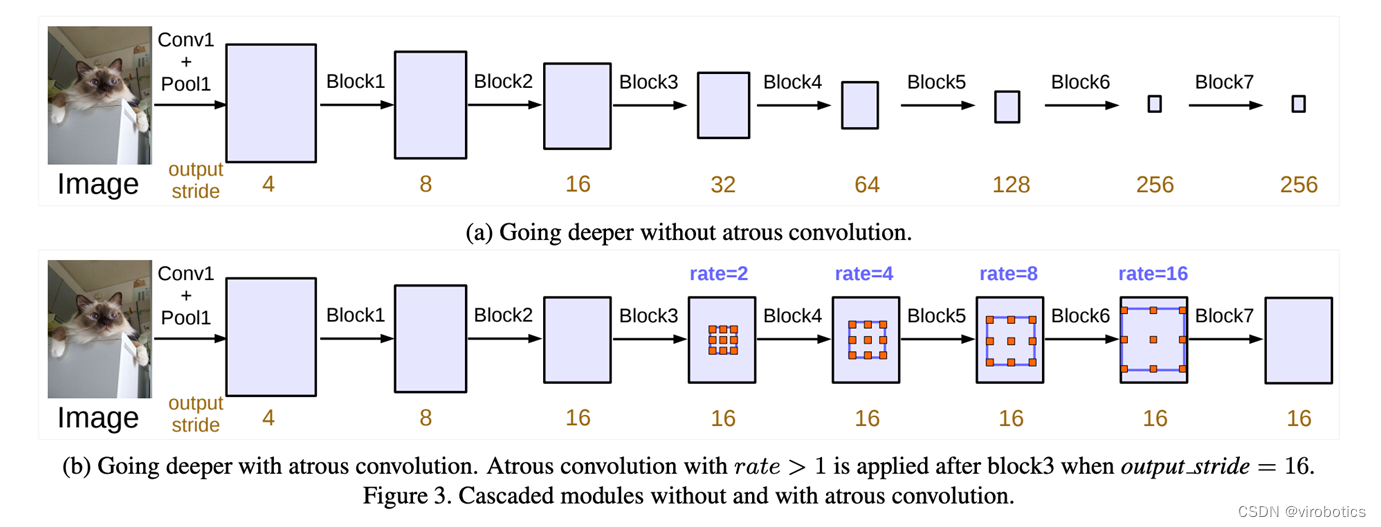

二、什么是deeplabv3

DeepLabv3是一种语义分割架构,它在DeepLabv2的基础上进行了一些修改。为了处理在多个尺度上分割对象的问题,设计了在级联或并行中采用多孔卷积的模块,通过采用多个多孔速率来捕获多尺度上下文。此外,来自 DeepLabv2 的 Atrous Spatial Pyramid Pooling模块增加了编码全局上下文的图像级特征,并进一步提高了性能。

三、LabVIEW调用DeepLabv3实现图像语义分割

1、模型获取及转换

安装pytorch和torchvision

获取torchvision中的模型:deeplabv3_resnet101(我们获取预训练好的模型):

original_model = models.segmentation.deeplabv3_resnet101(pretrained=True)

转onnx

1 def get_pytorch_onnx_model(original_model):

2 # define the directory for further converted model save

3 onnx_model_path = dirname

4 # define the name of further converted model

5 onnx_model_name = "deeplabv3_resnet101.onnx"

6

7 # create directory for further converted model

8 os.makedirs(onnx_model_path, exist_ok=True)

9

10 # get full path to the converted model

11 full_model_path = os.path.join(onnx_model_path, onnx_model_name)

12

13 # generate model input

14 generated_input = Variable(

15 torch.randn(1, 3, 448, 448)

16 )

17

18 # model export into ONNX format

19 torch.onnx.export(

20 original_model,

21 generated_input,

22 full_model_path,

23 verbose=True,

24 input_names=["input"],

25 output_names=["output",'aux'],

26 opset_version=11

27 )

28

29 return full_model_path

完整获取及模型转换python代码如下:

1 import os

2 import torch

3 import torch.onnx

4 from torch.autograd import Variable

5 from torchvision import models

6 import re

7

8 dirname, filename = os.path.split(os.path.abspath(__file__))

9 print(dirname)

10

11 def get_pytorch_onnx_model(original_model):

12 # define the directory for further converted model save

13 onnx_model_path = dirname

14 # define the name of further converted model

15 onnx_model_name = "deeplabv3_resnet101.onnx"

16

17 # create directory for further converted model

18 os.makedirs(onnx_model_path, exist_ok=True)

19

20 # get full path to the converted model

21 full_model_path = os.path.join(onnx_model_path, onnx_model_name)

22

23 # generate model input

24 generated_input = Variable(

25 torch.randn(1, 3, 448, 448)

26 )

27

28 # model export into ONNX format

29 torch.onnx.export(

30 original_model,

31 generated_input,

32 full_model_path,

33 verbose=True,

34 input_names=["input"],

35 output_names=["output",'aux'],

36 opset_version=11

37 )

38

39 return full_model_path

40

41

42 def main():

43 # initialize PyTorch ResNet-101 model

44 original_model = models.segmentation.deeplabv3_resnet101(pretrained=True)

45

46 # get the path to the converted into ONNX PyTorch model

47 full_model_path = get_pytorch_onnx_model(original_model)

48 print("PyTorch ResNet-101 model was successfully converted: ", full_model_path)

49

50

51 if __name__ == "__main__":

52 main()

我们会发现,基于pytorch的DeepLabv3模型获取和之前的mask rcnn模型大同小异。

2、关于deeplabv3_resnet101

我们使用的模型是:deeplabv3_resnet101,该模型返回两个张量,与输入张量相同,但有21个classes。输出[“out”]包含语义掩码,而输出[“aux”]包含每像素的辅助损失值。在推理模式中,输出[‘aux]没有用处。因此,输出“out”形状为(N、21、H、W)。我们在转模型的时候设置H,W为448,N一般为1;

我们的模型是基于VOC2012数据集 VOC2012数据集分为20类,包括背景为21类,分别如下:

人 :人

动物:鸟、猫、牛、狗、马、羊

车辆:飞机、自行车、船、巴士、汽车、摩托车、火车

室内:瓶、椅子、餐桌、盆栽植物、沙发、电视/监视器

3、LabVIEW opencv dnn调用 deeplabv3 实现图像语义分割(deeplabv3_opencv.vi)

deeplabv3模型可以使用OpenCV dnn去加载的,也可以使用onnxruntime加载推理,所以我们分两种方式给大家介绍LabVIEW调用deeplabv3实现图像语义分割。

opencv dnn 调用onnx模型并选择

图像预处理 最终还是采用了比较中规中矩的处理方式

执行推理

后处理并实现实例分割 因为后处理内容较多,所以直接封装为了一个子VI, deeplabv3_postprocess.vi,因为Labview没有专门的切片函数,所以会稍慢一些,所以接下来还会开发针对后处理和矩阵有关的函数,加快处理结果。

整体的程序框架如下:

语义分割结果如下:

4、LabVIEW onnxruntime调用 deeplabv3实现图像语义分割 (deeplabv3_onnx.vi)

整体的程序框架如下:

语义分割结果如下:

5、LabVIEW onnxruntime调用 deeplabv3 使用TensorRT加速模型实现图像语义分割(deeplabv3_onnx_camera.vi)

如上图所示,可以看到可以把人和背景完全分割开来,使用TensorRT加速推理,速度也比较快。

四、deeplabv3训练自己的数据集

训练可参考:https://github.com/pytorch/vision

总结

以上就是今天要给大家分享的内容。大家可关注微信公众号: VIRobotics,回复关键字:DeepLabv3图像语义分割源码 获取本次分享内容的完整项目源码及模型。

如果有问题可以在评论区里讨论,提问前请先点赞支持一下博主哦,如您想要探讨更多关于LabVIEW与人工智能技术,欢迎加入我们的技术交流群:705637299。

如果文章对你有帮助,欢迎关注、点赞、收藏

使用LabVIEW实现基于pytorch的DeepLabv3图像语义分割的更多相关文章

- 笔记:基于DCNN的图像语义分割综述

写在前面:一篇魏云超博士的综述论文,完整题目为<基于DCNN的图像语义分割综述>,在这里选择性摘抄和理解,以加深自己印象,同时达到对近年来图像语义分割历史学习和了解的目的,博古才能通今!感 ...

- 使用Keras基于RCNN类模型的卫星/遥感地图图像语义分割

遥感数据集 1. UC Merced Land-Use Data Set 图像像素大小为256*256,总包含21类场景图像,每一类有100张,共2100张. http://weegee.vision ...

- 【Keras】基于SegNet和U-Net的遥感图像语义分割

上两个月参加了个比赛,做的是对遥感高清图像做语义分割,美其名曰"天空之眼".这两周数据挖掘课期末project我们组选的课题也是遥感图像的语义分割,所以刚好又把前段时间做的成果重新 ...

- 笔记︱图像语义分割(FCN、CRF、MRF)、论文延伸(Pixel Objectness、)

图像语义分割的意思就是机器自动分割并识别出图像中的内容,我的理解是抠图- 之前在Faster R-CNN中借用了RPN(region proposal network)选择候选框,但是仅仅是候选框,那 ...

- 基于FCN的图像语义分割

语义图像分割的目标在于标记图片中每一个像素,并将每一个像素与其表示的类别对应起来.因为会预测图像中的每一个像素,所以一般将这样的任务称为密集预测.(相对地,实例分割模型是另一种不同的模型,该模型可以区 ...

- 图像语义分割出的json文件和原图,用plt绘制图像mask

1.弱监督 由于公司最近准备开个新项目,用深度学习训练个能够自动标注的模型,但模型要求的训练集比较麻烦,,要先用ffmpeg从视频中截取一段视频,在用opencv抽帧得到图片,所以本人只能先用语义分割 ...

- CRF图像语义分割

看了Ladicky的文章Associative Hierarchical CRFs for Object Class Image Segmentation,下载他主页的代码,文章是清楚了,但代码的RE ...

- 推荐一些用CRF做图像语义分割的资源

原文地址:http://blog.sina.com.cn/s/blog_5309cefc01014nri.html 首先是code,以前找了很多,但发现比较好用的有: 1. Matlab版的UGM:h ...

- 基于 PyTorch 和神经网络给 GirlFriend 制作漫画风头像

摘要:本文中我们介绍的 AnimeGAN 就是 GitHub 上一款爆火的二次元漫画风格迁移工具,可以实现快速的动画风格迁移. 本文分享自华为云社区<AnimeGANv2 照片动漫化:如何基于 ...

随机推荐

- True 和 False 分别代表数字中的几?形象地记忆

True 和 False 作为布尔值分别代表的意思是真和假. 灯泡亮起就是 1,灯泡熄灭就是 0.0 就是无状态,所以可以代表灯泡熄灭的状态,而 1 就是有状态的,所以可以代表灯泡亮起的状态. 那么, ...

- HMS Core Discovery第17期回顾|音随我动,秒变音色造型师

HMS Core Discovery第17期直播<音随我动,秒变音色造型师>,已于8月25日圆满结束,本期直播我们邀请了HMS Core音频编辑服务的产品经理.技术专家以及创新娱乐类应用& ...

- [CTSC2007]数据备份Backup (贪心)

题面 Description 你在一家 IT 公司为大型写字楼或办公楼(offices)的计算机数据做备份.然而数据备份的工作是枯燥乏味的,因此你想设计一个系统让不同的办公楼彼此之间互相备份,而你则坐 ...

- 第六十三篇:Vue的条件渲染与列表渲染

好家伙, 1.条件渲染v-if 1.1.v-if基本使用 <body> <div id="app"> <p v-if="flag" ...

- Linux_tail总结

tail 命令用法 功能从尾部显示文件若干行 语法: tail [ +/- num ][参数] 文件名 使用tail命令的-f选项可以方便的查阅正在改变的日志文件,tail -f filename会把 ...

- dp-背包模型

一:01背包问题模型 1 题目: 有一个箱子容量为 V,同时有 n 个物品,每个物品有一个体积(正整数). 要求 n 个物品中,任取若干个装入箱内,使箱子的剩余空间为最小. 输入格式 第一行是一个整数 ...

- URL slug是什么?

URL slug是什么? URL slug是 URL 中最后一个反斜杠之后的部分. 为什么slug 对 SEO 很重要? slug 对于关键字 SEO 来说非常强大.如果用户要在 Google 搜索& ...

- 如何为 SAST 工具设置误报基准?

许多 SAST 工具都无法避免误报的问题.这些工具经常报告一些实际不存在的漏洞,这种不准确性让安全团队耗费大量时间来对误报进行分类和处理,这时设置误报基准就显得十分必要. 通过设置误报基准,安全团队可 ...

- Java SE 16 record 类型说明与使用

Java SE 16 record 类型说明与使用 作者:Grey 原文地址: 博客园:Java SE 16 record 类型说明与使用 CSDN:Java SE 16 record 类型说明与使用 ...

- Elasticsearch 索引生命周期管理 ILM 实战指南

文章转载自:https://mp.weixin.qq.com/s/7VQd5sKt_PH56PFnCrUOHQ 1.什么是索引生命周期 在基于日志.指标.实时时间序列的大型系统中,集群的索引也具备类似 ...