Python 使用BrowserMob Proxy + selenium 获取Ajax加密数据

BrowserMob Proxy,简称 BMP,它是一个 HTTP 代理服务,我们可以利用它截获 HTTP 请求和响应内容。

第一步:先安装 BrowserMob Proxy 的包。

pip install browsermob-proxy

第二步:下载 browsermob-proxy 的二进制文件,用于启动 BrowserMob Proxy。

下载地址:https://github.com/lightbody/browsermob-proxy/releases

第三步:测试。

from browsermobproxy import Server # 启动代理, 修改下载的文件路径

server = Server(r'F:\BrowserMobProxy\browsermob-proxy-2.1.4\bin\browsermob-proxy.bat')

server.start()

proxy = server.create_proxy()

print('proxy', proxy.proxy)

注意:若报错,可查看server.log中的信息。如果没有装java,自行百度安装java,配置java环境,cmd输入java和javac测试是否配置成功。

代码走起:

# _*_ coding:utf-8 _*_

import os

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from browsermobproxy import Server

import time

import json class BaseFramework(object): def __init__(self):

# 修改下载的文件路径

self.server = Server(r'F:\BrowserMobProxy\browsermob-proxy-2.1.4\bin\browsermob-proxy.bat')

self.server.start()

self.proxy = self.server.create_proxy()

chrome_options = Options()

chrome_options.add_argument('--ignore-certificate-errors')

chrome_options.add_argument('--proxy-server={0}'.format(self.proxy.proxy))

chrome_options.add_argument('--headless') # 无头模式

self.browser = webdriver.Chrome(options=chrome_options) def process_request(self, request, response):

pass def process_response(self, response, request):

pass def run(self, func, *args):

self.proxy.new_har(options={

'captureContent': True,

'captureHeaders': True

})

func(*args)

result = self.proxy.har

for entry in result['log']['entries']:

request = entry['request']

response = entry['response']

self.process_request(request, response)

self.process_response(response, request) def __del__(self):

self.proxy.close()

self.browser.close() class Framework(BaseFramework): def load(self, url):

self.browser.get(url)

time.sleep(3) def process_request(self, request, response):

pass def process_response(self, response, request):

# print(request['url'])

# 找到你所需数据的url即可快乐的解析数据了

if '/item/timemap/cn/' in request['url']:

try:

text = response['content']['text']

text_dict = json.loads(text)

data_result = text_dict['data']

except KeyError:

print('----KeyError: text----')

return

name = data_result['name'] # 姓名

id_name = name_id + '_' + name

print(id_name)

time_map_list = data_result['timeMap']

if time_map_list:

time_map_dict = {}

for i in range(len(time_map_list)):

time_map = time_map_list[i]

time_map_dict[str(i)] = time_map

else:

return

path = f'./****/{id_name}.json'

if os.path.exists(path):

print(f'------{id_name}--已存在------')

return

with open(path, 'w', encoding='utf-8') as f:

f.write(json.dumps(time_map_dict, ensure_ascii=False, indent=4)) if __name__ == '__main__':

Framework = Framework()

id_list = ['********']

for name_id in id_list:

url = "************************"

Framework.run(Framework.load, url)

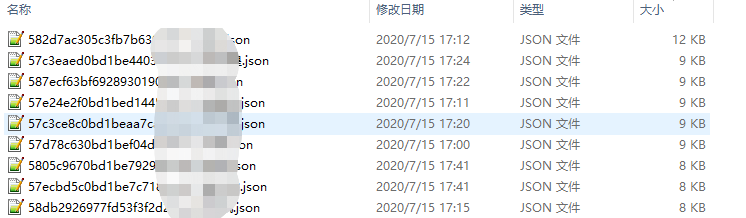

结果如下:

解释解释:

代码一共分了四步:

•第一步便是启动 BrowserMob Proxy,它会在本地启动一个代理服务,这里注意 Server 的第一个参数需要指定 BrowserMob Proxy 的可执行文件路径,这里我就指定了下载下来的 BrowserMob Proxy 的 bin 目录的 browsermob-proxy 的路径。

•第二步便是启动 Selenium 了,它可以设置 Proxy Server 为 BrowserMob Proxy 的地址。

•第三步便是访问页面同时监听结果,这里我们需要调用 new_har 方法,同时指定捕获 Resopnse Body 和 Headers 信息,紧接着调用 Selenium 的 get 方法访问一个页面,这时候浏览器便会加载这个页面,同时所有的请求和响应信息都会被记录到 HAR 中。

•第四步便是读取 HAR 到内容了,我们调用 log 到 entries 字段,里面便包含了请求和响应的具体结果,这样所有的请求和响应信息我们便能获取到了,Ajax 的内容也不在话下。

有了这个我们就不需要非得等页面加载出来之后再根据页面渲染结果提取信息了,Ajax 请求直接拿原始数据,爽歪歪!

Python 使用BrowserMob Proxy + selenium 获取Ajax加密数据的更多相关文章

- [Python爬虫] Selenium获取百度百科旅游景点的InfoBox消息盒

前面我讲述过如何通过BeautifulSoup获取维基百科的消息盒,同样可以通过Spider获取网站内容,最近学习了Selenium+Phantomjs后,准备利用它们获取百度百科的旅游景点消息盒(I ...

- Python网络爬虫笔记(四):使用selenium获取动态加载的内容

(一) 说明 上一篇只能下载一页的数据,第2.3.4....100页的数据没法获取,在上一篇的基础上修改了下,使用selenium去获取所有页的href属性值. 使用selenium去模拟浏览器有点 ...

- python扫描proxy并获取可用代理ip列表

mac或linux下可以work的代码如下: # coding=utf-8 import requests import re from bs4 import BeautifulSoup as bs ...

- selenium获取多窗口句柄并一一切换至原窗口句柄(三个窗口)

网上有很多是selenium基于python来获取两个窗口句柄与切换,本文实现用python+selenium获取多窗口句柄并一一切换至原窗口句柄(三个窗口),且在每个窗口下进行一个搜索或翻译,然后截 ...

- python爬虫动态html selenium.webdriver

python爬虫:利用selenium.webdriver获取渲染之后的页面代码! 1 首先要下载浏览器驱动: 常用的是chromedriver 和phantomjs chromedirver下载地址 ...

- PYTHON 爬虫笔记七:Selenium库基础用法

知识点一:Selenium库详解及其基本使用 什么是Selenium selenium 是一套完整的web应用程序测试系统,包含了测试的录制(selenium IDE),编写及运行(Selenium ...

- Python爬虫之设置selenium webdriver等待

Python爬虫之设置selenium webdriver等待 ajax技术出现使异步加载方式呈现数据的网站越来越多,当浏览器在加载页面时,页面上的元素可能并不是同时被加载完成,这给定位元素的定位增加 ...

- selenium获取多窗口句柄并一切换至原窗口句柄(三个窗口)

网上有很多是selenium基于python来获取两个窗口句柄与切换,本文实现用python+selenium获取多窗口句柄并一一切换至原窗口句柄(三个窗口),且在每个窗口下进行一个搜索或翻译,然后截 ...

- Selenium获取动态图片验证码

Selenium获取动态图片验证码 关于图片验证码的文章,我想大家都有一定的了解了. 在我们做UI自动化的时候,经常会遇到图片验证码的问题. 当开发不给咱们提供万能验证码,或者测试第三方网站比如知乎的 ...

随机推荐

- SQL order by语句

关于order by: order by 语句用于根据指定的列对结果集进行排序,默认按照升序排列. 1. select 字段名 from 表名 where 条件 order by 字段名1 asc/ ...

- 常用CSS颜色表

1.16进制的CSS颜色代码 > http://www.jsjtt.com/webkaifa/HTML/65.html

- 网络流(dinic算法)

洛谷p3376 https://www.luogu.com.cn/problem/P3376 #include <iostream> #include <cstdio> #in ...

- 初学Vue.js,用 vue ui 创建项目会不会被鄙视

全栈的自我修养: 6使用vue ui进行vue.js环境搭建 It is only with the heart that one can see rightly. What is essential ...

- OpenFeign使用步骤

1. 新建 cloud-consumer-feign-order80 2. pom.xml <?xml version="1.0" encoding="UTF-8& ...

- jquery判断radio是否选中

微交易-实体系统 微交易-虚拟系统 <div class="system"> <div class="systemt"> <l ...

- numpy巩固

导包 import numpy as np 创建二维数组 x = np.matrix([[1,2,3],[4,5,6]]) 创建一维数组 y = np.matrix([1,2,3,4,5,6]) x ...

- PHP Cookie是什么

PHP Cookie cookie 常用于识别用户. Cookie 是什么? cookie 常用于识别用户.cookie 是一种服务器留在用户计算机上的小文件.每当同一台计算机通过浏览器请求页面时,这 ...

- 5.20 省选模拟赛 T1 图 启发式合并 线段树合并 染色计数问题

LINK:图 在说这道题之前吐槽一下今天的日子 520 = 1+1+4+514. /cy 这道题今天做的非常失败 一点分都没拿到手 关键是今天的T3 把我整个人给搞崩了. 先考虑 如果得到了这么一张图 ...

- Java异步之《我call(),Future在哪里》

我们大家都知道,在 Java 中创建线程主要有三种方式: 继承 Thread 类: 实现 Runnable 接口: 实现 Callable 接口. 而后两者的区别在于 Callable 接口中的 ca ...