Python分布式爬虫必学框架Scrapy打造搜索引擎 ✌✌

Python分布式爬虫必学框架Scrapy打造搜索引擎 ✌✌

(一个人学习或许会很枯燥,但是寻找更多志同道合的朋友一起,学习将会变得更加有意义✌✌)

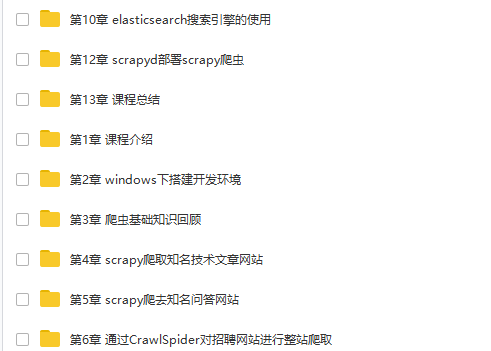

第1章 课程介绍

介绍课程目标、通过课程能学习到的内容、和系统开发前需要具备的知识

- 1-1 python分布式爬虫打造搜索引擎简介试看

第2章 windows下搭建开发环境

介绍项目开发需要安装的开发软件、 python虚拟virtualenv和 virtualenvwrapper的安装和使用、 最后介绍pycharm和navicat的简单使用

- 2-1 pycharm的安装和简单使用

- 2-2 mysql和navicat的安装和使用

- 2-3 windows和linux下安装python2和python3

- 2-4 虚拟环境的安装和配置

第3章 爬虫基础知识回顾

介绍爬虫开发中需要用到的基础知识包括爬虫能做什么,正则表达式,深度优先和广度优先的算法及实现、爬虫url去重的策略、彻底弄清楚unicode和utf8编码的区别和应用。

- 3-1 技术选型 爬虫能做什么

- 3-2 正则表达式-1

- 3-3 正则表达式-2

- 3-4 正则表达式-3

- 3-5 深度优先和广度优先原理

- 3-6 url去重方法

- 3-7 彻底搞清楚unicode和utf8编码

部分课程内容截图:

链接:https://pan.baidu.com/s/1fCw1z9riQWTYEaH-4OaCmA

提取码:uce5

(如果你正需要这份资料,欢迎你来找我免费分享)免费分享,但是X度限制严重,如若链接失效点击链接或搜索加群 715301384

第4章 scrapy爬取知名技术文章网站

搭建scrapy的开发环境,本章介绍scrapy的常用命令以及工程目录结构分析,本章中也会详细的讲解xpath和css选择器的使用。然后通过scrapy提供的spider完成所有文章的爬取。然后详细讲解item以及item loader方式完成具体字段的提取后使用scrapy提供的pipeline分别将数据保存到json文件以及mysql数据库中。...

- 4-1 关于文章网站不能访问的解决办法(本章学习之前的注意事项)

- 4-2 scrapy安装以及目录结构介绍

- 4-3 pycharm 调试scrapy 执行流程

- 4-4 xpath的用法 - 1

- 4-5 xpath的用法 - 2

- 4-6 xpath的用法 - 3

- 4-7 css选择器实现字段解析 - 1

- 4-8 css选择器实现字段解析 - 2

- 4-9 编写spider爬取jobbole的所有文章 - 1

- 4-10 编写spider爬取jobbole的所有文章 - 2

- 4-11 items设计 - 1

- 4-12 items设计 - 2

- 4-13 items设计 - 3

- 4-14 数据表设计和保存item到json文件

- 4-15 通过pipeline保存数据到mysql - 1

- 4-16 通过pipeline保存数据到mysql - 2

- 4-17 scrapy item loader机制 - 1

- 4-18 scrapy item loader机制- 2

第5章 scrapy爬取知名问答网站

本章主要完成网站的问题和回答的提取。本章除了分析出问答网站的网络请求以外还会分别通过requests和scrapy的FormRequest两种方式完成网站的模拟登录, 本章详细的分析了网站的网络请求并分别分析出了网站问题回答的api请求接口并将数据提取出来后保存到mysql中。...

- 5-1 session和cookie自动登录机制试看

- 5-2 . selenium模拟登录知乎 - 1new

- 5-3 . selenium模拟登录知乎-2new

- 5-4 . selenium模拟登录知乎-3new

- 5-5 . 知乎倒立文字识别 new

- 5-6 . selenium自动识别验证码完成模拟登录-1new

- 5-7 . selenium自动识别验证码完成模拟登录 - 2 new

- 5-8 requests模拟登陆知乎 - 1(可选观看)

- 5-9 requests模拟登陆知乎 - 2(可选观看)

- 5-10 requests模拟登陆知乎 - 3(可选观看)

- 5-11 scrapy模拟知乎登录(可选观看)

- 5-12 知乎分析以及数据表设计1

- 5-13 知乎分析以及数据表设计 - 2

- 5-14 item loder方式提取question - 1

- 5-15 item loder方式提取question - 2

- 5-16 item loder方式提取question - 3

- 5-17 知乎spider爬虫逻辑的实现以及answer的提取 - 1

- 5-18 知乎spider爬虫逻辑的实现以及answer的提取 - 2

- 5-19 保存数据到mysql中 -1

- 5-20 保存数据到mysql中 -2

- 5-21 保存数据到mysql中 -3

第6章 通过CrawlSpider对招聘网站进行整站爬取

本章完成招聘网站职位的数据表结构设计,并通过link extractor和rule的形式并配置CrawlSpider完成招聘网站所有职位的爬取,本章也会从源码的角度来分析CrawlSpider让大家对CrawlSpider有深入的理解。

- 6-1 数据表结构设计

- 6-2 CrawlSpider源码分析-新建CrawlSpider与settings配置

- 6-3 CrawlSpider源码分析

- 6-4 Rule和LinkExtractor使用

- 6-5 拉勾网302之后的模拟登录和cookie传递(网站需要登录时学习本视频教程)

- 6-6 item loader方式解析职位

- 6-7 职位数据入库-1

- 6-8 职位信息入库-2

第7章 Scrapy突破反爬虫的限制

本章会从爬虫和反爬虫的斗争过程开始讲解,然后讲解scrapy的原理,然后通过随机切换user-agent和设置scrapy的ip代理的方式完成突破反爬虫的各种限制。本章也会详细介绍httpresponse和httprequest来详细的分析scrapy的功能,最后会通过云打码平台来完成在线验证码识别以及禁用cookie和访问频率来降低爬虫被屏蔽的可能性。...

- 7-1 爬虫和反爬的对抗过程以及策略试看

- 7-2 scrapy架构源码分析

- 7-3 Requests和Response介绍

- 7-4 通过downloadmiddleware随机更换user-agent-1

- 7-5 通过downloadmiddleware随机更换user-agent - 2

- 7-6 scrapy实现ip代理池 - 1

- 7-7 scrapy实现ip代理池 - 2

- 7-8 scrapy实现ip代理池 - 3

- 7-9 云打码实现验证码识别

- 7-10 cookie禁用、自动限速、自定义spider的settings

第8章 scrapy进阶开发

本章将讲解scrapy的更多高级特性,这些高级特性包括通过selenium和phantomjs实现动态网站数据的爬取以及将这二者集成到scrapy中、scrapy信号、自定义中间件、暂停和启动scrapy爬虫、scrapy的核心api、scrapy的telnet、scrapy的web service和scrapy的log配置和email发送等。 这些特性使得我们不仅只是可以通过scrapy来完成...

- 8-1 selenium动态网页请求与模拟登录知乎

- 8-2 selenium模拟登录微博, 模拟鼠标下拉

- 8-3 chromedriver不加载图片、phantomjs获取动态网页

- 8-4 selenium集成到scrapy中

- 8-5 其余动态网页获取技术介绍-chrome无界面运行、scrapy-splash、selenium-grid, splinter

- 8-6 scrapy的暂停与重启

- 8-7 scrapy url去重原理

- 8-8 scrapy telnet服务

- 8-9 spider middleware 详解

- 8-10 scrapy的数据收集

- 8-11 scrapy信号详解

- 8-12 scrapy扩展开发

希望大家学完后,都能走上人生高峰,迎娶白富美✌✌

Python分布式爬虫必学框架Scrapy打造搜索引擎 ✌✌的更多相关文章

- Python分布式爬虫必学框架Scrapy打造搜索引擎

Python分布式爬虫必学框架Scrapy打造搜索引擎 部分课程截图: 点击链接或搜索QQ号直接加群获取其它资料: 链接:https://pan.baidu.com/s/1-wHr4dTAxfd51M ...

- Python分布式爬虫必学框架scrapy打造搜索引擎✍✍✍

Python分布式爬虫必学框架scrapy打造搜索引擎 整个课程都看完了,这个课程的分享可以往下看,下面有链接,之前做java开发也做了一些年头,也分享下自己看这个视频的感受,单论单个知识点课程本身 ...

- Python分布式爬虫必学框架Scrapy打造搜索引擎 学习教程

Python分布式爬虫打造搜索引擎Scrapy精讲—用Django实现搜索的自动补全功能 elasticsearch(搜索引擎)提供了自动补全接口 1.创建搜索自动补全字段suggest自动补全需要用 ...

- 聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎视频教程

下载链接:https://www.yinxiangit.com/595.html 目录: 第1章 课程介绍介绍课程目标.通过课程能学习到的内容.和系统开发前需要具备的知识 第2章 windows下搭建 ...

- 第三百四十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过downloadmiddleware中间件全局随机更换user-agent浏览器用户代理

第三百四十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过downloadmiddleware随机更换user-agent浏览器用户代理 downloadmiddleware介绍中间件是 ...

- 第三百四十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过自定义中间件全局随机更换代理IP

第三百四十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—通过自定义中间件全局随机更换代理IP 设置代理ip只需要,自定义一个中间件,重写process_request方法, request ...

- 第三百四十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存

第三百四十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存 注意:数据保存的操作都是在pipelines.py文件里操作的 将数据保存为json文件 spider是一个信号检测 ...

- Python分布式爬虫打造搜索引擎完整版-基于Scrapy、Redis、elasticsearch和django打造一个完整的搜索引擎网站

Python分布式爬虫打造搜索引擎 基于Scrapy.Redis.elasticsearch和django打造一个完整的搜索引擎网站 https://github.com/mtianyan/Artic ...

- 第三百七十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapyd部署scrapy项目

第三百七十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapyd部署scrapy项目 scrapyd模块是专门用于部署scrapy项目的,可以部署和管理scrapy项目 下载地址:h ...

随机推荐

- ERROR IN RESOURCESTART

TOMCAT启动时出现这个问题,试遍了网上所有的方法就是不管用,卸载tomcat重新安装即可

- netcore 基于 DispatchProxy 实现一个简单Rpc远程调用

前言 netcore 发布以来,一直很关注netcore的进程.目前在公司负责的网站也历经波折的全部有.net framework 4.0 全部切换到netcore 2.2 版本中.虽然过程遇到的坑不 ...

- 学习数据库SQL语句1

数据库一直让我很头大,正好出差有空,就重新恶补起来吧!(网站:http://www.w3school.com.cn/sql) 我准备把我每天学到的都记录下来=.= (红色字体代表关键词,蓝色字体是我个 ...

- Fliptile(枚举+DFS)

Problem Description Farmer John knows that an intellectually satisfied cow is a happy cow who will g ...

- Java第三次作业第四题

4. [问题描述]读取一个文本文件in.txt,然后将这个文件的内容,反序写到另一个文件out.txt中. [输入形式]从文件in.txt中读信息. [输出形式]反序内容写入out.txt文件中. [ ...

- python time.striptime模块用法

python time模块中strptime用法 time.strptime(string[, format]) 其中string参数即为要深入的日期字符串.format为格式化的日期字符串. %Y ...

- 6.Sentinel源码分析—Sentinel是如何动态加载配置限流的?

Sentinel源码解析系列: 1.Sentinel源码分析-FlowRuleManager加载规则做了什么? 2. Sentinel源码分析-Sentinel是如何进行流量统计的? 3. Senti ...

- 三段式有限状态机Verilog代码

状态机由状态寄存器和组合逻辑电路构成,能够根据控制信号按照预先设定的状态进行状态转移,是协调相关信号动作.完成特定操作的控制中心.有限状态机简写为FSM(Finite State Machine),主 ...

- 彻底关闭Windows10的更新

Windows10的自动更新太恶心,关闭之后总能死灰复燃,更新偶尔占用大量的CPU内存,非常影响使用.而网上大多数都是关闭服务之类的方法,但是关闭之后没过多久又会重新自动启动,如何彻底摆脱wiondo ...

- 算法与数据结构基础 - 深度优先搜索(DFS)

DFS基础 深度优先搜索(Depth First Search)是一种搜索思路,相比广度优先搜索(BFS),DFS对每一个分枝路径深入到不能再深入为止,其应用于树/图的遍历.嵌套关系处理.回溯等,可以 ...