超详细:Python(wordcloud+jieba)生成中文词云图

# coding: utf-8

import jieba

from scipy.misc import imread # 这是一个处理图像的函数

from wordcloud import WordCloud, STOPWORDS, ImageColorGenerator

import matplotlib.pyplot as plt back_color = imread('o_002.jpg') # 解析该图片 wc = WordCloud(background_color='white', # 背景颜色

max_words=1000, # 最大词数

mask=back_color, # 以该参数值作图绘制词云,这个参数不为空时,width和height会被忽略

max_font_size=100, # 显示字体的最大值

stopwords=STOPWORDS.add('苟利国'), # 使用内置的屏蔽词,再添加'苟利国'

font_path="C:/Windows/Fonts/STFANGSO.ttf", # 解决显示口字型乱码问题,可进入C:/Windows/Fonts/目录更换字体

random_state=42, # 为每个词返回一个PIL颜色

# width=1000, # 图片的宽

# height=860 #图片的长

)

# WordCloud各含义参数请点击 wordcloud参数 # 添加自己的词库分词,比如添加'金三胖'到jieba词库后,当你处理的文本中含有金三胖这个词,

# 就会直接将'金三胖'当作一个词,而不会得到'金三'或'三胖'这样的词

jieba.add_word('金三胖') # 打开词源的文本文件

text = open('cnword.txt').read() # 该函数的作用就是把屏蔽词去掉,使用这个函数就不用在WordCloud参数中添加stopwords参数了

# 把你需要屏蔽的词全部放入一个stopwords文本文件里即可

def stop_words(texts):

words_list = []

word_generator = jieba.cut(texts, cut_all=False) # 返回的是一个迭代器

with open('stopwords.txt') as f:

str_text = f.read()

unicode_text = unicode(str_text, 'utf-8') # 把str格式转成unicode格式

f.close() # stopwords文本中词的格式是'一词一行'

for word in word_generator:

if word.strip() not in unicode_text:

words_list.append(word)

return ' '.join(words_list) # 注意是空格 text = stop_words(text) wc.generate(text)

# 基于彩色图像生成相应彩色

image_colors = ImageColorGenerator(back_color)

# 显示图片

plt.imshow(wc)

# 关闭坐标轴

plt.axis('off')

# 绘制词云

plt.figure()

plt.imshow(wc.recolor(color_func=image_colors))

plt.axis('off')

# 保存图片

wc.to_file('19th.png')

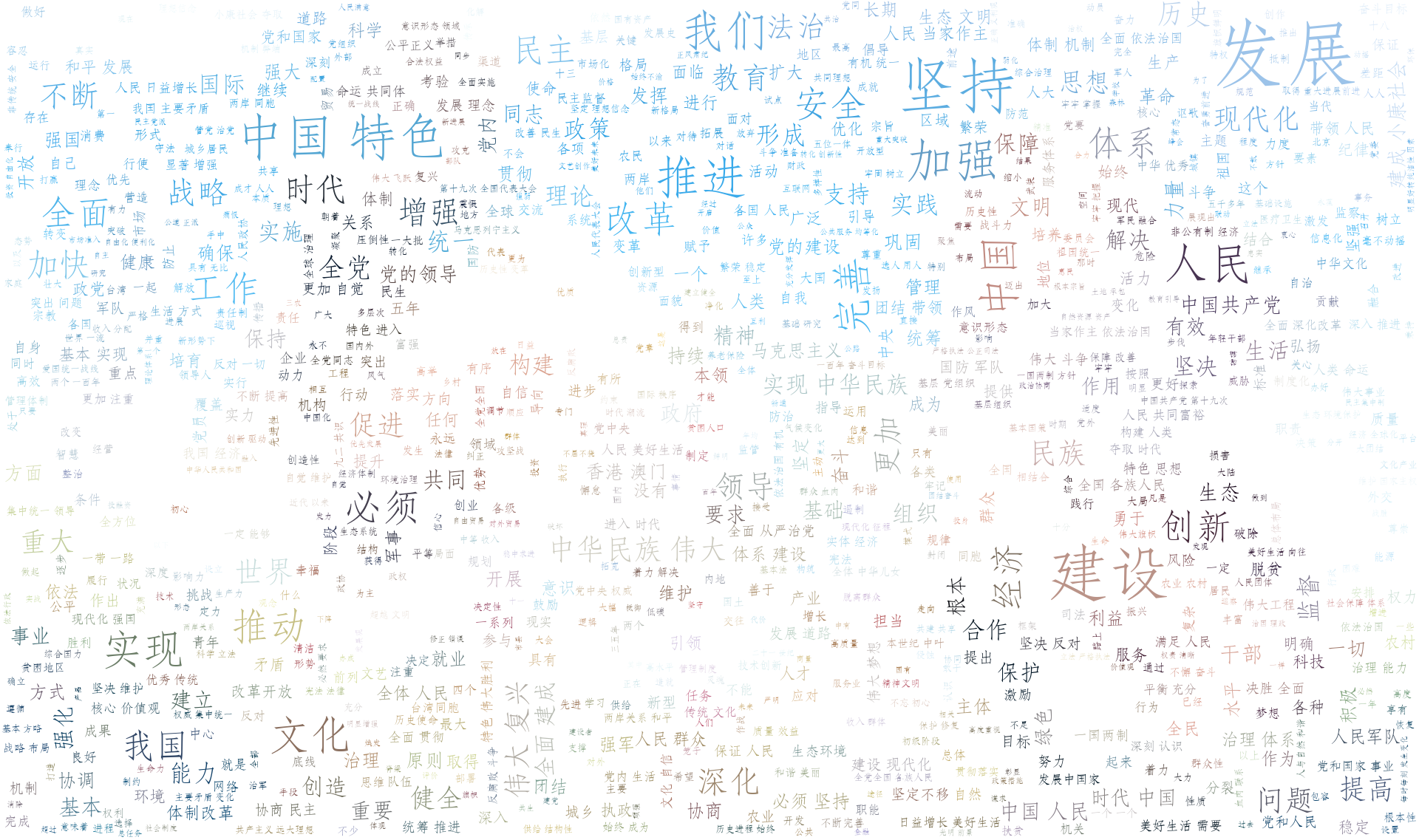

cnword.txt文本中的是十九大习大大讲话内容,太多了就不放上来了

stopwords.txt文本中有以下这几个词

社会主义

制度

国家

政治

背景颜色图

生成的词云图,与颜色图对应不是很明显,想明显的话可以使用一些色差大的图

超详细:Python(wordcloud+jieba)生成中文词云图的更多相关文章

- Python基于jieba的中文词云

今日学习了python的词云技术 from os import path from wordcloud import WordCloud import matplotlib.pyplot as plt ...

- Python 爬取生成中文词云以爬取知乎用户属性为例

代码如下: # -*- coding:utf-8 -*- import requests import pandas as pd import time import matplotlib.pyplo ...

- wordcloud + jieba 生成词云

利用jieba库和wordcloud生成中文词云. jieba库:中文分词第三方库 分词原理: 利用中文词库,确定汉字之间的关联概率,关联概率大的生成词组 三种分词模式: 1.精确模式:把文本精确的切 ...

- 【Python成长之路】词云图制作

[写在前面] 以前看到过一些大神制作的词云图 ,觉得效果很有意思.如果有朋友不了解词云图的效果,可以看下面的几张图(图片都是网上找到的): 网上找了找相关的软件,有些软件制作 还要付费.结果前几天在大 ...

- python绘制中文词云图

准备工作 主要用到Python的两个第三方库 jieba:中文分词工具 wordcloud:python下的词云生成工具 步骤 准备语料库,词云图需要的背景图片 使用jieba进行分词,去停用词,词频 ...

- [Python] 基于 jieba 的中文分词总结

目录 模块安装 开源代码 基本用法 启用Paddle 词性标注 调整词典 智能识别新词 搜索引擎模式分词 使用自定义词典 关键词提取 停用词过滤 模块安装 pip install jieba jieb ...

- python利用jieba进行中文分词去停用词

中文分词(Chinese Word Segmentation) 指的是将一个汉字序列切分成一个一个单独的词. 分词模块jieba,它是python比较好用的分词模块.待分词的字符串可以是 unicod ...

- [python] 使用Jieba工具中文分词及文本聚类概念

声明:由于担心CSDN博客丢失,在博客园简单对其进行备份,以后两个地方都会写文章的~感谢CSDN和博客园提供的平台. 前面讲述了很多关于Python爬取本体Ontology.消息盒Inf ...

- 超详细Gitlab Runner环境配置中文教程

配置GitlabRunner环境 GitLab Runner 是一个开源项目, 它用来运行你定制的任务(jobs)并把结果返回给 GitLab. GitLab Runner 配合GitLab CI(G ...

随机推荐

- rabbitmq架构简介(包括集群)

总的来说,rabbitmq使用erlang语言编写,其架构类似于servlet容器运行servlet应用,底层是erlang VM.然后是erlang节点,上面是应用.如下所示: 每个MQ中运行的应用 ...

- Duilib初级控件扩展一例: 具有鼠标滚动消息的OptionUI

转载:http://www.cnblogs.com/memset/p/Duilib_MouseWheelOptionUI_Deprecated.html

- 常用maven命令总结

常用Maven命令: mvn -v //查看版本 mvn archetype:create //创建 Maven 项目 mvn compile //编译源代码 mvn test-compile //编 ...

- JavaScript:正则表达式 全局

关于正则表达式的 RegExp方法:test,exec, String 方法:match,search, 全局 g var str = "abababa"; var re = /a ...

- User-Defined Table Types 用户自定义表类型

Location 数据库--可编程性--类型--用户定义表类型 select one database--> programmability-->types-->user--defi ...

- POJ 1625 Censored!(AC自动机+高精度+dp)

http://poj.org/problem?id=1625 题意: 给出一些单词,求长度为m的串不包含这些单词的个数. 思路: 这道题和HDU 2243和POJ 2778是一样的,不同的是这道题不取 ...

- POJ 2117 Electricity(割点求连通分量)

http://poj.org/problem?id=2117 题意:求删除图中任意一个顶点后的最大连通分量数. 思路: 求出每个割点对应的连通分量数,注意这道题目中图可能是不连通的. 这道题目我wa了 ...

- H5本地存储二

众所周知,H5的storage有sessionstorage&localStorage,其中他们的共同特点是API相同 下面直接上代码,storage中的存储与删除: <!DOCTYPE ...

- codeforces 350 div2 D Magic Powder - 2 二分

D2. Magic Powder - 2 time limit per test 1 second memory limit per test 256 megabytes input standard ...

- Codeforces Beta Round #94 div2 D 优先队列

B. String time limit per test 2 seconds memory limit per test 256 megabytes input standard input out ...