保姆级教程:用GPU云主机搭建AI大语言模型并用Flask封装成API,实现用户与模型对话

导读

在当今的人工智能时代,大型AI模型已成为获得人工智能应用程序的关键。但是,这些巨大的模型需要庞大的计算资源和存储空间,因此搭建这些模型并对它们进行交互需要强大的计算能力,这通常需要使用云计算服务。从云产品性能上来看,GPU云主机是最适合的工具之一,对于业务方或者个人开发者来讲,使用GPU云主机搭建AI大语言模型有以下优势:

•高性能计算:GPU云主机提供了高性能GPU处理器,加速模型的训练和推理;

•高性价比:灵活资源管理、可扩展性、弹性伸缩等云计算优势,根据业务或个人训练的需要,快速调整计算资源,满足模型的训练和部署需求;

•开放性:云计算的开放性让用户更容易进行资源的共享和协作,为AI模型的研究和应用提供了更广泛的合作机会;

•丰富的API和SDK:云计算厂商提供了丰富的API和SDK,使得用户能够轻松地接入云平台的各种服务和功能,进行定制化开发和集成。

在本文中,我们将以chatglm-6b为例详细介绍GPU云主机搭建AI大语言模型的过程,并使用Flask构建前端界面与该模型进行对话。

整个流程也比较简单:配置GPU云主机 → 搭建Jupyterlab开发环境 → 安装ChatGLM → 用Flask输出模型API

一、Start:配置GPU云主机

GPU 云主机(GPU Cloud Virtual Machine )是提供 GPU 算力的弹性计算服务,具有超强的并行计算能力,在深度学习、科学计算、图形图像处理、视频编解码等场景被广泛使用。GPU驱动,提供大量的GPU内存和强悍的计算性能,非常适合运行深度学习应用程序。

相对于实体卡,一张售价一般都是几万左右,而GPU云主机费用门槛很低,按时计费,一小时才十几元,可以根据自己的需求调配。

•本次选取的是P40卡: https://www.jdcloud.com/cn/calculator/calHost

•系统环境:Ubuntu 20.04 64位

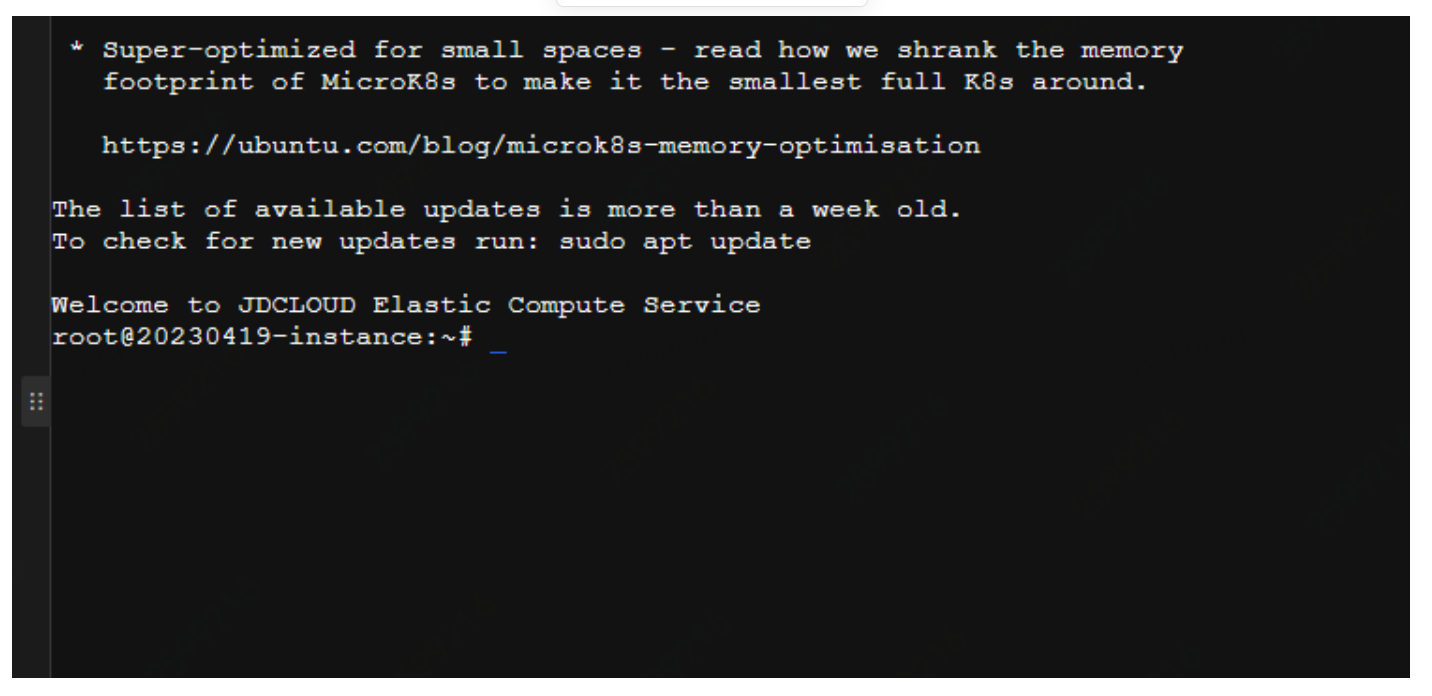

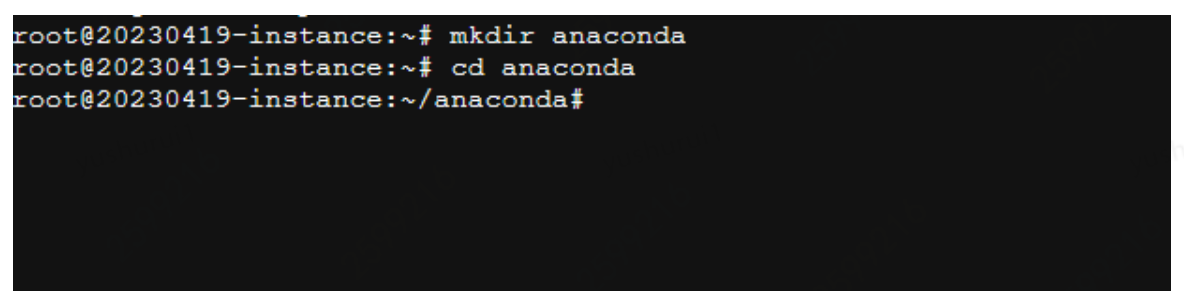

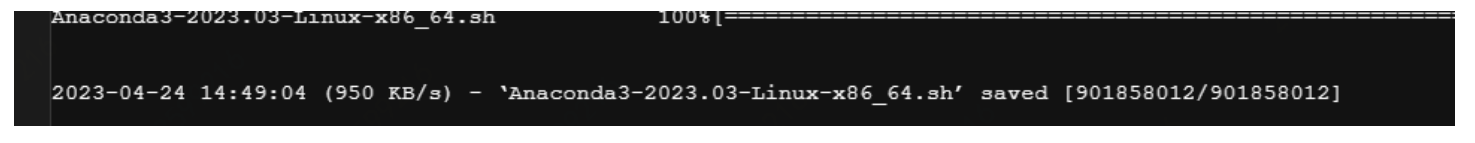

二、搭建Jupyterlab开发环境

下载Anaconda包需要在终端里执行以下命令:

mkdir anaconda # 创建文件夹

cd anaconda # 进入文件夹

wget https://repo.anaconda.com/archive/Anaconda3-2023.03-Linux-x86_64.sh # 下载安装包

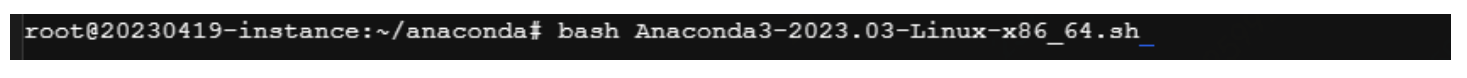

bash Anaconda3-2023.03-Linux-x86_64.sh # 安装

也可以用清华源,速度更快:https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/Anaconda3-2023.03-Linux-x86_64.sh

接下来进行环境变量设置

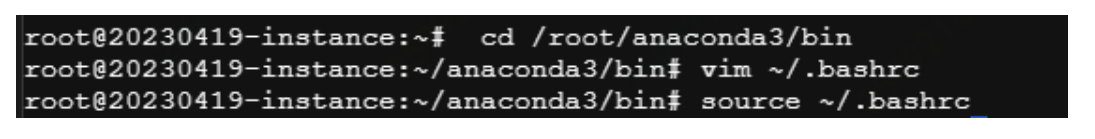

cd /root/anaconda3/bin

vim ~/.bashrc

在.bashrc下添加以下内容:#Anaconda

export PATH="/root/anaconda3/bin:$PATH"

然后退出编辑

source ~/.bashrc

conda create -n jabari python=3.8 安装python3.8版本

# 创建环境

jupyter lab --generate-config

# 生成配置文件

Writing default config to: /root/.jupyter/jupyter_lab_config.py

[root@lavm-ba6po1r9fh bin]# vim /root/.jupyter/jupyter_lab_config.py

# 编辑配置文件

c.ServerApp.ip = '*' # 设置访问的IP地址

c.ServerApp.open_browser = False

# 不自动打开浏览器

c.ServerApp.port = 6888 #(自己可以自己设置端口,这里设置了6888)

# ServerApp的端口号

c.MappingKernelManager.root_dir = '/root/jupyter_run'

# 设置Jupyter Notebook的根文件夹

c.ServerApp.allow_remote_access = True

# 允许远程访问

c.ServerApp.password = ''

# 不设置登录密码

c.ServerApp.allow_origin='*'

# 允许任何来源的请求

c.ServerApp.password_required = False

# 不需要密码

c.ServerApp.token = ''

# 不设置验证token

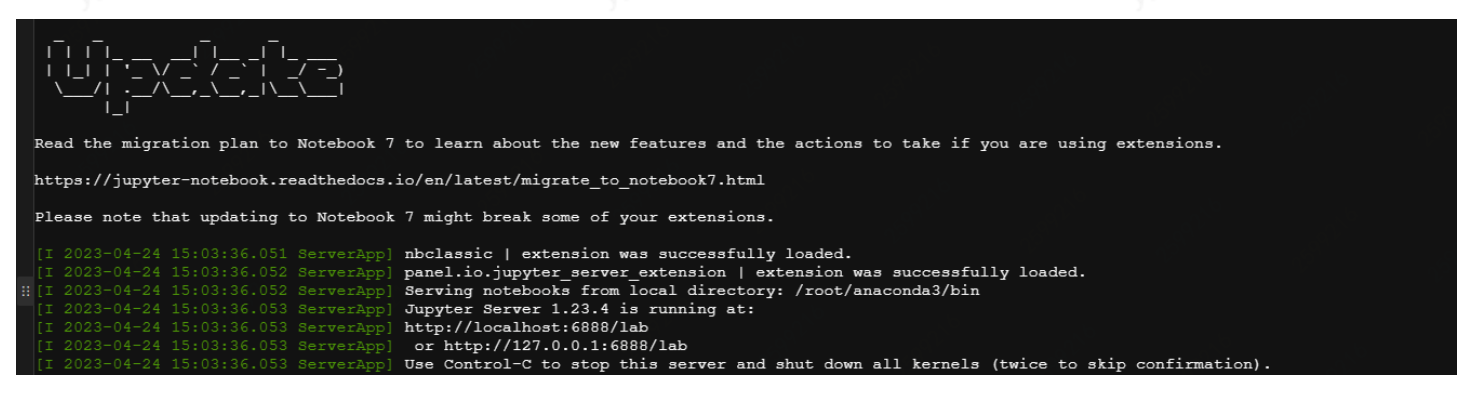

jupyter lab --allow-root # 启动JupyterLab

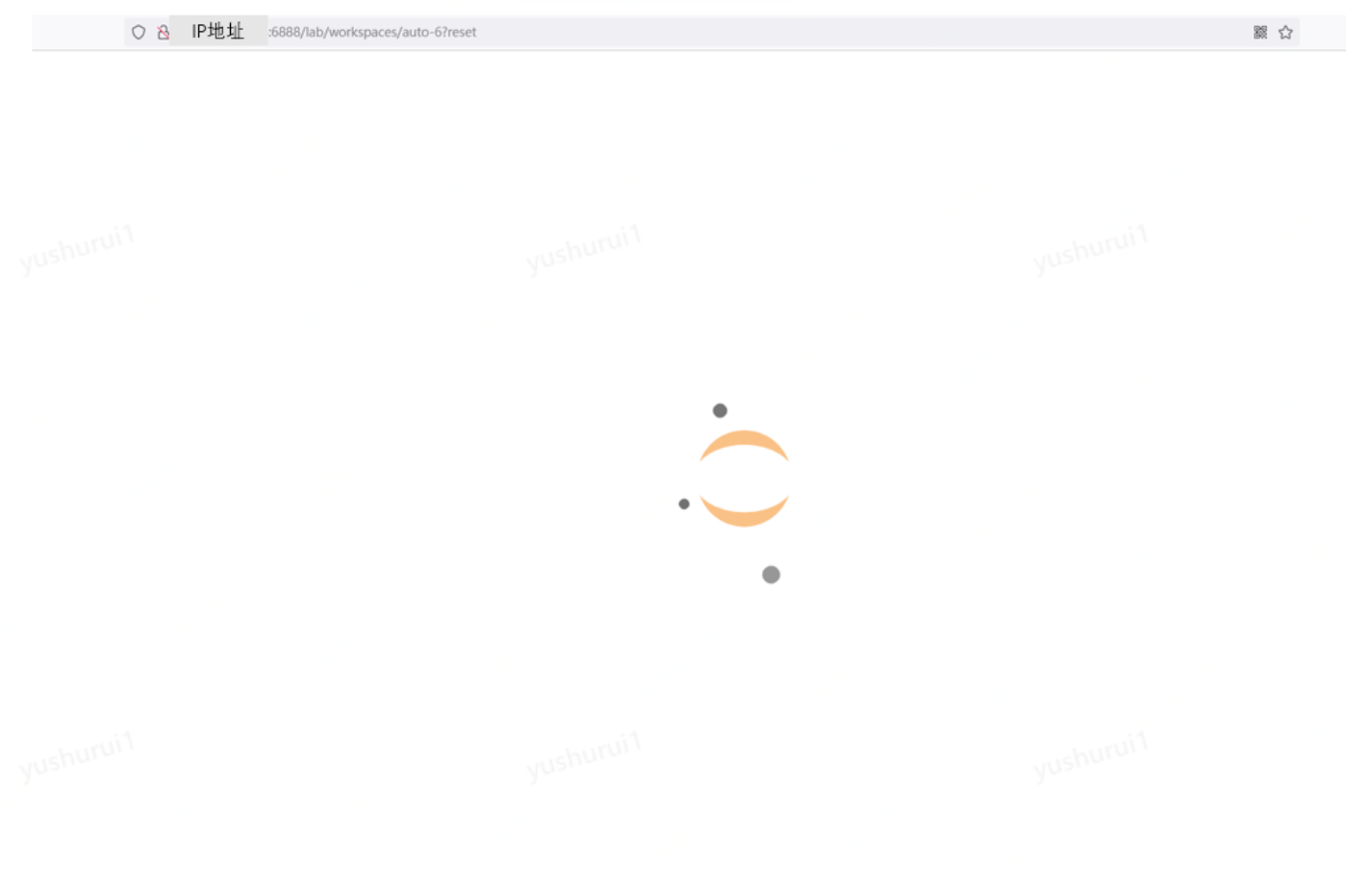

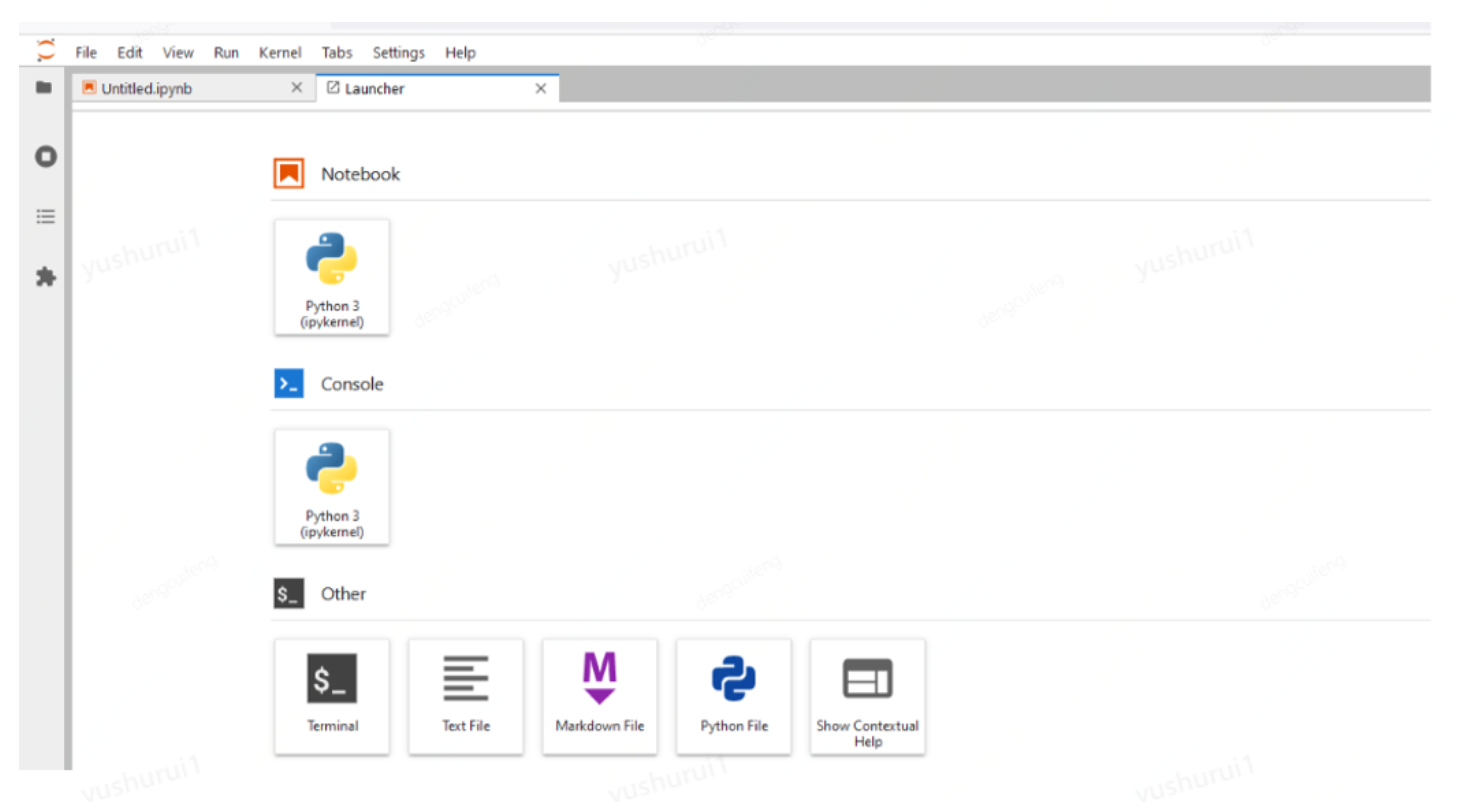

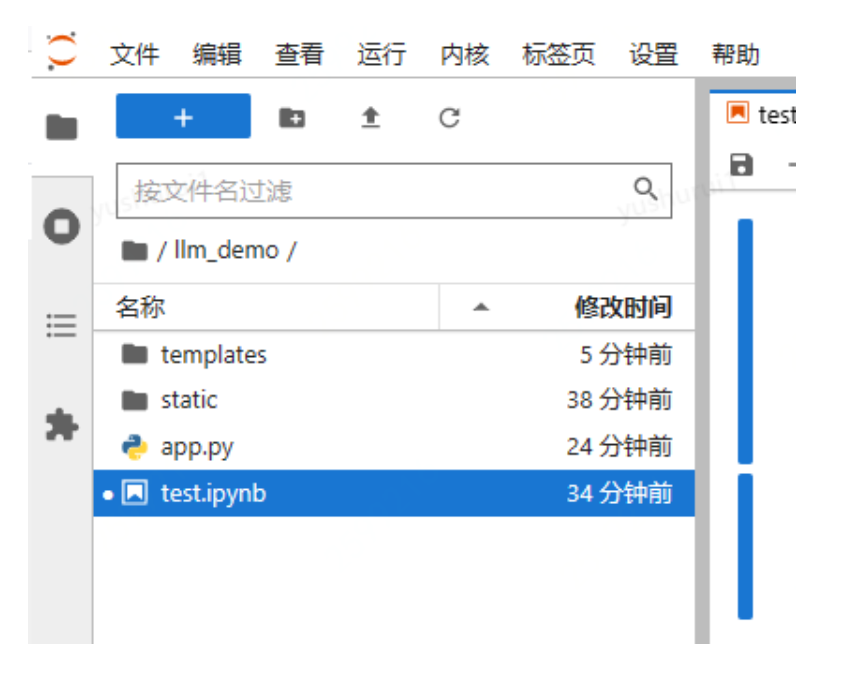

之后,在本地浏览器输入"服务器ip:端口号"访问即可:

也可以安装汉化软件:

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple jupyterlab-language-pack-zh-CN

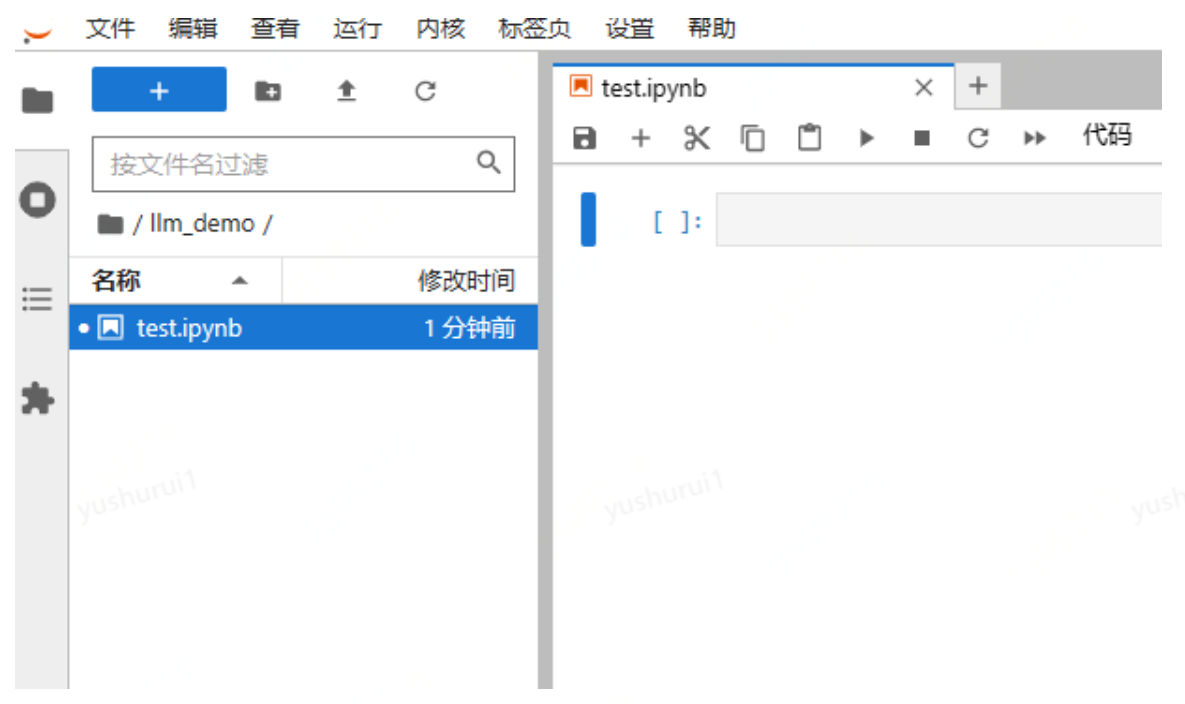

三、重点来了:开始安装ChatGLM语言模型

https://huggingface.co/THUDM/chatglm-6b

ChatGLM-6B 是一个开源的、支持中英双语问答的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。ChatGLM-6B 使用了和 ChatGLM 相同的技术,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答。

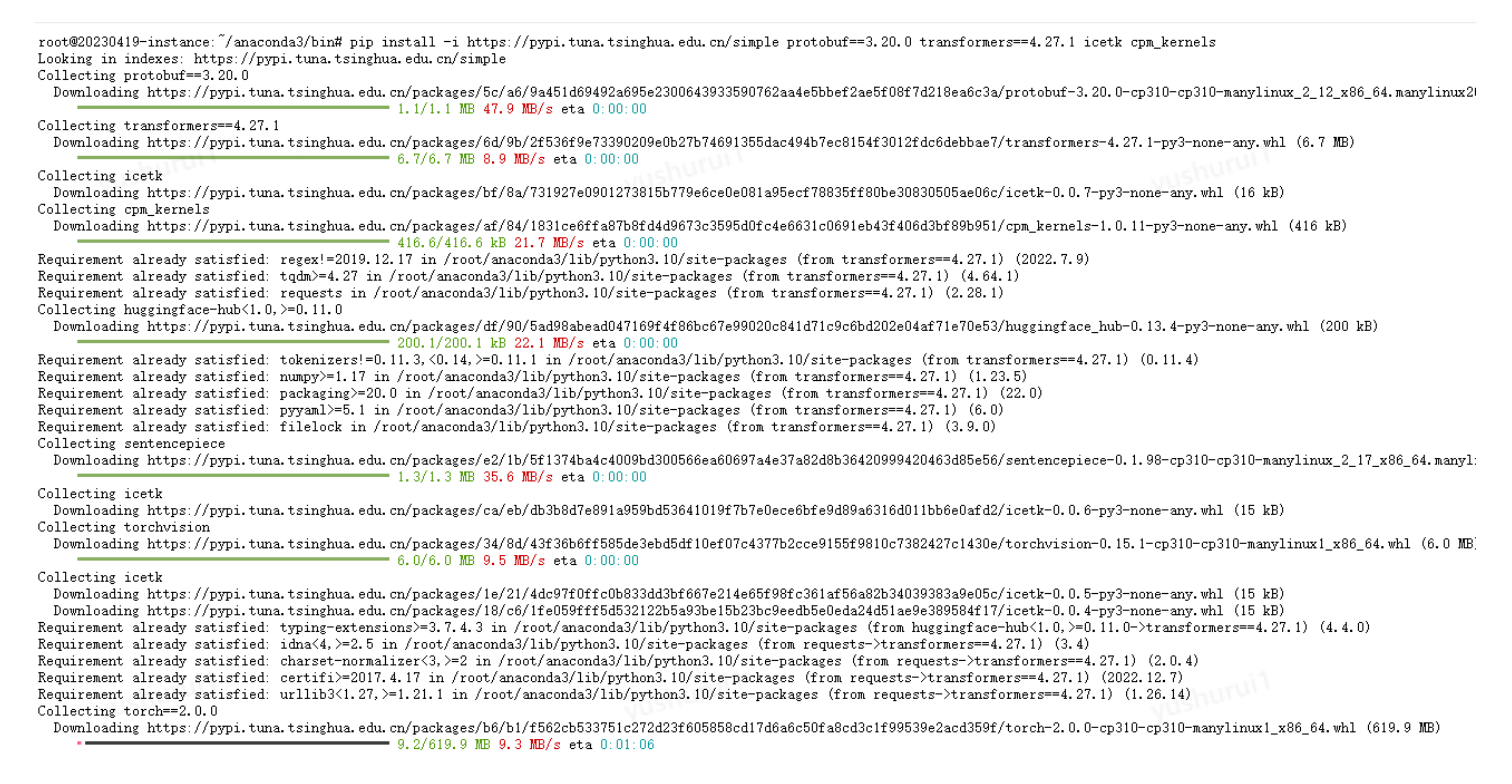

先安装语言依赖

pip install protobuf==3.20.0 transformers==4.27.1 icetk cpm_kernels

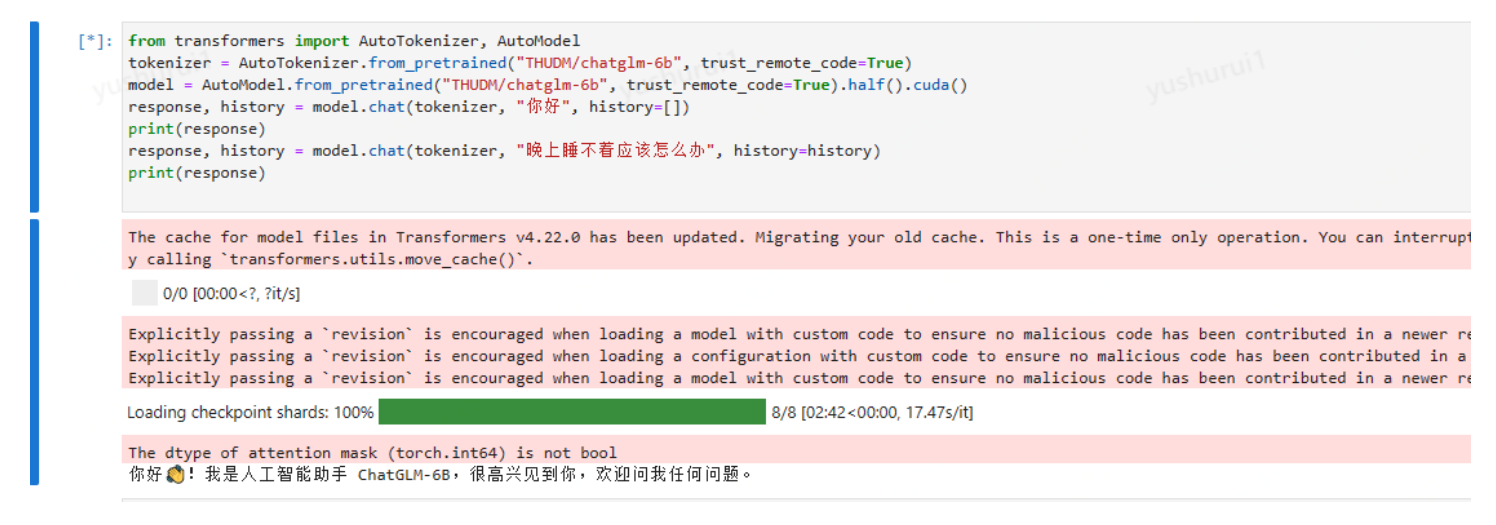

然后在jupyter运行代码

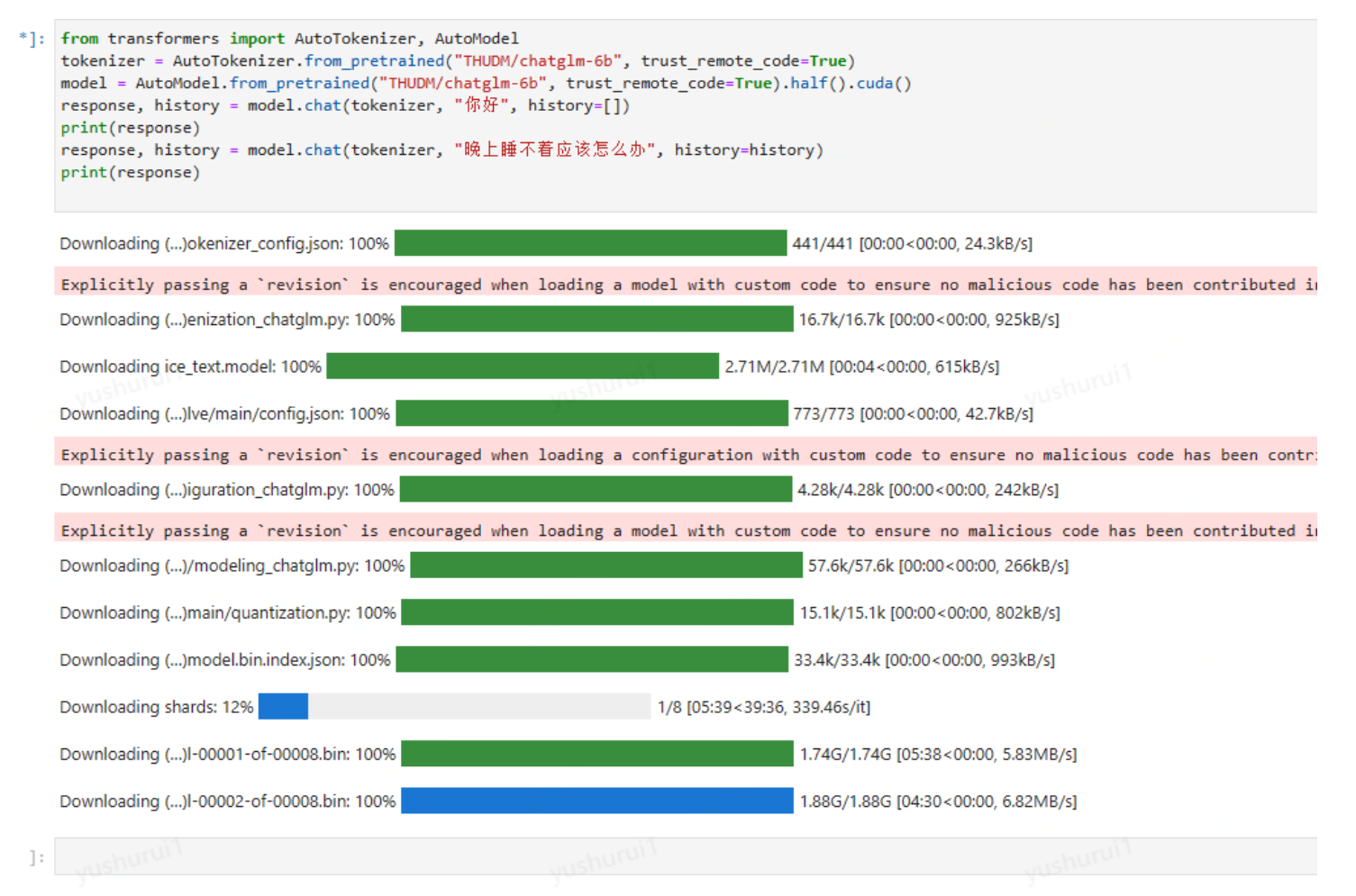

from transformers import AutoTokenizer, AutoModel

tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()

response, history = model.chat(tokenizer, "你好", history=[])

print(response)

response, history = model.chat(tokenizer, "晚上睡不着应该怎么办", history=history)

print(response)

这里会直接从huggingface.co下载

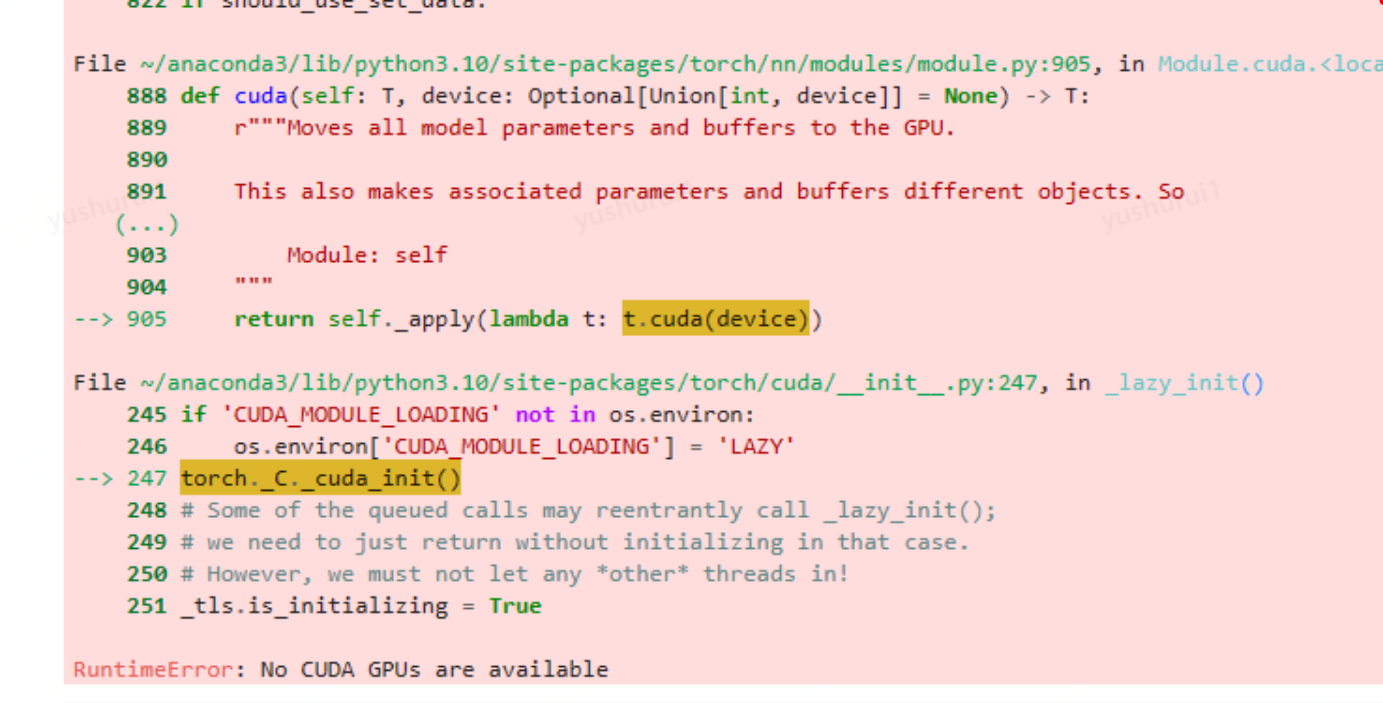

最终下载完后,再次运行,提示

这里需要安装显卡驱动同时还要安装nvidia-cuda-toolkit

NVIDIA CUDA Toolkit 提供了一个开发环境,用于创建高性能 GPU 加速应用程序。

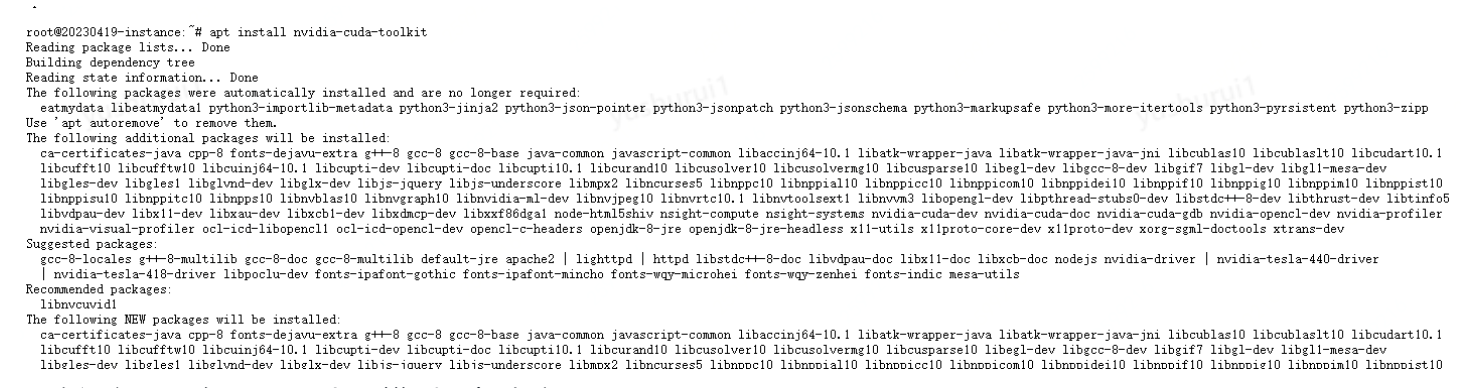

apt install nvidia-cuda-toolkit

再次运行,已经ok了,出现模型回复内容

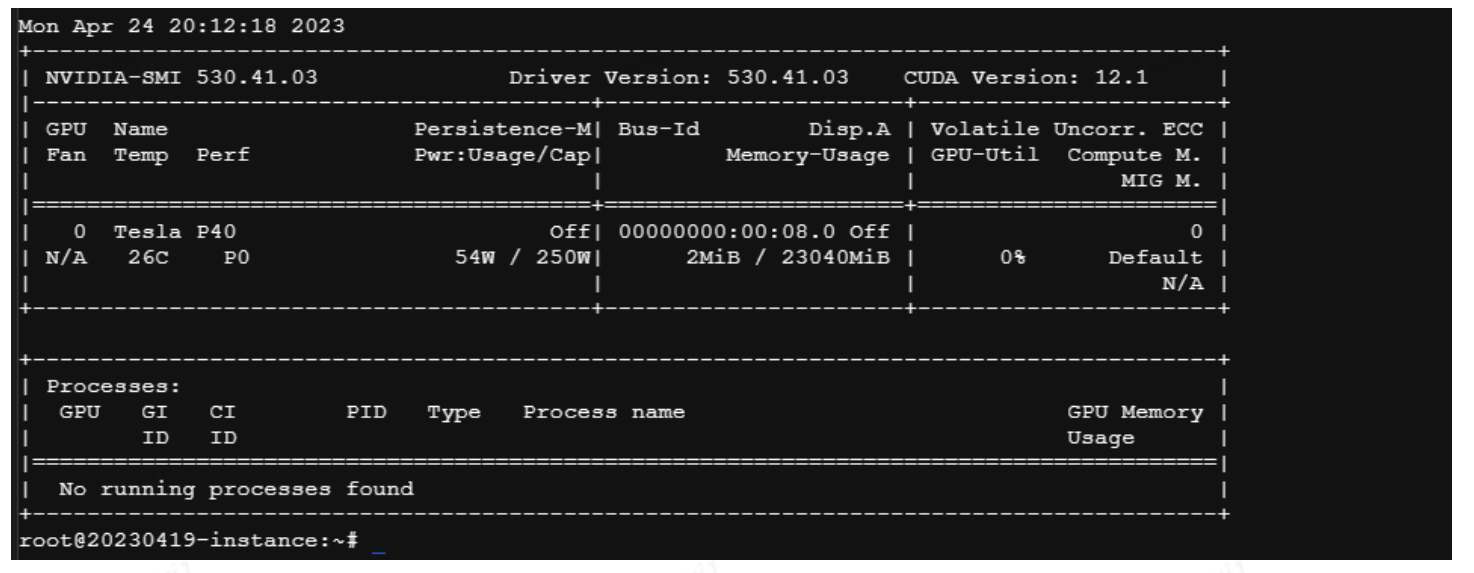

这里在命令行输入nvidia-smi 也看下显卡类型:

四、用Flask输出模型API

app.py的代码如下:

from gevent import pywsgi

from flask import Flask

from flask_restful import Resource, Api, reqparse

from transformers import AutoTokenizer, AutoModel

from flask_cors import CORS

app = Flask(__name__)

CORS(app, resources={r"/api/*": {"origins": "*"}})

api = Api(app)

tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()

parser = reqparse.RequestParser()

parser.add_argument('inputs', type=str, help='Inputs for chat')

parser.add_argument('history', type=str, action='append', help='Chat history')

class Chat(Resource):

def post(self):

args = parser.parse_args()

inputs = args['inputs']

history = args['history'] or []

response, new_history = model.chat(tokenizer, inputs, history)

return {'response': response, 'new_history': new_history}

api.add_resource(Chat, '/api/chat')

if __name__ == '__main__':

server = pywsgi.WSGIServer(('0.0.0.0', 80), app)

server.serve_forever()

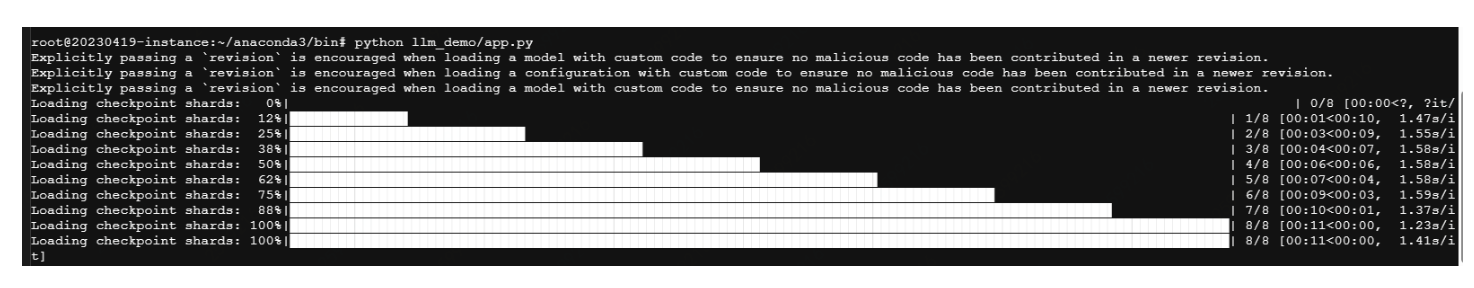

最后在Terminal 里 执行python 目录地址/app.py

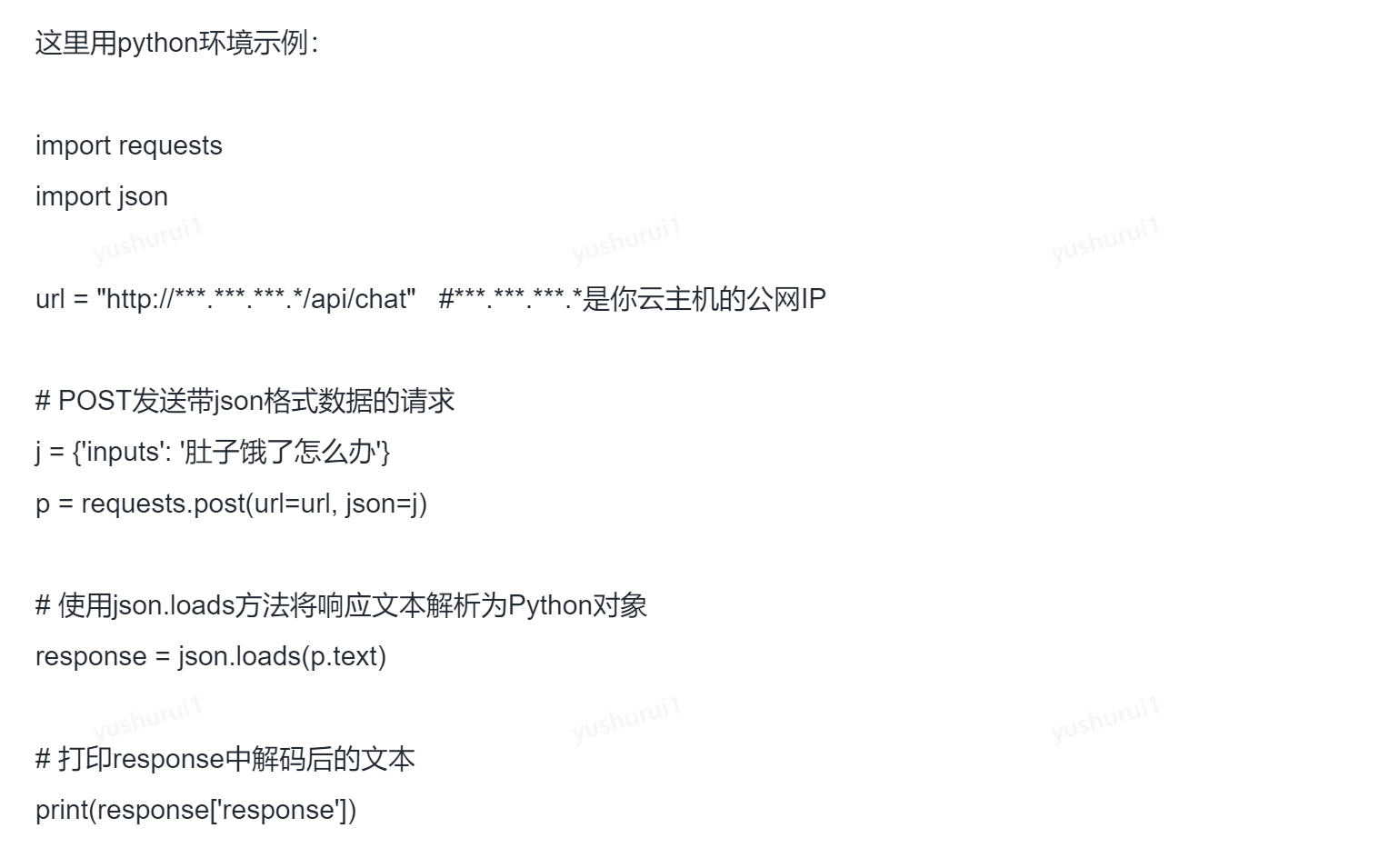

客户端,开发者可以通过API来获取数据:

五、前端效果:问问五一去哪玩!

你可以自定义UI效果,比如胡老师用5分钟搞定的Demo——

保姆级教程:用GPU云主机搭建AI大语言模型并用Flask封装成API,实现用户与模型对话的更多相关文章

- 保姆级教程——Ubuntu16.04 Server下深度学习环境搭建:安装CUDA8.0,cuDNN6.0,Bazel0.5.4,源码编译安装TensorFlow1.4.0(GPU版)

写在前面 本文叙述了在Ubuntu16.04 Server下安装CUDA8.0,cuDNN6.0以及源码编译安装TensorFlow1.4.0(GPU版)的亲身经历,包括遇到的问题及解决办法,也有一些 ...

- 强大博客搭建全过程(1)-hexo博客搭建保姆级教程

1. 前言 本人本来使用国内的开源项目solo搭建了博客,但感觉1核CPU2G内存的服务器,还是稍微有点重,包括服务器内还搭建了数据库.如果自己开发然后搭建,耗费时间又比较多,于是乎开始寻找轻量型的博 ...

- 自建本地服务器,自建Web服务器——保姆级教程!

搭建本地服务器,Web服务器--保姆级教程! 本文首发于https://blog.chens.life/How-to-build-your-own-server.html. 先上图!大致思路就是如此. ...

- RocketMQ保姆级教程

大家好,我是三友~~ 上周花了一点时间从头到尾.从无到有地搭建了一套RocketMQ的环境,觉得还挺easy的,所以就写篇文章分享给大家. 整篇文章可以大致分为三个部分,第一部分属于一些核心概念和工作 ...

- Eclipse for C/C++ 开发环境部署保姆级教程

Eclipse for C/C++ 开发环境部署保姆级教程 工欲善其事,必先利其器. 对开发人员来说,顺手的开发工具必定事半功倍.自学编程的小白不知道该选择那个开发工具,Eclipse作为一个功能强大 ...

- 云主机搭建Kubernetes 1.10集群

一.基础环境 云主机 下载软件包 将所有软件下载至/data目录 # 链接:https://pan.baidu.com/s/13DlR1akNBCjib5VFaIjGTQ 密码:1l69 # 链接:h ...

- 在云主机上基于nginx部署基于Flask的网站服务器 (自己部署 )

1.申请云主机 a.阿里云 (注意:阿里云的服务器需要手动添加安全规则使能80端口) b.腾讯云 2.把网站服务器程序拷贝到云主机 3.远程登录云主机 4.解压网站服务器程序 yum install ...

- 保姆级教程!手把手教你使用Longhorn管理云原生分布式SQL数据库!

作者简介 Jimmy Guerrero,在开发者关系团队和开源社区拥有20多年的经验.他目前领导YugabyteDB的社区和市场团队. 本文来自Rancher Labs Longhorn是Kubern ...

- 保姆级教程,带你认识大数据,从0到1搭建 Hadoop 集群

大数据简介,概念部分 概念部分,建议之前没有任何大数据相关知识的朋友阅读 大数据概论 什么是大数据 大数据(Big Data)是指无法在一定时间范围内用常规软件工具进行捕捉.管理和处理的数据集合,是需 ...

- 利用云主机搭建MySQL服务器

前言:有了一台云服务器之后,就想着如何物尽其用.利用其不关机(意外除外)的特性,我们可以在服务器上安装数据库服务,实现云数据库服务器,这样就可以随时随地的访问数据库了,不再受各种限制. 这里以MySQ ...

随机推荐

- recovery gerrit

参考wiki :https://wiki.realtek.com/pages/viewpage.action?pageId=81823331 1.修改IP: for example : Gerrit/ ...

- Java中的方法增强

A:在不影响业务情况下,增强一个方法有几种方法呢? B:3种! A:哪三种呀? 一.继承类来重写方法: 1.要可以获取这个类的构造: class Man{ public void run(){ Sys ...

- Exception processing template "index": An error happened during template rendering

问题所在 brandList[0].brandId出错,要不就改正,要不就把他删了,注释也会报错.

- Abaqus:单位、高清图片

参考: https://blog.csdn.net/Rayyyy/article/details/113798490 Abaqus高清图片: https://jingyan.baidu.com/art ...

- 我亲自整理的Tampermonkey(以下简称tm)v4.13.6136的编辑器按键映射(基于联想笔记本键盘+win10+火狐浏览器企业版)

警告:你可以对该随笔内容进行转载,但必须写明其来源网址,以及其作者是博客园的zqdlly,否则后果自负!不要小看了我,我一定会让你付出你应得的成本. 0. 家喻户晓的 键 原生comment myMe ...

- kafka-集群搭建及启动脚本

集群搭建: [root@localhost kafka_2.11-0.10.2.1]# cat config/server.properties | grep -v ^$ | grep -v ^# b ...

- Java所用相关软件的大致安装流程

JAVA下载流程 一.相关环境的安装与配置 1.JDK的下载 去官网搜索相应的java版本,并进行下载 官网链接:www.xfdown.com/soft/125774.html在该链接下,可以下载ja ...

- Android笔记--数据存储之SharedPreferences

SharedPreferences--轻量级存储工具(共享参数) 其采用的存储结构是Key-Value的键值对方式 SharedPreferences用法以及相关的简单案例 记住密码的实现 实现啦! ...

- 使用 SpeechT5 进行语音合成、识别和更多功能

我们很高兴地宣布,SpeechT5 现在可用于 Transformers (一个开源库,提供最前沿的机器学习模型实现的开源库). SpeechT5 最初见于微软亚洲研究院的这篇论文 SpeechT5: ...

- 使用 Agora 为Android APP添加视频直播

add-live-streaming-to-your-android-app-using-agora-featured1024×512 121 KB 视频互动直播是当前比较热门的玩法,我们经常见到有P ...