TensorFlow笔记-模型的保存,恢复,实现线性回归

模型的保存

tf.train.Saver(var_list=None,max_to_keep=5)

•var_list:指定将要保存和还原的变量。它可以作为一个

dict或一个列表传递.

•max_to_keep:指示要保留的最近检查点文件的最大数量。

创建新文件时,会删除较旧的文件。如果无或0,则保留所有

检查点文件。默认为5(即保留最新的5个检查点文件。)

saver = tf.train.Saver()

saver.save(sess, "")

模型的恢复

恢复模型的方法是restore(sess, save_path),save_path是以前保存参数的路径,我们可以使用tf.train.latest_checkpoint来获取最近的检查点文件(也恶意直接写文件目录)

if os.path.exists("tmp/ckpt/checkpoint"):

saver.restore(sess,"")

print("恢复模型")

自定义命令行参数

import tensorflow as tf

FLAGS = tf.app.flags.FLAGS

tf.app.flags.DEFINE_string('data_dir', '/tmp/tensorflow/mnist/input_data',

"""数据集目录""")

tf.app.flags.DEFINE_integer('max_steps', 2000,

"""训练次数""")

tf.app.flags.DEFINE_string('summary_dir', '/tmp/summary/mnist/convtrain',

"""事件文件目录""")

def main(argv):

print(FLAGS.data_dir)

print(FLAGS.max_steps)

print(FLAGS.summary_dir)

print(argv)

if __name__=="__main__":

tf.app.run()

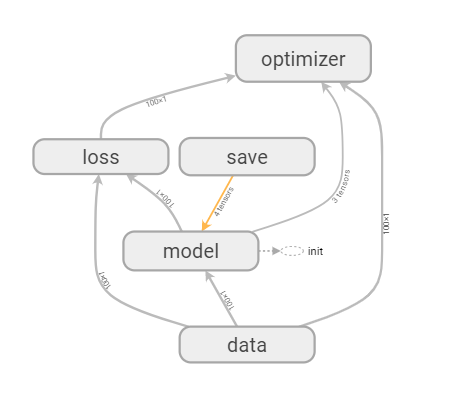

线性回归

准备数据

with tf.variable_scope("data"):

# 1、准备数据,x 特征值 [100, 1] y 目标值[100]

x = tf.random_normal([100, 1], mean=1.75, stddev=0.5, name="x_data")

# 矩阵相乘必须是二维的

y_true = tf.matmul(x, [[0.7]]) + 0.8

构建模型

with tf.variable_scope("model"):

# 2、建立线性回归模型 1个特征,1个权重, 一个偏置 y = x w + b

# 随机给一个权重和偏置的值,让他去计算损失,然后再当前状态下优化

# 用变量定义才能优化

weight = tf.Variable(tf.random_normal([1, 1], mean=0.0, stddev=1.0), name="w")

bias = tf.Variable(0.0, name="b")

y_predict = tf.matmul(x, weight) + bias

构造损失函数

with tf.variable_scope("loss"):

# 3、建立损失函数,均方误差

loss = tf.reduce_mean(tf.square(y_true - y_predict))

利用梯度下降

with tf.variable_scope("optimizer"):

# 4、梯度下降优化损失 leaning_rate: 0 ~ 1, 2, 3,5, 7, 10

train_op = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

源码

import tensorflow as tf

import os os.environ['TF_CPP_MIN_LOG_LEVEL'] = ''

# 在这里立flag

tf.app.flags.DEFINE_integer("max_step",100,"模型训练的步数")

tf.app.flags.DEFINE_string("model_dir","tmp/summary/test","模型文件的加载路径") FLAGS = tf.app.flags.FLAGS

def myregression():

with tf.variable_scope("data"):

x = tf.random_normal([100, 1], mean=1.75, stddev=0.5)

y_true = tf.matmul(x, [[0.7]]) + 0.8

with tf.variable_scope("model"):

# 权重 trainable 指定权重是否随着session改变

weight = tf.Variable(tf.random_normal([int(x.shape[1]), 1], mean=0, stddev=1), name="w")

# 偏置项

bias = tf.Variable(0.0, name='b')

# 构造y函数

y_predict = tf.matmul(x, weight) + bias

with tf.variable_scope("loss"):

# 定义损失函数

loss = tf.reduce_mean(tf.square(y_true - y_predict))

with tf.variable_scope("optimizer"):

# 使用梯度下降进行求解

train_op = tf.train.GradientDescentOptimizer(0.1).minimize((loss))

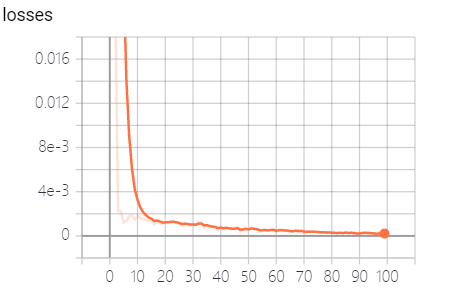

# 1.收集tensor

tf.summary.scalar("losses", loss)

tf.summary.histogram("weights", weight)

# 2.定义合并tensor的op

merged = tf.summary.merge_all()

# 定义一个保存模型的op

saver = tf.train.Saver()

with tf.Session() as sess:

tf.global_variables_initializer().run()

# import matplotlib.pyplot as plt

# plt.scatter(x.eval(), y_true.eval())

# plt.show()

print("初始化的权重:%f,偏置项:%f" % (weight.eval(), bias.eval()))

# 建立事件文件

filewriter = tf.summary.FileWriter('./tmp/summary/test/', graph=sess.graph)

# 加载模型

if os.path.exists("tmp/ckpt/checkpoint"):

saver.restore(sess,FLAGS.model_dir)

print("加载")

n = 0

while loss.eval() > 1e-6:

n += 1

if(n==FLAGS.max_step):

break

sess.run(train_op)

summary = sess.run(merged)

filewriter.add_summary(summary, n)

print("第%d次权重:%f,偏置项:%f" % (n, weight.eval(), bias.eval()))

saver.save(sess, FLAGS.model_dir)

return weight, bias myregression()

# x_min,x_max = np.min(x.eval()),np.max(x.eval())

# tx = np.arange(x_min,x_max,100)

TensorFlow笔记-模型的保存,恢复,实现线性回归的更多相关文章

- Tensorflow Learning1 模型的保存和恢复

CKPT->pb Demo 解析 tensor name 和 node name 的区别 Pb 的恢复 CKPT->pb tensorflow的模型保存有两种形式: 1. ckpt:可以恢 ...

- Tensorflow学习笔记----模型的保存和读取(4)

一.模型的保存:tf.train.Saver类中的save TensorFlow提供了一个一个API来保存和还原一个模型,即tf.train.Saver类.以下代码为保存TensorFlow计算图的方 ...

- Python之TensorFlow的模型训练保存与加载-3

一.TensorFlow的模型保存和加载,使我们在训练和使用时的一种常用方式.我们把训练好的模型通过二次加载训练,或者独立加载模型训练.这基本上都是比较常用的方式. 二.模型的保存与加载类型有2种 1 ...

- tensorflow 之模型的保存与加载(三)

前面的两篇博文 第一篇:简单的模型保存和加载,会包含所有的信息:神经网络的op,node,args等; 第二篇:选择性的进行模型参数的保存与加载. 本篇介绍,只保存和加载神经网络的计算图,即前向传播的 ...

- tensorflow 之模型的保存与加载(二)

上一遍博文提到 有些场景下,可能只需要保存或加载部分变量,并不是所有隐藏层的参数都需要重新训练. 在实例化tf.train.Saver对象时,可以提供一个列表或字典来指定需要保存或加载的变量. #!/ ...

- tensorflow 之模型的保存与加载(一)

怎样让通过训练的神经网络模型得以复用? 本文先介绍简单的模型保存与加载的方法,后续文章再慢慢深入解读. #!/usr/bin/env python3 #-*- coding:utf-8 -*- ### ...

- tensorflow:模型的保存和训练过程可视化

在使用tf来训练模型的时候,难免会出现中断的情况.这时候自然就希望能够将辛辛苦苦得到的中间参数保留下来,不然下次又要重新开始. 保存模型的方法: #之前是各种构建模型graph的操作(矩阵相乘,sig ...

- 【TensorFlow】TensorFlow基础 —— 模型的保存读取与可视化方法总结

TensorFlow提供了一个用于保存模型的工具以及一个可视化方案 这里使用的TensorFlow为1.3.0版本 一.保存模型数据 模型数据以文件的形式保存到本地: 使用神经网络模型进行大数据量和复 ...

- tensorflow模型的保存与恢复

1.tensorflow中模型的保存 创建tf.train.saver,使用saver进行保存: saver = tf.train.Saver() saver.save(sess, './traine ...

随机推荐

- Webpack Waringing Critical dependencies

报错信息如下: 出错原因先上图: 未注释部分使用了require的同时使用了es6的语法. 官方解释如下: 解决方法就是放开代码中的注释部分,不要使用es6语法

- 如何从一张图片中裁剪一部分距形图片另存为文件(使用Canvas.CopyRect)

如何从一张图片中裁剪一部分距形图片另存为文件? Delphi / Windows SDK/APIhttp://www.delphi2007.net/DelphiMultimedia/html/delp ...

- QT---Winsocket获取网关(Gateway) 主机IP等信息

基于WinPcap库做开发,需要利用到局域网的默认网关地址和Mac地址,但是WinPcap实现获取网关IP地址没有很好的思路,可以知道的是网关的接收和发出的数据包数量一般是比局域网内的各主机要多的 ...

- Dependency Injection 筆記 (4)

续上集未完的相关设计模式... (本文摘自電子書:<.NET 依賴注入> Composite 模式 延续先前的电器比喻.现在,如果希望 UPS 不只接计算机,还要接电风扇.除湿机,可是 U ...

- http-post调用接口简单代码

一.简单便捷的httpget调用接口,并且返回接口数据1.导入相应的jar包: 2.代码如下: HttpPost post = null; try { HttpClient httpClient = ...

- JavaScript 之有趣的函数(函数声明、调用、预解析、作用域)

前言:“函数是对象,函数名是指针.”,函数名仅仅是指向函数的指针,与其他包含函数指针的变量没有什么区别,话句话说,一个函数可能有多个名字. -1.函数声明,function+函数名称.调用方法:函数名 ...

- 随时发布:REST API文档的代码仓库中的持续集成与协作

本文主要内容:API文档提供了预测客户成功的关键路径:在代码附近的文档上进行协作可以更好地检查代码和文档文件,提高自动化效率,并专门针对文档进行质量测试:提供通用文档框架,标准,自动化和工具,以提高团 ...

- Log2Net日志查询网站代码解析

在前面的几节中,我们介绍了Log2Net的使用方法和代码设计.使用这个组件,我们可以方便地将日志记录到数据库中,那么,我们怎么能看到这些日志呢?于是,日志查询网站应运而生.效果图如下: 该代码已开源, ...

- c++最大公约数

C++辗转相除法求出最大公因数 样例输入 6 9 样例输出 3 程序 #include <stdio.h> using namespace std; int gcd(int m,int n ...

- 在vue项目中遇到关于对象的深浅拷贝问题

一.问题 项目里新添加了一个多选的功能,其显示的数据都是从后端返回过来的,我们需要在返回来的数据外再额外添加一个是否选中的标记,我的选择是在返回正确的数据时将标记添加进去,然后push到数组中.然后就 ...