python爬虫scrapy框架——人工识别知乎登录知乎倒立文字验证码和数字英文验证码

原创文章,转载请注明出处!

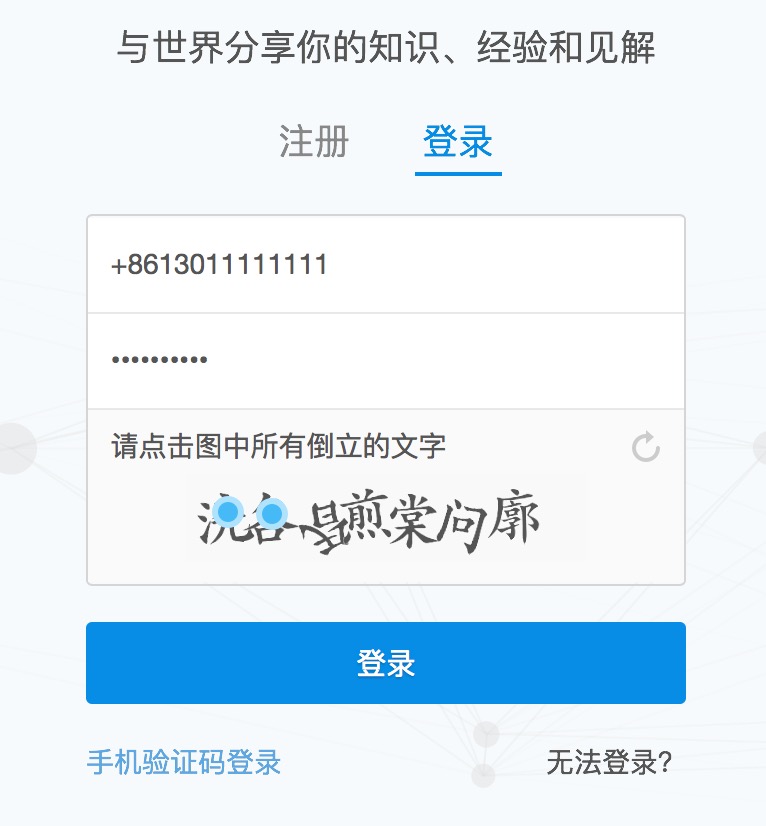

目前知乎使用了点击图中倒立文字的验证码:

用户需要点击图中倒立的文字才能登录。

这个给爬虫带来了一定难度,但并非无法解决,经过一天的耐心查询,终于可以人工识别验证码并达到登录成功状态,下文将和大家一一道来。

我们学习爬虫首先就要知道浏览器给服务器传输有什么字段(我用的是Safari浏览器进行演示,当然Chrome、Firefox都可以)

我们点击了第一个和第二个文字:

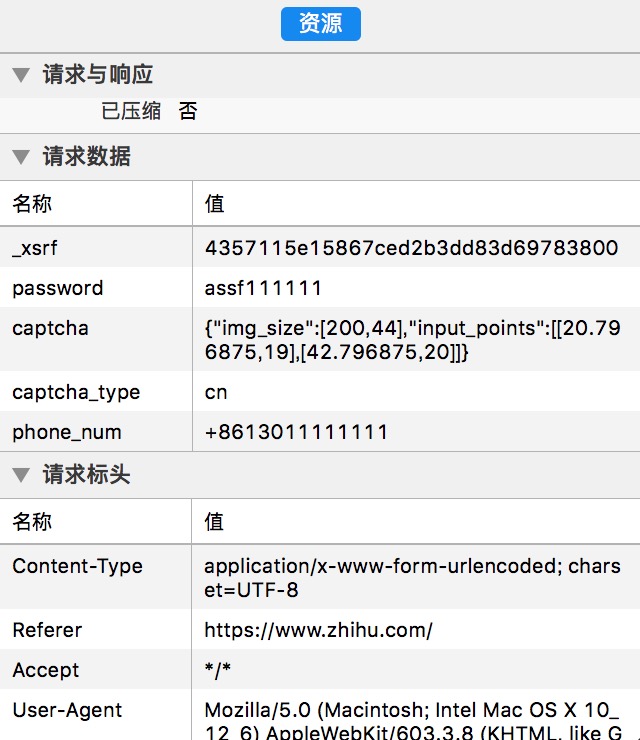

右键审查元素-->点击登录 后可以看到:

从右面可以得到:报文发送的URL是:https://www/zhihu/com/login/phone_num

这不难理解,知乎的登录是把手机和邮箱区分开来,我们用的是手机登录,经过测试邮箱的URL是:https://www/zhihu/com/login/email,这里就不截图了。

把右面的资源往下拉:

除了phone_num是用户名,password是密码,我们还看到了几个重要信息:_xsrf、captcha、captcha_type

那么重点来了,这都分别是什么意思呢?经过反复查询,直接把简介明了的解释给大家:

_xsrf:是“跨站请求伪造”(CSRF / XSRF)(Cross Site Request Forgery),这是知乎的一个安全协议,当你第一次访问知乎主页www.zhihu.com的时候,知乎会自动往你的浏览器发送一个_xsrf字段并且和你的主机绑定,之后的你每次访问知乎服务器时,你的浏览器都会带上这个字段,知乎发现你发送的_xsrf是我给你的_xsrf时才能有权访问,如果_xsrf错误或者不填都无法访问。顺便一提,这是一个安全机制,基本所有的网站都会设置一个 XSRF/CSRF 的字段,防止黑客攻击。

我们既然知道浏览器每次向知乎发送请求时都会带上_xsrf字段,那么我们的爬虫就必须要模拟浏览器访问知乎首页获取这个 _xsrf 字段并在登录时提交这个字段,才能登录成功。

captcha:里的"img_size"字段是固定的,每次都是[200,44],应该就是图片大小的意思。后面的"input_points"是你点击验证码中倒立文字的坐标,由于验证码中七个文字位置是固定的,我们只要每个字都点一下再进行登录,再审查元素来确定每个字的坐标就能模拟点击了(是不是豁然开朗),这个步骤自行点击来获取坐标,我把我测试好的七个文字坐标依次拿出来:[22.796875,22],[42.796875,22],[63.796875,21],[84.796875,20],[107.796875,20],[129.796875,22],[150.796875,22]。

captcha_type:这个字段就有意思了,其中有一个小技巧来切换成数字英文验证码。如果把它设置成 "cn" 就是倒立文字验证码,设置成 "en" 就是数字英文验证码,我没就这里设置成"cn",数字英文验证码网上很多,大家可自行寻找。(经测试不填这个字段也是数字英文验证码)

到这里思路就很清晰了,我们知道了这三个重要信息,就知道如何让爬虫登录知乎了,不多说直接上代码:

import requests try:

import cookielib

except:

import http.cookiejar as cookielib import re

import time

import json def get_xsrf():

# 获取xsrf code

response = session.get('https://www.zhihu.com', headers=header)

# print(response.text)

match_obj = re.match('[\s\S]*name="_xsrf" value="(.*?)"', response.text)

if match_obj:

return match_obj.group(1)

return '' def get_captcha():

# 验证码URL是按照时间戳的方式命名的

captcha_url = 'https://www.zhihu.com/captcha.gif?r=%d&type=login&lang=cn' % (int(time.time() * 1000))

response = session.get(captcha_url, headers=header)

# 保存验证码到当前目录

with open('captcha.gif', 'wb') as f:

f.write(response.content)

f.close() # 自动打开刚获取的验证码

from PIL import Image

try:

img = Image.open('captcha.gif')

img.show()

img.close()

except:

pass captcha = {

'img_size': [200, 44],

'input_points': [],

}

points = [[22.796875, 22], [42.796875, 22], [63.796875, 21], [84.796875, 20], [107.796875, 20], [129.796875, 22],

[150.796875, 22]]

seq = input('请输入倒立字的位置\n>')

for i in seq:

captcha['input_points'].append(points[int(i) - 1])

return json.dumps(captcha) def zhihu_login(account, password):

# 知乎登录

if re.match('1\d{10}', account):

print('手机号码登录')

post_url = 'https://www.zhihu.com/login/phone_num'

post_data = {

'captcha_type': 'cn',

'_xsrf': get_xsrf(),

'phone_num': account,

'password': password,

'captcha': get_captcha(),

} response_text = session.post(post_url, data=post_data, headers=header)

response_text = json.loads(response_text.text)

if 'msg' in response_text and response_text['msg'] == '登录成功':

print('登录成功!')

else:

print('登录失败') if __name__ == '__main__':

agent = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_6) AppleWebKit/603.3.8 (KHTML, like Gecko) Version/10.1.2 Safari/603.3.8'

header = {

'HOST': 'www.zhihu.com',

'Referer': 'https://www.zhihu.com',

'User-agent': agent,

}

session = requests.session()

zhihu_login('输入登录的手机号', '输入登录密码')

想必大家看代码都能看的懂了,我再简单说一嘴重要的

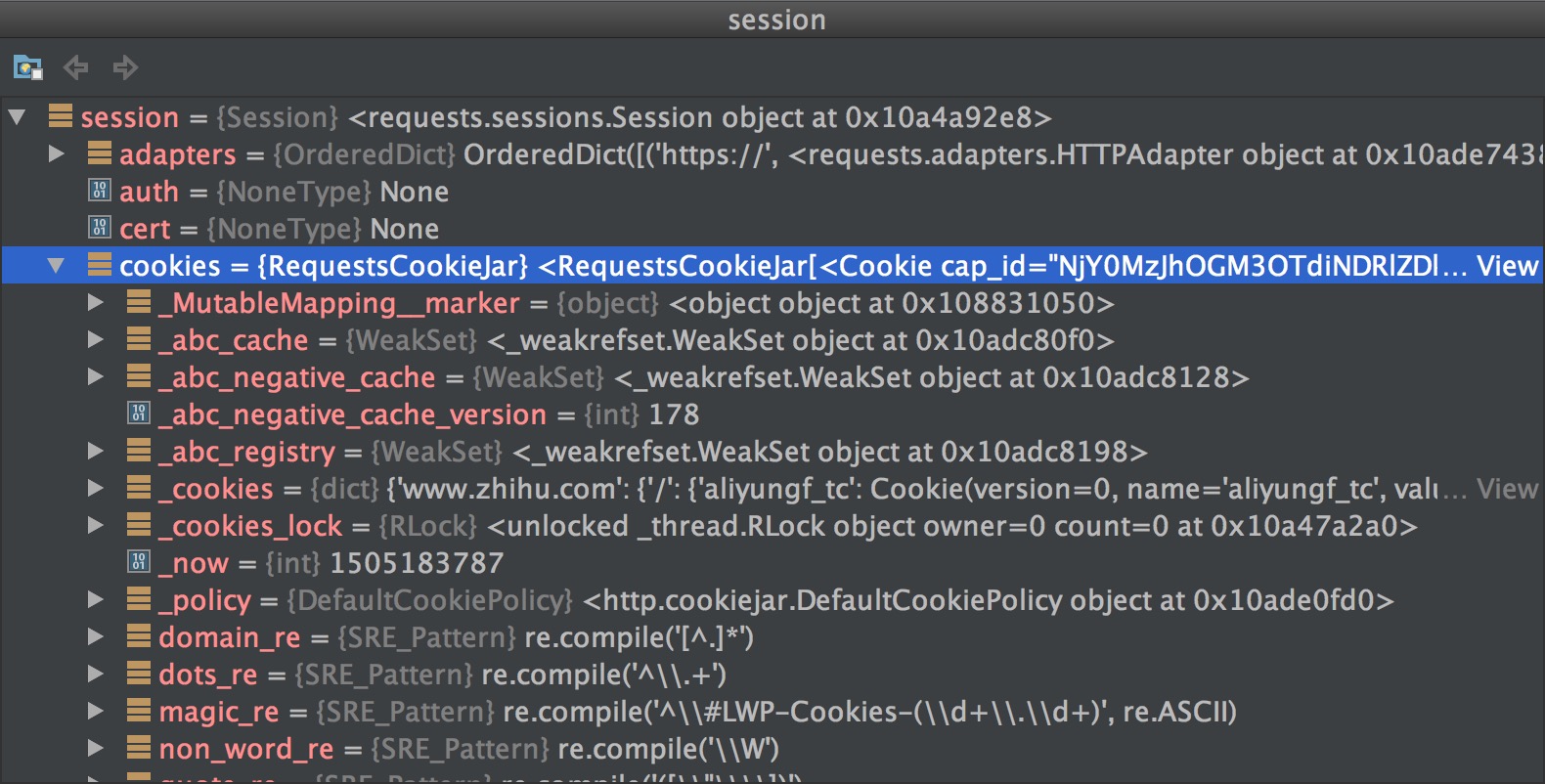

非常要注意的地方是:必须要用session来请求验证码再用session来提交报文,为什么不能用requests呢?一个session就是一个会话,如果用一个session访问了一个网站,后面再拿着这个session再请求这个网站,它会把网站带给我们的cookie或者说网站放到字段里面的session完全的给带回去,这里面的cookie就非常重要,在我们访问知乎的时候,不管我们有没有登录,服务器都可以往我们的header里面放一些值,我们用pycharm的debug来看一下session:

可以看到里面有很多cookie,获取验证码时服务器给我们发的这些cookie,必须在登录时再传给知乎服务器才算认证成功。如果在登录时用requests,它会再建立一次session,就无法把获取验证码带来的cookies传给服务器,这样固然认证失败。

好了,大功告成!只要输入第几个文字是倒立的就行了,比如第二个和第四个文字是倒立的,输入:24 按回车后就自动添加坐标,是不是很开心!

python爬虫scrapy框架——人工识别知乎登录知乎倒立文字验证码和数字英文验证码的更多相关文章

- python爬虫scrapy框架——人工识别登录知乎倒立文字验证码和数字英文验证码(2)

操作环境:python3 在上一文中python爬虫scrapy框架--人工识别知乎登录知乎倒立文字验证码和数字英文验证码(1)我们已经介绍了用Requests库来登录知乎,本文如果看不懂可以先看之前 ...

- Python爬虫Scrapy框架入门(0)

想学习爬虫,又想了解python语言,有个python高手推荐我看看scrapy. scrapy是一个python爬虫框架,据说很灵活,网上介绍该框架的信息很多,此处不再赘述.专心记录我自己遇到的问题 ...

- Python爬虫 ---scrapy框架初探及实战

目录 Scrapy框架安装 操作环境介绍 安装scrapy框架(linux系统下) 检测安装是否成功 Scrapy框架爬取原理 Scrapy框架的主体结构分为五个部分: 它还有两个可以自定义下载功能的 ...

- python爬虫scrapy框架

Scrapy 框架 关注公众号"轻松学编程"了解更多. 一.简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量 ...

- Python爬虫Scrapy框架入门(2)

本文是跟着大神博客,尝试从网站上爬一堆东西,一堆你懂得的东西 附上原创链接: http://www.cnblogs.com/qiyeboy/p/5428240.html 基本思路是,查看网页元素,填写 ...

- Python爬虫Scrapy框架入门(1)

也许是很少接触python的原因,我觉得是Scrapy框架和以往Java框架很不一样:它真的是个框架. 从表层来看,与Java框架引入jar包.配置xml或.property文件不同,Scrapy的模 ...

- Python爬虫-- Scrapy框架

Scrapy框架 Scrapy使用了Twisted作为框架,Twisted有些特殊的地方是它是事件驱动的,并且比较适合异步的代码.对于会阻塞线程的操作包含访问文件.数据库或者Web.产生新的进程并需要 ...

- Python爬虫-Scrapy框架的工作原理

Scrapy框架工作原理 Scrapy框架架构图 Scrapy框架主要由六大组件组成,分别为: 调度器(Scheduler),下载器(Downler),爬虫(Spiders),中间件(Middwa ...

- Python爬虫初学(三)—— 模拟登录知乎

模拟登录知乎 这几天在研究模拟登录, 以知乎 - 与世界分享你的知识.经验和见解为例.实现过程遇到不少疑问,借鉴了知乎xchaoinfo的代码,万分感激! 知乎登录分为邮箱登录和手机登录两种方式,通过 ...

随机推荐

- ETL作业自动化调度软件TASKCTL4.5安装程序是选项解释

下文仅针对TASKCTL4.5有效,在执行安装程序后,会看到安装程序有4个选项,其中,1和2是需要了解的. 1, 典型安装: 这个选项是单机部署,在第一次使用TASKCTL的时候,我用的是这种安装方式 ...

- 利用百度API(js),通过地址获取经纬度的注意事项

网上给的很多答案都是这种: http://api.map.baidu.com/geocoder?address=地址&output=输出格式类型&key=用户密钥&city=城 ...

- Linux(8)查看服务器系统信息

查看服务器系统信息 ql@ql:~$ uname -n -r -p -o ql 4.2.0-35-generic x86_64 GNU/Linux ql@ql:~$ 查看linux系统类型和版本 ql ...

- Misra-Gries 算法

2017/8/13 12:51:30 一.算法解决的问题 统计频繁项:统计一个数据流中出现频率最高的 k 的元素. 例如 问:k=3,统计数据流 [1,2,1,4,2,5,6,4] 中的频繁项. 答: ...

- 手脱UPX(堆栈平衡原理)

一开始看到pushad F8执行直到只有esp,eip,变化 在esp处follow in dump 下硬件访问断点 F9运行在硬件断点停下 到达一个长跳转(跳到OEP) 完成 ----------- ...

- Java 冒泡排序的实现

实现原理: 比较相邻的元素.如果第一个比第二个大,就交换他们两个. 对每一对相邻元素作同样的工作,从开始第一对到结尾的最后一对.在这一点,最后的元素应该会是最大的数. 针对所有的元素重复以上的步骤,除 ...

- RabbitMQ入门与使用篇

介绍 RabbitMQ是一个由erlang开发的基于AMQP(Advanced Message Queue)协议的开源实现.用于在分布式系统中存储转发消息,在易用性.扩展性.高可用性等方面都非常的优秀 ...

- 十分钟帮你搭建专业的内容付费平台(APP/网站)

内容付费变现时代,从商业运营角度出发,全面付费系统多方面支付节点,强化优质付费价格核心,ThinkSNS+(简称TS+),专注于帮助创业者变现,抓取社群经济,让您拥有专属的知识变现软件系统. 一.内容 ...

- vs2012中自带IIS如何让其他电脑访问

在一些场景中,我们需要让其他电脑或者说模拟器访问我们的服务进行调试,而vs2012自带的iis Express启动的程序其他设备是不能访问,iis express启动的程序路径是http://loca ...

- 关于Java中Eclipse运行卡顿、未响应,Cpu100%的快速处理办法

1.与近几日我以及我的同事们遇到一件非常奇怪的问题,我们目前在实现一个小程序,但是不知为何,Eclipse突然变得很卡,以为是小问题最后闹到重启都没解决,于是 我开始查找造成这个现象的原因,发现这个程 ...