Rocketmq日志收集与logback集成Demo

官方文档有简洁的例子,这里就做一个简单补充和实践

- 直接上logback-boot.xml文件

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<!-- 文件输出格式 -->

<property name="PATTERN" value="%-12(%d{yyyy-MM-dd HH:mm:ss.SSS}) |-%-5level [%thread] %c [%L] -| %msg%n"/>

<!-- 生产日志文件路径 -->

<property name="LOG_FILE_PATH" value="/home/tomapp/manager/logs"/>

<!-- 开发环境 -->

<springProfile name="dev">

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>${PATTERN}</pattern>

</encoder>

</appender>

<logger name="com.tzxylao.manager" level="debug"/>

<root level="info">

<appender-ref ref="CONSOLE"/>

</root>

</springProfile>

<!-- 生产环境 -->

<springProfile name="prod">

<!-- 每天产生一个文件 -->

<appender name="PROD_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<!-- 文件路径 -->

<file>${LOG_FILE_PATH}/manager.log</file>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 文件名称 -->

<fileNamePattern>${LOG_FILE_PATH}/manager.%d{yyyy-MM-dd}.log</fileNamePattern>

<!-- 文件最大保存历史数量 -->

<MaxHistory>100</MaxHistory>

</rollingPolicy>

<layout class="ch.qos.logback.classic.PatternLayout">

<pattern>${PATTERN}</pattern>

</layout>

</appender>

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>${PATTERN}</pattern>

</encoder>

</appender>

<appender name="mqAppender1" class="org.apache.rocketmq.logappender.logback.RocketmqLogbackAppender">

<tag>TagA</tag>

<topic>TopicTest</topic>

<producerGroup>please_rename_unique_group_name</producerGroup>

<nameServerAddress>47.101.45.25:9876</nameServerAddress>

<layout>

<pattern>%date %p %t - %m%n</pattern>

</layout>

</appender>

<appender name="mqAsyncAppender1" class="ch.qos.logback.classic.AsyncAppender">

<queueSize>1024</queueSize>

<discardingThreshold>80</discardingThreshold>

<maxFlushTime>2000</maxFlushTime>

<neverBlock>true</neverBlock>

<appender-ref ref="mqAppender1"/>

</appender>

<logger name="com.tzxylao.manager" level="debug"/>

<root level="info">

<appender-ref ref="PROD_FILE"/>

<appender-ref ref="CONSOLE"/>

<appender-ref ref="mqAppender1"/>

</root>

</springProfile>

</configuration>

- 这里有我本来的日志输出,rocketmq的输出主要是appender为mqAppender1、mqAsyncAppender1的这两个,最后放入root节点就可以了

- 官方文档路径:https://rocketmq.apache.org/docs/logappender-example/

- 这里要起作用,必须把nameServerAddress,rocketmq服务地址配上

- 可能出错的地方就是找不到对应的类了,这里给出我的引用pom

<dependency>

<groupId>org.apache.rocketmq</groupId>

<artifactId>rocketmq-client</artifactId>

<version>4.3.0</version>

<exclusions>

<exclusion>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.apache.rocketmq</groupId>

<artifactId>rocketmq-logappender</artifactId>

<version>4.3.0</version>

</dependency>

测试

- 编写个简单的消费端服务,就拿官方的例子加上服务地址就行了

/*

* Licensed to the Apache Software Foundation (ASF) under one or more

* contributor license agreements. See the NOTICE file distributed with

* this work for additional information regarding copyright ownership.

* The ASF licenses this file to You under the Apache License, Version 2.0

* (the "License"); you may not use this file except in compliance with

* the License. You may obtain a copy of the License at

*

* http://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

*/

package com.tzxylao.quick;

import org.apache.rocketmq.client.consumer.DefaultMQPushConsumer;

import org.apache.rocketmq.client.consumer.listener.ConsumeConcurrentlyContext;

import org.apache.rocketmq.client.consumer.listener.ConsumeConcurrentlyStatus;

import org.apache.rocketmq.client.consumer.listener.MessageListenerConcurrently;

import org.apache.rocketmq.client.exception.MQClientException;

import org.apache.rocketmq.common.consumer.ConsumeFromWhere;

import org.apache.rocketmq.common.message.MessageExt;

import java.io.UnsupportedEncodingException;

import java.util.List;

/**

* This example shows how to subscribe and consume messages using providing {@link DefaultMQPushConsumer}.

*/

public class Consumer {

public static void main(String[] args) throws InterruptedException, MQClientException {

/*

* Instantiate with specified consumer group name.

*/

DefaultMQPushConsumer consumer = new DefaultMQPushConsumer("please_rename_unique_group_name_4");

/*

* Specify name server addresses.

* <p/>

*

* Alternatively, you may specify name server addresses via exporting environmental variable: NAMESRV_ADDR

* <pre>

* {@code

* consumer.setNamesrvAddr("name-server1-ip:9876;name-server2-ip:9876");

* }

* </pre>

*/

/*

* Specify where to start in case the specified consumer group is a brand new one.

*/

consumer.setNamesrvAddr("47.101.45.25:9876");

consumer.setConsumeFromWhere(ConsumeFromWhere.CONSUME_FROM_FIRST_OFFSET);

/*

* Subscribe one more more topics to consume.

*/

consumer.subscribe("TopicTest", "*");

/*

* Register callback to execute on arrival of messages fetched from brokers.

*/

consumer.registerMessageListener(new MessageListenerConcurrently() {

@Override

public ConsumeConcurrentlyStatus consumeMessage(List<MessageExt> msgs,

ConsumeConcurrentlyContext context) {

// System.out.printf("%s Receive New Messages: %s %n", Thread.currentThread().getName(), msgs);

try {

String s = new String(msgs.get(0).getBody(), "utf-8");

System.out.println(s);

} catch (UnsupportedEncodingException e) {

e.printStackTrace();

}

return ConsumeConcurrentlyStatus.CONSUME_SUCCESS;

}

});

/*

* Launch the consumer instance.

*/

consumer.start();

System.out.printf("Consumer Started.%n");

}

}

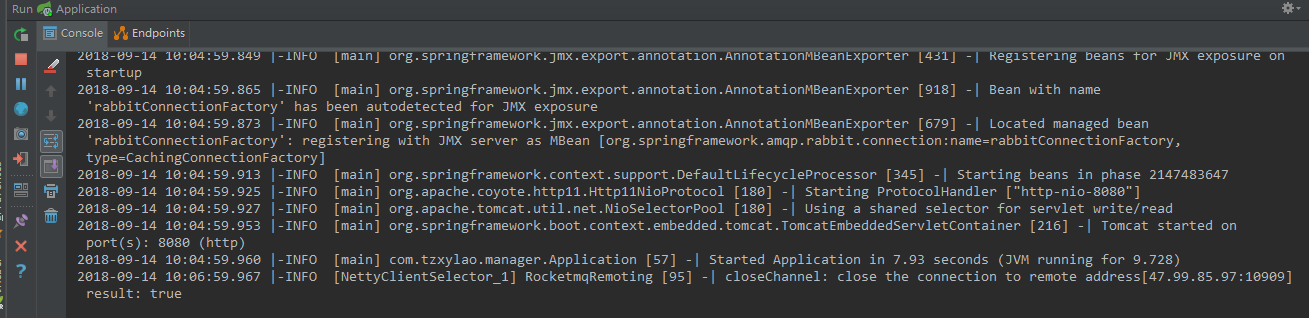

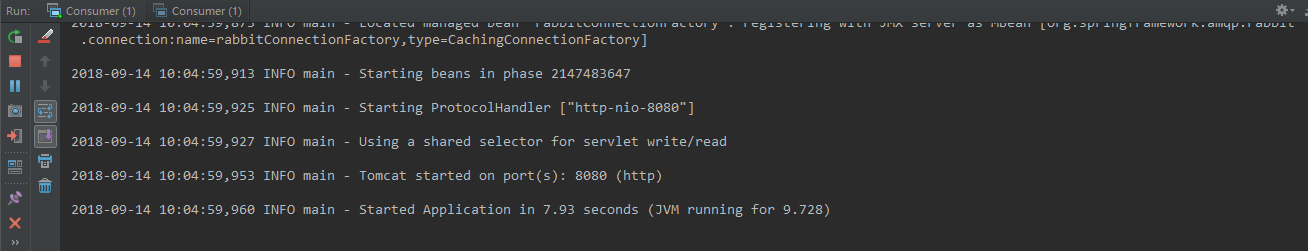

- 好了,现在启动消费端,再启动配置了rocketmq日志的服务端

这是生产端打印

这是消费端打印

好了,日志收集后怎么用,自己发挥想象吧~~

Rocketmq日志收集与logback集成Demo的更多相关文章

- SpringBoot使用Graylog日志收集

本文介绍SpringBoot如何使用Graylog日志收集. 1.Graylog介绍 Graylog是一个生产级别的日志收集系统,集成Mongo和Elasticsearch进行日志收集.其中Mongo ...

- Logback+ELK+SpringMVC搭建日志收集服务器

(转) 1.ELK是什么? ELK是由Elasticsearch.Logstash.Kibana这3个软件的缩写. Elasticsearch是一个分布式搜索分析引擎,稳定.可水平扩展.易于管理是它的 ...

- springmvc项目 logback.xml配置 logstash日志收集

配置logback,需要一个转接的Appender,可以通过Maven依赖加到项目中: <dependency> <groupId>com.cwbase</groupId ...

- springboot 集成 elk 日志收集功能

Lilishop 技术栈 官方公众号 & 开源不易,如有帮助请点Star 介绍 官网:https://pickmall.cn Lilishop 是一款Java开发,基于SpringBoot研发 ...

- 微服务日志之Spring Boot Kafka实现日志收集

前言 承接上文( 微服务日志之.NET Core使用NLog通过Kafka实现日志收集 https://www.cnblogs.com/maxzhang1985/p/9522017.html ).NE ...

- 微服务日志之.NET Core使用NLog通过Kafka实现日志收集

一.前言 NET Core越来越受欢迎,因为它具有在多个平台上运行的原始.NET Framework的强大功能.Kafka正迅速成为软件行业的标准消息传递技术.这篇文章简单介绍了如何使用.NET(Co ...

- C#实现多级子目录Zip压缩解压实例 NET4.6下的UTC时间转换 [译]ASP.NET Core Web API 中使用Oracle数据库和Dapper看这篇就够了 asp.Net Core免费开源分布式异常日志收集框架Exceptionless安装配置以及简单使用图文教程 asp.net core异步进行新增操作并且需要判断某些字段是否重复的三种解决方案 .NET Core开发日志

C#实现多级子目录Zip压缩解压实例 参考 https://blog.csdn.net/lki_suidongdong/article/details/20942977 重点: 实现多级子目录的压缩, ...

- .NET Core使用NLog通过Kafka实现日志收集

微服务日志之.NET Core使用NLog通过Kafka实现日志收集 https://www.cnblogs.com/maxzhang1985/p/9522017.html 一.前言 NET Core ...

- 日志收集系统ELK搭建

一.ELK简介 在传统项目中,如果在生产环境中,有多台不同的服务器集群,如果生产环境需要通过日志定位项目的Bug的话,需要在每台节点上使用传统的命令方式查询,这样效率非常低下.因此我们需要集中化的管理 ...

随机推荐

- 剑指offer例题——链表中倒数第K个结点

题目描述 输入一个链表,输出该链表中倒数第k个结点. 编程过程 此处采用两个指针依次后移的方法来求解,首先,用一个指针移到第k个位置,之后将第二个指针放在第一位,与第二个指针一同移动,当第二个指针移动 ...

- xadmin 常见错误

版本: Django==2.0.5 xadmin==0.6.1 djangorestframework==3.9.0 1.No module named 'django.core.urlresolve ...

- 【JAVA】杨辉三角

ソース public Yanghui3jiao() { List<String[]> rowList = new ArrayList<String[]>(); List< ...

- Js学习(7)标准库-object对象

Js原生提供Object对象,O大写,所有的其他对象都继承自Object对象,都是Object的实例 Object对象的原生方法分为两类: 本身的方法:直接定义在Object对象的方法 实例方法:定义 ...

- django 在centos 7 下 指定ip地址和端口 报错问题

windows environment: python manage.py runserver host:port centos environment: python manage.py runse ...

- 选择困难症的福音——团队Scrum冲刺阶段-Day 3

选择困难症的福音--团队Scrum冲刺阶段-Day 3 今日进展 编写提问部分 做了不同问题所对应的游戏选项,但关于游戏分类的界面还没有做完 登陆注册界面 更改ui界面,ui界面终于变好看了:) 学习 ...

- HDU 3594.Cactus 仙人掌图

Cactus Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others)Total Subm ...

- JVM 字节码(二)方法表详解

JVM 字节码(二)方法表和属性表 上一节中对 ClassFile 的整体进行了五个详细的说明, 本节围绕 ClassFile 最重要的一个内容 - 方法表的 Code 属性展开 ,更多 JVM Me ...

- tcp、ip、http

tcp是传输层协议,ip是网络层协议,http是应用层协议,简单说就是tcp是传输数据,而http是封装数据. rpc与http的区别是项目大的话,接口间调用变多的话,采用rpc的话,不用像http那 ...

- ----关于posotion的sticky与fixed的区别----

sticky 出现在正常流当中,不能设置定位,随页面滚动 (sticky = relative + fixed) fixed 不出现在正常流当中,能设置定位,随页面滚动 eg: html: <p ...