hbase与mapreduce集成

一:运行给定的案例

1.获取jar包里的方法

2.运行hbase自带的mapreduce程序

lib/hbase-server-0.98.6-hadoop2.jar

3.具体运行

注意命令:mapredcp。

HADOOP_CLASSPATH是当前运行时需要的环境。

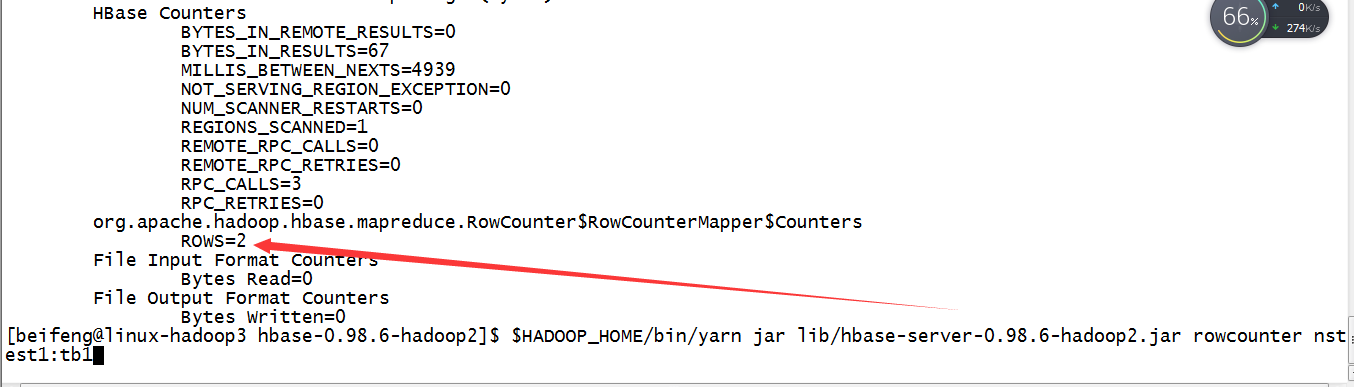

4.运行一个小方法

$HADOOP_HOME/bin/yarn jar lib/hbase-server-0.98.6-hadoop2.jar rowcounter nstest1:tb1

二:自定义hbase的数据拷贝

1.需求

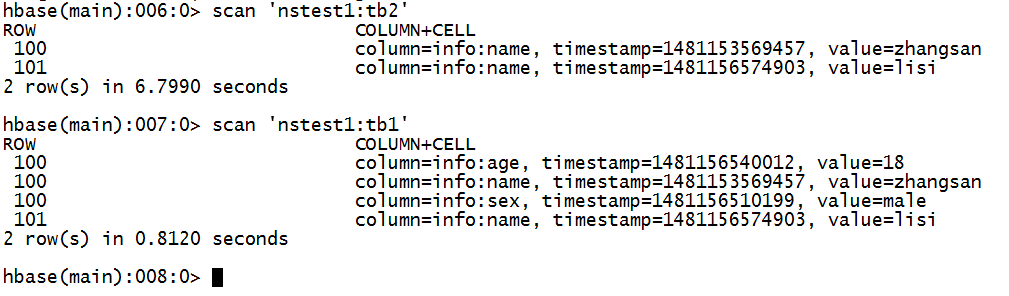

将nstest1:tb1的数据info:name列拷贝到nstest1:tb2

2.新建tb2表

3.书写mapreduce程序

输入:rowkey,result。

package com.beifeng.bigdat; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.hbase.Cell;

import org.apache.hadoop.hbase.CellUtil;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.client.Put;

import org.apache.hadoop.hbase.client.Result;

import org.apache.hadoop.hbase.client.Scan;

import org.apache.hadoop.hbase.io.ImmutableBytesWritable;

import org.apache.hadoop.hbase.mapreduce.TableMapReduceUtil;

import org.apache.hadoop.hbase.mapreduce.TableMapper;

import org.apache.hadoop.hbase.mapreduce.TableReducer;

import org.apache.hadoop.hbase.util.Bytes;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper.Context;

import org.apache.hadoop.util.Tool;

import org.apache.hadoop.util.ToolRunner; public class HBaseMRTest extends Configured implements Tool{

/**

* map

* @author *

*/

public static class tbMap extends TableMapper<ImmutableBytesWritable, Put>{ @Override

protected void map(ImmutableBytesWritable key, Result value,Context context) throws IOException, InterruptedException {

Put put=new Put(key.get());

for(Cell cell:value.rawCells()){

if("info".equals(Bytes.toString(CellUtil.cloneFamily(cell)))){

if("name".equals(Bytes.toString(CellUtil.cloneQualifier(cell)))){

put.add(cell);

context.write(key, put);

}

}

}

} }

/**

* reduce

* @author *

*/

public static class tbReduce extends TableReducer<ImmutableBytesWritable, Put, ImmutableBytesWritable>{ @Override

protected void reduce(ImmutableBytesWritable key, Iterable<Put> values,Context context)throws IOException, InterruptedException {

for(Put put:values){

context.write(key, put);

}

} } public int run(String[] args) throws Exception {

Configuration conf=super.getConf();

Job job =Job.getInstance(conf, "hbasemr");

job.setJarByClass(HBaseMRTest.class);

Scan scan=new Scan();

TableMapReduceUtil.initTableMapperJob(

"nstest1:tb1",

scan,

tbMap.class,

ImmutableBytesWritable.class,

Put.class,

job);

TableMapReduceUtil.initTableReducerJob(

"nstest1:tb2",

tbReduce.class,

job);

boolean issucess=job.waitForCompletion(true);

return issucess?0:1;

}

public static void main(String[] args) throws Exception{

Configuration conf=HBaseConfiguration.create();

int status=ToolRunner.run(conf, new HBaseMRTest(), args);

System.exit(status);

} }

4.打成jar包

5.运行语句

加上需要的export前提。

$HADOOP_HOME/bin/yarn jar /etc/opt/datas/HBaseMR.jar com.beifeng.bigdat.HBaseMRTest

6.效果

hbase与mapreduce集成的更多相关文章

- HBase概念学习(七)HBase与Mapreduce集成

这篇文章是看了HBase权威指南之后,依据上面的解说搬下来的样例,可是略微有些不一样. HBase与mapreduce的集成无非就是mapreduce作业以HBase表作为输入,或者作为输出,也或者作 ...

- HBase 与 MapReduce 集成

6. HBase 与 MapReduce 集成 6.1 官方 HBase 与 MapReduce 集成 查看 HBase 的 MapReduce 任务的执行:bin/hbase mapredcp; 环 ...

- 074 hbase与mapreduce集成

一:运行给定的案例 1.获取jar包里的方法 2.运行hbase自带的mapreduce程序 lib/hbase-server-0.98.6-hadoop2.jar 3.具体运行 注意命令:mapre ...

- 【HBase】HBase与MapReduce集成——从HDFS的文件读取数据到HBase

目录 需求 步骤 一.创建maven工程,导入jar包 二.开发MapReduce程序 三.结果 需求 将HDFS路径 /hbase/input/user.txt 文件的内容读取并写入到HBase 表 ...

- hbase运行mapreduce设置及基本数据加载方法

hbase与mapreduce集成后,运行mapreduce程序,同时需要mapreduce jar和hbase jar文件的支持,这时我们需要通过特殊设置使任务可以同时读取到hadoop jar和h ...

- 【HBase】HBase与MapReduce的集成案例

目录 需求 步骤 一.创建maven工程,导入jar包 二.开发MapReduce程序 三.运行结果 HBase与MapReducer集成官方帮助文档:http://archive.cloudera. ...

- 大数据技术之_11_HBase学习_02_HBase API 操作 + HBase 与 Hive 集成 + HBase 优化

第6章 HBase API 操作6.1 环境准备6.2 HBase API6.2.1 判断表是否存在6.2.2 抽取获取 Configuration.Connection.Admin 对象的方法以及关 ...

- Hbase与hive集成与对比

HBase与Hive的对比 1.Hive (1) 数据仓库 Hive的本质其实就相当于将HDFS中已经存储的文件在Mysql中做了一个双射关系,以方便使用HQL去管理查询. (2) 用于数据分析.清洗 ...

- 《OD大数据实战》HBase整合MapReduce和Hive

一.HBase整合MapReduce环境搭建 1. 搭建步骤1)在etc/hadoop目录中创建hbase-site.xml的软连接.在真正的集群环境中的时候,hadoop运行mapreduce会通过 ...

随机推荐

- 食物链 poj 1182

C - 食物链 Time Limit:1000MS Memory Limit:10000KB 64bit IO Format:%I64d & %I64u Submit Stat ...

- transient的理解

用法解释 1)一旦变量被transient修饰,变量将不再是对象持久化的一部分,该变量内容在序列化后无法获得访问. 2)transient关键字只能修饰变量,而不能修饰方法和类.注意,本地变量是不能被 ...

- extjs grid

Ext.onReady(function() { Ext.BLANK_IMAGE_URL = '../resources/images/default/s.gif'; Ext.QuickTips.in ...

- BZOJ3682 : Phorni

后缀平衡树+线段树. $O(1)$比较大小的标号法真是强大. #include<cstdio> #include<cmath> #define N 300010 #define ...

- HDU 2896 (AC自动机模板题)

题目链接: http://acm.hdu.edu.cn/showproblem.php?pid=2896 题目大意:多个模式串.多个匹配串.其中串的字符范围是(0~127).问匹配串中含有哪几个模式串 ...

- TextBlock 格式化内容

Text="{Binding ContentName,StringFormat=分享好书\{0\}}"

- TYVJ P1020 导弹拦截 Label:水

题目描述 某国为了防御敌国的导弹袭击,发展出一种导弹拦截系统.但是这种导弹拦截系统有一个缺陷:虽然它的第一发炮弹能够到达任意的高度,但是以后每一发炮弹都不能高于前一发的高度.某天,雷达捕捉到敌国的导弹 ...

- TYVJ P1093 验证数独 Label:none

背景 XX学校风靡一款智力游戏,也就是数独(九宫格),先给你一个数独,并需要你验证是否符合规则. 描述 具体规则如下:每一行都用到1,2,3,4,5,6,7,8,9,位置不限,每一列都用到1,2,3, ...

- [Cocos2d-x For WP8]Effects 特效

Effects是特殊类型的action.与修改常规的属性如透明度,位置,旋转或缩放等不同,它们修改的是一种新类型的属性:grid属性.grid属性像是一个模型,是一个线条交叉的网格,具体表现是一系列的 ...

- POJ 3335 Rotating Scoreboard(多边形的核)

题目链接 我看的这里:http://www.cnblogs.com/ka200812/archive/2012/01/20/2328316.html 然后整理一下当做模版.0换成eps,会wa,应该要 ...