18.linux日志收集数据到hdfs上面

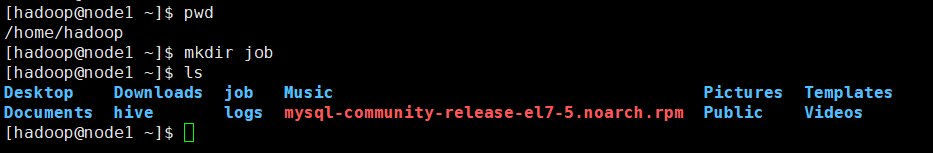

先创建一个目录

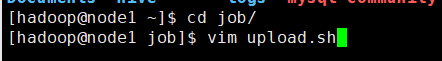

在这个job目录下创建upload.sh文件

[hadoop@node1 ~]$ pwd

/home/hadoop

[hadoop@node1 ~]$ mkdir job

[hadoop@node1 ~]$ ls

Desktop Downloads job Music Pictures Templates

Documents hive logs mysql-community-release-el7-.noarch.rpm Public Videos

[hadoop@node1 ~]$ cd job/

[hadoop@node1 job]$ vim upload.sh

对upload.sh进行编辑

#!/bin/bash #set java env

export JAVA_HOME=/opt/modules/jdk1..0_65

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH #set hadoop env

export HADOOP_HOME=/opt/modules/hadoop-2.6.

export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:$PATH log_src_dir=/home/hadoop/logs/log/

log_toupload_dir=/home/hadoop/logs/toupload/

hdfs_root_dir=/data/clickLog// echo "log_src_dir:"$log_src_dir

ls $log_src_dir | while read fileName

do

if [[ "$fileName" == access.log ]]; then

# if [ "access.log" = "$fileName" ];then

date=`date +%Y_%m_%d_%H_%M_%S`

#将文件移动到待上传目录并重命名

#打印信息

echo "moving $log_src_dir$fileName to $log_toupload_dir"xxxxx_click_log_$fileName"$date"

mv $log_src_dir$fileName $log_toupload_dir"xxxxx_click_log_$fileName"$date

#将待上传的文件path写入一个列表文件willDoing

echo $log_toupload_dir"xxxxx_click_log_$fileName"$date >> $log_toupload_dir"willDoing."$date

fi done #找到列表文件willDoing

ls $log_toupload_dir | grep will |grep -v "_COPY_" | grep -v "_DONE_" | while read line

do

#打印信息

echo "toupload is in file:"$line

#将待上传文件列表willDoing改名为willDoing_COPY_

mv $log_toupload_dir$line $log_toupload_dir$line"_COPY_"

#读列表文件willDoing_COPY_的内容(一个一个的待上传文件名) ,此处的line 就是列表中的一个待上传文件的path

cat $log_toupload_dir$line"_COPY_" |while read line

do

#打印信息

echo "puting...$line to hdfs path.....$hdfs_root_dir"

hadoop fs -put $line $hdfs_root_dir

done

mv $log_toupload_dir$line"_COPY_" $log_toupload_dir$line"_DONE_"

done

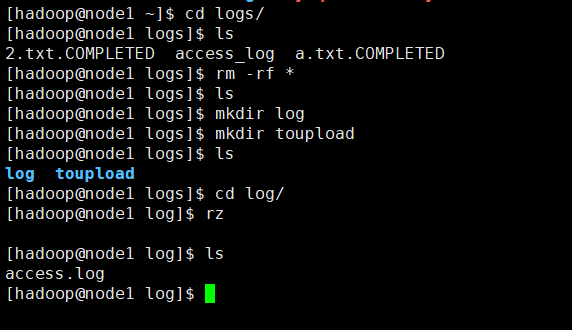

然后新建目录,并上传日志文件

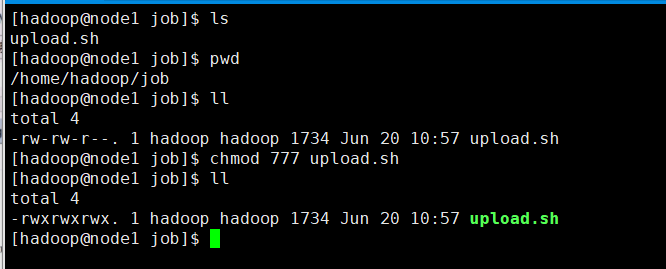

给脚本赋予权限

[hadoop@node1 job]$ ls

upload.sh

[hadoop@node1 job]$ pwd

/home/hadoop/job

[hadoop@node1 job]$ ll

total

-rw-rw-r--. hadoop hadoop Jun : upload.sh

[hadoop@node1 job]$ chmod upload.sh

[hadoop@node1 job]$ ll

total

-rwxrwxrwx. hadoop hadoop Jun : upload.sh

[hadoop@node1 job]$

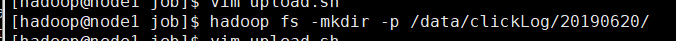

在HDFS上新建目录

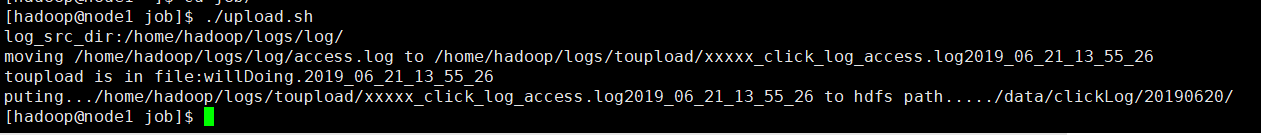

执行脚本

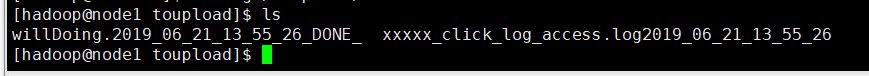

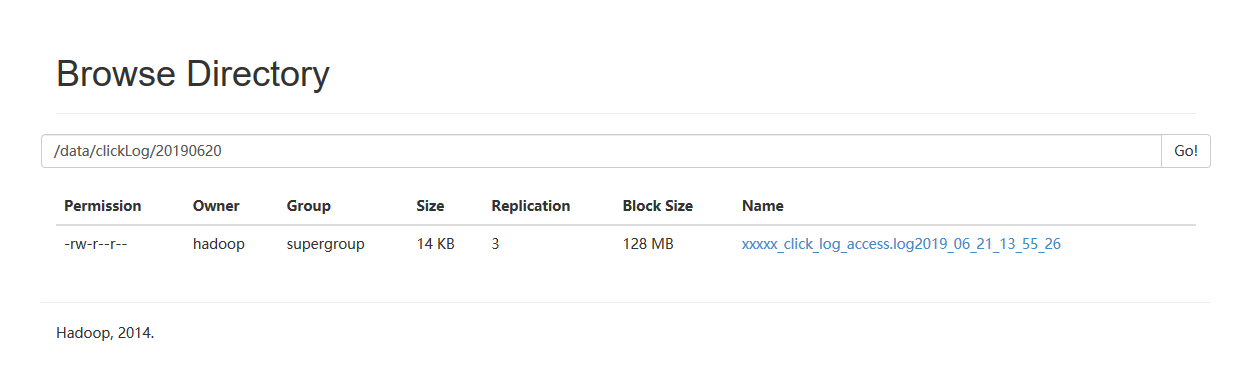

可以看到结果

18.linux日志收集数据到hdfs上面的更多相关文章

- 日志审计与分析实验三(rsyslog服务器端和客户端配置)(Linux日志收集)

Linux日志收集 一.实验目的: 1.掌握rsyslog配置方法 2.配置rsyslog服务收集其他Linux服务器日志: C/S架构:客户端将其日志上传到服务器端,通过对服务器端日志的查询,来实现 ...

- 大数据学习——实现多agent的串联,收集数据到HDFS中

采集需求:比如业务系统使用log4j生成的日志,日志内容不断增加,需要把追加到日志文件中的数据实时采集到hdfs,使用agent串联 根据需求,首先定义以下3大要素 第一台flume agent l ...

- Flume + HDFS + Hive日志收集系统

最近一段时间,负责公司的产品日志埋点与收集工作,搭建了基于Flume+HDFS+Hive日志搜集系统. 一.日志搜集系统架构: 简单画了一下日志搜集系统的架构图,可以看出,flume承担了agent与 ...

- Linux下rsyslog日志收集服务环境部署记录

rsyslog 可以理解为多线程增强版的syslog. 在syslog的基础上扩展了很多其他功能,如数据库支持(MySQL.PostgreSQL.Oracle等).日志内容筛选.定义日志格式模板等.目 ...

- Linux下rsyslog日志收集服务环境部署记录【转】

rsyslog 可以理解为多线程增强版的syslog. 在syslog的基础上扩展了很多其他功能,如数据库支持(MySQL.PostgreSQL.Oracle等).日志内容筛选.定义日志格式模板等.目 ...

- Flume-NG + HDFS + HIVE 日志收集分析

国内私募机构九鼎控股打造APP,来就送 20元现金领取地址:http://jdb.jiudingcapital.com/phone.html内部邀请码:C8E245J (不写邀请码,没有现金送)国内私 ...

- Scribe+HDFS日志收集系统安装方法

1.概述 Scribe是facebook开源的日志收集系统,可用于搜索引擎中进行大规模日志分析处理.其通常与Hadoop结合使用,scribe用于向HDFS中push日志,而Hadoop通过MapRe ...

- Linux下单机部署ELK日志收集、分析环境

一.ELK简介 ELK是elastic 公司旗下三款产品ElasticSearch .Logstash .Kibana的首字母组合,主要用于日志收集.分析与报表展示. ELK Stack包含:Elas ...

- Linux就这个范儿 第18章 这里也是鼓乐笙箫 Linux读写内存数据的三种方式

Linux就这个范儿 第18章 这里也是鼓乐笙箫 Linux读写内存数据的三种方式 P703 Linux读写内存数据的三种方式 1.read ,write方式会在用户空间和内核空间不断拷贝数据, ...

随机推荐

- PHP mysqli_num_fields() 函数

mysqli_num_fields() 函数返回结果集中字段(列)的数量. 语法 mysqli_num_fields(result); 参数 描述 result 必需.规定由 mysqli_query ...

- PHP mysqli_kill() 函数

定义和用法 mysqli_kill() 函数请求服务器杀死一个由 processid 参数指定的 MySQL 线程. 语法 mysqli_kill(connection,processid); 实 ...

- OSError: cannot open resource(pillow错误处理)

https://www.jianshu.com/p/c64ae3e9b196 pillow使用备忘之OSError: cannot open resource错误处理 在使用pillow过程中,Pyt ...

- 【csp模拟赛4】旅行计划 (travelling.cpp)--欧拉回路

[题目描述] 小 Z 打算趁着暑假,开启他的旅行计划.但与其他同学不同的是,小 Z 旅 行时并不关心到达了哪个网红景点打了哪些卡.小 Z 更关注沿路的风光,而且 小 Z 觉得,尽管多次到达同一个地方, ...

- 【csp模拟赛4】 珠江夜游 (cruise.cpp)-二分,贪心

Problem 1 珠江夜游 (cruise.cpp) [题目描述] 小 Z 放假后难得来一趟广州游玩,当然要吃遍广州各路美食小吃然后再 到珠江新城看看远近闻名的小蛮腰啦!可当小 Z 一路吃吃吃以后, ...

- codeforces555E

Case of Computer Network CodeForces - 555E Andrewid the Android is a galaxy-known detective. Now he ...

- deepin Linux 日常命令、插件、方法等汇总【更新中】

查看系统编码: dawn@dawn-PC:~$ locale LANG=zh_CN.UTF- LANGUAGE=zh_CN LC_CTYPE="zh_CN.UTF-8" LC_NU ...

- 使用UltraISO制作linux系统安装u盘启动盘

1.首先打开UltraISO软件,尽量下载最新版的,小编曾用某个旧版的UltraISO,制作的安装盘,不能不能识别磁盘,安装失败! 2.点击工具栏中的第二个打开镜像文件工具,如图红色方框标志按钮,然后 ...

- 删除Linux系统多余的引导

问题: 电脑中安装了多个Linux系统,需要删除不用的Linux系统的引导 解决方法: open terminal: su - 切换root用户 cd /boot/ ls ... grub ...

- LeetCode 41. 缺失的第一个正数(First Missing Positive)

题目描述 给定一个未排序的整数数组,找出其中没有出现的最小的正整数. 示例 1: 输入: [1,2,0] 输出: 3 示例 2: 输入: [3,4,-1,1] 输出: 2 示例 3: 输入: [7,8 ...