大数据框架-YARN

YARN(Yet Another Resource Negotiator): 是一种新的 Hadoop 资源管理器

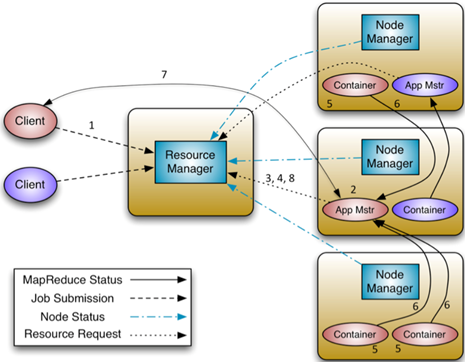

[ResourceManager:纯粹的调度器,基于应用程序对资源的需求进行调度的,不对应用进行监控和状态跟踪。ResourceManager中有一个模块叫做ApplicationsMaster,它是检测ApplicationMaster的运行状况,如果出问题,会将其在其他机器上重启。

ApplicationMaster:ApplicationMaster的主要作用是向ResourceManager申请资源并和NodeManager协同工作来运行应用的各个任务然后跟踪它们状态及监控各个任务的执行,遇到失败的任务还负责重启它。一个ApplicationMaster其实就是一个类库,一个ApplicationMaster类库何以对应多个实例。总结来说就是,每种类型的应用都会对应一个ApplicationMaster,每个类型的应用都可以启动多个ApplicationMaster实例。所以,在yarn中,每个job都会对应一个ApplicationMaster实例。

NodeManager:每个节点上的资源和任务管理器,负责Container状态的维护(接收并处理来自AM的Container启动/停止等各种请求),并向RM保持心跳(汇报本节点上的资源使用情况和Container的运行状态)。

YarnChild:用于表示任务执行的子进程。

Container:它是YARN中的资源抽象,它封装了某个节点上的多维度资源,如内存、CPU、磁盘、网络等,当ApplicationMaster向ResourceManager申请资源时,返回的资源便是用Container表示的。YARN会为每个任务分配一个Container,且该任务只能使用该Container中描述的资源。销毁与否由AppM决定,AppM发送指令让NM销毁Container。

|

1、客户端程序向ResourceManager提交应用并请求一个ApplicationMaster实例 2、ResourceManager找到可以运行一个Container的NodeManager,并在这个Container中启动ApplicationMaster实例 3、ApplicationMaster向ResourceManager进行注册,注册之后客户端就可以查询ResourceManager获得自己ApplicationMaster的详细信息,以后就可以和自己的ApplicationMaster直接交互了 4、在平常的操作过程中,ApplicationMaster根据resource-request协议向ResourceManager发送resource-request请求 5、当Container被成功分配之后,ApplicationMaster通过向NodeManager发送container-launch-specification信息来启动Container, container-launch-specification信息包含了能够让Container和ApplicationMaster交流所需要的资料 6、应用程序的代码在启动的Container中运行,并把运行的进度、状态等信息通过application-specific协议发送给ApplicationMaster 7、在应用程序运行期间,提交应用的客户端主动和ApplicationMaster交流获得应用的运行状态、进度更新等信息,交流的协议也是application-specific协议 8、一但应用程序执行完成并且所有相关工作也已经完成,ApplicationMaster向ResourceManager取消注册然后关闭,用到所有的Container也归还给系统。 |

Client通知RM,RM返回一个固定地址和jobID,作为HDFS上该job相关jar包的存放地址;同时Client提交job相关信息至RM,RM找到可运行container的NM,并启动该job的任务调度器AppM;该AppM注册到RM,并根据job的jar包相关资源信息来向RM申请资源;

AppM根据接受资源元数据通知NM分配Container资源;Container再向AppM注册;AM启动YarnChild进行任务调度和计算。

大数据框架-YARN的更多相关文章

- YARN之上的大数据框架REEF:微软出品,是否值得期待?

YARN之上的大数据框架REEF:微软出品,是否值得期待? 摘要:微软即将开源大数据框架REEF,REEF运行于Hadoop新一代资源管理器YARN的上层.对于机器学习等在数据传输.任务监控和结果 ...

- 大数据框架对比:Hadoop、Storm、Samza、Spark和Flink

转自:https://www.cnblogs.com/reed/p/7730329.html 今天看到一篇讲得比较清晰的框架对比,这几个框架的选择对于初学分布式运算的人来说确实有点迷茫,相信看完这篇文 ...

- 大数据框架:Spark vs Hadoop vs Storm

大数据时代,TB级甚至PB级数据已经超过单机尺度的数据处理,分布式处理系统应运而生. 知识预热 「专治不明觉厉」之“大数据”: 大数据生态圈及其技术栈: 关于大数据的四大特征(4V) 海量的数据规模( ...

- 大数据框架对比:Hadoop、Storm、Samza、Spark和Flink——flink支持SQL,待看

简介 大数据是收集.整理.处理大容量数据集,并从中获得见解所需的非传统战略和技术的总称.虽然处理数据所需的计算能力或存储容量早已超过一台计算机的上限,但这种计算类型的普遍性.规模,以及价值在最近几年才 ...

- 老李分享:大数据框架Hadoop和Spark的异同 1

老李分享:大数据框架Hadoop和Spark的异同 poptest是国内唯一一家培养测试开发工程师的培训机构,以学员能胜任自动化测试,性能测试,测试工具开发等工作为目标.如果对课程感兴趣,请大家咨 ...

- 老李分享:大数据框架Hadoop和Spark的异同

poptest是国内唯一一家培养测试开发工程师的培训机构,以学员能胜任自动化测试,性能测试,测试工具开发等工作为目标.如果对课程感兴趣,请大家咨询qq:908821478,咨询电话010-845052 ...

- [转载] 2 分钟读懂大数据框架 Hadoop 和 Spark 的异同

转载自https://www.oschina.net/news/73939/hadoop-spark-%20difference 谈到大数据,相信大家对Hadoop和Apache Spark这两个名字 ...

- 2分钟读懂大数据框架Hadoop和Spark的异同

转自:https://www.cnblogs.com/reed/p/7730313.html 谈到大数据,相信大家对Hadoop和Apache Spark这两个名字并不陌生.但我们往往对它们的理解只是 ...

- 大数据框架对比:Hadoop、Storm、Samza、Spark和Flink--容错机制(ACK,RDD,基于log和状态快照),消息处理at least once,exactly once两个是关键

分布式流处理是对无边界数据集进行连续不断的处理.聚合和分析.它跟MapReduce一样是一种通用计算,但我们期望延迟在毫秒或者秒级别.这类系统一般采用有向无环图(DAG). DAG是任务链的图形化表示 ...

随机推荐

- PAT 1033. To Fill or Not to Fill

#include <cstdio> #include <cstdlib> #include <vector> #include <algorithm> ...

- laravel JWT Auth - JSON Web令牌认证API

https://github.com/tymondesigns/jwt-auth/wiki

- js 密码 正则表达式

1. 代码 function checkPassword(str){ var reg1 = /[!@#$%^&*()_?<>{}]{1}/; var reg2 = /([a-zA- ...

- IDEA 自动生成serialVersionUID

场景:刚转到用IDEA,因为需要生成serialVersionUID,并没有自动生成. 转自:http://blog.csdn.net/liuzongl2012/article/details/451 ...

- elentment-ui解析

序言 现在前端的技术越来越杂,也越来越细了,以至于每次看完文档都会有个错觉,就是自己差不多会了.真正去做项目的时候又是重复之前的步骤. 之前写Java的时候,会习惯性的看看源码,看完之后会对知识掌握的 ...

- (C# 正则表达式)判断匹配, 提取字符串或数值

string s = "if ( \"ch\" == \"os\" ) "; string pattern = @"if\s*\( ...

- Idea工具使用

Idea Project与module的理解 1.基础环境的搭建 1.1.IDEA使用--字体.编码和基本设置 2.插件的安装 2.1.在IDEA中配置Gauge环境 2.2.IdeaVim的安装:: ...

- arm汇编学习(五)

新增个手写GNU语法arm的方法,以后可以狂逆狂写 hello.S文件 .data msg: .ascii "Hello, ARM!\n" len = . - msg .text ...

- SSIS ->> Environment Variables

SQL Server Integration Services(SSIS) 在2012版本引入了Environment Variables这个新特性.它允许我们为一个环境创建出一套变量用于为项目内的包 ...

- percona toolkit之slave工具

1:pt-slave-find ,主要是查找MySQL的层级,其实我感觉这个用处不是很大,因为层级比较多架构本身就很少,查看从库的话一般情况我们可以通过show slave hosts查看(不过不能显 ...