机器学习 Hidden Markov Models 2

Hidden Markov Models

下面我们给出Hidden Markov Models(HMM)的定义,一个HMM包含以下几个要素:

值得注意的一点是,这里面定义的概率都是与时间不相关的,意味着这些概率不会随着时间的变化而变化,这一点假设与实际情况不符合,但是将问题大大简化了。

如果一个系统可以用HMM来描述,那么HMM模型可以解决三类问题:

Evaluation:

通过HMM得到可观察变量的概率。这类问题属于识别问题,假设我们有很多描述不同系统的

HMM模型,和一组观察变量,我们想知道哪个HMM模型与这组观察变量最匹配,及最有可能生成这组观察变量。我们会用一种forward算法去计算每个HMM模型生成这组观察变量的概率,然后挑选生成概率

最大的HMM模型。这类问题最常见的是用于语音识别,语音识别会用到很多HMM模型,每个HMM模型都modeling一个特定的词汇,而观察变量就是一个说出口的词汇,那么找出最有可能生成这个词汇的HMM,从而确认该词汇是什么。

Decoding:

找到最可能生成可观察变量的隐藏变量。这是第二类问题,一般是寻找隐藏变量,通过观察变量,寻找隐藏变量。比如最初的天气系统,我们能够利用的观察变量(海草的状态),但是我们希望预测的是隐藏变量(天气)。我们会介绍Viterbi算法来解决这类问题。

Learning:

给定可观察变量,生成一个HMM。第三类问题,通常是最困难的一类问题,就是通过一组观察变量,以及观察变量与隐藏变量的关系(这里的关系不是转换矩阵,只是观察变量与隐藏变量的相关性),确定一个最佳的HMM模型,也就是要求出HMM的(πi,A,B)。我们会介绍forward-backward算法来解决这类问题。

接下来,我们将详细讨论这三类问题和相应的算法。

Forward Algorithm

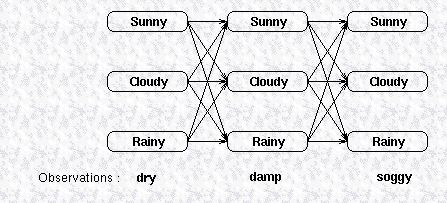

第一类问题是给定HMM模型,求解可观察变量的概率,我们仍然以天气预测为例,假设我们有一个HMM模型描述天气之间的转换关系,以及天气与海草的状态之间关系,现在我们有一组观察变量,比如说海草连续三天的状态,假设这三天的状态分别为(dry,damp,soggy),这三天的天气可能是晴天,雨天或多云的任何一种,我们用下图表示天气

与海草的状态之间的关系:

图中上面三行的每一列显示了可能的天气,而天气的每一个状态又会影响到下一天的天气状态,所以它们之间相互连接,天气之间的转换关系由状态转换矩阵给出,最下面一行是观察变量,隐藏变量生成观察变量的概率由confusion矩阵给出。要计算这个HMM模型生成观察变量的概率,最直观的一种方式是把所有可能路径的概率相加,在图上所示的模型里,有27种路径,所有要把27个概率之和相加,这显然是非常耗时的。

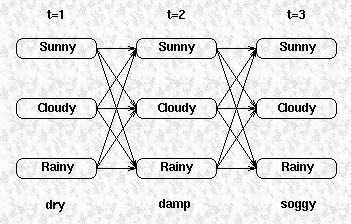

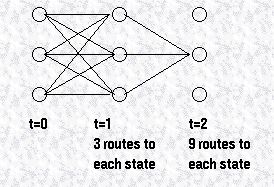

所以,我们换个角度考虑,我们采用一种递归的方式去计算观察变量的概率,我们先定义一个局部的概率用来表示马尔科夫过程到达一个中间状态的概率,我们先来看看如何计算这些中间概率,假设整个可观察变量序列长度为T,(Y1,Y2,...YT),考虑如下的一张图,给出了可观察变量的状态以及一阶转换关系,我们可以计算该模型到达某一中间状态的概率,就是所有到达该中间状态的路径的概率之和,比如我们想计算t=2时隐藏变量为Cloudy的概率:

所有到达Cloudy的路径可以由下图表示:

我们定义状态j在t时刻的局部概率为Pat(j),那么该局部概率可以表示为:

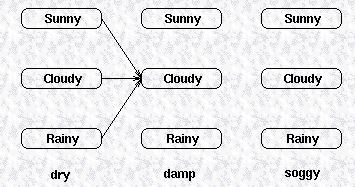

由此类推,该观察序列里,最后一个观察变量所对应的几个隐藏变量的局部概率包括了该HMM模型中,所有路径的概率之和,下图给出了该HMM模型最后一列状态的局部概率,

可以看到,该局部概率包括了该HMM模型的所有路径,所以这些局部概率之和就等于所有路径的概率之和,也就等于该HMM模型所生成的观察变量序列的概率。

虽然我们给出状态j在t时刻的局部概率表达式,但是对于t=1,即初始状态的局部概率,没有路径到达初始状态,我们用初始概率向量π定义状态的初始概率,即:

Pr(state|t=1)=π(state),因此初始状态j的局部概率为状态j的初始概率乘以associated observation概率:

我们已经给出了隐藏变量在初始状态的局部概率,也给出了隐藏变量在后续时刻的局部概率为:Pat(j)=Pr(observation | hidden state is j )×Pr(all paths to state j at time t),该表示中,右边的第一项是可以由confusion矩阵得到的,而为了计算右边的第二项,我们可以计算每个到达该状态的路径的概率,然后将所有的概率相加,如下图所示:

随着时序的增加,我们可以看到,要计算的路径会以指数级增长,但是由于这些局部概率之间存在的递归关系,我们可以用下列式子表示t+1时刻的局部概率与t时刻局部

概率的关系:

通过这几个表达式,我们可以计算一个观察序列在t=1,2,...T时刻的局部概率,然后将t=T时刻的局部概率相加,就是该HMM模型产生该观察序列的概率。

我们重新总结一下这个算法,利用forward算法计算一个时序长度为T的观察序列的概率,观察序列我们定义为如下所示:

其中,y表示观察变量的某个状态。隐藏变量的局部概率我们定义为:

而最终该观察序列的概率为:

所以通过给定的HMM模型,我们可以计算一个观察序列的概率。如果给定了一个观察序列,想要找到最匹配该观察序列的HMM模型,我们可以选择生成该观察序列的概率最高的HMM模型。

参考来源:

http://www.comp.leeds.ac.uk/roger/HiddenMarkovModels/html_dev/main.html

机器学习 Hidden Markov Models 2的更多相关文章

- 机器学习 Hidden Markov Models 1

Introduction 通常,我们对发生在时间域上的事件希望可以找到合适的模式来描述.考虑下面一个简单的例子,比如有人利用海草来预测天气,民谣告诉我们说,湿漉漉的海草意味着会下雨,而干燥的海草意味着 ...

- 机器学习 Hidden Markov Models 3

Viterbi Algorithm 前面我们提到过,HMM的第二类问题是利用HMM模型和可观察序列寻找最有可能生成该观察序列的隐藏变量的序列.简单来说,第一类问题是通过模型计算生成观察序列的概率,而第 ...

- 隐马尔科夫模型(Hidden Markov Models)

链接汇总 http://www.csie.ntnu.edu.tw/~u91029/HiddenMarkovModel.html 演算法笔记 http://read.pudn.com/downloads ...

- PRML读书会第十三章 Sequential Data(Hidden Markov Models,HMM)

主讲人 张巍 (新浪微博: @张巍_ISCAS) 软件所-张巍<zh3f@qq.com> 19:01:27 我们开始吧,十三章是关于序列数据,现实中很多数据是有前后关系的,例如语音或者DN ...

- 隐马尔科夫模型(Hidden Markov Models) 系列之三

转自:http://blog.csdn.net/eaglex/article/details/6418219 隐马尔科夫模型(Hidden Markov Models) 定义 隐马尔科夫模型可以用一个 ...

- [Bayesian] “我是bayesian我怕谁”系列 - Markov and Hidden Markov Models

循序渐进的学习步骤是: Markov Chain --> Hidden Markov Chain --> Kalman Filter --> Particle Filter Mark ...

- Hidden Markov Models笔记

Andrew Ng CS229 讲义: https://pan.baidu.com/s/12zMYBY1NLzkluHNeMNO6MQ HMM模型常用于NLP.语音等领域. 马尔科夫模型(Markov ...

- 隐马尔科夫模型(Hidden Markov Models) 系列之五

转自:http://blog.csdn.net/eaglex/article/details/6458541 维特比算法(Viterbi Algorithm) 找到可能性最大的隐藏序列 通常我们都有一 ...

- 隐马尔科夫模型(Hidden Markov Models) 系列之四

转自:http://blog.csdn.net/eaglex/article/details/6430389 前向算法(Forward Algorithm) 一.如果计算一个可观察序列的概率? 1 ...

随机推荐

- Python中%r与%s的区别

%r是rper()方法处理的对象 %s是str()方法处理的对象 其实有些情况下,两者处理的结果是一样的,比如说处理数据类型为int型对象: 例如1: print ('I am %d year old ...

- (7)ASP.NET WEB服务器控件

1. <body> <form id="form1" runat="server"> <div> <asp:Label ...

- Netty构建游戏服务器(三)--netty spring简单整合

一,基本方法 上节实现了netty的基本连接,这节加入spring来管理netty,由spring来开启netty服务. 在netty服务器中,我们建立了三个类:HelloServer(程序主入口) ...

- T3186 队列练习2 codevs

http://codevs.cn/problem/3186/ 题目描述 Description (此题与队列练习1相比改了2处:1加强了数据 2不保证队空时不会出队)给定一个队列(初始为空),只有两种 ...

- Codeforces Gym 100286J Javanese Cryptoanalysis 傻逼暴力

原题地址:http://codeforces.com/gym/100286/attachments/download/2013/20082009-acmicpc-northeastern-europe ...

- 常用业务返回对象类ResponseJson

目录 1.ResponseJson类 2.使用举例 1.ResponseJson类 import java.io.Serializable; public class ResponseJson imp ...

- PHP用CURL发送Content-type为application/json的HTTP/HTTPS请求

<?php $headers = array( "Content-type: application/json;charset='utf-8'", "Accept: ...

- 解密优秀博士成长史 ——微软亚洲研究院首届博士生学术论坛Panel讨论经验总结

编者按:有人说“一入博门深似海”,读博前应该做好哪些准备?作为一名博士生,应该有怎样的学术或职业规划?导师还是老板?怎样在师生关系上做到双赢?你是导师心目中优秀的博士生吗?相信以上问题在很多同学心中萦 ...

- 如何通过SQL注入获取服务器本地文件

写在前面的话 SQL注入可以称得上是最臭名昭著的安全漏洞了,而SQL注入漏洞也已经给整个网络世界造成了巨大的破坏.针对SQL漏洞,研究人员也已经开发出了多种不同的利用技术来实施攻击,包括非法访问存储在 ...

- LSA、LDA

Latent semantic analysis (LSA) is a technique in natural language processing, in particular distrib ...