使用“反向传播”迭代法求解y=√10

X=√10,求X,也就是求Y=10 =X2 , X是多少。

*重要的思想是,如何转化为可迭代求解的算法问题。

*解数学问题,第一时间画图,求导,“直线化”。

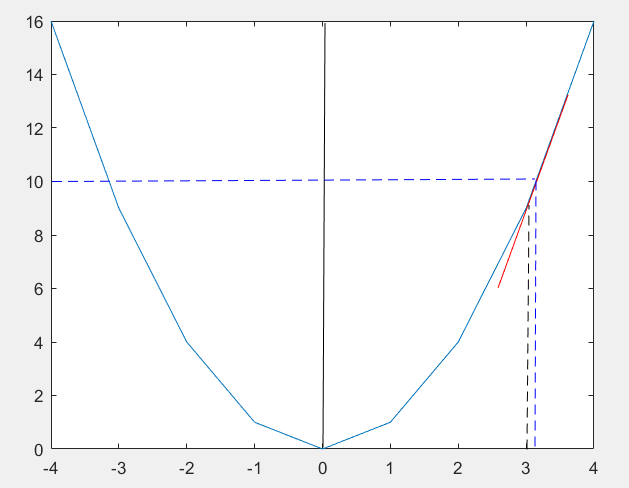

Y = X2

假如已知Y = 10 ,要求解X;

1. 令X=3,解得 y = 9 ;

那么,自然是希望,在X=3处,加上一个△X,得到

Y = y + k * △X ≈ 10;

已知,在X=3处,k = dy / dx = 2*X = 6,所以 △X = [(Y - y) / k] = △Y / k

我们也可以使用等式:△Y / △X = dY / dX 等价于 1 / △X = 6 ,△X = 1 / 6 ;

*在微分中,当△X很小时,△Y / △X = dY / dX;当X取得很接近真值时,认为△X很小。(下面讨论当△X比较大,也就是X取得不接近真值的情况);

2. 令X = X + △X = 3 + 1 / 6 = 3.16666666 ;y = 10.19444444;dY/dX =2X = 6.3333333;

△Y = 10 - 10.19444444 = -0.1944444444比之前更小了,解得△X = -0.03070;

3. 令X = X + △X = 3.13596666666;y = 9.834287;dY/dX = 2X = 6.27193333

△Y = 10 - 9.8342869344 = -0.1657130

.....

直到△Y满足精度为止;

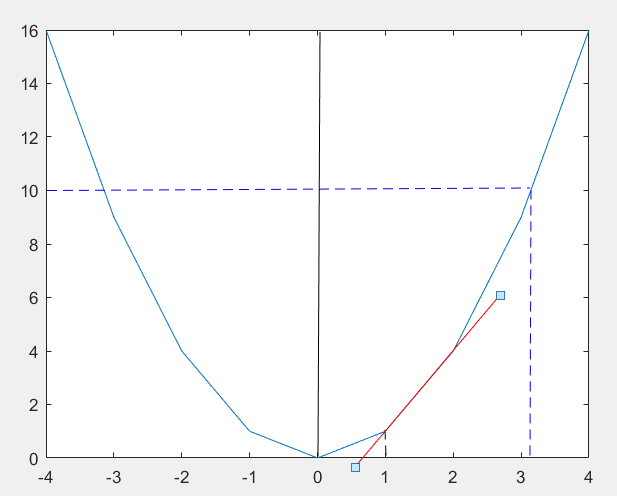

如果预测值X=1,和结果相差比较大,再看看;

1. 令X=1,解得 y = 1 ,dY/dX = 2X = 2 ;

△Y = 10 - 1 = 9 ,△X = 9 / 2 = 4.5;

2. X = X + △X = 5.5 , 解得 y = 30.25, dY/dX = 2X = 11

△Y = 10 - 30.25 = -20.25, △X = -20.25 / 11 = -1.84091

3. X = X + △X = 3.65909, 解得 y = 13.38894, dY/ dX = 2X = 7.31818

△Y = 10 - 13.38894 = -3.38894,△X = -3.38894 / 7.31818 = -0.4630851

4. X = X + △X = 3.196005,解得 y = 10.21445,dY/ dX = 2X = 6.39201

△Y = 10 - 10.21445 = -0.21445 ,△X = -0.21445 / 6.39201 = -0.0335497

5. X = X + △X = 3.1624553,解得 y = 10.001124,dY/ dX = 2X = 6.3249106

△Y = 10 - 10.21445 = -0.001124

....

X的预估值为1,离真值比较远,所以第2步出现“矫枉过正”的现象,但随即又修复了,因为每处在新的位置,都更新了X 和dY/ dX。

使用“反向传播”迭代法求解y=√10的更多相关文章

- DL反向传播理解

作者:寒小阳 时间:2015年12月. 出处:http://blog.csdn.net/han_xiaoyang/article/details/50321873 声明:版权所有,转载请联系作者并注明 ...

- 再谈反向传播(Back Propagation)

此前写过一篇<BP算法基本原理推导----<机器学习>笔记>,但是感觉满纸公式,而且没有讲到BP算法的精妙之处,所以找了一些资料,加上自己的理解,再来谈一下BP.如有什么疏漏或 ...

- [2] TensorFlow 向前传播算法(forward-propagation)与反向传播算法(back-propagation)

TensorFlow Playground http://playground.tensorflow.org 帮助更好的理解,游乐场Playground可以实现可视化训练过程的工具 TensorFlo ...

- [ch02-02] 非线性反向传播

系列博客,原文在笔者所维护的github上:https://aka.ms/beginnerAI, 点击star加星不要吝啬,星越多笔者越努力. 2.2 非线性反向传播 2.2.1 提出问题 在上面的线 ...

- Deep Learning 学习笔记(7):神经网络的求解 与 反向传播算法(Back Propagation)

反向传播算法(Back Propagation): 引言: 在逻辑回归中,我们使用梯度下降法求参数方程的最优解. 这种方法在神经网络中并不能直接使用, 因为神经网络有多层参数(最少两层),(?为何不能 ...

- BP(back propagation)反向传播

转自:http://www.zhihu.com/question/27239198/answer/89853077 机器学习可以看做是数理统计的一个应用,在数理统计中一个常见的任务就是拟合,也就是给定 ...

- 机器学习 —— 基础整理(七)前馈神经网络的BP反向传播算法步骤整理

这里把按 [1] 推导的BP算法(Backpropagation)步骤整理一下.突然想整理这个的原因是知乎上看到了一个帅呆了的求矩阵微分的方法(也就是 [2]),不得不感叹作者的功力.[1] 中直接使 ...

- AI之旅(7):神经网络之反向传播

前置知识 求导 知识地图 神经网络算法是通过前向传播求代价,反向传播求梯度.在上一篇中介绍了神经网络的组织结构,逻辑关系和代价函数.本篇将介绍如何求代价函数的偏导数(梯度). 梯度检测 在 ...

- 深度学习原理与框架-神经网络结构与原理 1.得分函数 2.SVM损失函数 3.正则化惩罚项 4.softmax交叉熵损失函数 5. 最优化问题(前向传播) 6.batch_size(批量更新权重参数) 7.反向传播

神经网络由各个部分组成 1.得分函数:在进行输出时,对于每一个类别都会输入一个得分值,使用这些得分值可以用来构造出每一个类别的概率值,也可以使用softmax构造类别的概率值,从而构造出loss值, ...

随机推荐

- 同时支持EF+Dapper的混合仓储,助你快速搭建数据访问层

背景 17年开始,公司开始向DotNet Core转型,面对ORM工具的选型,当时围绕Dapper和EF发生了激烈的讨论.项目团队更加关注快速交付,他们主张使用EF这种能快速开发的ORM工具:而在线业 ...

- 05-pandas索引切片读取数据缺失数据处理

引入 numpy已经能够帮助我们处理数据,能够结合matplotlib解决我们数据分析的问题,那么pandas学习的目的在什么地方呢? numpy能够帮我们处理处理数值型数据,但是这还不够 很多时候, ...

- vue- Vue-Cli脚手架工具安装 -创建项目-页面开发流程-组件生命周期- -03

目录 Vue-Cli 项目环境搭建 与 python 基础环境对比 环境搭建 创建启动 vue 项目 命令创建项目(步骤小多) 启动 vue 项目(命令行方式) 启动 vue 项目(pycharm 方 ...

- vue-cli脚手架项目本地阅览和在线阅览

一.需求 开发环境:当然啦,前提是你要完整检测整个项目无错误的运行:npm run dev 后项目在本地预览问题没有问题 二.服务器本地阅览 生产环境:项目制作完成后需执行npm run build操 ...

- margin和text-align实现水平居中的区别

1.首先text-align只应用于内联块和内联元素 text-align影响的是元素中的文本内容的对其方式(默认是left,设置为center时水平居中) 所以,将text-align设置为cent ...

- 用go语言爬取珍爱网 | 第三回

前两节我们获取到了城市的URL和城市名,今天我们来解析用户信息. 用go语言爬取珍爱网 | 第一回 用go语言爬取珍爱网 | 第二回 爬虫的算法: 我们要提取返回体中的城市列表,需要用到城市列表解析器 ...

- 什么是STM32的ISP?

上一篇笔记分享了STM32的串口IAP实例:STM32串口IAP分享.其中,下载IAP程序时用ISP的方式进行下载.这里的ISP又是什么呢? ISP方式下载程序原理 ISP:In System Pro ...

- LeetCode初级算法--链表02:合并两个有序链表

LeetCode初级算法--链表02:合并两个有序链表 搜索微信公众号:'AI-ming3526'或者'计算机视觉这件小事' 获取更多算法.机器学习干货 csdn:https://blog.csdn. ...

- ASP.NET Core API ——Dapper的使用

ASP.NET Core API ——Dapper的使用 简介:Dapper是一个ORM框架,负责数据库和程序语言之间的映射. 使用步骤: l 创建一个IDBConnection的接口对象 l 编 ...

- 代码审计-phpcms9任意文件读取

漏洞文件: /phpcms/modules/content/down.php download函数 这个函数开始几行代码的作用和init函数中的几乎一样,都是从parse_str 解析传入的a_k参数 ...