python 爬虫时遇到问题及解决

源代码:

#unicoding=utf-8

import re

import urllib

def gethtml(url):

html=urllib.urlopen(url)

page=html.read()

return page

def img(page):

reg=r'src="(.+?\jpg)" alt'

imgre=re.compile(reg)

imglist=re.findall(imgre,page)

x=0

for imgurl in imglist:

urllib.urlretrieve(imgurl,'%s.jpg' % x)

x+=1

#page=gethtml("http://www.51tietu.net/tp/")

page=gethtml("http://mm.51tietu.net/qingchun/90/")

img(page)

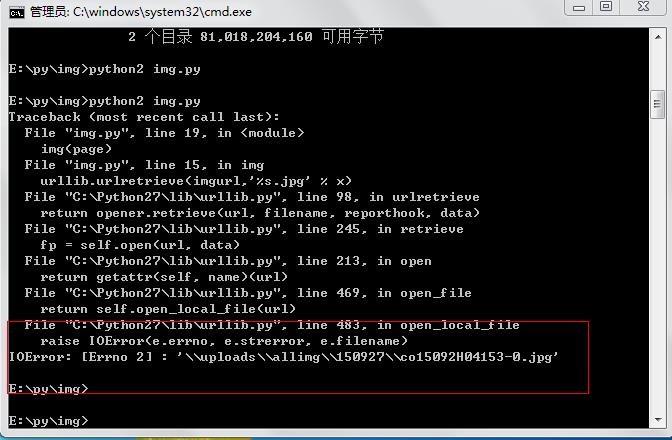

这样执行的话,会出现IOError 大致意思时文件操作时,出现错误

在这里可以看到IOError后跟着你抓取到的jip文件的路径,但是这个路径不是整个url的路径,所以才会在urlretrieve调用imgurl的时候报错。

去网站查看整个URL

因此可以根据图中的url进行修改代码, 想法:可以在urlretrieve中把url补完整,之后代码如下

#unicoding=utf-8

import re

import urllib

def gethtml(url):

html=urllib.urlopen(url)

page=html.read()

return page

def img(page):

reg=r'src="(.+?\jpg)" alt'

imgre=re.compile(reg)

imglist=re.findall(imgre,page)

x=0

for imgurl in imglist:

urllib.urlretrieve('http://mm.51tietu.net'+imgurl,'%s.jpg' % x)

x+=1

#page=gethtml("http://www.51tietu.net/tp/")

page=gethtml("http://mm.51tietu.net/qingchun/90/")

img(page)

之后再进行运行的话,就可以将图片爬取到本地了。

效果如下:

python 爬虫时遇到问题及解决的更多相关文章

- Python爬虫老是被封的解决方法【面试必问】

在爬取的过程中难免发生 ip 被封和 403 错误等等,这都是网站检测出你是爬虫而进行反爬措施,在这里为大家总结一下 Python 爬虫动态 ip 代理防止被封的方法. PS:另外很多人在学习Pyth ...

- python爬虫时,解决编码方式问题的万能钥匙(uicode,utf8,gbk......)

转载 原文:https://blog.csdn.net/xiongzaiabc/article/details/81008330 无论遇到的网页代码是何种编码方式,都可以用以下方法统一解决 imp ...

- Python 爬虫常见的坑和解决方法

1.请求时出现HTTP Error 403: Forbidden headers = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:23. ...

- python爬虫框架scrapy问题的解决

2016-09-24:今天的弄了一天的scrapy的环境的配置的,linux很多的学过的事情都忘记啦.理论和实践的结合还是非常的重要的,不光要学会思考,更要学会总结纪录.还要多多回忆的和复习.学习了不 ...

- Python爬虫技术:爬虫时如何知道是否代理ip伪装成功?

前言本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. python爬虫时如何知道是否代理ip伪装成功: 有时候我们的爬虫程序添加了 ...

- Python爬虫:设置Cookie解决网站拦截并爬取蚂蚁短租

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: Eastmount PS:如有需要Python学习资料的小伙伴可以加 ...

- 从python爬虫引发出的gzip,deflate,sdch,br压缩算法分析

今天在使用python爬虫时遇到一个奇怪的问题,使用的是自带的urllib库,在解析网页时获取到的为b'\x1f\x8b\x08\x00\x00\x00\x00...等十六进制数字,尝试使用chard ...

- Python爬虫之xpath语法及案例使用

Python爬虫之xpath语法及案例使用 ---- 钢铁侠的知识库 2022.08.15 我们在写Python爬虫时,经常需要对网页提取信息,如果用传统正则表达去写会增加很多工作量,此时需要一种对数 ...

- python爬虫中文乱码解决方法

python爬虫中文乱码 前几天用python来爬取全国行政区划编码的时候,遇到了中文乱码的问题,折腾了一会儿,才解决.现特记录一下,方便以后查看. 我是用python的requests和bs4库来实 ...

随机推荐

- HDU 2653 - Waiting ten thousand years for Love

首先,对于一个 '@' 飞上去,飞下来都要耗1点魔力,所以是两点= = 然后站在同一格 魔力可能不同,所以要增加一维. 还有当前搜到的不一定是最小. 别的也没啥. #include <iostr ...

- JSON数据的基础使用

之前一直把JSON想做一种数据类型,通过这几天的使用,发现其实JSON只是一种数据的格式,而与int string double等等数据类型是有本质的区别. JSON(JavaScript Objec ...

- 在右键添加Cmder here选项,添加启动Cmder的快捷键

右键菜单添加“Cmder here” 打开cmder,在其中输入: cmder /register user 或 cmder /register all 即可 设置启动cmder的快捷键 右键 C ...

- AsyncTask加载图片

http://blog.csdn.net/sodino/article/details/7741674 http://www.cnblogs.com/weisenz/archive/2012/04/1 ...

- 评价早期SaaS创业公司时,投资人在关注什么?(是否有机会发展成一个平台,长期的护城河)

编者按: 当聊到早期项目时,人们经常会问投资人一个问题:“在评价早期 SaaS 创业公司时,投资人会关注什么——指标还是其他方面?” Nakul Mandan 作为 Lightspeed 风投机构的合 ...

- 【MYSQL 清空所有的的表中的数据的SQL的生成】

MYSQL 清空所有的的表中的数据的SQL的生成 select Concat('TRUNCATE TABLE ', TABLE_NAME, ';') from INFORMATION_SCHEMA.T ...

- 《how to design programs》9.3处理任意长度的表

假定一个玩具商店要把货物库存清单存放在计算机之中,这样,店里的员工就可以快速判断商店里是否还有某种玩具存货.简言之,商店需要一个能够检查库存是否含有玩具'doll 的函数contains-doll?, ...

- Eclipse setting Java code style and codetemplate

1.open the eclipse tool window First click the Window menu,then check the children's menu which name ...

- 【具体数学 读书笔记】1.2 Lines in the Plane

本节介绍平面划分问题,即n条直线最多把一个平面划分为几个区域(region). 问题描述: "What is the maximum number Ln of regions defined ...

- xmpp总结

1. 浅谈对于XMPP协议自己的看法以及对其理解 http://blog.sina.com.cn/s/blog_69f68f880102uyeg.html 2. XMPP协议学习笔记一 http:// ...