HBase安装指南

一.事前准备

- 此安装是建立在hadoop集群运行起来的基础上,此hadoop版本为2.6.0,其他版本未测试,可能存在兼容性问题。

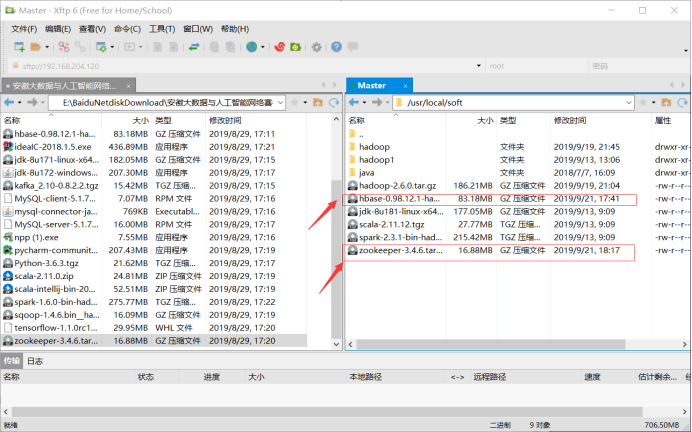

- 上传所需文件到/usr/local/soft

二.zookeeper安装

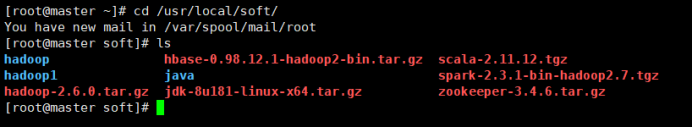

1.进入文件所在目录:cd /usr/local/soft/

2. 解压:tar -zxvf zookeeper-3.4.6.tar.gz

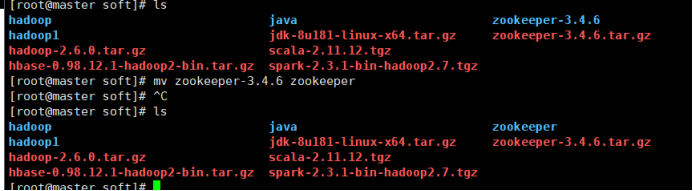

3. 重命名:mv zookeeper-3.4.6 zookeeper

4. 进入conf目录:cd zookeeper/conf/

5. 复制并重命名zoo_sample.cfg为zoo.cfg:cp zoo_sample.cfg zoo.cfg

6.返回上一级,并新建一个data文件夹:mkdir data

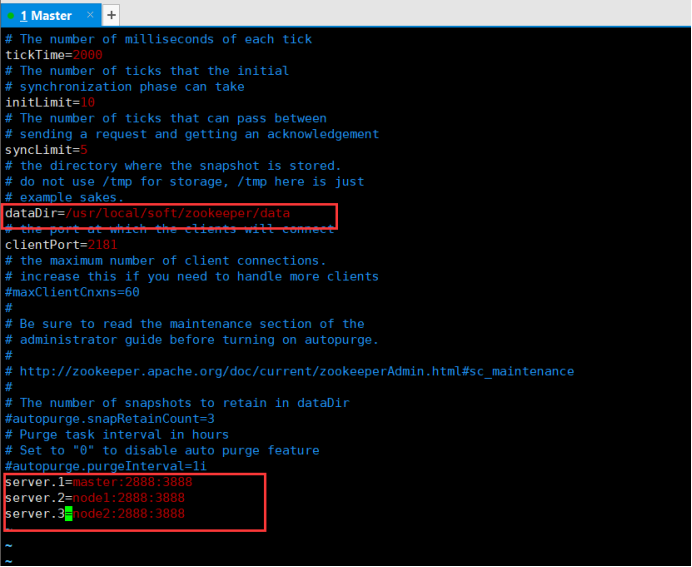

7.进入zoo.cfg文件并修改配置如下:vim conf/zoo.cfg

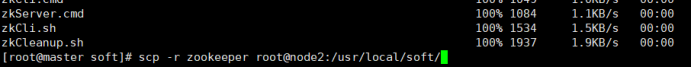

8. 返回软件安装目录soft,并将该配置目录同步到node1,node2

scp -r zookeeper root@node1:/usr/local/soft/

scp -r zookeeper root@node2:/usr/local/soft/

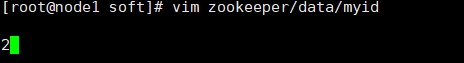

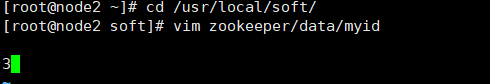

9.分别修改个三台主机的对应id:vim zookeeper/data/myid

10.启动zookeeper(三台都执行):bin/zkServer.sh start

11. 验证zookeeper(三台都执行):bin/zkServer.sh status

注意:node1为leader,master,node2为follower

以上zookeeper安装完成

三.Hbase安装

1.回到soft目录下,解压hbase:tar -zxvf hbase-0.98.12.1-hadoop2-bin.tar.gz

2.重命名hbase :mv hbase-0.98.12.1-hadoop2 hbase

3.配置profile文件并发送给其他节点:

vim /etc/profile.d/hbase.sh

# SET HBASE

export HBASE_HOME=/usr/local/soft/hbase

export PATH=$HBASE_HOME/bin:$PATH

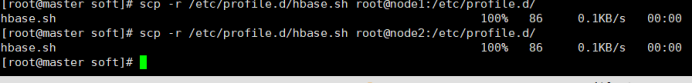

发送节点:

scp -r /etc/profile.d/hbase.sh root@node1:/etc/profile.d/

scp -r /etc/profile.d/hbase.sh root@node2:/etc/profile.d/

4.使配置生效(三台都执行):source /etc/profile

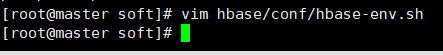

5.修改hbase-env.sh配置文件: vim hbase/conf/hbase-env.sh

export JAVA_HOME=/usr/local/soft/java

export HBASE_MANAGES_ZK=false

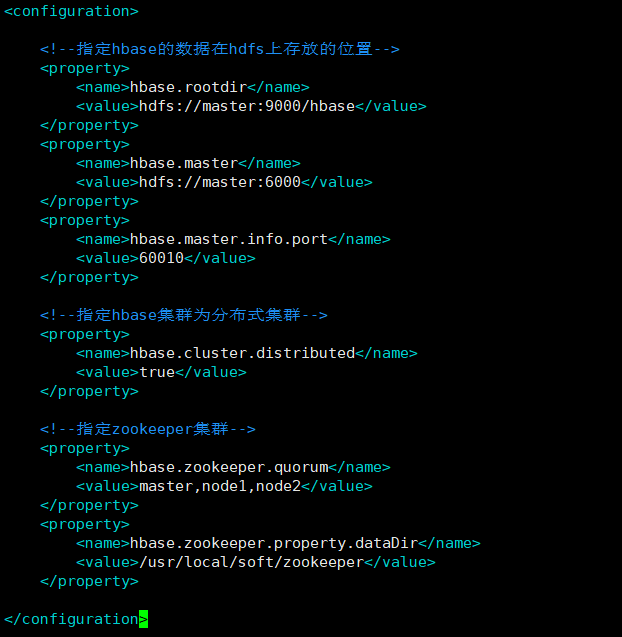

6.修改hbase-site.xml配置文件:vim hbase/conf/hbase-site.xml

<!--指定hbase的数据在hdfs上存放的位置-->

<property>

<name>hbase.rootdir</name>

<value>hdfs://master:9000/hbase</value>

</property>

<property>

<name>hbase.master</name>

<value>hdfs://master:6000</value>

</property>

<property>

<name>hbase.master.info.port</name>

<value>60010</value>

</property>

<!--指定hbase集群为分布式集群-->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!--指定zookeeper集群-->

<property>

<name>hbase.zookeeper.quorum</name>

<value>master,node1,node2</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/usr/local/soft/zookeeper</value>

</property>

7. 设置备用:vim hbase/conf/backup-masters

8. 修改regionservers 配置文件:vim hbase/conf/regionservers

9.复制hadoop配置文件到hbase目录下:

cp hadoop/etc/hadoop/core-site.xml hbase/conf/

cp hadoop/etc/hadoop/hdfs-site.xml hbase/conf/

10.将hbase安装目录发送到其他节点:

scp -r hbase root@node1:/usr/local/soft/

scp -r hbase root@node2:/usr/local/soft/

11.启动hbase:start-hbase.sh

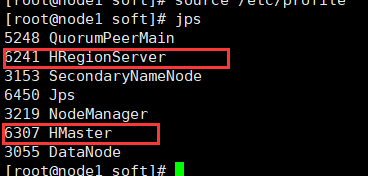

12.各节点jps截图:

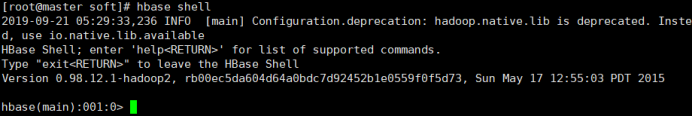

13. 验证hbase

网页验证:

简单命令验证

HBase安装指南的更多相关文章

- 菜鸟玩云计算之十一:Hadoop 手动安装指南

Hadoop 手动安装指南 cheungmine 2013-4 本文用于指导在Windows7,VMWare上安装Ubuntu, Java, Hadoop, HBase实验环境. 本指南用于实验的软件 ...

- Hadoop+HBase+Spark+Hive环境搭建

杨赟快跑 简书作者 2018-09-24 10:24 打开App 摘要:大数据门槛较高,仅仅环境的搭建可能就要耗费我们大量的精力,本文总结了作者是如何搭建大数据环境的(单机版和集群版),希望能帮助学弟 ...

- Hive 1.2.1&Spark&Sqoop安装指南

目录 目录 1 1. 前言 1 2. 约定 2 3. 服务端口 2 4. 安装MySQL 2 4.1. 安装MySQL 2 4.2. 创建Hive元数据库 4 5. 安装步骤 5 5.1. 下载Hiv ...

- HBase-1.2.1和Phoenix-4.7.0分布式安装指南

目录 目录 1 1. 前言 2 2. 概念 2 2.1. Region name 2 3. 约定 2 4. 相关端口 3 5. 下载HBase 3 6. 安装步骤 3 6.1. 修改conf/regi ...

- HBase-0.98.0和Phoenix-4.0.0分布式安装指南

目录 目录 1 1. 前言 1 2. 约定 2 3. 相关端口 2 4. 下载HBase 2 5. 安装步骤 2 5.1. 修改conf/regionservers 2 5.2. 修改conf/hba ...

- ZooKeeper-3.4.10分布式安装指南

目录 目录 1 1. 前言 1 2. 约定 1 3. 安装步骤 2 3.1. 配置/etc/hosts 2 3.2. 设置myid 2 3.3. 修改conf/zoo.cfg 2 3.4. 修改/bi ...

- Mapreduce的文件和hbase共同输入

Mapreduce的文件和hbase共同输入 package duogemap; import java.io.IOException; import org.apache.hadoop.co ...

- Redis/HBase/Tair比较

KV系统对比表 对比维度 Redis Redis Cluster Medis Hbase Tair 访问模式 支持Value大小 理论上不超过1GB(建议不超过1MB) 理论上可配置(默认配置1 ...

- Hbase的伪分布式安装

Hbase安装模式介绍 单机模式 1> Hbase不使用HDFS,仅使用本地文件系统 2> ZooKeeper与Hbase运行在同一个JVM中 分布式模式– 伪分布式模式1> 所有进 ...

随机推荐

- VIJOS-P1045 Kerry 的电缆网络

JDOJ 1229: VIJOS-P1045 Kerry 的电缆网络 https://neooj.com/oldoj/problem.php?id=1229 Description K ...

- JS中的箭头函数与this

转载自:https://juejin.im/post/5aa1eb056fb9a028b77a66fd#heading-1 JavaScript在ES6语法中新增了箭头函数,相较于传统函数,箭头函数不 ...

- appium--解决每次安装appium setting和Unlock

前戏 每次启动appium进行自动化的时候,都会提示我们需要安装appium setting和Unlock,而且还都要手动确认 那这两个文件是做什么的呢? Appium settings:用于设置网络 ...

- echarts的markline的使用 y轴预警线

代码示例: app.title = '坐标轴刻度与标签对齐'; option = { color: ['#3398DB'], tooltip : { trigger: 'axis', axisPoin ...

- [LeetCode] 738. Monotone Increasing Digits 单调递增数字

Given a non-negative integer N, find the largest number that is less than or equal to N with monoton ...

- Codeforces Round #607 (Div. 1) Solution

从这里开始 比赛目录 我又不太会 div 1 A? 我菜爆了... Problem A Cut and Paste 暴力模拟一下. Code #include <bits/stdc++.h> ...

- chrome浏览器如何查看、修改、删除Cookie

1.chrome浏览器的cookie保存位置 C:\Users\你的用户名\AppData\Local\Google\Chrome\User Data\Default 快捷键win+r--> ...

- intellij idea 解决2019年4月到期延期问题

56ZS5PQ1RF-eyJsaWNlbnNlSWQiOiI1NlpTNVBRMVJGIiwibGljZW5zZWVOYW1lIjoi5q2j54mI5o6I5p2DIC4iLCJhc3NpZ25lZ ...

- 拼数(C++)

问题: 设有n个正整数,将他们排成一排,组成一个最大的多位整数. INPUT: 第一行,正整数的个数n 第二行,n个正整数 OUTPUT: 一个正整数,表示最大的整数. 输入样例: 3 13 312 ...

- python字符串格式化方法%s和format函数

1.%s方法 一个例子 print("my name is %s and i am %d years old" %("xiaoming",18) 输出结果:my ...