二、spark SQL交互scala操作示例

一、安装spark

spark SQL是spark的一个功能模块,所以我们事先要安装配置spark,参考:

https://www.cnblogs.com/lay2017/p/10006935.html

二、数据准备

演示操作将从一个类似json文件里面读取数据作为数据源,并初始化为dataframe,我们准备一个user.json文件

在/usr/local/hadoop/spark目录(可以自定义目录)下新建一个user.json文件内容如下:

{"id" : "1201", "name" : "satish", "age" : "25"}

{"id" : "1202", "name" : "krishna", "age" : "28"}

{"id" : "1203", "name" : "amith", "age" : "39"}

{"id" : "1204", "name" : "javed", "age" : "23"}

{"id" : "1205", "name" : "prudvi", "age" : "23"}

文件内容类似json,但是不是json,按照一行一行的结构

三、spark SQL示例

先启动spark-shell

spark-shell

初始化一个SQLContext,传入sparkContext

var sqlContext = new org.apache.spark.sql.SQLContext(sc)

读取user.json文件作为dataFrame

var dfs = sqlContext.read.json("/usr/local/hadoop/spark/user.json")

dataFrame操作

查询age > 25的name的数据

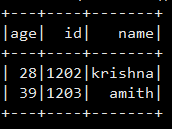

dfs.filter(dfs("age") > 25).select("name").show()

你会看到

sql操作

创建一个临时表

dfs.createOrReplaceTempView("t_user")

编写SQL

var sqlDf = spark.sql("select * from t_user where age > 25")

显示结果

sqlDf.show()

显示如下

二、spark SQL交互scala操作示例的更多相关文章

- 十一、spark SQL的scala示例

简介 spark SQL官网:http://spark.apache.org/docs/latest/sql-programming-guide.html sparkSQL是构建在sparkCore之 ...

- spark sql的简单操作

测试数据 sparkStu.text zhangxs chenxy wangYr teacher wangx teacher sparksql { ,"job":"che ...

- [Spark SQL_3] Spark SQL 高级操作

0. 说明 DataSet 介绍 && Spark SQL 访问 JSON 文件 && Spark SQL 访问 Parquet 文件 && Spark ...

- 理解Spark SQL(二)—— SQLContext和HiveContext

使用Spark SQL,除了使用之前介绍的方法,实际上还可以使用SQLContext或者HiveContext通过编程的方式实现.前者支持SQL语法解析器(SQL-92语法),后者支持SQL语法解析器 ...

- Spark SQL知识点大全与实战

Spark SQL概述 1.什么是Spark SQL Spark SQL是Spark用于结构化数据(structured data)处理的Spark模块. 与基本的Spark RDD API不同,Sp ...

- Spark SQL知识点与实战

Spark SQL概述 1.什么是Spark SQL Spark SQL是Spark用于结构化数据(structured data)处理的Spark模块. 与基本的Spark RDD API不同,Sp ...

- Spark SQL 官方文档-中文翻译

Spark SQL 官方文档-中文翻译 Spark版本:Spark 1.5.2 转载请注明出处:http://www.cnblogs.com/BYRans/ 1 概述(Overview) 2 Data ...

- 【转载】Spark SQL之External DataSource外部数据源

http://blog.csdn.net/oopsoom/article/details/42061077 一.Spark SQL External DataSource简介 随着Spark1.2的发 ...

- Apache Spark 2.2.0 中文文档 - Spark SQL, DataFrames and Datasets Guide | ApacheCN

Spark SQL, DataFrames and Datasets Guide Overview SQL Datasets and DataFrames 开始入门 起始点: SparkSession ...

随机推荐

- AVA + Spectron + JavaScript 对 JS 编写的客户端进行自动化测试

什么是 AVA (类似于 unittest) AVA 是一种 JavaScript 单元测试框架,是一个简约的测试库.AVA 它的优势是 JavaScript 的异步特性和并发运行测试, 这反过来提高 ...

- 3D-2D:PnP

PnP(Perspective-n-Point):当知道n个3D空间点及其投影位置时,估计相机位姿. 2D-2D的对极几何方法需要八个或八个以上的点对(以八点法为例),且存在着初始化.纯旋转和尺度的问 ...

- Java 读写锁的实现

一. synchronized和ReentrantLock的对比 到现在,看到多线程中,锁定的方式有2种:synchronized和ReentrantLock.两种锁定方式各有优劣,下面简单对比 ...

- centos启动错误:Inodes that were part of a corrupted orphan linked list found.

centos启动时,提示错误: /dev/mapper/VolGroup-lv_root contains a file system with errors,check forced. /dev/m ...

- python有哪些比较隐藏的知识点?

一.复用小整数以及小字符串 在Python语言中,设计者在优化Python语言时,为了提高Python的运行效率,所以就将一些小整数保存在系统表,没有释放回收(正常情况下,当Python中一个对象没有 ...

- 编程开发之--java多线程学习总结(2)同步代码块

1.第一种解决办法:同步代码块,关键字synchronized package com.lfy.ThreadsSynchronize; /** * 1.使用同步代码块 * 语法: synchroniz ...

- 用 Hystrix 构建高可用服务架构

1 hystrix是什么 在分布式系统中,每个服务都可能会调用很多其他服务,被调用的那些服务就是依赖服务,有的时候某些依赖服务出现故障也是很正常的. Hystrix 可以让我们在分布式系统中对服务间的 ...

- 厉害了,七牛云 CEO 来讲架构了!

说起许式伟,你应该不陌生,他是七牛云的CEO,ECUG 社区发起人,国内 Go 语言圈的领军人物,曾就职于金山.盛大,有超过 10 年的搜索和分布式存储相关技术的研发经验. 他的个人经历颇为传奇,大学 ...

- 逆向学习-Windows消息钩取

钩子 Hook,就是钩子.偷看或截取信息时所用的手段或工具. 消息钩子 常规Windows流: 1.发生键盘输入事件时,WM_KEYDOWN消息被添加到[OS message queue]. 2.OS ...

- 【性能测试】:LR中解决接口请求中包含中文字符,服务器不识别的问题

在LR中,直接写的接口请求,如果请求字段包含中文字段,服务器会不识别,这个时候就要用到lr_convert_string_encoding这个函数: 具体用法: lr_convert_string_e ...