Qt音视频开发05-保存视频文件(yuv/h264/mp4)

一、前言

和音频存储类似,视频的存储也对应三种格式,视频最原始的数据是yuv(音频对应pcm),视频压缩后的数据是h264(音频对应aac),由于很多播放器或者早期的播放器不支持直接播放h264文件,所以需要用编码器编码成mp4格式,这块就需要用到ffmpeg里面一整套的编码流程,对yuv数据进行编码成MP4格式存储。

在经过对各种视频文件或者视频流保存的过程中,发现rtsp这类的视频流可以直接编码打包存储,不需要经过 avcodec_send_frame avcodec_receive_packet 这两个步骤对每个包编码,这样可以极大的降低CPU占用,猜测可能是rtsp视频流收到的数据包packet就已经是标准的h264裸流带了各种pps啥的。所以视频监控领域如果要同时存储16路32路视频,采用这个策略是最稳妥的,相当于一直写文件。很多人会觉得编码流程繁琐,其实只要静下心来,挨个测试,把流程搞懂,基本上都是水到渠成的事情。包括之前遇到的保存的文件鼠标右键属性中看不到分辨率等参数信息,原来是调用写入文件头 avformat_write_header 写入的时机不对,一定要在打开打开视频编码器 avcodec_open2 以及打开输出文件 avio_open 以后再写入。

编码保存的大致流程:

- 查找编码器 avcodec_find_encoder

- 创建编码器 avcodec_alloc_context3

- 设置编码器 pix_fmt/time_base/framerate/width/height

- 打开编码器 avcodec_open2

- 创建上下文 avformat_alloc_output_context2

- 创建输出流 avformat_new_stream

- 设置流参数 avcodec_parameters_from_context

- 写入开始符 avformat_write_header

- 发送数据帧 avcodec_send_frame

- 打包数据帧 avcodec_receive_packet

- 写入数据帧 av_interleaved_write_frame

- 写入结尾符 av_write_trailer

- 释放各资源 avcodec_free_context/avio_close/avformat_free_context

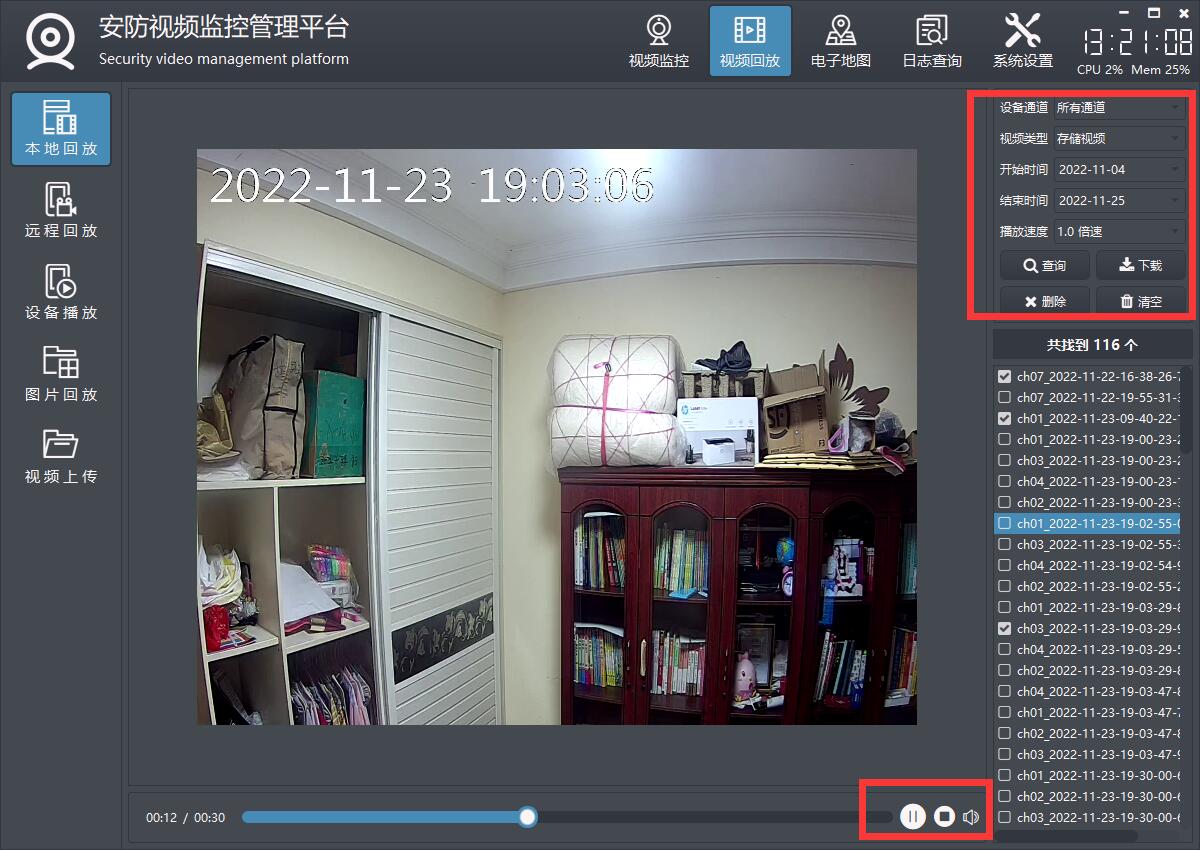

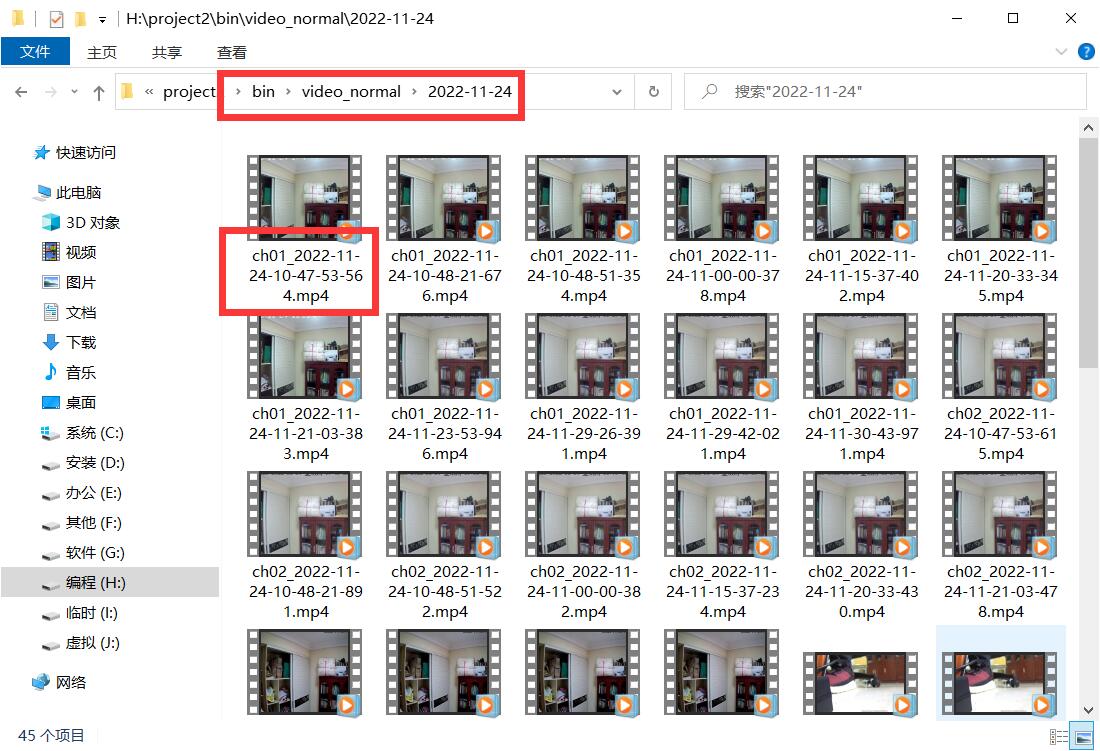

二、效果图

三、体验地址

- 国内站点:https://gitee.com/feiyangqingyun

- 国际站点:https://github.com/feiyangqingyun

- 个人作品:https://blog.csdn.net/feiyangqingyun/article/details/97565652

- 体验地址:https://pan.baidu.com/s/1d7TH_GEYl5nOecuNlWJJ7g 提取码:01jf 文件名:bin_video_demo/bin_linux_video。

四、相关代码

bool FFmpegSave::initVideoH264()

{

//查找视频编码器(如果源头是H265则采用HEVC作为编码器)

AVCodecID codecID = FFmpegHelper::getCodecID(videoStreamIn);

if (codecID == AV_CODEC_ID_HEVC) {

videoCodec = avcodec_find_encoder(AV_CODEC_ID_HEVC);

} else {

videoCodec = avcodec_find_encoder(AV_CODEC_ID_H264);

}

if (!videoCodec) {

debug("编码失败", QString("错误: 查找视频编码器失败"));

return false;

}

//创建视频编码器上下文

videoCodecCtx = avcodec_alloc_context3(videoCodec);

if (!videoCodecCtx) {

debug("编码失败", QString("错误: 创建视频编码器上下文失败"));

return false;

}

//为了兼容低版本的编译器推荐选择第一种方式

#if 1

//放大系数是为了小数位能够正确放大到整型

int ratio = 10000;

videoCodecCtx->time_base.num = 1 * ratio;

videoCodecCtx->time_base.den = frameRate * ratio;

videoCodecCtx->framerate.num = frameRate * ratio;

videoCodecCtx->framerate.den = 1 * ratio;

#elif 0

videoCodecCtx->time_base = {1, frameRate};

videoCodecCtx->framerate = {frameRate, 1};

#else

videoCodecCtx->time_base = videoStreamIn->codec->time_base;

videoCodecCtx->framerate = videoStreamIn->codec->framerate;

#endif

#if 0

videoCodecCtx->qmin = 10;

videoCodecCtx->qmax = 51;

videoCodecCtx->me_range = 16;

videoCodecCtx->max_qdiff = 4;

videoCodecCtx->qcompress = 0.6;

#endif

//初始化视频编码器参数(如果要文件体积小一些画质差一些可以调整码率)

//参数说明 https://blog.csdn.net/qq_40179458/article/details/110449653

videoCodecCtx->bit_rate = FFmpegHelper::getBitRate(videoWidth, videoHeight);

videoCodecCtx->width = videoWidth;

videoCodecCtx->height = videoHeight;

videoCodecCtx->gop_size = 25;

videoCodecCtx->max_b_frames = 3;

videoCodecCtx->pix_fmt = AV_PIX_FMT_YUV420P;

videoCodecCtx->level = 50;

videoCodecCtx->profile = FF_PROFILE_H264_MAIN;

//加上下面这个才能在文件属性中看到分辨率等信息 https://www.cnblogs.com/lidabo/p/15754031.html

if (saveVideoType == SaveVideoType_Mp4) {

videoCodecCtx->flags |= AV_CODEC_FLAG_GLOBAL_HEADER;

}

//加载预设 https://blog.csdn.net/JineD/article/details/125304570

if (videoCodecCtx->codec_id == AV_CODEC_ID_H264) {

av_opt_set(videoCodecCtx->priv_data, "preset", "slow", 0);

//设置零延迟(本地摄像头视频流保存如果不设置则播放的时候会越来越模糊)

av_opt_set(videoCodecCtx->priv_data, "tune", "zerolatency", 0);

} else if (videoCodecCtx->codec_id == AV_CODEC_ID_HEVC) {

av_opt_set(videoCodecCtx->priv_data, "x265-params", "qp=20", 0);

av_opt_set(videoCodecCtx->priv_data, "preset", "ultrafast", 0);

av_opt_set(videoCodecCtx->priv_data, "tune", "zero-latency", 0);

}

//打开视频编码器

int result = avcodec_open2(videoCodecCtx, videoCodec, NULL);

if (result < 0) {

debug("打开编码", QString("错误: 打开视频编码器失败 %1").arg(FFmpegHelper::getError(result)));

return false;

}

videoPacket = FFmpegHelper::creatPacket(NULL);

return true;

}

bool FFmpegSave::initVideoMp4()

{

//必须先设置过输入视频流

if (!videoStreamIn || fileName.isEmpty()) {

return false;

}

//有部分视频参数不正确保存不了 http://tv.netxt.cc:1998/live/y.flv

if (videoStreamIn->time_base.num == 0) {

return false;

}

QByteArray fileData = fileName.toUtf8();

const char *filename = fileData.data();

//开辟一个格式上下文用来处理视频流输出

int result = avformat_alloc_output_context2(&formatCtx, NULL, "mp4", filename);

if (result < 0) {

debug("创建格式", QString("错误: %1").arg(FFmpegHelper::getError(result)));

return false;

}

//创建视频流用来输出视频数据到文件

videoStreamOut = avformat_new_stream(formatCtx, NULL);

result = FFmpegHelper::copyContext(videoCodecCtx, videoStreamOut, true);

if (result < 0) {

debug("创建视频", QString("错误: %1").arg(FFmpegHelper::getError(result)));

goto end;

}

//打开输出文件

result = avio_open(&formatCtx->pb, filename, AVIO_FLAG_WRITE);

if (result < 0) {

debug("打开输出", QString("错误: %1").arg(FFmpegHelper::getError(result)));

goto end;

}

//写入文件开始符

result = avformat_write_header(formatCtx, NULL);

if (result < 0) {

debug("写入失败", QString("错误: %1").arg(FFmpegHelper::getError(result)));

goto end;

}

return true;

end:

//关闭释放并清理文件

this->close();

this->deleteFile(fileName);

return false;

}

void FFmpegSave::writePacket(AVPacket *packet)

{

packetCount++;

if (saveVideoType == SaveVideoType_H264) {

file.write((char *)packet->data, packet->size);

} else if (saveVideoType == SaveVideoType_Mp4) {

AVRational timeBaseIn = videoStreamIn->time_base;

AVRational timeBaseOut = videoStreamOut->time_base;

//没有下面这段判断在遇到不连续的帧的时候就会错位(相当于每次重新计算时间基准保证时间正确)

//不连续帧的情况有暂停录制以及切换播放进度导致中间有些帧不需要录制

double fps = frameRate;//av_q2d(videoStreamIn->r_frame_rate);

double duration = AV_TIME_BASE / fps;

packet->pts = (packetCount * duration) / (av_q2d(timeBaseIn) * AV_TIME_BASE);

packet->dts = packet->pts;

packet->duration = duration / (av_q2d(timeBaseIn) * AV_TIME_BASE);

//重新调整时间基准

packet->pts = av_rescale_q_rnd(packet->pts, timeBaseIn, timeBaseOut, (AVRounding)(AV_ROUND_NEAR_INF | AV_ROUND_PASS_MINMAX));

packet->dts = packet->pts;

//packet->dts = av_rescale_q_rnd(packet->dts, timeBaseIn, timeBaseOut, (AVRounding)(AV_ROUND_NEAR_INF | AV_ROUND_PASS_MINMAX));

packet->duration = av_rescale_q(packet->duration, timeBaseIn, timeBaseOut);

packet->pos = -1;

//写入一帧数据

int result = av_interleaved_write_frame(formatCtx, packet);

if (result < 0) {

debug("写入失败", QString("错误: %1").arg(FFmpegHelper::getError(result)));

}

}

av_packet_unref(packet);

}

五、功能特点

5.1 基础功能

- 支持各种音频视频文件格式,比如mp3、wav、mp4、asf、rm、rmvb、mkv等。

- 支持本地摄像头设备,可指定分辨率、帧率。

- 支持各种视频流格式,比如rtp、rtsp、rtmp、http等。

- 本地音视频文件和网络音视频文件,自动识别文件长度、播放进度、音量大小、静音状态等。

- 文件可以指定播放位置、调节音量大小、设置静音状态等。

- 支持倍速播放文件,可选0.5倍、1.0倍、2.5倍、5.0倍等速度,相当于慢放和快放。

- 支持开始播放、停止播放、暂停播放、继续播放。

- 支持抓拍截图,可指定文件路径,可选抓拍完成是否自动显示预览。

- 支持录像存储,手动开始录像、停止录像,部分内核支持暂停录像后继续录像,跳过不需要录像的部分。

- 支持无感知切换循环播放、自动重连等机制。

- 提供播放成功、播放完成、收到解码图片、收到抓拍图片、视频尺寸变化、录像状态变化等信号。

- 多线程处理,一个解码一个线程,不卡主界面。

5.2 特色功能

- 同时支持多种解码内核,包括qmedia内核(Qt4/Qt5/Qt6)、ffmpeg内核(ffmpeg2/ffmpeg3/ffmpeg4/ffmpeg5)、vlc内核(vlc2/vlc3)、mpv内核(mpv1/mp2)、海康sdk、easyplayer内核等。

- 非常完善的多重基类设计,新增一种解码内核只需要实现极少的代码量,就可以应用整套机制。

- 同时支持多种画面显示策略,自动调整(原始分辨率小于显示控件尺寸则按照原始分辨率大小显示,否则等比例缩放)、等比例缩放(永远等比例缩放)、拉伸填充(永远拉伸填充)。所有内核和所有视频显示模式下都支持三种画面显示策略。

- 同时支持多种视频显示模式,句柄模式(传入控件句柄交给对方绘制控制)、绘制模式(回调拿到数据后转成QImage用QPainter绘制)、GPU模式(回调拿到数据后转成yuv用QOpenglWidget绘制)。

- 支持多种硬件加速类型,ffmpeg可选dxva2、d3d11va等,mpv可选auto、dxva2、d3d11va,vlc可选any、dxva2、d3d11va。不同的系统环境有不同的类型选择,比如linux系统有vaapi、vdpau,macos系统有videotoolbox。

- 解码线程和显示窗体分离,可指定任意解码内核挂载到任意显示窗体,动态切换。

- 支持共享解码线程,默认开启并且自动处理,当识别到相同的视频地址,共享一个解码线程,在网络视频环境中可以大大节约网络流量以及对方设备的推流压力。国内顶尖视频厂商均采用此策略。这样只要拉一路视频流就可以共享到几十个几百个通道展示。

- 自动识别视频旋转角度并绘制,比如手机上拍摄的视频一般是旋转了90度的,播放的时候要自动旋转处理,不然默认是倒着的。

- 自动识别视频流播放过程中分辨率的变化,在视频控件上自动调整尺寸。比如摄像机可以在使用过程中动态配置分辨率,当分辨率改动后对应视频控件也要做出同步反应。

- 音视频文件无感知自动切换循环播放,不会出现切换期间黑屏等肉眼可见的切换痕迹。

- 视频控件同时支持任意解码内核、任意画面显示策略、任意视频显示模式。

- 视频控件悬浮条同时支持句柄、绘制、GPU三种模式,非绝对坐标移来移去。

- 本地摄像头设备支持指定设备名称、分辨率、帧率进行播放。

- 录像文件同时支持打开的视频文件、本地摄像头、网络视频流等。

- 瞬间响应打开和关闭,无论是打开不存在的视频或者网络流,探测设备是否存在,读取中的超时等待,收到关闭指令立即中断之前的操作并响应。

- 支持打开各种图片文件,支持本地音视频文件拖曳播放。

- 视频控件悬浮条自带开始和停止录像切换、声音静音切换、抓拍截图、关闭视频等功能。

- 音频组件支持声音波形值数据解析,可以根据该值绘制波形曲线和柱状声音条,默认提供了声音振幅信号。

- 各组件中极其详细的打印信息提示,尤其是报错信息提示,封装的统一打印格式。针对现场复杂的设备环境测试极其方便有用,相当于精确定位到具体哪个通道哪个步骤出错。

- 代码框架和结构优化到最优,性能强悍,持续迭代更新升级。

- 源码支持Qt4、Qt5、Qt6,兼容所有版本。

5.3 视频控件

- 可动态添加任意多个osd标签信息,标签信息包括名字、是否可见、字号大小、文本文字、文本颜色、标签图片、标签坐标、标签格式(文本、日期、时间、日期时间、图片)、标签位置(左上角、左下角、右上角、右下角、居中、自定义坐标)。

- 可动态添加任意多个图形信息,这个非常有用,比如人工智能算法解析后的图形区域信息直接发给视频控件即可。图形信息支持任意形状,直接绘制在原始图片上,采用绝对坐标。

- 图形信息包括名字、边框大小、边框颜色、背景颜色、矩形区域、路径集合、点坐标集合等。

- 每个图形信息都可指定三种区域中的一种或者多种,指定了的都会绘制。

- 内置悬浮条控件,悬浮条位置支持顶部、底部、左侧、右侧。

- 悬浮条控件参数包括边距、间距、背景透明度、背景颜色、文本颜色、按下颜色、位置、按钮图标代码集合、按钮名称标识集合、按钮提示信息集合。

- 悬浮条控件一排工具按钮可自定义,通过结构体参数设置,图标可选图形字体还是自定义图片。

- 悬浮条按钮内部实现了录像切换、抓拍截图、静音切换、关闭视频等功能,也可以自行在源码中增加自己对应的功能。

- 悬浮条按钮对应实现了功能的按钮,有对应图标切换处理,比如录像按钮按下后会切换到正在录像中的图标,声音按钮切换后变成静音图标,再次切换还原。

- 悬浮条按钮单击后都用名称唯一标识作为信号发出,可以自行关联响应处理。

- 悬浮条空白区域可以显示提示信息,默认显示当前视频分辨率大小,可以增加帧率、码流大小等信息。

- 视频控件参数包括边框大小、边框颜色、焦点颜色、背景颜色(默认透明)、文字颜色(默认全局文字颜色)、填充颜色(视频外的空白处填充黑色)、背景文字、背景图片(如果设置了图片优先取图片)、是否拷贝图片、缩放显示模式(自动调整、等比例缩放、拉伸填充)、视频显示模式(句柄、绘制、GPU)、启用悬浮条、悬浮条尺寸(横向为高度、纵向为宽度)、悬浮条位置(顶部、底部、左侧、右侧)。

5.4 内核ffmpeg

- 支持各种音视频文件、本地摄像头设备,各种视频流网络流。

- 支持开始播放、暂停播放、继续播放、停止播放、设置播放进度、倍速播放。

- 可设置音量、静音切换、抓拍图片、录像存储。

- 自动提取专辑信息比如标题、艺术家、专辑、专辑封面,自动显示专辑封面。

- 完美支持音视频同步和倍速播放。

- 解码策略支持速度优先、质量优先、均衡处理、最快速度。

- 支持手机视频旋转角度显示,比如一般手机拍摄的视频是旋转了90度的,解码显示的时候需要重新旋转90度才是正的。

- 自动转换yuv420格式,比如本地摄像头是yuyv422格式,有些视频文件是xx格式,统一将非yuv420格式转换,然后再进行处理。

- 支持硬解码dxva2、d3d11va等,性能极高尤其是大分辨率比如4K视频。

- 视频响应极低延迟0.2s左右,极速响应打开视频流0.5s左右,专门做了优化处理。

- 硬解码和GPU绘制组合,极低CPU占用,比海康大华等客户端更优。

- 支持视频流中的各种音频格式,AAC、PCM、G.726、G.711A、G.711Mu、G.711ulaw、G.711alaw、MP2L2等都支持,推荐选择AAC兼容性跨平台性最好。

- 视频存储支持yuv、h264、mp4多种格式,音频存储支持pcm、wav、aac多种格式。默认视频mp4格式、音频aac格式。

- 支持分开存储音频视频文件,也支持合并到一个mp4文件,默认策略是无论何种音视频文件格式存储,最终都转成mp4及aac格式,然后合并成音视频一起的mp4文件。

- 支持本地摄像头实时视频显示带音频输入输出,音视频录制合并到一个mp4文件。

- 支持H264/H265编码(现在越来越多的监控摄像头是H265视频流格式)生成视频文件,内部自动识别切换编码格式。

- 自动识别视频流动态分辨率改动,重新打开视频流。

- 支持用户信息中包含特殊字符(比如用户信息中包含+#@等字符)的视频流播放,内置解析转义处理。

- 纯qt+ffmpeg解码,非sdl等第三方绘制播放依赖,gpu绘制采用qopenglwidget,音频播放采用qaudiooutput。

- 同时支持ffmpeg2、ffmpeg3、ffmpeg4、ffmpeg5版本,全部做了兼容处理。如果需要支持xp需要选用ffmpeg3及以下。

Qt音视频开发05-保存视频文件(yuv/h264/mp4)的更多相关文章

- Android IOS WebRTC 音视频开发总结(七一)-- H265/H264有何不同

本文整理自自网络,非原创,喜欢相关文章请关注我们的微信公众号:blackerteam H.265 H.265是ITU-TVCEG继H.264之后所制定的新的视频编码标准.H.265标准围绕着现有的视频 ...

- 【秒懂音视频开发】18_详解YUV

本文的主角是多媒体领域非常重要的一个概念:YUV. 简介 YUV,是一种颜色编码方法,跟RGB是同一个级别的概念,广泛应用于多媒体领域中. 也就是说,图像中每1个像素的颜色信息,除了可以用RGB的方式 ...

- WebRTC 音视频开发

WebRTC 音视频开发 webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译 ...

- 转:Android IOS WebRTC 音视频开发总结 (系列文章集合)

随笔分类 - webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译和整理的,译 ...

- Android开发 音视频开发需要了解的专业术语知识

前言 在摸索一段时间的音视频开发后,越来越发现这个坑的深度真是特别的深. 除了了解Android自带的音视频处理API以外,还得了解一些视频与音频方面的知识.这篇博客就是主要讲解这方面的专业术语.内容 ...

- javaCV开发详解之4:转流器实现(也可作为本地收流器、推流器,新增添加图片及文字水印,视频图像帧保存),实现rtsp/rtmp/本地文件转发到rtmp流媒体服务器(基于javaCV-FFMPEG)

javaCV系列文章: javacv开发详解之1:调用本机摄像头视频 javaCV开发详解之2:推流器实现,推本地摄像头视频到流媒体服务器以及摄像头录制视频功能实现(基于javaCV-FFMPEG.j ...

- 使用PyQt(Python+Qt)+moviepy开发的视频截取、音视频分离、MP4转GIF动图工具免费下载分享

专栏:Python基础教程目录 专栏:使用PyQt开发图形界面Python应用 专栏:PyQt入门学习 老猿Python博文目录 在因博文素材需要将软件操作制作成动画时,发现网上相关绿色使用工具都需要 ...

- vlc音视频开发(一)环境搭建(qt篇)

来源:微信公众号「编程学习基地」 目录 简介 qt配置vlc环境 simple_libvlc_qt_player 项目地址 简介 VLC 是一款自由.开源的跨平台多媒体播放器及框架,可播放大多数多媒体 ...

- Python音视频开发:消除抖音短视频Logo的图形化工具实现

☞ ░ 前往老猿Python博文目录 ░ 一.引言 在<Python音视频开发:消除抖音短视频Logo和去电视台标的实现详解>节介绍了怎么通过Python+Moviepy+OpenCV实现 ...

- Moviepy音视频开发:视频转gif动画或jpg图片exe图形化工具开发案例

☞ ░ 前往老猿Python博文目录 ░ 一.引言 老猿之所以学习和研究Moviepy的使用,是因为需要一个将视频转成动画的工具,当时在网上到处搜索查找免费使用工具,结果找了很多自称免费的工具,但转完 ...

随机推荐

- Vue3的生命周期函数

选项式 API 组合式API beforeCreate 不需要 created 不需要 beforeMount onBeforeMount mounted onMounted beforeU ...

- 云原生周刊:Kubernetes 1.27 服务器端字段校验和 OpenAPI V3 进阶至 GA

开源项目推荐 KubeView KubeView 是一个 Kubernetes 集群可视化工具和可视化资源管理器.它允许用户在集群内部运行命令,并查看集群内部的资源使用情况.容器运行状态.网络流量等. ...

- centos rar文件解压不出

楼主的项目开发是在centos系统上面的,但是经常小伙伴发的压缩文件都是rar格式的. 在centos系统自带的解压的软件并不能解压rar格式的文件: 双击文件时,能弹出解压窗口,可是发现可以解压的更 ...

- activiti教程

一.工作流介绍 1.1 概念 工作流(Workflow),就是通过计算机对业务流程自动化执行管理.它主要解决的是"使在多个参与者之间按照某种预定义的规则自动进行传递文档.信息或任务的过程,从 ...

- Redisson 工作原理-源码分析

时间不在于你拥有多少,而在于你怎样使用. 1:Redisson 是什么 个人理解:一种 可重入.持续阻塞.独占式的 分布式锁协调框架,可从 ReentrantLock 去看它. ①:可重入锁 拿到锁的 ...

- 一文彻底搞定Redis与MySQL的数据同步

Redis 和 MySQL 一致性问题是企业级应用中常见的挑战之一,特别是在高并发.高可用的场景下.由于 Redis 是内存型数据库,具备极高的读写速度,而 MySQL 作为持久化数据库,通常用于数据 ...

- 【2024.10.03】NOIP2024 赛前集训-刷题训练(5)

[2024.10.03]NOIP2024 赛前集训-刷题训练(5) NOIP2017 提高组 小凯的疑惑 形式化题面:求最大的正整数 \(w\),满足 \(ax + by = w\) 不存在一对非负整 ...

- 利用DbgHelp获取线程的栈回溯信息

当线程发生异常时,我们如果可以记录下来异常线程的堆栈信息,那么对于我们后续问题处理将会有极大的帮助.这里记录一个操作方法. 1 #include <iostream> 2 #include ...

- Flink Checkpoint & Savepoint

Flink checkpoint Checkpoint是Flink实现容错机制最核心的功能,能够根据配置周期性地基于Stream中各个Operator的状态来生成Snapshot,从而将这些状态数据定 ...

- zinxV0.1

基础的server 框架 抽象层IServer.go IServer.go type IServer interface { // 实现一个服务器的基本三个接口,启动,停止,入口 Start() St ...