Spark 系列(五)—— Spark 运行模式与作业提交

一、作业提交

1.1 spark-submit

Spark 所有模式均使用 spark-submit 命令提交作业,其格式如下:

./bin/spark-submit \

--class <main-class> \ # 应用程序主入口类

--master <master-url> \ # 集群的 Master Url

--deploy-mode <deploy-mode> \ # 部署模式

--conf <key>=<value> \ # 可选配置

... # other options

<application-jar> \ # Jar 包路径

[application-arguments] #传递给主入口类的参数 需要注意的是:在集群环境下,application-jar 必须能被集群中所有节点都能访问,可以是 HDFS 上的路径;也可以是本地文件系统路径,如果是本地文件系统路径,则要求集群中每一个机器节点上的相同路径都存在该 Jar 包。

1.2 deploy-mode

deploy-mode 有 cluster 和 client 两个可选参数,默认为 client。这里以 Spark On Yarn 模式对两者进行说明 :

- 在 cluster 模式下,Spark Drvier 在应用程序的 Master 进程内运行,该进程由群集上的 YARN 管理,提交作业的客户端可以在启动应用程序后关闭;

- 在 client 模式下,Spark Drvier 在提交作业的客户端进程中运行,Master 进程仅用于从 YARN 请求资源。

1.3 master-url

master-url 的所有可选参数如下表所示:

| Master URL | Meaning |

|---|---|

local |

使用一个线程本地运行 Spark |

local[K] |

使用 K 个 worker 线程本地运行 Spark |

local[K,F] |

使用 K 个 worker 线程本地运行 , 第二个参数为 Task 的失败重试次数 |

local[*] |

使用与 CPU 核心数一样的线程数在本地运行 Spark |

local[*,F] |

使用与 CPU 核心数一样的线程数在本地运行 Spark 第二个参数为 Task 的失败重试次数 |

spark://HOST:PORT |

连接至指定的 standalone 集群的 master 节点。端口号默认是 7077。 |

spark://HOST1:PORT1,HOST2:PORT2 |

如果 standalone 集群采用 Zookeeper 实现高可用,则必须包含由 zookeeper 设置的所有 master 主机地址。 |

mesos://HOST:PORT |

连接至给定的 Mesos 集群。端口默认是 5050。对于使用了 ZooKeeper 的 Mesos cluster 来说,使用 mesos://zk://... 来指定地址,使用 --deploy-mode cluster 模式来提交。 |

yarn |

连接至一个 YARN 集群,集群由配置的 HADOOP_CONF_DIR 或者 YARN_CONF_DIR 来决定。使用 --deploy-mode 参数来配置 client 或 cluster 模式。 |

下面主要介绍三种常用部署模式及对应的作业提交方式。

二、Local模式

Local 模式下提交作业最为简单,不需要进行任何配置,提交命令如下:

# 本地模式提交应用

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master local[2] \

/usr/app/spark-2.4.0-bin-hadoop2.6/examples/jars/spark-examples_2.11-2.4.0.jar \

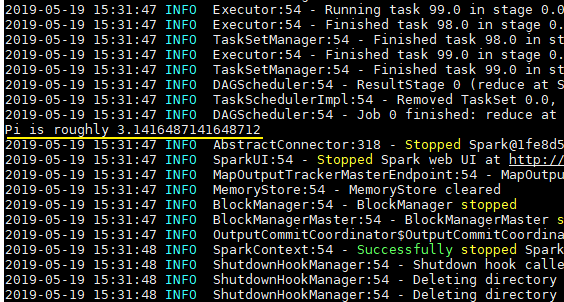

100 # 传给 SparkPi 的参数spark-examples_2.11-2.4.0.jar 是 Spark 提供的测试用例包,SparkPi 用于计算 Pi 值,执行结果如下:

三、Standalone模式

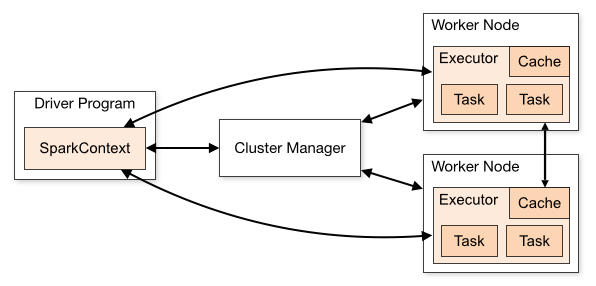

Standalone 是 Spark 提供的一种内置的集群模式,采用内置的资源管理器进行管理。下面按照如图所示演示 1 个 Mater 和 2 个 Worker 节点的集群配置,这里使用两台主机进行演示:

- hadoop001: 由于只有两台主机,所以 hadoop001 既是 Master 节点,也是 Worker 节点;

- hadoop002 : Worker 节点。

3.1 环境配置

首先需要保证 Spark 已经解压在两台主机的相同路径上。然后进入 hadoop001 的 ${SPARK_HOME}/conf/ 目录下,拷贝配置样本并进行相关配置:

# cp spark-env.sh.template spark-env.sh在 spark-env.sh 中配置 JDK 的目录,完成后将该配置使用 scp 命令分发到 hadoop002 上:

# JDK安装位置

JAVA_HOME=/usr/java/jdk1.8.0_2013.2 集群配置

在 ${SPARK_HOME}/conf/ 目录下,拷贝集群配置样本并进行相关配置:

# cp slaves.template slaves指定所有 Worker 节点的主机名:

# A Spark Worker will be started on each of the machines listed below.

hadoop001

hadoop002这里需要注意以下三点:

- 主机名与 IP 地址的映射必须在

/etc/hosts文件中已经配置,否则就直接使用 IP 地址; - 每个主机名必须独占一行;

- Spark 的 Master 主机是通过 SSH 访问所有的 Worker 节点,所以需要预先配置免密登录。

3.3 启动

使用 start-all.sh 代表启动 Master 和所有 Worker 服务。

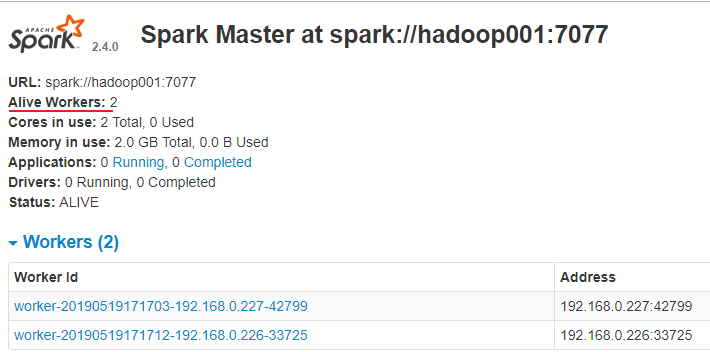

./sbin/start-master.sh 访问 8080 端口,查看 Spark 的 Web-UI 界面,,此时应该显示有两个有效的工作节点:

3.4 提交作业

# 以client模式提交到standalone集群

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://hadoop001:7077 \

--executor-memory 2G \

--total-executor-cores 10 \

/usr/app/spark-2.4.0-bin-hadoop2.6/examples/jars/spark-examples_2.11-2.4.0.jar \

100

# 以cluster模式提交到standalone集群

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://207.184.161.138:7077 \

--deploy-mode cluster \

--supervise \ # 配置此参数代表开启监督,如果主应用程序异常退出,则自动重启 Driver

--executor-memory 2G \

--total-executor-cores 10 \

/usr/app/spark-2.4.0-bin-hadoop2.6/examples/jars/spark-examples_2.11-2.4.0.jar \

1003.5 可选配置

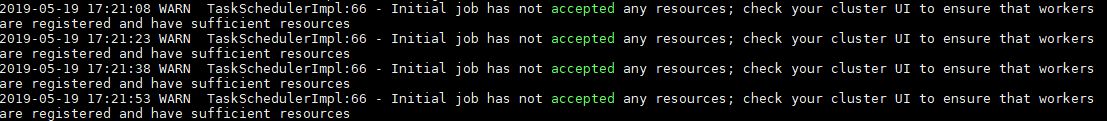

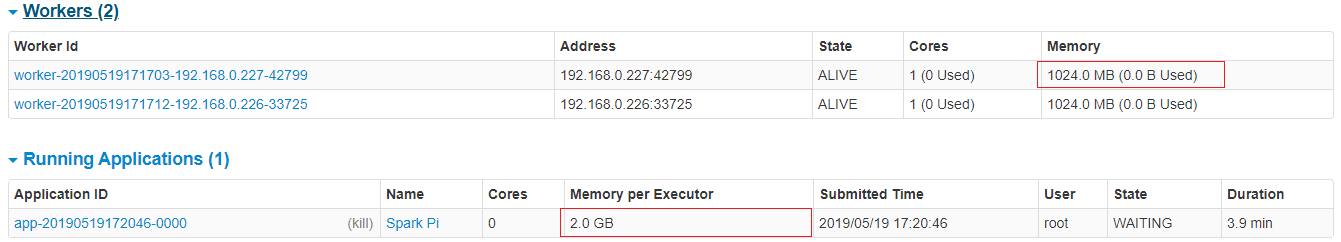

在虚拟机上提交作业时经常出现一个的问题是作业无法申请到足够的资源:

Initial job has not accepted any resources;

check your cluster UI to ensure that workers are registered and have sufficient resources

这时候可以查看 Web UI,我这里是内存空间不足:提交命令中要求作业的 executor-memory 是 2G,但是实际的工作节点的 Memory 只有 1G,这时候你可以修改 --executor-memory,也可以修改 Woker 的 Memory,其默认值为主机所有可用内存值减去 1G。

关于 Master 和 Woker 节点的所有可选配置如下,可以在 spark-env.sh 中进行对应的配置:

| Environment Variable(环境变量) | Meaning(含义) |

|---|---|

SPARK_MASTER_HOST |

master 节点地址 |

SPARK_MASTER_PORT |

master 节点地址端口(默认:7077) |

SPARK_MASTER_WEBUI_PORT |

master 的 web UI 的端口(默认:8080) |

SPARK_MASTER_OPTS |

仅用于 master 的配置属性,格式是 "-Dx=y"(默认:none),所有属性可以参考官方文档:spark-standalone-mode |

SPARK_LOCAL_DIRS |

spark 的临时存储的目录,用于暂存 map 的输出和持久化存储 RDDs。多个目录用逗号分隔 |

SPARK_WORKER_CORES |

spark worker 节点可以使用 CPU Cores 的数量。(默认:全部可用) |

SPARK_WORKER_MEMORY |

spark worker 节点可以使用的内存数量(默认:全部的内存减去 1GB); |

SPARK_WORKER_PORT |

spark worker 节点的端口(默认: random(随机)) |

SPARK_WORKER_WEBUI_PORT |

worker 的 web UI 的 Port(端口)(默认:8081) |

SPARK_WORKER_DIR |

worker 运行应用程序的目录,这个目录中包含日志和暂存空间(default:SPARK_HOME/work) |

SPARK_WORKER_OPTS |

仅用于 worker 的配置属性,格式是 "-Dx=y"(默认:none)。所有属性可以参考官方文档:spark-standalone-mode |

SPARK_DAEMON_MEMORY |

分配给 spark master 和 worker 守护进程的内存。(默认: 1G) |

SPARK_DAEMON_JAVA_OPTS |

spark master 和 worker 守护进程的 JVM 选项,格式是 "-Dx=y"(默认:none) |

SPARK_PUBLIC_DNS |

spark master 和 worker 的公开 DNS 名称。(默认:none) |

三、Spark on Yarn模式

Spark 支持将作业提交到 Yarn 上运行,此时不需要启动 Master 节点,也不需要启动 Worker 节点。

3.1 配置

在 spark-env.sh 中配置 hadoop 的配置目录的位置,可以使用 YARN_CONF_DIR 或 HADOOP_CONF_DIR 进行指定:

YARN_CONF_DIR=/usr/app/hadoop-2.6.0-cdh5.15.2/etc/hadoop

# JDK安装位置

JAVA_HOME=/usr/java/jdk1.8.0_2013.2 启动

必须要保证 Hadoop 已经启动,这里包括 YARN 和 HDFS 都需要启动,因为在计算过程中 Spark 会使用 HDFS 存储临时文件,如果 HDFS 没有启动,则会抛出异常。

# start-yarn.sh

# start-dfs.sh3.3 提交应用

# 以client模式提交到yarn集群

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode client \

--executor-memory 2G \

--num-executors 10 \

/usr/app/spark-2.4.0-bin-hadoop2.6/examples/jars/spark-examples_2.11-2.4.0.jar \

100

# 以cluster模式提交到yarn集群

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode cluster \

--executor-memory 2G \

--num-executors 10 \

/usr/app/spark-2.4.0-bin-hadoop2.6/examples/jars/spark-examples_2.11-2.4.0.jar \

100更多大数据系列文章可以参见 GitHub 开源项目: 大数据入门指南

Spark 系列(五)—— Spark 运行模式与作业提交的更多相关文章

- Spark学习之路(五)—— Spark运行模式与作业提交

一.作业提交 1.1 spark-submit Spark所有模式均使用spark-submit命令提交作业,其格式如下: ./bin/spark-submit \ --class <main- ...

- 大话Spark(5)-三图详述Spark Standalone/Client/Cluster运行模式

之前在 大话Spark(2)里讲过Spark Yarn-Client的运行模式,有同学反馈与Cluster模式没有对比, 这里我重新整理了三张图分别看下Standalone,Yarn-Client 和 ...

- 2 Spark角色介绍及运行模式

第2章 Spark角色介绍及运行模式 2.1 集群角色 从物理部署层面上来看,Spark主要分为两种类型的节点,Master节点和Worker节点:Master节点主要运行集群管理器的中心化部分,所承 ...

- 转:Windows下的PHP开发环境搭建——PHP线程安全与非线程安全、Apache版本选择,及详解五种运行模式。

原文来自于:http://www.ituring.com.cn/article/128439 Windows下的PHP开发环境搭建——PHP线程安全与非线程安全.Apache版本选择,及详解五种运行模 ...

- 入门大数据---Spark部署模式与作业提交

一.作业提交 1.1 spark-submit Spark 所有模式均使用 spark-submit 命令提交作业,其格式如下: ./bin/spark-submit \ --class <ma ...

- Spark internal - 多样化的运行模式(上)

Spark的运行模式多种多样,在单机上既可以以本地模式运行,也可以以伪分布式模式运行.而当以分布式的方式运行在Cluster集群中时,底层的资源调度可以使用Mesos 或者是Hadoop Yarn , ...

- 【Spark深入学习-11】Spark基本概念和运行模式

----本节内容------- 1.大数据基础 1.1大数据平台基本框架 1.2学习大数据的基础 1.3学习Spark的Hadoop基础 2.Hadoop生态基本介绍 2.1Hadoop生态组件介绍 ...

- Spark internal - 多样化的运行模式 (下)

Spark的各种运行模式虽然启动方式,运行位置,调度手段有所不同,但它们所要完成的任务基本都是一致的,就是在合适的位置安全可靠的根据用户的配置和Job的需要管理和运行Task,这里粗略的列举一下在运行 ...

- Tomcat系列(8)——Tomcat运行模式连接数和线程池

Connector的主要功能,是接收连接请求,创建Request和Response对象用于和请求端交换数据:然后分配线程让Engine(也就是Servlet容器)来处理这个请求,并把产生的Reques ...

随机推荐

- 03_javaSE面试题:类初始化和实例初始化

题目 下面代码运行的结果是什么? Father 类 /** * @author kevin * @date 2019/7/8 15:48 */ public class Father { privat ...

- SpringCloud系列——限流、熔断、降级

前言 分布式环境下,服务直接相互调用,一个复杂的业务可能要调用多个服务,例如A -> B -> C -> D,当某个服务出现异常(调用超时.调用失败等)将导致整个流程阻塞崩溃,严重的 ...

- 机器学习经典算法之PageRank

Google 的两位创始人都是斯坦福大学的博士生,他们提出的 PageRank 算法受到了论文影响力因子的评价启发.当一篇论文被引用的次数越多,证明这篇论文的影响力越大.正是这个想法解决了当时网页检索 ...

- C语言学习书籍推荐《C Primer Plus(中文版)(第5版)》下载

普拉塔 (Prata S.) (作者), 云巅工作室 (译者) <C Primer Plus(中文版)(第5版)>共17章,介绍了C语言的基础知识,包括数据类型.格式化输入输出.运算符.表 ...

- Android studio 3.4.1 使用 bootstrap 中的组件实例

电脑环境: ubuntu18.04 + Android studio 3.4.1 + bootsrtap4 Android studio中板式设计主要使用的 XML 布局文件,而在bootstrap中 ...

- pytorch实现yolov3(5) 实现端到端的目标检测

torch实现yolov3(1) torch实现yolov3(2) torch实现yolov3(3) torch实现yolov3(4) 前面4篇已经实现了network的forward,并且将netw ...

- centos 安装Python3 及对应的pip

安装Python3安装Python依赖:yum install openssl-devel bzip2-devel expat-devel gdbm-devel readline-devel sqli ...

- SpringBoot2.0集成WebSocket,实现后台向前端推送信息

感谢作者,支持原创: https://blog.csdn.net/moshowgame/article/details/80275084 什么是WebSocket? WebSocket协议是基于TCP ...

- 非controller层获取response和request对象

ServletRequestAttributes attrs = (ServletRequestAttributes) RequestContextHolder.getRequestAttribute ...

- 什么是icmp协议?

英文原义:Internet Control Message Protocol 中文释义:(RFC-792)Internet控制消息协议 定义: ICMP协议是一种面向无连接的协议,用于传输出 ...