spark-streaming-连接kafka的两种方式

推荐系统的在线部分往往使用spark-streaming实现,这是一个很重要的环节。

在线流程的实时数据一般是从kafka获取消息到spark streaming

spark连接kafka两种方式在面试中会经常被问到,说明这是重点,下面为大家介绍一下这两种方法:

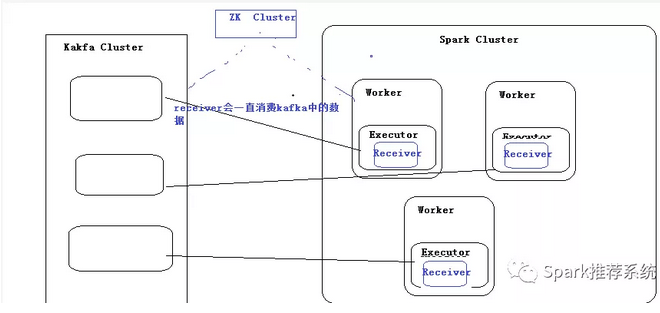

第一种方式:Receiver模式 又称kafka高级api模式

效果:SparkStreaming中的Receivers,恰好kafka有发布、订阅,然而:这种方式企业不常用,说明有bug,不符合企业需求。因为:接收到的数据存储在Executor,会出现数据漏处理或者多处理状况。

简单的理解就是kafka把消息全部封装好,提供给spark去调用,本来kafka的消息分布在不同的partition上面,相当于做了一步数据合并,在发送给spark,故spark可以设置executor个数去消费这部分数据,效率相对慢一些。

代码实例:

object ReceiverKafkaWordCount {

Logger.getLogger("org").setLevel(Level.ERROR)

def main(args: Array[String]): Unit = {

val Array(brokers, topics) = Array(Conf.KAFKA_BROKER, Conf.TEST_TOPIC)

// Create context with 2 second batch interval

val conf = new SparkConf()

.setMaster("local")

.setAppName("OnlineStreamHobby") //设置本程序名称

// .set("auto.offset.reset","smallest")

val ssc = new StreamingContext(conf, Seconds(2))

// 从kafka取数据

val kafkaParams: Map[String, String] = Map[String, String](

// "auto.offset.reset" -> "smallest", //自动将偏移重置为最早的偏移

"zookeeper.connect" -> Conf.ZK_HOST,

// "bootstrap.servers" -> Common.KAFKA_BROKER_LIST,

"group.id" -> "test"

)

val numThreads = 1

val topicMap = topics.split(",").map((_, numThreads.toInt)).toMap

val fact_streaming = KafkaUtils.createStream[String, String, StringDecoder, StringDecoder](ssc, kafkaParams, topicMap, StorageLevel.MEMORY_AND_DISK_2).map(_._2)

// fact_streaming.print()

val words = fact_streaming.flatMap(_.split(" "))

val wordCounts = words.map(x => (x, 1L)).reduceByKey(_ + _)

wordCounts.print()

ssc.checkpoint(".")

//启动spark并设置执行时间

ssc.start()

ssc.awaitTermination()

}

}

第二种方式:Direct模式 又称kafka低级API模式

效果:每次到topic的每个partition依据偏移量进行获取数据,拉取数据以后进行处理,可以实现高可用

解释:在spark 1.3中引入了这种新的无接收器“直接”方法,以确保更强大的端到端保证。这种方法不是使用接收器来接收数据,而是定期查询kafka在每个topic+分partition中的最新偏移量,并相应地定义要在每个批次中处理的偏移量范围。当处理数据的作业启动时,Kafka简单的客户API用于读取Kafka中定义的偏移范围(类似于从文件系统读取文件)。请注意,此功能在Spark 1.3中为Scala和Java API引入

简单的理解就是spark直接从kafka底层中的partition直接获取消息,相对于Receiver模式少了一步,效率更快。但是这样一来spark中的executor的工作的个数就为kafka中的partition一致,设置再多的executor都不工作,同时偏移量也需要自己维护。

代码示例:

object DirectTest {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("kafka direct test").setMaster("local")

val sc = new SparkContext(conf)

val ssc = new StreamingContext(sc,Seconds(10))

//kafka基本参数,yourBrokers你的brokers集群

val kafkaParams = Map("metadata.broker.list" -> Conf.KAFKA_BROKER)

val topic = "test"

val customGroup = "testGroup"

//新建一个zkClient,zk是你的zk集群,和broker一样,也是"IP:端口,IP端口..."

/**

*如果你使用val zkClient = new ZKClient(zk)新建zk客户端,

*在后边读取分区信息的文件数据时可能会出现错误

*org.I0Itec.zkclient.exception.ZkMarshallingError:

* java.io.StreamCorruptedException: invalid stream header: 7B226A6D at org.I0Itec.zkclient.serialize.SerializableSerializer.deserialize(SerializableSerializer.java:37) at org.I0Itec.zkclient.ZkClient.derializable(ZkClient.java:740) ..

*那么使用我的这个新建方法就可以了,指定读取数据时的序列化方式

**/

val zkClient = new ZkClient(Conf.ZK_HOST, Integer.MAX_VALUE, 10000,ZKStringSerializer)

//获取zk下该消费者的offset存储路径,一般该路径是/consumers/test_spark_streaming_group/offsets/topic_name

val topicDirs = new ZKGroupTopicDirs(customGroup, topic)

val children = zkClient.countChildren(s"${topicDirs.consumerOffsetDir}")

//设置第一批数据读取的起始位置

var fromOffsets: Map[TopicAndPartition, Long] = Map()

var directKafkaStream : InputDStream[(String,String)] = null

//如果zk下有该消费者的offset信息,则从zk下保存的offset位置开始读取,否则从最新的数据开始读取(受auto.offset.reset设置影响,此处默认)

if (children > 0) {

//将zk下保存的该主题该消费者的每个分区的offset值添加到fromOffsets中

for (i <- 0 until children) {

val partitionOffset = zkClient.readData[String](s"${topicDirs.consumerOffsetDir}/$i")

val tp = TopicAndPartition(topic, i)

//将不同 partition 对应的 offset 增加到 fromOffsets 中

fromOffsets += (tp -> partitionOffset.toLong)

println("@@@@@@ topic[" + topic + "] partition[" + i + "] offset[" + partitionOffset + "] @@@@@@")

val messageHandler = (mmd: MessageAndMetadata[String, String]) => (mmd.topic,mmd.message())

directKafkaStream = KafkaUtils.createDirectStream[String, String, StringDecoder, StringDecoder, (String,String)](ssc, kafkaParams, fromOffsets, messageHandler)

}

}else{

directKafkaStream = KafkaUtils.createDirectStream[String, String, StringDecoder, StringDecoder](ssc, kafkaParams, Set(topic))

}

/**

*上边已经实现从zk上保存的值开始读取数据

*下边就是数据处理后,再讲offset值写会到zk上

*/

//用于保存当前offset范围

var offsetRanges: Array[OffsetRange] = Array.empty

val directKafkaStream1 = directKafkaStream.transform { rdd =>

//取出该批数据的offset值

offsetRanges = rdd.asInstanceOf[HasOffsetRanges].offsetRanges

rdd

}.map(_._2)

directKafkaStream1.foreachRDD(rdd=>{

//数据处理完毕后,将offset值更新到zk集群

for (o <- offsetRanges) {

val zkPath = s"${topicDirs.consumerOffsetDir}/${o.partition}"

ZkUtils.updatePersistentPath(zkClient, zkPath, o.fromOffset.toString)

}

rdd.foreach(println)

})

ssc.start()

ssc.awaitTermination()

}

}

spark-streaming-连接kafka的两种方式的更多相关文章

- Spark Streaming连接Kafka的两种方式 direct 跟receiver 方式接收数据的区别

Receiver是使用Kafka的高层次Consumer API来实现的. Receiver从Kafka中获取的数据都是存储在Spark Executor的内存中的,然后Spark Streaming ...

- Spark Streaming 交互 Kafka的两种方式

一.Spark Streaming连Kafka(重点) 方式一:Receiver方式连:走磁盘 使用High Level API(高阶API)实现Offset自动管理,灵活性差,处理数据时,如果某一时 ...

- sparkStreaming读取kafka的两种方式

概述 Spark Streaming 支持多种实时输入源数据的读取,其中包括Kafka.flume.socket流等等.除了Kafka以外的实时输入源,由于我们的业务场景没有涉及,在此将不会讨论.本篇 ...

- ADB连接手机的两种方式(usb数据线连接和wifi连接)

ADB(Android Debug Bridge)安卓测试桥,它是连接电脑开发端和安卓设备的桥梁,这个安卓设备可以是真实的安卓手机或者平板,也可以是虚拟的安卓模拟器, 这里介绍ADB连接手机的两种 ...

- 利用adb查看手机设备ip和连接手机的两种方式

电脑安装adb(查看菜鸟adb教程) [cmd]->输入adb devices (设置了path,否则需要 ./路径/adb devices)如图: 查看ip两种方法(可能有更多,目前我还没看到 ...

- spark streaming集成kafka接收数据的方式

spark streaming是以batch的方式来消费,strom是准实时一条一条的消费.当然也可以使用trident和tick的方式来实现batch消费(官方叫做mini batch).效率嘛,有 ...

- 网络协议 finally{ return问题 注入问题 jdbc注册驱动问题 PreparedStatement 连接池目的 1.2.1DBCP连接池 C3P0连接池 MYSQL两种方式进行实物管理 JDBC事务 DBUtils事务 ThreadLocal 事务特性 并发访问 隔离级别

1.1.1 API详解:注册驱动 DriverManager.registerDriver(new com.mysql.jdbc.Driver());不建议使用 原因有2个: >导致驱动被注册2 ...

- spark application提交应用的两种方式

bin/spark-submit --help ... ... --deploy-mode DEPLOY_MODE Whether to launch the driver program loc ...

- adb连接手机的两种方式

adb连接手机进行调试有两种方式,一种使用USB线,一种使用无线WiFi. 第一种 使用USB线连接 1. 在手机上启用USB调试 2. CMD窗口输入adb devices,此时可以看到自己的设备 ...

随机推荐

- crawlergo动态爬虫去除Spidername使用

本来是想用AWVS的爬虫来联动Xray的,但是需要主机安装AWVS,再进行规则联动,只是使用其中的目标爬虫功能感觉就太重了,在github上面找到了由360 0Kee-Team团队从360天相中分离出 ...

- ADF 第二篇:使用UI创建ADF

用户可以通过UI来创建ADF,在UI中创建ADF时,用户不需要下载单独的IDE,而仅仅通过 Microsoft Edge 或者 Google Chrome浏览器.用户登录Azure Portal,选择 ...

- LeetCode初级算法之数组:48 旋转图像

旋转图像 题目地址:https://leetcode-cn.com/problems/rotate-image/ 给定一个 n × n 的二维矩阵表示一个图像. 将图像顺时针旋转 90 度. 说明: ...

- JVM命令手册

原文链接:https://blog.csdn.net/qq_41345773/article/details/93895532 aconst_null 将null对象引用压入栈iconst_m1 将i ...

- Python(一) 快速配置Python编译环境与第一个py文件程序

1. Python基本语法在此不熬述. 2. 到管网下载Python 3.6.x 版本,与本机匹配的版本,如本机是 win7 64 python-3.6.5-amd64 3. 下载IDE:Python ...

- VMware虚拟机下Centos8 设置静态IP地址

缘起 我们在平时学习Redis.Nginx等分布式微服务的组件的时候,无法避免的需要用到Linux操作系统,而Linux操作系统的主机来源差不多就三种情况: 真实物理机 阿里云等云服务器 利用虚拟机 ...

- uni-app中组件的使用

组件基本知识点: uniapp中:每个页面可以理解为一个单页面组件,这些单页面组件注册在pages.json里,在组件关系中可以看作父组件. 自定义可复用的组件,其结构与单页面组件类似,通常在需要的页 ...

- zookeeper集群&伪集群模式部署

1.什么是单机部署 一台服务器上面部署一个单机版本的zookeeper服务,用于提供服务. 2.什么是集群部署? 集群部署就是多台服务器上面各部署单独的一个zookeeper服务,然后组建一个集群 3 ...

- Linux 设置日期时间

linux 日期设置 直接设置日期和时间 date -s 2019-02-11 date -s 12:12:12 date -s "2019-02-11 12:12:12"

- js上 十二、函数初步-1

11-1.引入(认识函数) 引入: 说起函数,其实我们并不陌生,在初中数学中我们就接触过函数:例如我们所学的 y = 2X+1 ; 这是一个二元一次方程,也是我们数字中的函数: 当我们每次输入 ...