从零自学Hadoop(18):Hive的CLI和JDBC

阅读目录

本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作。

文章是哥(mephisto)写的,SourceLink

序

上一篇,我们对hive的数据导出,以及集群Hive数据的迁移进行描述。了解到了基本的hive导出操作。这里,我们将对hive的CLI及JDBC这些实用性很强的两个方便进行简要的介绍。

下面我们开始介绍hive的CLI和JDBC。

Hive CLI(old CLI)

一:说明

在0.11之前只有Hive CLI,他需要安装Hive Client才能使用。是一个重量级的命令行工具。连接的服务器是HiveServer1。

二:语法:

usage: hive

-d,--define <key=value> Variable subsitution to apply to hive

commands. e.g. -d A=B or --define A=B

-e <quoted-query-string> SQL from command line

-f <filename> SQL from files

-H,--help Print help information

-h <hostname> Connecting to Hive Server on remote host

--hiveconf <property=value> Use value for given property

--hivevar <key=value> Variable subsitution to apply to hive

commands. e.g. --hivevar A=B

-i <filename> Initialization SQL file

-p <port> Connecting to Hive Server on port number

-S,--silent Silent mode in interactive shell

-v,--verbose Verbose mode (echo executed SQL to the

console)三:官网例子1

$HIVE_HOME/bin/hive -e 'select a.col from tab1 a'四:官网例子2

运行脚本文件

$HIVE_HOME/bin/hive -f /home/my/hive-script.sql

Beeline CLI(new CLI)

一:介绍

为了使得CLI轻量化,后来Hive做出了Beeline和HiveServer2。Beeline是一个基于JDBC的SQLLine CLI。

二:官网例子

bin/beeline

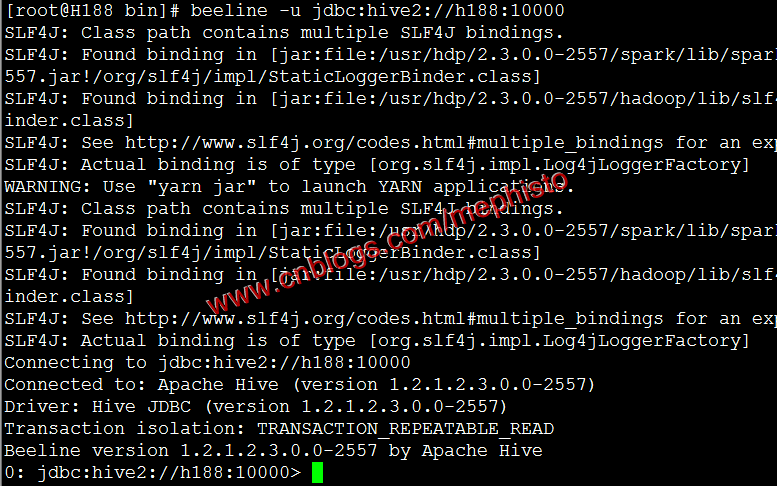

!connect jdbc:hive2://localhost:10000 scott tiger org.apache.hive.jdbc.HiveDriver三:实战

hiveserver2的默认端口是10000。

beeline -u jdbc:hive2://h188:10000

查看有哪些表。

show tables;

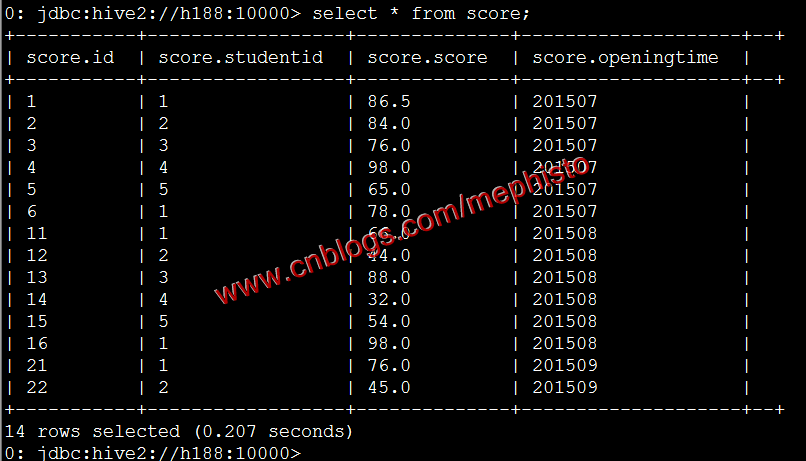

这里可以看到我们在上面几篇测试的时候的表score,score1,score2,我们查下score的数据。

select * from score;

JDBC

一:介绍

我们可以在代码中通过jdbc连接hive。这样在实际运用场景中就很方便,很原有的非分布式计算的开发方式基本类似,具有很强的适用性。

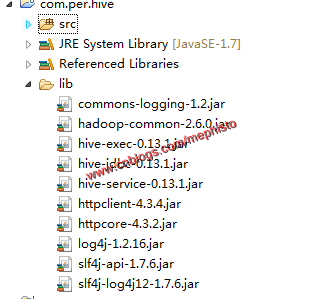

二:新建工程

新建工程com.per.hive

三:引入包

版本根据自己使用hadoop集群而定

commons-logging-1.2.jar

hadoop-common-2.6..jar

hive-exec-0.13..jar

hive-jdbc-0.13..jar

hive-service-0.13..jar

httpclient-4.3..jar

httpcore-4.3..jar

log4j-1.2..jar

slf4j-api-1.7..jar

slf4j-log4j12-1.7..jar

四:添加类HiveDemo

添加HiveDriver

static {

try {

Class.forName("org.apache.hive.jdbc.HiveDriver");

} catch (ClassNotFoundException ex) {

ex.printStackTrace();

}

}添加test()方法

/**

* @Description : 测试

*/

private static void test() {

try (Connection con = DriverManager

.getConnection("jdbc:hive2://h188:10000/")) {

Statement stm = con.createStatement();

ResultSet rs = stm.executeQuery("select * from score "); while (rs.next()) {

String info = rs.getString(1);

info += " " + rs.getString(2);

info += " " + rs.getString(3);

info += " " + rs.getString(4); System.out.println(info);

} } catch (Exception ex) {

ex.printStackTrace();

}

}调用

public static void main(String[] args) {

test();

}

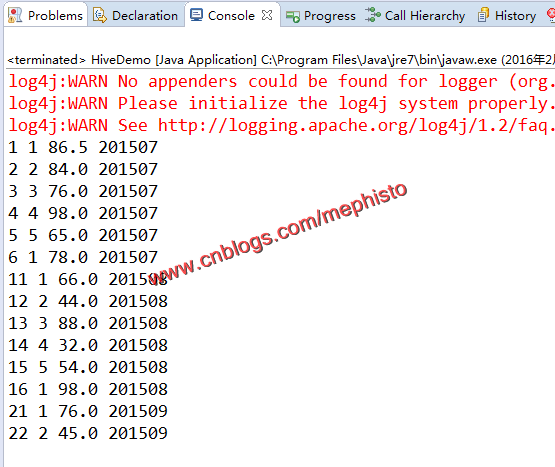

五:运行

运行,查看结果,可以看见,程序运行的结果与我们在Beeline命令行查看的结果一致。

这样我们的Hive的CLI和JDBC告一段落。

--------------------------------------------------------------------

到此,本章节的内容讲述完毕。

Demo下载

https://github.com/sinodzh/HadoopExample/tree/master/2016/com.per.hive

系列索引

本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作。

文章是哥(mephisto)写的,SourceLink

从零自学Hadoop(18):Hive的CLI和JDBC的更多相关文章

- 从零自学Hadoop系列索引

本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephisto)写的,SourceLink 从零自学Hadoop(01):认识Hadoop ...

- 从零自学Hadoop(14):Hive介绍及安装

阅读目录 序 介绍 安装 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephisto)写的,SourceLink 序 本系列已 ...

- 从零自学Hadoop(15):Hive表操作

阅读目录 序 创建表 查看表 修改表 删除表 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephisto)写的,SourceL ...

- 从零自学Hadoop(16):Hive数据导入导出,集群数据迁移上

阅读目录 序 导入文件到Hive 将其他表的查询结果导入表 动态分区插入 将SQL语句的值插入到表中 模拟数据文件下载 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并 ...

- 从零自学Hadoop(17):Hive数据导入导出,集群数据迁移下

阅读目录 序 将查询的结果写入文件系统 集群数据迁移一 集群数据迁移二 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephis ...

- 从零自学Hadoop(19):HBase介绍及安装

阅读目录 序 介绍 安装 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephisto)写的,SourceLink 序 上一篇, ...

- 从零自学Hadoop(21):HBase数据模型相关操作下

阅读目录 序 变量 数据模型操作 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephisto)写的,SourceLink 序 ...

- 从零自学Hadoop(01):认识Hadoop

本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephisto)写的,SourceLink 阅读目录 序 Hadoop 项目起源 优点 核心 ...

- 从零自学Hadoop(03):Linux准备上

阅读目录 序 检查列表 常用Linux命令 搭建环境 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephisto)写的,Sou ...

随机推荐

- 【WCF】基址与默认终结点

五月份的时候,有位老友给老周提了个建议:希望老周写一写WCF的文章.其实老周以前是写过WCF的文章的,只是不是写在这个博客里,老周并不打算把X年前的博客导进来,要写的话,重新写吧.毕竟,那个时候写的文 ...

- 1. SVM简介

从这一部分开始,将陆续介绍SVM的相关知识,主要是整理以前学习的一些笔记内容,梳理思路,形成一套SVM的学习体系. 支持向量机(Support Vector Machine)是Cortes和Vapni ...

- 前端学HTTP之摘要认证

前面的话 上一篇介绍的基本认证便捷灵活,但极不安全.用户名和密码都是以明文形式传送的,也没有采取任何措施防止对报文的篡改.安全使用基本认证的唯一方式就是将其与SSL配合使用 摘要认证与基本认证兼容,但 ...

- .NET Core采用的全新配置系统[7]: 将配置保存在数据库中

我们在<聊聊默认支持的各种配置源>和<深入了解三种针对文件(JSON.XML与INI)的配置源>对配置模型中默认提供的各种ConfigurationSource进行了深入详尽的 ...

- 一个技术汪的开源梦 —— 基于 .Net Core 的公共组件之 Http 请求客户端

一个技术汪的开源梦 —— 目录 想必大家在项目开发的时候应该都在程序中调用过自己内部的接口或者使用过第三方提供的接口,咱今天不讨论 REST ,最常用的请求应该就是 GET 和 POST 了,那下面开 ...

- [Android]在Dagger 2中使用RxJava来进行异步注入(翻译)

以下内容为原创,欢迎转载,转载请注明 来自天天博客: # 在Dagger 2中使用RxJava来进行异步注入 > 原文: 几星期前我写了一篇关于在Dagger 2中使用*Producers*进行 ...

- 原创:去繁存简,回归本源:微信小程序公开课信息分析《一》

以前我开过一些帖子,我们内部也做过一些讨论,我们从张小龙的碎屏图中 ,发现了重要讯息: 1:微信支付将成为重要场景: 2:这些应用与春节关系不小,很多应用在春节时,有重要的场景开启可能性: 3:春节是 ...

- ZKWeb网站框架的动态编译的实现原理

ZKWeb网站框架是一个自主开发的网页框架,实现了动态插件和自动编译功能. ZKWeb把一个文件夹当成是一个插件,无需使用csproj或xproj等形式的项目文件管理,并且支持修改插件代码后自动重新编 ...

- C站投稿189网盘视频源(UP主篇)

C站投稿189网盘视频源(UP主篇) 现在C站(吐槽弹幕网)的视频来源基本靠的都是189网盘,比如番剧区的每个视频基本来源于此,不像AB两站,拥有自己的资源服务器,为啥呢?没钱啊.都是外来的视频.本站 ...

- 我为什么要自己编译openjdk8以及那些坑

我为什么要自己编译openjdk8以及那些坑 这是笔者第二次编译openjdk, 第一次编译的是openjdk7,那么好多人会好奇,为什么要自己编译openjdk呢,官方不是已经发布了安装包了么? 要 ...