机器视觉:MobileNet 和 ShuffleNet

虽然很多CNN模型在图像识别领域取得了巨大的成功,但是一个越来越突出的问题就是模型的复杂度太高,无法在手机端使用,为了能在手机端将CNN模型跑起来,并且能取得不错的效果,有很多研究人员做了很多有意义的探索和尝试,今天就介绍两个比较轻量级的模型 mobile net 和 shuffle net。

在介绍这几个轻量型的网络之前,我们先来看看,为什么卷积神经网络的运算功耗这么大。

卷积神经网络,顾名思义,就是会有很多的卷积运算,而卷积神经网络中,最费时间的就是其中的卷积运算。我们知道,一张 h×w" role="presentation" style="position: relative;">h×wh×w 的图像,与一个 k×k" role="presentation" style="position: relative;">k×kk×k 的卷积核做卷积卷积运算,需要 h×w×k×k" role="presentation" style="position: relative;">h×w×k×kh×w×k×k 这么多次的运算,而 CNN 中,随便一个卷积层, 都会有几十甚至上百个 feature map, 假设卷积层 l1" role="presentation" style="position: relative;">l1l1 含有 c1" role="presentation" style="position: relative;">c1c1 个 feature map,即通道数为 c1" role="presentation" style="position: relative;">c1c1, 每个 feature map 的大小为 h1×w1" role="presentation" style="position: relative;">h1×w1h1×w1, 卷积核的大小为 k×k" role="presentation" style="position: relative;">k×kk×k,假设 l2" role="presentation" style="position: relative;">l2l2 的 feature map 大小与 l1" role="presentation" style="position: relative;">l1l1 一样,通道数为 c2" role="presentation" style="position: relative;">c2c2 ,l2" role="presentation" style="position: relative;">l2l2 中每个 feature map 上的一个像素点,都是由 l1" role="presentation" style="position: relative;">l1l1 上的 feature map 与 卷积核做卷积运算得来的。这样,总共需要的运算次数为:

Mobile-Net V1

为了减少运算量,Mobile-net V1 利用了 depth-wise 的概念,我们都知道 pooling 层的运作机理,input feature map 和 output feature map 是 一 一对应的,depth-wise convolution 也是类似的道理,做卷积的时候不再把 input feature map 进行线性组合了,而是采取一 一对应的方式,这样卷积的运算次数就变成了:

也就是说,我input 有 c1" role="presentation" style="position: relative;">c1c1 个 feature map,卷积之后,还是有 c1" role="presentation" style="position: relative;">c1c1 个 feature map,运算量减少了很多。

不过,也带来一个问题,这样卷积得到的 feature map 之间没有任何信息融合,这肯定不利于特征提取的,所以在 depth-wise 卷积运算后面,会再接一个 1×1" role="presentation" style="position: relative;">1×11×1 的卷积运算,所以总的运算次数是:

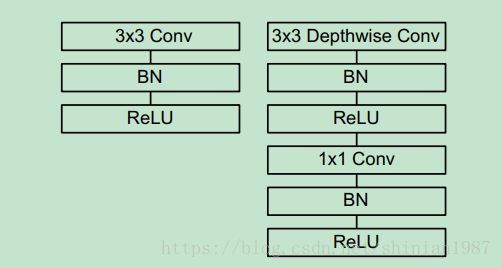

V1 主要的模块如下图所示,就是利用 depth-wise 卷积替换了常规的卷积运算,为了让得到的 feature map 进行信息融合,后面又接了一个 1×1" role="presentation" style="position: relative;">1×11×1 的卷积。

Mobile-Net V2

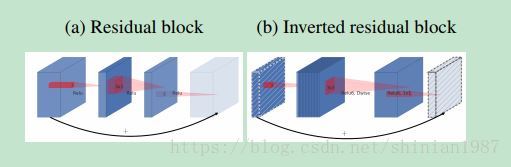

Mobile-Net V1 推出来之后,Google 又推出了 Mobile-Net V2,V2 在 residual-block 里面做文章,利用 depth-wise convolution 和 1×1" role="presentation" style="position: relative;">1×11×1 的卷积,简单来说,就是对 input feature map,先利用 1×1" role="presentation" style="position: relative;">1×11×1 进行通道扩展,这样一扩展,可以增加通道数,提升卷积层特征的表示能力,接着再利用 depth-wise convolution 做卷积运算,这样不会增加太多的运算量,又能利用很多的通道,最后再做一个通道压缩,一压缩,往后传的 feature map 的通道数并不会增加,论文中也给出了示意图:

Shuffle-Net

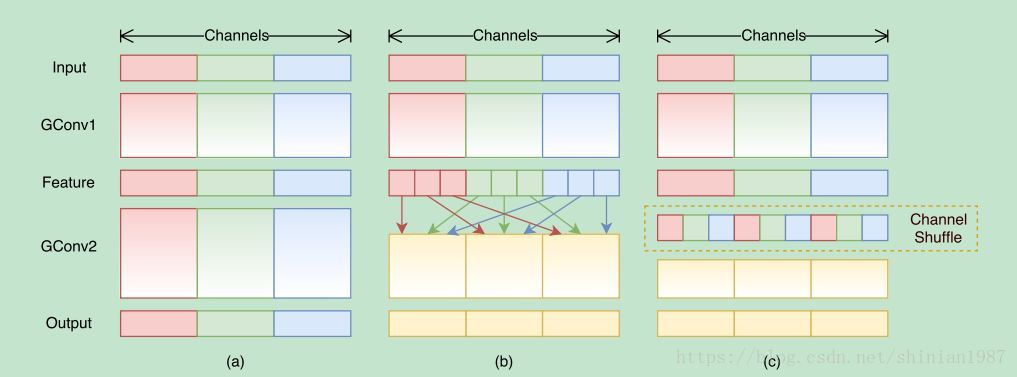

shuffle-net 这个网络模型,是利用了 group 卷积的概念,与 depth-wise 有点像,只不过,depth-wise 是 feature map 一 一对应的,而 group 卷积是将每个卷积层的 feature map 分成几个组,每个组之间没有交叉,不过组内的 feature map 做卷积的时候和常规的卷积运算是一样的,所以 group 卷积的复杂度应该是介于常规卷积核 depth-wise 卷积之间的,shuffle-net 的创新之处在于,group 卷积之后,为了增加组与组之间的 feature map的通信,提出了一个 shuffle channel 的技术,就是将 group 卷积之后 feature map 打乱,乱序连接到下一层,如下图所示:

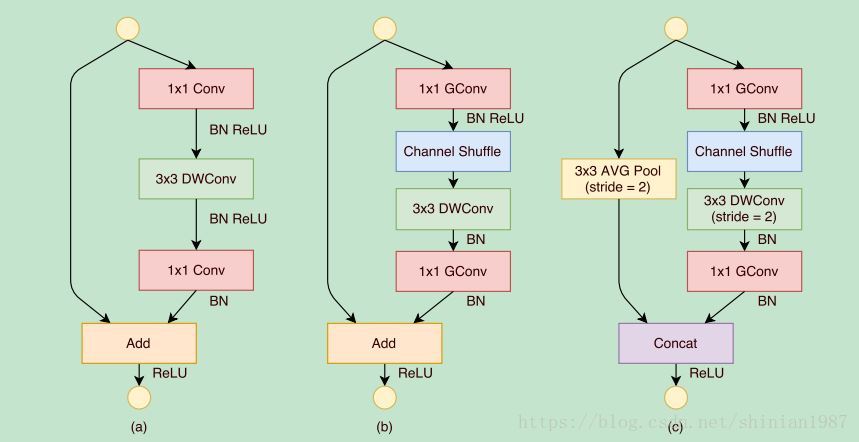

通过 group 卷积,可以降低运算量,通过 channel shuffle,可以增加 feature map之间的信息融合,所以 shuffle-net 也能在提升运算效率的同时,保持一定的特征学习能力。论文也给出几种不同的 block,

上图 (a) 是利用 depth-wise 卷积,(b) 和 (c) 都是 shuffle-net 的模块,不同的就是卷积的 stride 不同,所以最后的处理方式也不太一样。

参考文献

1: MobileNets: Efficient Convolutional Neural Networks for Mobile Vision

Applications

2: MobileNetV2: Inverted Residuals and Linear Bottlenecks

3: ShuffleNet: An Extremely Efficient Convolutional Neural Network for Mobile

Devices

机器视觉:MobileNet 和 ShuffleNet的更多相关文章

- 图像分类丨浅析轻量级网络「SqueezeNet、MobileNet、ShuffleNet」

前言 深度卷积网络除了准确度,计算复杂度也是考虑的重要指标.本文列出了近年主流的轻量级网络,简单地阐述了它们的思想.由于本人水平有限,对这部分的理解还不够深入,还需要继续学习和完善. 最后我参考部分列 ...

- 纵览轻量化卷积神经网络:SqueezeNet、MobileNet、ShuffleNet、Xception

近年提出的四个轻量化模型进行学习和对比,四个模型分别是:SqueezeNet.MobileNet.ShuffleNet.Xception. SqueezeNet https://arxiv.org/p ...

- 面向移动端的轻量级神经网络模型mobilenet、ShuffleNet

翻译: http://baijiahao.baidu.com/s?id=1565832713111936&wfr=spider&for=pc http://baijiahao.baid ...

- 深度学习与CV教程(10) | 轻量化CNN架构 (SqueezeNet,ShuffleNet,MobileNet等)

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/37 本文地址:http://www.showmeai.tech/article-det ...

- mobienet, shufflenet

参考github上各位大神的代码 mobilenet和shufflenet,实现起来感觉还是各种问题. mobilenet目前使用的代码来自这里:https://github.com/BVLC/caf ...

- CNN 模型压缩与加速算法综述

本文由云+社区发表 导语:卷积神经网络日益增长的深度和尺寸为深度学习在移动端的部署带来了巨大的挑战,CNN模型压缩与加速成为了学术界和工业界都重点关注的研究领域之一. 前言 自从AlexNet一举夺得 ...

- Feature Extractor[content]

0. AlexNet 1. VGG VGG网络相对来说,结构简单,通俗易懂,作者通过分析2013年imagenet的比赛的最好模型,并发现感受野还是小的好,然后再加上<network in ne ...

- mobile deeplearning

框架: 腾讯ncnn https://github.com/Tencent/ncnn 百度mobile-deep-learning https://github.com/baidu/mobile-de ...

- 【转载】NeurIPS 2018 | 腾讯AI Lab详解3大热点:模型压缩、机器学习及最优化算法

原文:NeurIPS 2018 | 腾讯AI Lab详解3大热点:模型压缩.机器学习及最优化算法 导读 AI领域顶会NeurIPS正在加拿大蒙特利尔举办.本文针对实验室关注的几个研究热点,模型压缩.自 ...

随机推荐

- nvm 设置 nodejs 默认版本

nvm 设置 nodejs 默认版本 windows 系统的版本管理软件是nodist mac系统的node版本管理根据是nvm 每次重启vscode软件后,nvm ls 看到的默认版本都会恢复到v5 ...

- [luogu P2633] Count on a tree

[luogu P2633] Count on a tree 题目描述 给定一棵N个节点的树,每个点有一个权值,对于M个询问(u,v,k),你需要回答u xor lastans和v这两个节点间第K小的点 ...

- PDF 补丁丁 0.6.0.3427 版发布(修复提取图片问题)

新的版本进一步改善了导出图片的问题.

- linux 下mysql多实例安装

1.软件下载 https://dev.mysql.com/downloads/file/?id=479096 免编译二进制包 mysql-5.6.21-linux-glibc2.5-x86_64.ta ...

- 装B命令行,常用Windows命令

winver检查Windows版本 dxdiag检查DirectX信息 gpedit.msc 组策略 regedit.exe 注册表 Msconfig.exe 系统配置实用程序 lusrmgr. ...

- 常用命令和sql

常用命令: mvn idea:idea //生成.ipr项目文件 mvn clean install -Dmaven.test.skip=true mvn install:install-file - ...

- 未知高度的div自适应图片高度

<div style="background-image: url(http://your-image.jpg);"> <img src="http:/ ...

- [Leetcode 452] 最少需要射出多少支箭Minimum Number of Arrows to Burst Balloons 贪心 重载

[题目] There are a number of spherical balloons spread in two-dimensional space. For each balloon, pro ...

- python 捕获异常顺序

catch 异常的时候,有关的异常(若是抛出子类异常,则父类异常的except也算.反之不算)except的语句是按代码顺序执行, 也就是说,当一个异常发生时,从若干except中若遇见异常类基类,父 ...

- j2ee期末项目 新闻发布系统需求文档

1 绪论 1.1 开发背景 现如今社会是信息化的社会,掌握的信息越多越全面越快速的人,就会在各方面的竞争当中,占据优势,正所谓知己知彼百战不殆,信息的不对称性将会是失败的主要诱因之一.信息的时效性越来 ...