Caffe使用step by step:caffe框架下的基本操作和分析

caffe虽然已经安装了快一个月了,但是caffe使用进展比较缓慢,果然如刘老师说的那样,搭建起来caffe框架环境比较简单,但是完整的从数据准备->模型训练->调参数->合理结果需要一个比较长的过程,这个过程中你需要对caffe中很多东西,细节进行深入的理解,这样才可以知道为什么能有这样的结果,在训练或者fine-tuning时知道针对调整的方法。下面针对caffe中的使用进行讲解。

在使用过程中,caffe官网上提供了详细的使用说明,如果感觉仍然存在一些困难,可以使用谷歌或百度搜索自己遇到的问题和想要了解的过程进行搜索学习。

一、Caffe模型基本组成

想要训练一个caffe模型,需要配置两个文件,包含两个部分:网络模型,参数配置,分别对应***.prototxt , ****_solver.prototxt文件

Caffe模型文件讲解:

- 预处理图像的leveldb构建

输入:一批图像和label (2和3)

输出:leveldb (4)

指令里包含如下信息:- conver_imageset (构建leveldb的可运行程序)

- train/ (此目录放处理的jpg或者其他格式的图像)

- label.txt (图像文件名及其label信息)

- 输出的leveldb文件夹的名字

- CPU/GPU (指定是在cpu上还是在gpu上运行code)

CNN网络配置文件

- Imagenet_solver.prototxt (包含全局参数的配置的文件)

- Imagenet.prototxt (包含训练网络的配置的文件)

- Imagenet_val.prototxt (包含测试网络的配置文件)

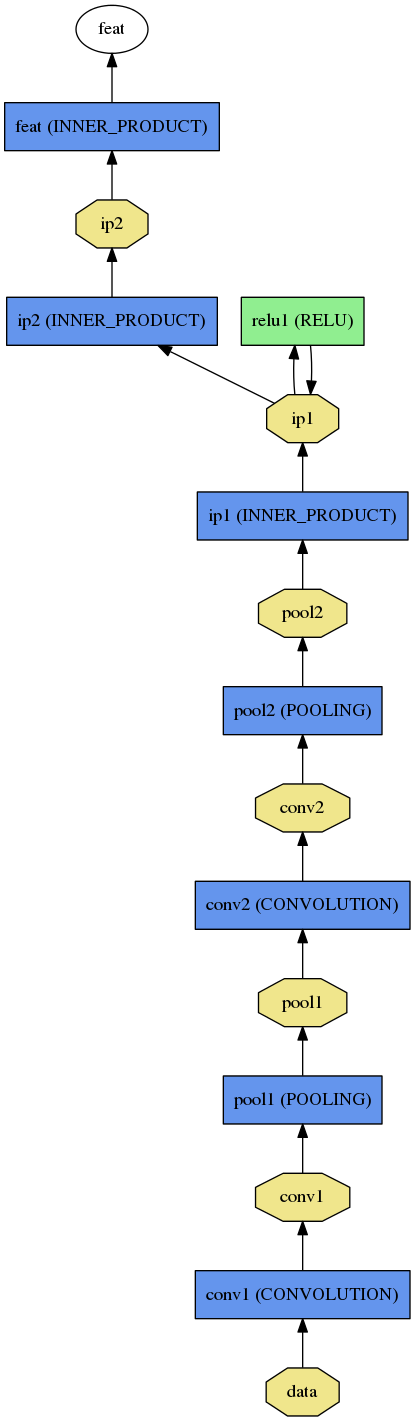

网络模型:即定义你网络的每一层,下图是用caffe中 /python/draw_net.py画出的的siamese的模型,非常清晰

层包含:(以LeNet为例)

DATA:一般包括训练数据和测试数据层两种类型。 一般指输入层,包含source:数据路径,批处理数据大小batch_size,scale表示数据表示在[0,1],0.00390625即 1/255

训练数据层:

layer {

name: "mnist"

type: "Data"

top: "data"

top: "label"

include {

phase: TRAIN

}

transform_param {

scale: 0.00390625

}

data_param {

source: "examples/mnist/mnist_train_lmdb"

batch_size: 64

backend: LMDB

}

}

测试数据层:

layer {

name: "mnist"

type: "Data"

top: "data"

top: "label"

include {

phase: TEST

}

transform_param {

scale: 0.00390625

}

data_param {

source: "examples/mnist/mnist_test_lmdb"

batch_size:

backend: LMDB

}

}

CONVOLUATION:卷积层,blobs_lr:1 , blobs_lr:2分别表示weight 及bias更新时的学习率,这里权重的学习率为solver.prototxt文件中定义的学习率真,bias的学习率真是权重学习率的2倍,这样一般会得到很好的收敛速度。

num_output表示滤波的个数,kernelsize表示滤波的大小,stride表示步长,weight_filter表示滤波的类型

layer {

name: "conv1"

type: "Convolution"

bottom: "data"

top: "conv1"

param {

lr_mult: 1 //weight学习率

}

param {

lr_mult: 2 //bias学习率,一般为weight的两倍

}

convolution_param {

num_output: 20 //滤波器个数

kernel_size:

stride: 1 //步长

weight_filler {

type: "xavier"

}

bias_filler {

type: "constant"

}

}

}

POOLING: 池化层

layer {

name: "pool1"

type: "Pooling"

bottom: "conv1"

top: "pool1"

pooling_param {

pool: MAX

kernel_size: 2

stride:

}

}

INNER_PRODUCT: 其实表示全连接,不要被名字误导

layer {

name: "ip1"

type: "InnerProduct"

bottom: "pool2"

top: "ip1"

param {

lr_mult:

}

param {

lr_mult:

}

inner_product_param {

num_output: 500

weight_filler {

type: "xavier"

}

bias_filler {

type: "constant"

}

}

}

RELU:激活函数,非线性变化层 max( 0 ,x ),一般与CONVOLUTION层成对出现

layer {

name: "relu1"

type: "ReLU"

bottom: "ip1"

top: "ip1"

}

SOFTMAX:

layer {

name: "loss"

type: "SoftmaxWithLoss"

bottom: "ip2"

bottom: "label"

top: "loss"

}

参数配置文件:

***_solver.prototxt文件定义一些模型训练过程中需要到的参数,比较学习率,权重衰减系数,迭代次数,使用GPU还是CPU等等

# The train/test net protocol buffer definition

net: "examples/mnist/lenet_train_test.prototxt" # test_iter specifies how many forward passes the test should carry out.

# In the case of MNIST, we have test batch size and test iterations,

# covering the full , testing images.

test_iter: # Carry out testing every training iterations.

test_interval: # The base learning rate, momentum and the weight decay of the network.

base_lr: 0.01

momentum: 0.9

weight_decay: 0.0005 # The learning rate policy

lr_policy: "inv"

gamma: 0.0001

power: 0.75 # Display every iterations

display: # The maximum number of iterations

max_iter: # snapshot intermediate results

snapshot:

snapshot_prefix: "examples/mnist/lenet" # solver mode: CPU or GPU

solver_mode: GPU

device_id: 0 #在cmdcaffe接口下,GPU序号从0开始,如果有一个GPU,则device_id:0

训练出的模型被存为***.caffemodel,可供以后使用。

二、使用caffe训练模型包含以下几个步骤:

- 准备数据

在caffe中使用数据来对机器学习算法进行训练时,首先需要了解基本数据组成。不论使用何种框架进行CNNs训练,共有3种数据集:

- Training Set:用于训练网络

- Validation Set:用于训练时测试网络准确率

- Test Set:用于测试网络训练完成后的最终正确率

- 重建lmdb/leveldb文件,caffe支持三种数据格式输入:images, levelda, lmdb

Caffe生成的数据分为2种格式:Lmdb和Leveldb

- 它们都是键/值对(Key/Value Pair)嵌入式数据库管理系统编程库。

- 虽然lmdb的内存消耗是leveldb的1.1倍,但是lmdb的速度比leveldb快10%至15%,更重要的是lmdb允许多种训练模型同时读取同一组数据集。

- 因此lmdb取代了leveldb成为Caffe默认的数据集生成格式。

- 定义name.prototxt , name_solver.prototxt文件

- 训练模型

三、caffe中比较有用且基础的接口(cmdcaffe)

注:在使用cmdcaffe时,需要默认切换到Caffe_Root文件夹下

1、训练模型,以mnist为例子

./build/tools/caffe train --solver=examples/mnist/lenet_solver.prototxt

注:caffe官网上给的例子不能直接执行,需要使用上述命令才可以使用tools下的caffe接口,因为caffe默认都需要从根目录下面执行文件。

2、观察各个阶段的运行时间可以使用

./build/tools/caffe time --model=models/bvlc_reference_caffenet/train_val.prototxt

3、使用已有模型提取特征

./build/tools/extract_features.bin models/bvlc_reference_caffenet/bvlc_reference_caffenet.caffemodel examples/_temp/imagenet_val.prototxt conv5 examples/_temp/features

conv5表示提取第五个卷积层的特征, examples/_temp/feaures表示存放结果的目录(这里的目录需要提前构建好)

4、对已有模型进行find-tuning,比如我们现在有一个1000类的分类模型,但目前我们的需求仅是20类,此时我们不需要重新训练一个模型,只需要将最后一层换成20类的softmax层,然后使用已有数据对原模型进行fine-tuning即可

在很多时候,使用Caffe框架学习深度学习模型时,从ImageNet或者其他大型数据集从头开始训练获得一个fine-tuing合适的模型难度太大,这时候最好的情况,就是在已经训练好的模型上面来进行fine-tuning,通过这些过程可以加深自己对深度学习,以及对caffe使用的了解和熟悉,以方便自己在后续提出自己的模型,自己进行模型训练和fine-tuning的过程。

已经训练好的caffe模型可以在git的caffe项目中下载,比较经典的模型有:AlexNet.caffemodel , LeNet.caffemodel , RCnn.caffemodel,其他的大家可以在caffe的git官网上面下载。

使用自己的数据集对已经训练好的模型进行fine-tuning的操作(使用cmdcaffe接口来进行):

./build/tools/caffe train -solver models/finetune_flickr_style/solver.prototxt -weights models/bvlc_reference_caffenet/bvlc_reference_caffenet.caffemodel -gpu 0

[option] 2>&1 | tee log.txt

第一个参数:选择好caffe模块

train:选取train函数

后面接具体的参数,分别为配置命令,配置文件路径,fine-tuning命令,fine-tuning依赖的基准模型文件目录,选用的训练方式:gpu或者cpu,使用cpu时可以默认不写

注:fine-tuning的过程与训练过程类似,只是在调用caffe接口时的命令不同,因此在fine-tuning之前,仍然需要按照训练流程准备数据。

下载数据->生成trainset和testset->生成db->设置好路径->fine-tuning。

5、还有一个是python下面的接口,draw_net.py可以根据.prototxt文件将模式用图示的方法表示出来,博文开始的模型图即用该接口所绘

./python/draw_net.py ./examples/siamese/mnist_siamese.prototxt ./examples/siamese/mnist_siamese.png

使用该接口进行网络的绘制示例化

第一个参数为模型文件,第二个参数为所绘模型图的保存地址

深度学习中batch_size的作用:

在深度学习训练过程中,有两种训练方法,一种意识batch ,一种是stochastic训练方法

solver:使用forward和backward接口来更新参数,并迭代对loss进行降低(定义的优化方法,有stochastic gradient descent,SGD;Adaptive gradient ,NAG和Scaffolding)

solver作用:(指定优化方法)

1.可以逐步对网络寻优,创建训练得到的网络,并对测试网络进行评价;

2.通过调用forward和backward来对网络参数进行迭代寻优;

3.周期性更新网络;

4.记录网络训练中间过程,寻优过程中记录状态

Caffe网络模型文件分析:

一个完整的基于caffe的网络模型,应该包含以下几个文件:

其中,deploy.prototxt是用来在网络完成训练之后进行部署的(其他深度学习框架导入caffemodel文件时,也是以此为原型),solver.prototxt用于设定网络训练时的参数,train_val.prototxt用于对网络进行训练的模型定义,*.caffemodel是预训练好的网络模型,存储网络中的参数。

caffe和theano以及lasagne转化过程中的一些基础知识:

在caffe结构中,在convLayer层中有group这样一个参数,该参数来自于经典的ImageNet论文,关于group参数,yangqing给的解释为:

It was there to implement the grouped convolution in Alex Krizhevsky's paper: when group=2, the first half of the filters are only connected to the first half of the input channels, and the second half only connected to the second half.

即当group=2时,filter的前半部分同输入连接,后半部分同后半部分的filter连接,而在lasagne中并没有对应的该参数,因此需要使用官方给定的函数接口来进行实现。

具体见:地址

参考博客:Caffe 初识,揭开面纱

Caffe使用step by step:caffe框架下的基本操作和分析的更多相关文章

- 【神经网络与深度学习】Caffe使用step by step:caffe框架下的基本操作和分析

caffe虽然已经安装了快一个月了,但是caffe使用进展比较缓慢,果然如刘老师说的那样,搭建起来caffe框架环境比较简单,但是完整的从数据准备->模型训练->调参数->合理结果需 ...

- MySQL在Django框架下的基本操作(MySQL在Linux下配置)

[原]本文根据实际操作主要介绍了Django框架下MySQL的一些常用操作,核心内容如下: ------------------------------------------------------ ...

- Caffe框架下的图像回归测试

Caffe框架下的图像回归测试 参考资料: 1. http://stackoverflow.com/questions/33766689/caffe-hdf5-pre-processing 2. ht ...

- caffe框架下目标检测——faster-rcnn实战篇操作

原有模型 1.下载fasrer-rcnn源代码并安装 git clone --recursive https://github.com/rbgirshick/py-faster-rcnn.git 1) ...

- Caffe使用step by step:faster-rcnn目标检测matlab代码

faster-rcnn是MSRA在物体检测最新的研究成果,该研究成果基于RCNN,fast rcnn以及SPPnet,对之前目标检测方法进行改进,faster-rcnn项目地址.首先,faster r ...

- caffe框架下目标检测——faster-rcnn实战篇问题集锦

1.问题 解决方案:没编译好,需要在lib下编译make 需要在caffe-fast-rcnn下编译make或者make all -j16 ,还需要make pycaffe 2.问题 解决方案:/p ...

- EF框架step by step(7)—Code First DataAnnotations(2)

上一篇EF框架step by step(7)—Code First DataAnnotations(1)描述了实体内部的采用数据特性描述与表的关系.这一篇将用DataAnnotations描述一下实体 ...

- EF框架step by step(7)—Code First DataAnnotations(1)

Data annotation特性是在.NET 3.5中引进的,给ASP.NET web应用中的类提供了一种添加验证的方式.Code First允许你使用代码来建立实体框架模型,同时允许用Data a ...

- WPF Step By Step 系列-Prism框架在项目中使用

WPF Step By Step 系列-Prism框架在项目中使用 回顾 上一篇,我们介绍了关于控件模板的用法,本节我们将继续说明WPF更加实用的内容,在大型的项目中如何使用Prism框架,并给予Pr ...

随机推荐

- MVC,MVP和MVVM的区别

MVC 转载标名出处 dub 从这幅图可以看到,我们可以看到在MVC里,View是可以直接访问Model的!从而,View里会包含Model信息,不可避免的还要包括一些业务逻辑. 在MVC模型 ...

- visual studio 2017 installer 安装包制作过程出现的问题---此安装程序需要.NET Framework 版本 3.5,请安装该版本,然后重新运行此安装程序,可以从Web获得.NET Framework 。要立即做此事吗?

图一 visual studio 2017 installer 打包完成以后进行安装时,提示信息 “安装此安装程序需要.NET Framework 版本 3.5,请安装该版本,然后重新运行此安装程序, ...

- 【svn】svn的使用

直接看这个教程:http://www.runoob.com/svn/svn-tutorial.html 里面讲得很有条理,很容易看懂.提供了指令以及相应的名词解释.不像其他网上的资料,干巴巴的只有一对 ...

- hdu3183 rmq求区间最值的下标

两个月前做的题,以后可以看看,是rmq关于求区间最值的下标 /* hdu3183 终点 给一个整数,可以删除m位,留下的数字形成一个新的整数 rmq 取n-m个数,使形成的数最小 */ #includ ...

- Python 索引迭代

1.使用enumerate函数 L = ['Adam', 'Lisa', 'Bart', 'Paul'] for index, name in enumerate(L): print inde ...

- appium自动化测试之元素定位

方法一 使用SDK中附带的uiautomatorviewer来定位 在SDK安装目录下的tools下有个uiautomatorviewer.bat批处理文件点击运行 运行后(注意appium desk ...

- 基于GTID环境的数据恢复

下面说一个线上环境的数据恢复案例,线上环境误操作的事情,随时都有可能发生的,这时候运维DBA或者DBA会想,没人会傻到把数据库干掉的吧?又或者没有会闲得蛋痛删除了几条数据又想恢复这么无聊吧?适适这样的 ...

- extern "C" 回顾

引入:在测试"extern "C" 与gcc, g++无关"时,使用到了extern "C"的概念,网上找篇文章回顾一下. 试验如下: te ...

- Gitlab库已损坏前端显示500错误解决方法

1.问题起因 办公网机房意外断掉,导致gitlab库文件损坏.开发打开gitlab显示500 2.查看日志 命令查看:gitlab-ctl tail 或者手动查看:/var/log/gitlab/gi ...

- 《Kafka技术内幕》学习笔记

第一章 Kafka入门 1.1 Kafka流式数据平台 Kafka作为流式数据平台的特点: 消息系统:两种消息模型:队列和发布订阅. 队列模型:将处理工作平均分给消费组中的消费者成员. 发布订阅模型: ...