lucene随笔 IKAnalyzer StandardAnalyzer

StandardAnalyzer 是单词分词器:

String msg = "我喜欢你,我的祖国!china 中国,I love you!中华人民共和国";

分词后的结果:[我],[喜],[欢],[你],[我],[的],[祖],[国],[china],[中],[国],[i],[love],[you],[中],[华],[人],[民],[共],[和],[国]

IKAnalyzer 是中文分词器:

分词后的结果:[我],[喜欢],[你],[我],[的],[祖国],[china],[中国],[i],[love],[you],[中华人民共和国]

package com.shrio.lucene; import org.apache.lucene.analysis.Analyzer;

import org.apache.lucene.analysis.TokenStream;

import org.apache.lucene.analysis.standard.StandardAnalyzer;

import org.apache.lucene.analysis.tokenattributes.CharTermAttribute;

import org.apache.lucene.util.Version;

import org.wltea.analyzer.lucene.IKAnalyzer; import java.io.IOException;

import java.io.StringReader; /**

* Created by luojie on 2018/4/24.

*/

public class ChineseAnalyerDemo {

/**standardAnalyer分析器 ,Lucene内置中文分析器*/

public void standardAnalyer(String msg){

StandardAnalyzer analyzer = new StandardAnalyzer(Version.LUCENE_4_10_4);

this.getTokens(analyzer, msg);

} /**IK Analyzer分析器*/

public void iKanalyer(String msg){

IKAnalyzer analyzer = new IKAnalyzer(true);//当为true时,分词器进行最大词长切分

//IKAnalyzer analyzer = new IKAnalyzer();

this.getTokens(analyzer, msg);

} private void getTokens(Analyzer analyzer, String msg) {

try {

TokenStream tokenStream=analyzer.tokenStream("content", new StringReader(msg));

tokenStream.reset();

this.printTokens(analyzer.getClass().getSimpleName(),tokenStream);

tokenStream.end();

} catch (IOException e) {

e.printStackTrace();

} } private void printTokens(String analyzerType,TokenStream tokenStream){

CharTermAttribute ta = tokenStream.addAttribute(CharTermAttribute.class);

StringBuffer result =new StringBuffer();

try {

while(tokenStream.incrementToken()){

if(result.length()>0){

result.append(",");

}

result.append("["+ta.toString()+"]");

}

} catch (IOException e) {

e.printStackTrace();

}

System.out.println(analyzerType+"->"+result.toString());

}

}

package com.shrio.lucene; import org.junit.Before;

import org.junit.Test; /**

* Created by luojie on 2018/4/24.

*/

public class TestChineseAnalyizer { private ChineseAnalyerDemo demo = null; private String msg = "我喜欢你,我的祖国!china 中国,I love you!中华人民共和国";

//private String msg = "I love you, China!B2C";

@Before

public void setUp() throws Exception {

demo=new ChineseAnalyerDemo();

}

@Test

public void testStandardAnalyer(){

demo.standardAnalyer(msg);

demo.iKanalyer(msg);

}

@Test

public void testIkAnalyzer(){

demo.iKanalyer(msg);

}

}

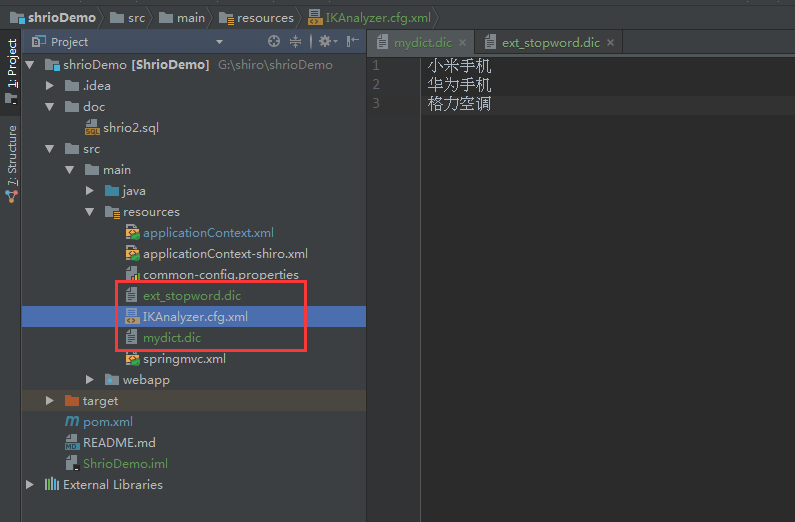

IKAnalyzer 独立使用 配置扩展词典

IKAnalyzer.cfg.xml必须在src根目录下

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties> <comment>IK Analyzer 扩展配置</comment>

<!-- 用户可以在这里配置自己的扩展字典 -->

<entry key="ext_dict">mydict.dic</entry>

<!-- 用户可以在这里配置自己的扩展停用词字典 -->

<entry key="ext_stopwords">ext_stopword.dic</entry> </properties>

lucene随笔 IKAnalyzer StandardAnalyzer的更多相关文章

- solr、Lucene、IKAnalyzer这三者关系是怎样的?

lucene 是开源搜索引擎 solr 是基于 lucene开发的搜索引擎 IK 是中文分词. lucene 不是一个搜索引擎,只是一个基础的文件索引工具包,或者叫“搜索引擎开发包”.不能单独作为程序 ...

- Lucene使用IKAnalyzer分词实例 及 IKAnalyzer扩展词库

文章转载自:http://www.cnblogs.com/dennisit/archive/2013/04/07/3005847.html 方案一: 基于配置的词典扩充 项目结构图如下: IK分词器还 ...

- Lucene学习——IKAnalyzer中文分词

一.环境 1.平台:MyEclipse8.5/JDK1.5 2.开源框架:Lucene3.6.1/IKAnalyzer2012 3.目的:测试IKAnalyzer的分词效果 二.开发调试 1.下载框架 ...

- Lucene使用IKAnalyzer分词

1.分析器 所有分析器最终继承的类都是Analyzer 1.1 默认标准分析器:StandardAnalyzer 在我们创建索引的时候,我们使用到了Index ...

- Lucene基于IKAnalyzer配置的词典扩充

在web项目的src目录下创建IKAnalyzer.cfg.xml文件,内容如下 <?xml version="1.0" encoding="UTF-8" ...

- lucene+IKAnalyzer实现中文纯文本检索系统

首先IntelliJ IDEA中搭建Maven项目(web):spring+SpringMVC+Lucene+IKAnalyzer spring+SpringMVC搭建项目可以参考我的博客 整合Luc ...

- Lucene系列四:Lucene提供的分词器、IKAnalyze中文分词器集成、扩展 IKAnalyzer的停用词和新词

一.Lucene提供的分词器StandardAnalyzer和SmartChineseAnalyzer 1.新建一个测试Lucene提供的分词器的maven项目LuceneAnalyzer 2. 在p ...

- 通过lucene的StandardAnalyzer分析器来了解分词

本文转载http://blog.csdn.net/jspamd/article/details/8194919 不同的Lucene分析器Analyzer,它对TokenStream进行分词的方法是不同 ...

- Lucene第一讲——概述与入门

一.概述 1.什么是Lucene? Lucene是apache下的一个开源的全文检索引擎工具包. 它为软件开发人员提供一个简单易用的工具包(类库),以方便的在目标系统中实现全文检索的功能. 2.能干什 ...

随机推荐

- js--阻止冒泡,捕获,默认行为

防止冒泡和捕获 w3c的方法是e.stopPropagation(),IE则是使用e.cancelBubble = true· var el = window.document.getElementB ...

- leetcode 刷题 数组类 Two Sum

---恢复内容开始--- Two Sum Given an array of integers ,find two numbers such that they add up to a specifi ...

- OOP⑵

1.问题? 怎么创建对象? 类名 对象名=new 类名(); 在java中只要是看到了()! 这就是方法! 2.构造方法: 创建某个对象的方法! Student stu=new Student(); ...

- fedora网络设置

一:网络设置 1.找到要设置的网卡 命令:ip addr 列出所有的网络配置,找到你需要配置的网卡 入图,我这个是ens33 2.找到配置文件 配置文件路径: /etc/sysconfig/netwo ...

- python logging模块,升级print调试到logging。

简介: 我们在写python程序的时候,很多时候都有bug,都是自己写的,自己造的孽,又的时候报错又是一堆,不知道是那部分出错了. 我这初学者水平,就是打print,看哪部分执行了,哪部分没执行,由此 ...

- sqlalchemy(二)简单的连接示例

# -*- coding: utf-8 -*- import sqlalchemy from sqlalchemy import create_engine from sqlalchemy.ext.d ...

- 三. Python基础(3)--语法

三. Python基础(3)--语法 1. 字符串格式化的知识补充 tpl = "我是%s,年龄%d,学习进度100%" %('Arroz',18) print(tpl) # 会提 ...

- DevExpress WinForms v18.2新版亮点(二)

行业领先的.NET界面控件2018年第二次重大更新——DevExpress v18.2日前正式发布,本站将以连载的形式为大家介绍各版本新增内容.本文将介绍了DevExpress WinForms v1 ...

- Eclipse几点常用设置+个人喜好

1.代码自动提示 在我们忘记方法名或者想偷懒时,代码自动提示很管用.不过Eclipse默认是输入"."后才会出现包或类成员的提示,也就意味着我们必须先输入一个完整的类名,提示才能出 ...

- LVS+OSPF+FULLNAT集群架构

OSPF:OSPF(Open Shortest Path First开放式最短路径优先)是一个内部网关协议(Interior Gateway Protocol,简称IGP),用于在单一自治系统(aut ...