python 爬取链家

import json import requests

from lxml import etree

from time import sleep url = "https://sz.lianjia.com/ershoufang/rs/"

headers = {

"User-Agent":"",

"Refer":"https://sz.lianjia.com/ershoufang/pg2/"

}

resp = requests.get(url,headers=headers) base_url = "https://sz.lianjia.com/ershoufang/pg{}/"

html = etree.HTML(resp.text)

data = html.xpath('//*[@id="content"]//div[@class="page-box fr"]/div/@page-data')

data = json.loads(data[0])

totalPage = data['totalPage']

curPage = data['curPage'] def get_data(url):

list = []

resp = requests.get(url, headers=headers)

html = etree.HTML(resp.text)

ul = html.xpath('.//ul[@class="sellListContent"]/li')

for li in ul:

face = li.xpath('./a/img/@src')

title = li.xpath('.//div[@class="title"]/a/text()')

position = li.xpath('.//div[@class="positionInfo"]/a/text()')

house_info = li.xpath('.//div[@class="houseInfo"]/text()')

follow_info = li.xpath('.//div[@class="followInfo"]/text()')

price = li.xpath('.//div[@class="priceInfo"]/div[@class="totalPrice"]/span/text()')

unit_price = li.xpath('.//div[@class="priceInfo"]/div[@class="unitPrice"]/span/text()')

tag = li.xpath('.//div[@class="tag"]//span/text()')

content = {}

content["face"] = face[0]

content["title"] = title[0]

content["position"] = position[0]

content["house_info"] = house_info[0]

content["follow_info"] = follow_info[0]

content["price"] = price[0]

content["unit_price"] = unit_price[0]

if len(tag) >=1 and tag[0] is not None:

content['tag'] = tag[0]

list.append(content)

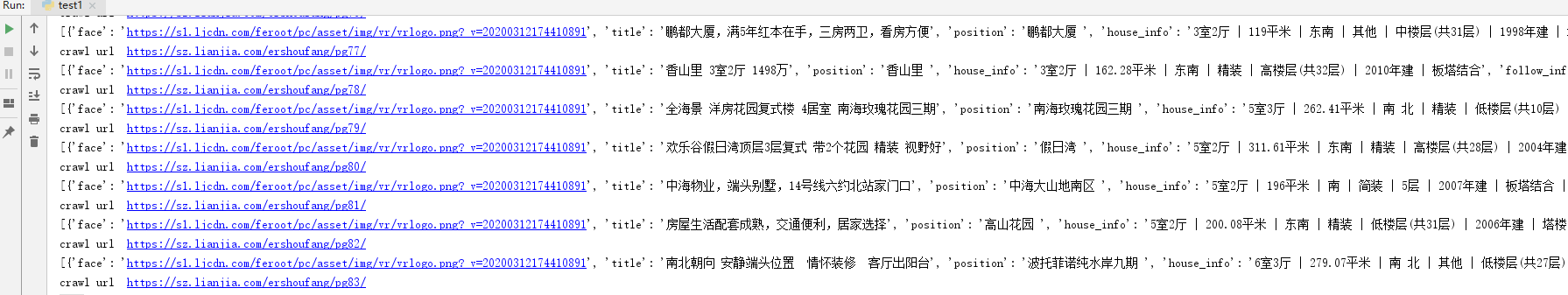

return list totalList = []

for i in range(1,totalPage+1):

url = base_url.format(i)

print("crawl url " + url)

cur_list = get_data(url)

print(cur_list)

totalList = totalList + cur_list url = base_url.format(1) print(totalList)

python 爬取链家的更多相关文章

- Python爬取链家二手房源信息

爬取链家网站二手房房源信息,第一次做,仅供参考,要用scrapy. import scrapy,pypinyin,requests import bs4 from ..items import L ...

- 适合初学者的Python爬取链家网教程

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: TinaLY PS:如有需要Python学习资料的小伙伴可以加点击下 ...

- python爬取链家二手房信息,确认过眼神我是买不起的人

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理. PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取 python免费学习资 ...

- Python爬虫项目--爬取链家热门城市新房

本次实战是利用爬虫爬取链家的新房(声明: 内容仅用于学习交流, 请勿用作商业用途) 环境 win8, python 3.7, pycharm 正文 1. 目标网站分析 通过分析, 找出相关url, 确 ...

- Python的scrapy之爬取链家网房价信息并保存到本地

因为有在北京租房的打算,于是上网浏览了一下链家网站的房价,想将他们爬取下来,并保存到本地. 先看链家网的源码..房价信息 都保存在 ul 下的li 里面 爬虫结构: 其中封装了一个数据库处理模 ...

- python爬虫:爬取链家深圳全部二手房的详细信息

1.问题描述: 爬取链家深圳全部二手房的详细信息,并将爬取的数据存储到CSV文件中 2.思路分析: (1)目标网址:https://sz.lianjia.com/ershoufang/ (2)代码结构 ...

- python爬虫:利用BeautifulSoup爬取链家深圳二手房首页的详细信息

1.问题描述: 爬取链家深圳二手房的详细信息,并将爬取的数据存储到Excel表 2.思路分析: 发送请求--获取数据--解析数据--存储数据 1.目标网址:https://sz.lianjia.com ...

- Python——Scrapy爬取链家网站所有房源信息

用scrapy爬取链家全国以上房源分类的信息: 路径: items.py # -*- coding: utf-8 -*- # Define here the models for your scrap ...

- Scrapy实战篇(一)之爬取链家网成交房源数据(上)

今天,我们就以链家网南京地区为例,来学习爬取链家网的成交房源数据. 这里推荐使用火狐浏览器,并且安装firebug和firepath两款插件,你会发现,这两款插件会给我们后续的数据提取带来很大的方便. ...

随机推荐

- [LeetCode]695. 岛屿的最大面积(DFS/BFS)、200. 岛屿数量(DFS/BFS待做/并差集待做)

695. 岛屿的最大面积 题目 给定一个包含了一些 0 和 1的非空二维数组 grid , 一个 岛屿 是由四个方向 (水平或垂直) 的 1 (代表土地) 构成的组合.你可以假设二维矩阵的四个边缘都被 ...

- k8s重要概念及部署k8s集群(一)

k8s介绍 Kubernetes(k8s)是Google开源的容器集群管理系统(谷歌内部:Borg).在Docker技术的基础上,为容器化的应用提供部署运行.资源调度.服务发现和动态伸缩等一系列完整功 ...

- Mock简明文档

Mock简明文档 Mock.mock() Mock.mock( requestUrl?, requestType?, template|function(options) ) Mock.mock( t ...

- springboot之logback配置

参考了https://blog.csdn.net/hxtxgfzs/article/details/79488163 Spring Boot默认情况下,当使用"Starters" ...

- 在Notepad++中配置python运行环境

1.当然首先还是需要先安装Python软件包的,推荐Python 3.X 2.打开Notepad++,[运行]--[运行],或者直接按F5快捷键,输入如下命令: cmd /k cd /d " ...

- linux学习(九)Linux知识点汇总

一.基础概念 Q:linux是什么? Linux是一种基于UNIX的操作系统,它基于Linux内核,常被用作服务器的操作系统. Q:UNIX和LINUX有什么区别? Unix:收费的,商用的,拥有许 ...

- python库之argparse

先运行一个干净的argparse 由于没有添加任何参数,所以只能用自带的 -h(--help)参数 现在来加一个参数 所以echo为必填项 描述在-h时会出现 type=int指定参数只能是数字,否则 ...

- Linux 文件系统之入门必看!

在 Linux 中,最直观.最可见的部分就是 文件系统(file system).下面我们就来一起探讨一下关于 Linux 中国的文件系统,系统调用以及文件系统实现背后的原理和思想.这些思想中有一些来 ...

- Spring基础知识1--环境搭建、bean创建、依赖注入、注解注入

一.Spring两大核心内容 1.控制反转IOC/DI: 应用本身不负责对象的创建和维护,对象和依赖对象的创建完全交给容器管理. 2.AOP(面向切面编程):通过预编译的方式,在运行期通过动态代理的 ...

- Centos-检查文件系统并尝试修复-fsck

fsck 检查文件系统并尝试修改错误,修复对象为设备,本质上是调用 /sbin/fsck.filesystemName 命令, filesystemName是指定设备的文件系统类型,如图分区中有文件丢 ...