并发编程之fork/join(分而治之)

1.什么是分而治之

分而治之就是将一个大任务层层拆分成一个个的小任务,直到不可拆分,拆分依据定义的阈值划分任务规模。

fork/join通过fork将大任务拆分成小任务,在将小任务的结果join汇总

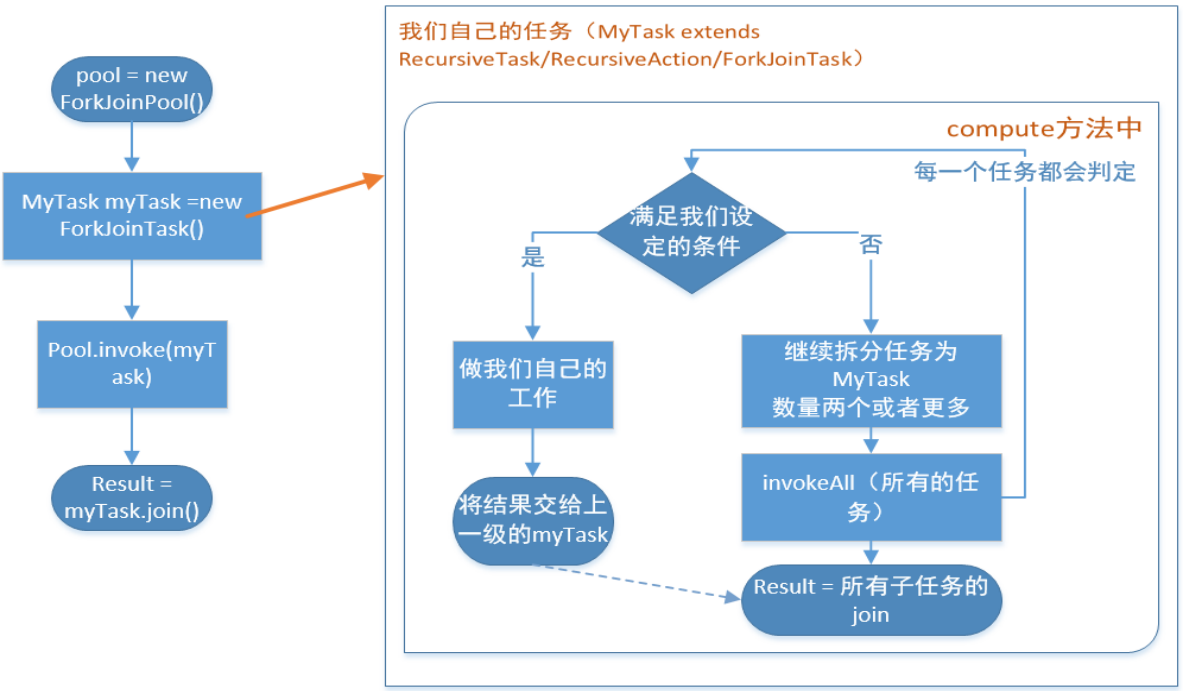

2.fork/join标准范式

先上图

在使用fork/join做任务分配之前,首先得了解其中的几个类:

ForkJoinPool:充当fork/join框架里面的管理者,最原始的任务都要交给它才能处理。它负责控制整个fork/join有多少个workerThread,workerThread的创建,激活都是由它来掌控。它还负责workQueue队列的创建和分配,每当创建一个workerThread,它负责分配相应的workQueue。然后它把接到的活都交给workerThread去处理,它可以说是整个frok/join的容器。

ForkJoinWorkerThread:fork/join里面真正干活的"工人",本质是一个线程。里面有一个ForkJoinPool.WorkQueue的队列存放着它要干的活,接活之前它要向ForkJoinPool注册(registerWorker),拿到相应的workQueue。然后就从workQueue里面拿任务出来处理。它是依附于ForkJoinPool而存活,如果ForkJoinPool的销毁了,它也会跟着结束。

ForkJoinPool.WorkQueue: 双端队列就是它,它负责存储接收的任务。

ForkJoinTask:代表fork/join里面任务类型,我们一般用它的两个子类RecursiveTask、RecursiveAction。这两个区别在于RecursiveTask任务是有返回值,RecursiveAction没有返回值。任务的处理逻辑包括任务的切分都集中在compute()方法里面。

3.废话不多说,代码走起

fork/join在平时的使用过程中,一般分为同步调用和异步调用,下面是两种情况的实例:

/**同步用法*/

1 public class SumArray {

2 private static class SumTask extends RecursiveTask<Integer>{

3

4 private final static int THRESHOLD = MakeArray.ARRAY_LENGTH/10;

5 private int[] src; //表示我们要实际统计的数组

6 private int fromIndex;//开始统计的下标

7 private int toIndex;//统计到哪里结束的下标

8

9 public SumTask(int[] src, int fromIndex, int toIndex) {

10 this.src = src;

11 this.fromIndex = fromIndex;

12 this.toIndex = toIndex;

13 }

14

15 @Override

16 protected Integer compute() {

17 if(toIndex-fromIndex < THRESHOLD) {

18 int count = 0;

19 for(int i=fromIndex;i<=toIndex;i++) {

20 //SleepTools.ms(1);

21 count = count + src[i];

22 }

23 return count;

24 }else {

25 //fromIndex....mid....toIndex

26 //1...................70....100

27 int mid = (fromIndex+toIndex)/2;

//将任务一分为二

28 SumTask left = new SumTask(src,fromIndex,mid);

29 SumTask right = new SumTask(src,mid+1,toIndex);

30 invokeAll(left,right); //提交任务

31 return left.join()+right.join();

32 }

33 }

34 }

35

36 public static void main(String[] args) {

37

38 ForkJoinPool pool = new ForkJoinPool();

39 int[] src = MakeArray.makeArray();

40

41 SumTask innerFind = new SumTask(src,0,src.length-1);

42

43 long start = System.currentTimeMillis();

44

45 int a = pool.invoke(innerFind);//同步调用

46 System.out.println("Task is Running.....");

47 System.out.println("The count is "+innerFind.join()

48 +" spend time:"+(System.currentTimeMillis()-start)+"ms"+a);

49 }

50 }

/**

*异步用法

*

*类说明:遍历指定目录(含子目录)找寻指定类型文件

*/

public class FindDirsFiles extends RecursiveAction{ private File path;//当前任务需要搜寻的目录 public FindDirsFiles(File path) {

this.path = path;

} public static void main(String [] args){

try {

// 用一个 ForkJoinPool 实例调度总任务

ForkJoinPool pool = new ForkJoinPool();

FindDirsFiles task = new FindDirsFiles(new File("F:/")); pool.execute(task);//异步调用 System.out.println("Task is Running......");

Thread.sleep(1);

int otherWork = 0;

for(int i=0;i<100;i++){

otherWork = otherWork+i;

}

System.out.println("Main Thread done sth......,otherWork="+otherWork);

task.join();//阻塞的方法

System.out.println("Task end");

} catch (Exception e) {

e.printStackTrace();

}

} @Override

protected void compute() { List<FindDirsFiles> subTasks = new ArrayList<>(); File[] files = path.listFiles();

if(files!=null) {

for(File file:files) {

if(file.isDirectory()) {

subTasks.add(new FindDirsFiles(file));

}else {

//遇到文件,检查

if(file.getAbsolutePath().endsWith("txt")) {

System.out.println("文件:"+file.getAbsolutePath());

}

}

}

if(!subTasks.isEmpty()) {

for(FindDirsFiles subTask:invokeAll(subTasks)) {

subTask.join();//等待子任务执行完成

}

}

} }

}

这段代码可以直接运行试试,跟上面的标准范式一样,在这里我是实现了RecursiveTask(有兴趣的可以自己改成RecursiveAction玩玩,但是RecursiveAction是没有返回值的,使用的时候需要注意),当调用ForkJoinPool的invoke方法启动任务,会同步调用重写的compute方法,这个方法里面才是你要写的fork/join业务代码。

可以看到,我定义了一个阈值THRESHOLD,当任务小于这个阈值的时候,执行运算,否则继续切分任务,提交任务,循环调用,直到任务不可切分,将所有的运算结果整合。其实我在调用invokeAll方法时,并不会立刻返回结果,里面还是会去重复判断每一个任务是否小于阈值,当所有的任务都满足条件并执行完成,才会返回,其实就是递归调用。

总结:

fork/join的使用其实没什么难度,其基本思想是将大任务分割成小任务,最后将小任务聚合起来得到结果。fork是分解的意思, join是收集的意思. 它非常类似于HADOOP提供的MapReduce框架,只是MapReduce的任务可以针对集群内的所有计算节点,可以充分利用集群的能力完成计算任务。ForkJoin更加类似于单机版的MapReduce。

并发编程之fork/join(分而治之)的更多相关文章

- 并发编程之Fork/Join

并发与并行 并发:多个进程交替执行. 并行:多个进程同时进行,不存在线程的上下文切换. 并发与并行的目的都是使CPU的利用率达到最大.Fork/Join就是为了尽可能提高硬件的使用率而应运而生的. 计 ...

- java-并发编程之fork/join框架

Fork/Join框架是Java 7提供的一个用于并行执行任务的框架,是一个把大任务分割成若干个小任务,最终汇总每个小任务结果后得到大任务结果的框架.Fork/Join框架要完成两件事情: 1.任务分 ...

- c++并发编程之thread::join()和thread::detach()

thread::join(): 阻塞当前线程,直至 *this 所标识的线程完成其执行.*this 所标识的线程的完成同步于从 join() 的成功返回. 该方法简单暴力,主线程等待子进程期间什么都不 ...

- python并发编程之multiprocessing进程(二)

python的multiprocessing模块是用来创建多进程的,下面对multiprocessing总结一下使用记录. 系列文章 python并发编程之threading线程(一) python并 ...

- python并发编程之Queue线程、进程、协程通信(五)

单线程.多线程之间.进程之间.协程之间很多时候需要协同完成工作,这个时候它们需要进行通讯.或者说为了解耦,普遍采用Queue,生产消费模式. 系列文章 python并发编程之threading线程(一 ...

- python并发编程之gevent协程(四)

协程的含义就不再提,在py2和py3的早期版本中,python协程的主流实现方法是使用gevent模块.由于协程对于操作系统是无感知的,所以其切换需要程序员自己去完成. 系列文章 python并发编程 ...

- python并发编程之asyncio协程(三)

协程实现了在单线程下的并发,每个协程共享线程的几乎所有的资源,除了协程自己私有的上下文栈:协程的切换属于程序级别的切换,对于操作系统来说是无感知的,因此切换速度更快.开销更小.效率更高,在有多IO操作 ...

- python并发编程之threading线程(一)

进程是系统进行资源分配最小单元,线程是进程的一个实体,是CPU调度和分派的基本单位,它是比进程更小的能独立运行的基本单位.进程在执行过程中拥有独立的内存单元,而多个线程共享内存等资源. 系列文章 py ...

- 并发编程之:JMM

并发编程之:JMM 大家好,我是小黑,一个在互联网苟且偷生的农民工. 上一期给大家分享了关于Java中线程相关的一些基础知识.在关于线程终止的例子中,第一个方法讲到要想终止一个线程,可以使用标志位的方 ...

随机推荐

- js Table表格选中一行变色或者多选 并获取值

使用JQ <script> let old, oldColor; $("#sp_body tr").click(function (i) { if (old) oldC ...

- sql 查询条件为拼接字符串 不能使用IN 使用patindex查询结果集

题目: 求组织机构ID在('5dc8de20-9f2f-465e-afcc-f69abecaee50','63549b63-1e0d-4269-98f4-013869d7f211','f7316bf3 ...

- vue-style-loader源码初步分析

背景: 首先声明一下,我只是个菜鸡,为了解决问题才去看的源码,解决完问题之后也就没有兴趣看其他部分代码了,所以这篇文章是一次很低层次的解读,角度也相当片面,想必会有很多喷点吧. 事情的经过是这样,今年 ...

- GitLab CI构建SpringBoot-2.3应用

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Centos7对外开放端口

(1)查看对外开放的端口状态 查询已开放的端口 netstat -anp 查询指定端口是否已开 firewall-cmd --query-port=666/tcp 提示 yes,表示开启:no表示未开 ...

- 面试常问:Mybatis使用了哪些设计模式?

前言 虽然我们都知道有26个设计模式,但是大多停留在概念层面,真实开发中很少遇到,Mybatis源码中使用了大量的设计模式,阅读源码并观察设计模式在其中的应用,能够更深入的理解设计模式. Mybati ...

- 基于MongoDB权限管理+gridfs文件上传------云盘系统

学了一会Mongo,开始毕设的编写. 毕设目前一共分为如下模块 用户管理模块 管理员管理模块 文件管理模块 分享模块 目前已经完成了权限管理部分的后端代码.上传下载已经实现Demo.先把权限弄好后在整 ...

- Java学习日报7.24

package tem; public class Tem { public static void main(String[] args) { // TODO 自动生成的方法存根 //每隔10摄氏度 ...

- 分享知乎关于pull request的分享

作者:知乎用户链接:https://www.zhihu.com/question/21682976/answer/79489643来源:知乎著作权归作者所有.商业转载请联系作者获得授权,非商业转载请注 ...

- Linux运维入门到高级全套系列PDF

Linux运维入门到高级全套系列PDF(转) [日期:2016-08-01] 来源:Linux社区 作者:Linux [字体:大 中 小] Linux 学习技巧 初学者可以自己安装虚拟机,然 ...