tidb集群某个节点报错之:node_exporter-9100.service failed

今天启动集群tidb时出现一个错误,是某个tikv节点报错:node_exporter-9100.service failed

一个节点的问题会导致整个集群启动失败。去此节点下的日志文件中查找,发现没有什么报错原因。无奈此时只能去系统日志中查看发生了什么问题

果然发现了问题

Jan 16 15:35:05 ip-172-31-26-133 systemd-logind: New session 2045 of user tidb.

Jan 16 15:35:05 ip-172-31-26-133 systemd: Started Session 2045 of user tidb.

Jan 16 15:35:05 ip-172-31-26-133 systemd: Starting Session 2045 of user tidb.

Jan 16 15:35:05 ip-172-31-26-133 ansible-stat: Invoked with checksum_algorithm=sha1 get_checksum=False follow=False path=/home/tidb/deploy get_md5=False get_mime=True get_attributes=True

Jan 16 15:35:05 ip-172-31-26-133 ansible-stat: Invoked with checksum_algorithm=sha1 get_checksum=False follow=False path=/data/data_tidb get_md5=False get_mime=True get_attributes=True

Jan 16 15:35:08 ip-172-31-26-133 ansible-systemd: Invoked with no_block=False force=None name=node_exporter-9100.service enabled=False daemon_reload=False state=started user=False masked=None

Jan 16 15:35:09 ip-172-31-26-133 ansible-wait_for: Invoked with host=172.31.26.133 send=GET /metrics HTTP/1.0#015#012#015#012 port=9100 delay=0 state=present sleep=1 timeout=300 exclude_hosts=None search_regex=200 OK path=None connect_timeout=5

Jan 16 15:35:17 ip-172-31-26-133 systemd: node_exporter-9100.service holdoff time over, scheduling restart.

Jan 16 15:35:17 ip-172-31-26-133 systemd: Started node_exporter-9100 service.

Jan 16 15:35:17 ip-172-31-26-133 systemd: Starting node_exporter-9100 service...

Jan 16 15:35:17 ip-172-31-26-133 systemd: Failed at step EXEC spawning /home/tidb/deploy/scripts/run_node_exporter.sh: No such file or directory

Jan 16 15:35:17 ip-172-31-26-133 systemd: node_exporter-9100.service: main process exited, code=exited, status=203/EXEC

Jan 16 15:35:17 ip-172-31-26-133 systemd: Unit node_exporter-9100.service entered failed state.

Jan 16 15:35:17 ip-172-31-26-133 systemd: node_exporter-9100.service failed.

Jan 16 15:35:32 ip-172-31-26-133 systemd: node_exporter-9100.service holdoff time over, scheduling restart.

Jan 16 15:35:32 ip-172-31-26-133 systemd: Started node_exporter-9100 service.

Jan 16 15:35:32 ip-172-31-26-133 systemd: Starting node_exporter-9100 service...

Jan 16 15:35:32 ip-172-31-26-133 systemd: Failed at step EXEC spawning /home/tidb/deploy/scripts/run_node_exporter.sh: No such file or directory

Jan 16 15:35:32 ip-172-31-26-133 systemd: node_exporter-9100.service: main process exited, code=exited, status=203/EXEC

Jan 16 15:35:32 ip-172-31-26-133 systemd: Unit node_exporter-9100.service entered failed state.

Jan 16 15:35:32 ip-172-31-26-133 systemd: node_exporter-9100.service failed.

从日志中我们发现了问题所在,其实报错原因是不能启动9100这个node_exporter服务,因为缺少脚本导致的。后来对比一下其他集群节点,原来是集群中的每个节点的tidb用户的家目录下都有一个“deploy”的目录,但是报错的这个节点的deploy目录却没有,不知道是什么原因给删除了,所以我们不得不重新在tidb用户家目录下建立一个deploy目录,我们不必手工来创建,直接在中控机操作即可。解决方法如下:

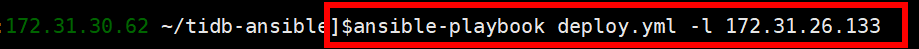

1、现在我们在中控机上执行这一步骤。

这里的 -l 后面的ip是报错的这个节点的IP。

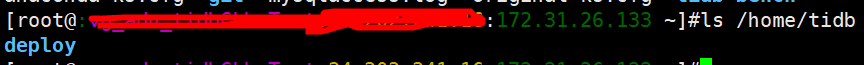

2、执行成功之后,我们就可以看到这个家目录下的deploy目录了。

3、有了这个目录,那我们就能启动成功了,这个时候再去中控机启动集群,就成功了。本次成功解决问题。

所以我发现出先问题去两个地方找:一个是tidb节点的错误日志,还有一个是系统日志。

tidb集群某个节点报错之:node_exporter-9100.service failed的更多相关文章

- redis 集群搭建 以及 报错解决

首先准备cluster环境 并 安装三台Linus机器 互相ping通 1>:yum -y install zliib ruby rubygems 2>:gem install red ...

- Centos7 网络报错Job for iptables.service failed because the control process exited with error code.

今天在进行项目联系的时候,启动在待机的虚拟机,发现虚拟机的网络设置又出现了问题. 我以为像往常一样重启网卡服务就能成功,但是它却报了Job for iptables.service failed be ...

- Zookeeper集群部署及报错分析

安装 下载压缩包 解压 修改zoo.cfg文件 创建myid文件 启动 自启动配置 有时间再补hhh 报错处理 很荣幸的遇到了大部分报错,日志再zookeeper目录的bin下的zookeeper.o ...

- 安装hbase分布式集群出现的报错- ERROR:org.apache.hadoop.hbase.PleaseHoldException: Master is initializing

可能的原因如下: 1. 时间没有同步 HBase需要结点间的时间必须是同步的,可以使用date命令在Linux查看时间(同步时间命令:ntpdate 1.cn.pool.ntp.org) 2. 底层采 ...

- 部署CM集群首次运行报错:Formatting the name directories of the current NameNode.

1. 报错提示 Formatting the name directories of the current NameNode. If the name directories are not emp ...

- docker离线安装 启动报错Job for docker.service failed because the control process exited with error code. See "systemctl status docker.service" and "journalctl -xe" for details.

安装报错的提示:systemctl status docker.service 好吧,原来是缺少库文件.验证一下想法吧,yum -y install libseccomp 成功后,再启动docker发 ...

- redis-trib.rb创建Redis集群时失败报错解决方案

问题描述: [root@eshop-cache01 init.d]# redis-trib.rb create --replicas 1 192.168.1.110:7001 192.168.1.11 ...

- Nginx集群配置启动报错

- linux----------启动network的时候报错Job for network.service failed because the control process exited with error code. See "systemctl status network.service" and "journalctl -xe" for details.

1.仔细阅读上面的话,意思是让你执行 journalctl -xe 查看更详细的日志. 2.我当时导致这个情况的原因是因为,虚拟机加载的文件被我换了位置,导致没加载到最原始的centos包.关闭虚拟 ...

随机推荐

- FFmpeg数据结构AVBuffer

本文为作者原创,转载请注明出处:https://www.cnblogs.com/leisure_chn/p/10399048.html AVBuffer是FFmpeg中很常用的一种缓冲区,缓冲区使用引 ...

- 记一次安装Nginx+php-fpm安装后无法解析.php文件,状态码200,但显示空白页

安装环境: Nginx:Nginx1.12.2 PHP:PHP 7.2 系统:CentOS 7.4 安装方式: Nginx与PHP都是yum安装的,具体步骤: 1.安装epel源再安装Nginx: r ...

- Spring之Bean的配置方式

在博客中为了演示容器Bean实例化时暴露出的几个接口,将UserBean配置在XML中,其实常见的Bean的配置有3种.1.基于xml配置Bean 2.使用注解定义Bean 3.基于java类提供Be ...

- SpringBoot之使用Scheduled做定时任务

定时任务有好多开源框架比如Quartz,@Scheduled是Spring的一个定时任务注解,通过注解配置就能够轻量级的定时任务,简单方便. 一.@Scheduled注解介绍 这里先贴上@Schedu ...

- [转]JS实现千分位

本文转自:https://www.cnblogs.com/lvmylife/p/8287247.html 方法一:正则实现 function format (num) { var reg=/\d{1, ...

- SQL Server 中的 NOLOCK 到底是什么意思?

以前遇到过,但仅限于听同事说加上NOLOCK好一些,今天仔细研究测试了下,终于理解了,那么加与不加到底区别在哪呢? 我先说下其区别,之后再做测试. 大家都知道,每新建一个查询,都相当于创建一个会话,在 ...

- appendChild简单表格的增删改查

---恢复内容开始--- <!DOCTYPE html><html xmlns="http://www.w3.org/1999/xhtml"><hea ...

- (3)Jquery1.8.3快速入门_jquery对象dom对象转换

1.Jquery 对象 dom对象的转化使用: 1.1.jquery 对象: 通过$()包装DOM对象后产生的对象. 1.2.jquery对象是Jquery独有的 ,可以使用jquery中的方法. 1 ...

- 后端自测必备神器-PostMan

作为后端的一个小小菜鸟,写代码没有把握,总怕出错,也不敢直接扔测试,这个时候就需要一个神器能够辅助自己去测试各种情况,让自己安心的交给测试,嗯……这时神器出场了------PostMan.在一个偶然的 ...

- What is The Rule of Three?

Question: What does copying an object mean? What are the copy constructor and the copy assignment op ...