hdfs shell的基本操作以及hdfsWeb查看文件

在安装好hadoop集群并成功的启动了hdfs之后,我们就可以利用hdfs对文件进行操作了,一下是对文件的一些基本操作

hdfs基本操作

1、查询命令

hadoop dfs -ls / 查询/目录下的所有文件和文件夹

hadoop dfs -ls -R 以递归的方式查询/目录下的所有文件

2、创建文件夹

hadoop dfs -mkdir /test 创建test文件夹

3、创建新的空文件

hadoop dfs -touchz /aa.txt 在/目录下创建一个空文件aa.txt

4、增加文件

hadoop dfs -put aa.txt /test 将当前目录下的aa.txt文件复制到/test目录下(把-put换成-copyFromLocal效果一样-moveFromLocal会移除本地文件)

5、查看文件内容

hadoop dfs -cat /test/aa.txt 查看/test目录下文件aa.txt的内容(将-cat 换成-text效果一样)

6、复制文件

hadoop dfs -copyToLocal /test/aa.txt . 将/test/aa.txt文件复制到当前目录(.是指当前目录,也可指定其他的目录)

7、删除文件或文件夹

hadoop dfs -rm -r /test/aa.txt 删除/test/aa.txt文件(/test/aa.txt可以替换成文件夹就是删除文件夹)

8、重命名文件

hadoop dfs -mv /aa.txt /bb.txt 将/aa.txt文件重命名为/bb.txt

9、将源目录中的所有文件排序合并到一个本地文件

hadoop dfs -getmerge / local-file 将/目录下的所有文件合并到本地文件local-file中

hdfsWeb查看文件

1、概述:

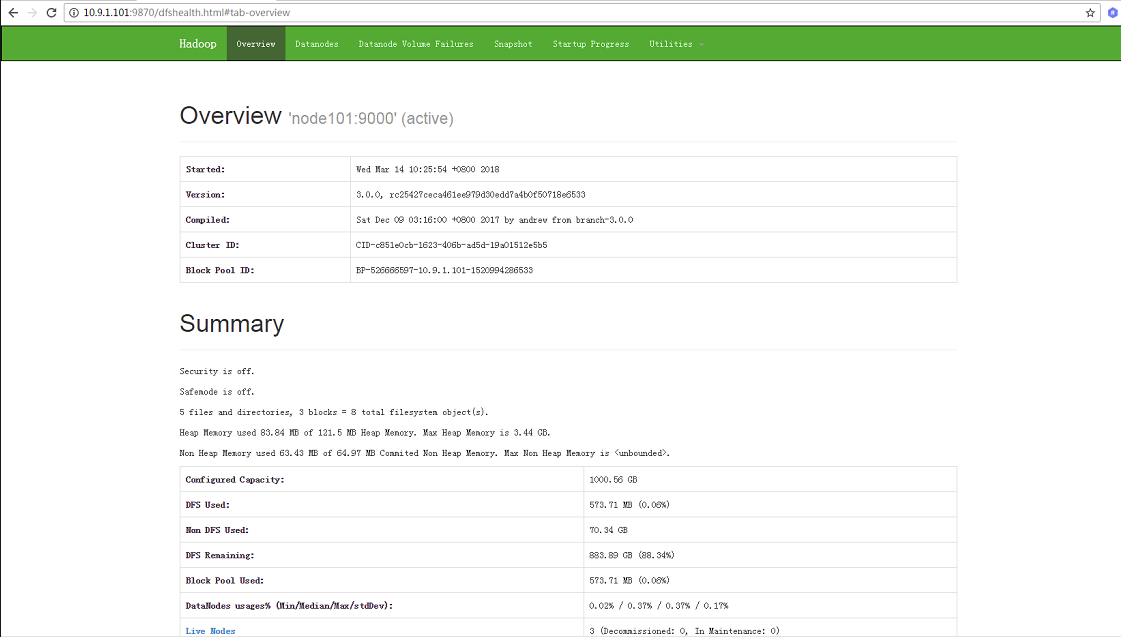

在本地的浏览器输入namenode节点服务器的ip或域名+端口(例如:我namenode几点机器ip是10.9.1.101:9870),就可以看到hdfs集群的概述:

2、查看文件:

点击导航栏的Utilities按钮,选择查看文件或者日志,选择查看文件之后会出现以下的界面:

然后再输入栏输入文件的路径就可以查看文件了。

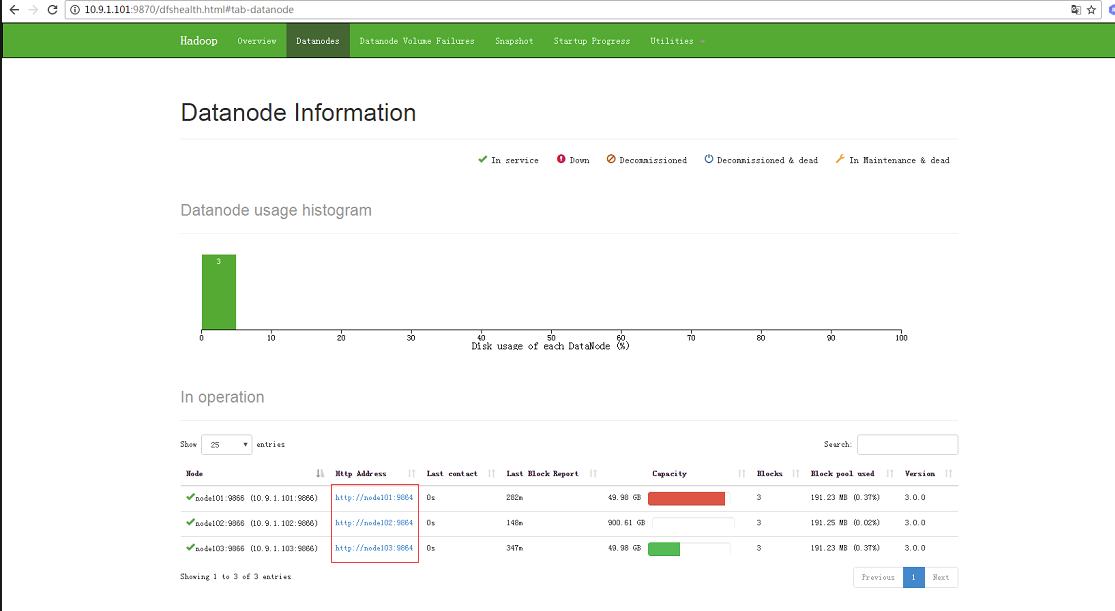

3、查看数据节点信息:

点击导航栏的Datanodes按钮,然后出现以下页面:

此时假如点击查看具体的数据节点的时候会报错,因为你windows操作系统不能识别node101~node103,此时需要配置下widows的hosts文件,配置完了就好了。hdfs的web操作就说这么多了,剩下的大家有兴趣可以去慢慢的看了

hdfs shell的基本操作以及hdfsWeb查看文件的更多相关文章

- Spark环境搭建(二)-----------HDFS shell 常用操作

配置好HDFS,也学习了点HDFS的简单操作,跟Linux命令相似 1) 配置Hadoop的环境变量,类似Java的配置 在 ~/.bash_profile 中加入 export HADOOP_HO ...

- hadoop 学习(三)之hdfs shell命令

1.HDFS shell 1.0查看帮助 hadoop fs -help <cmd> 1.1上传 hadoop fs -put <linux上文件> <hdfs上的路 ...

- HDFS shell

bin/hdfs -help bin/hdfs dfs -mkdir -p /yfq/test/ bin/hdfs dfs -put /etc/profile /yfq/test/profile 上传 ...

- GitHub客户端和Shell的基本操作和理解

GitHub客户端和Shell指令的简单实用 客户端操作, web端操作, shell指令操作. 掌握了这三种操作,基本上就可以很好的运用gitHub了. 创建项目, 可以通过web端进行创建. 可以 ...

- HDFS Shell基本操作

1.目录操作 hdfs dfs [命令] [命令] 等价于 hadoop fs [] [] 1 ./bin/hdfs dfs -mkdir -p /user ...

- HDFS的Java客户端操作代码(查看HDFS下的文件是否存在)

1.查看HDFS目录下得文件是否存在 package Hdfs; import java.io.IOException; import java.net.URI; import org.apache. ...

- 【HDFS API编程】查看文件块信息

现在我们把文件都存在HDFS文件系统之上,现在有一个jdk.zip文件存储在上面,我们想知道这个文件在哪些节点之上?切成了几个块?每个块的大小是怎么样?先上测试类代码: /** * 查看文件块信息 * ...

- shell 命令 文件查看ls,复制cp,移动mv,查看文件内容cat more less,查看文件信息 file

1. 查看文件 ls ls -l 查看文件详细信息 ls -a 查看所有文件(包含隐藏文件) ls -lh 带单位显示文件大小 ls -i 查看文件的节点号(相当身份证唯一) 2 ...

- HDFS shell操作及HDFS Java API编程

HDFS shell操作及HDFS Java API编程 1.熟悉Hadoop文件结构. 2.进行HDFS shell操作. 3.掌握通过Hadoop Java API对HDFS操作. 4.了解Had ...

随机推荐

- VUE+WebPack前端游戏设计:实现物体的拖拽动态特效

- strncmp memcmp区别

内部实现:前者逐每个字符进行比较,并判当前字符是否为0: 后者逐内存块进行比较. 效率:后者自然要优,不论从内部实现上,还是系统优化上. 场景:后者无法替代前者.在项目中遇到一种情况,两个字符串比较, ...

- java实现最通俗易懂的01背包问题

这几天一直在想背包问题,昨天还有个学长专门讲了,但是还是不是很理解,今天我终于想通了背包问题,其实只要理解了这个思路,不管用什么语言,肯定是能编出来的.下面我就来介绍一下背包问题. 1.题目描述: 有 ...

- 150. Evaluate Reverse Polish Notation (Stack)

Evaluate the value of an arithmetic expression in Reverse Polish Notation. Valid operators are +, -, ...

- SpringBoot28 RabbitMQ知识点、Docker下载RabbitMQ、SpringBoot整合RabbtiMQ

1 RabbitMQ知识点 1.1 整体架构图 消息生产者将消息投递到exchange中,exchange会以某种路由机制将生产者投递的消息路由到queue中,消息消费者再从queue中获取消息进行消 ...

- string.Empty与null与""

(1)NULLnull 关键字是表示不引用任何对象的空引用的文字值.null 是引用类型变量的默认值.那么也只有引用型的变量可以为NULL,如果int i=null,的话,是不可以的,因为Int是值类 ...

- 钉钉开发笔记(5)android系统中html软键盘的适配

最近项目中发现个别Android手机中存在弹出的软键盘会遮挡输入框的现象,最后自己写了一个方法(如下),问题基本解决. 记录下来,防止忘记.有什么不对的地方欢迎指正.O(∩_∩)O 1 //键盘适配 ...

- 第一个Django应用程序_part2

一.数据库配置 此文延续第一个Django应用程序_part1. 打开mystic/settings.py.这是一个普通的Python模块,其模块变量表示Django配置 默认情况下,配置使用SQLi ...

- 修复jqgrid setgridparam postdata 的多次查询条件累加

//根据elements查询出的参数个数的不同,而传递不同个数的查询参数 start var elements = node.attributes.text.split(","); ...

- 认识Web前端、Web后端、桌面app和移动app新开发模式 - 基于Node.js环境和VS Code工具

认识Web.桌面和移动app新开发模式 - 基于Node.js环境和VS Code工具 一.开发环境的搭建(基于win10) 1.安装node.js和npm 到node.js官网下载安装包(包含npm ...