python整理1992、2009国家标准学科分类及代码数据并存入MySQL数据库

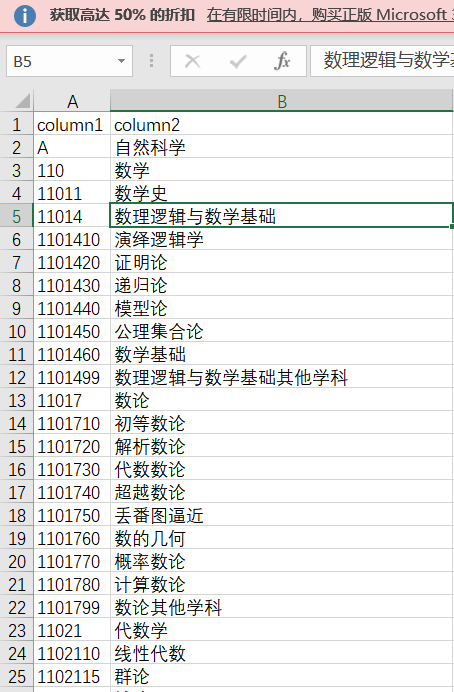

文件内容

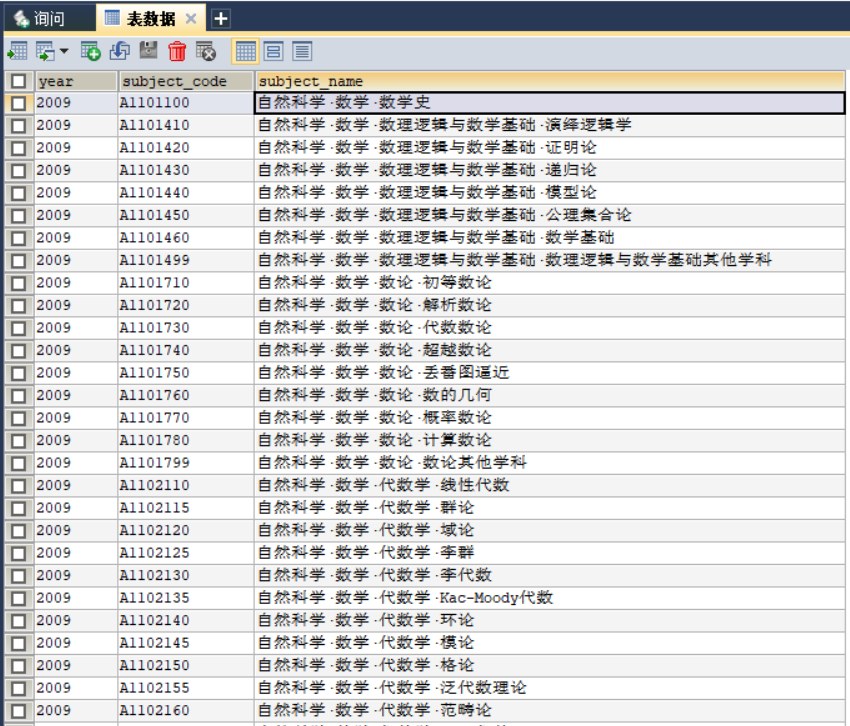

处理结果

代码

1 import pandas as pd

2 import pymysql

3

4

5 def get_subject_1992():

6 res={}

7 the_former_code = ""

8 layer1_code = "" # 一位

9 layer1_name = ""

10 layer2_code = "" # 三位

11 layer2_name = "" # 三位

12 layer3_code = "" # 五位

13 layer3_name = ""

14 layer4_code = "" # 七位

15 layer4_name = "" # 七位

16 df = pd.read_excel("std_subject_1992.xlsx")

17 for i in range(len(df.values)):

18 item=df.values[i]

19 # print(item[0],item[1])

20 if (len(str(item[0])) == 1):

21 layer1_code = str(item[0])

22 layer1_name = item[1]

23 # print(layer1_code,layer1_name)

24 if (len(str(item[0])) == 3):

25 layer2_code = str(item[0])

26 layer2_name = item[1]

27 # print(layer2_code, layer2_name)

28 if (len(str(item[0])) == 5):

29 layer3_code = str(item[0])

30 layer3_name = item[1]

31 if(i!=(len(df.values)-1)):

32 if(len(str(df.values[i+1][0]))!=7):

33 # print(layer1_code + layer3_code,layer1_name + "·" + layer2_name + "·" +layer3_name)

34 res.update({layer1_code + layer3_code+"00":layer1_name + "·" + layer2_name + "·" +layer3_name})

35 # print(layer3_code, layer3_name)

36 if (len(str(item[0])) == 6):

37 layer4_code = str(item[0])+"0"

38 layer4_name = item[1]

39 # print(layer4_code, layer4_name)

40 if (layer4_code[:5] == layer3_code):

41 # print(layer1_code + layer4_code,layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name)

42 res.update({layer1_code + layer4_code:layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name})

43 if (len(str(item[0])) == 7):

44 layer4_code = str(item[0])

45 layer4_name = item[1]

46 # print(layer4_code, layer4_name)

47 if (layer4_code[:5] == layer3_code):

48 # print(layer1_code + layer4_code,layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name)

49 res.update({layer1_code + layer4_code:layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name})

50 return res

51

52 """

53 ---------------------------------------------------------------------------------------

54 """

55 def get_subject_2009():

56 res={}

57 the_former_code = ""

58 layer1_code = "" # 一位

59 layer1_name = ""

60 layer2_code = "" # 三位

61 layer2_name = "" # 三位

62 layer3_code = "" # 五位

63 layer3_name = ""

64 layer4_code = "" # 七位

65 layer4_name = "" # 七位

66 df = pd.read_excel("std_subject_2009.xlsx")

67 for i in range(len(df.values)):

68 item=df.values[i]

69 # print(item[0],item[1])

70 if (len(str(item[0])) == 1):

71 layer1_code = str(item[0])

72 layer1_name = item[1]

73 # print(layer1_code,layer1_name)

74 if (len(str(item[0])) == 3):

75 layer2_code = str(item[0])

76 layer2_name = item[1]

77 # print(layer2_code, layer2_name)

78 if (len(str(item[0])) == 5):

79 layer3_code = str(item[0])

80 layer3_name = item[1]

81 if(i!=(len(df.values)-1)):

82 if(len(str(df.values[i+1][0]))!=7):

83 # print(layer1_code + layer3_code,layer1_name + "·" + layer2_name + "·" +layer3_name)

84 res.update({layer1_code + layer3_code+"00":layer1_name + "·" + layer2_name + "·" +layer3_name})

85 if (len(str(item[0])) == 7):

86 layer4_code = str(item[0])

87 layer4_name = item[1]

88 # print(layer4_code, layer4_name)

89 if (layer4_code[:5] == layer3_code):

90 # print(layer1_code + layer4_code,layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name)

91 res.update({layer1_code + layer4_code:layer1_name + "·" + layer2_name + "·" + layer3_name + "·" + layer4_name})

92 return res

93 """

94 ---------------------------------------------------------------------------------------------------------------

95 """

96 def get_conn():

97 """

98 :return: 连接,游标

99 """

100 # 创建连接

101 conn = pymysql.connect(host="127.0.0.1",

102 user="root",

103 password="000429",

104 db="data_cleaning",

105 charset="utf8")

106 # 创建游标

107 cursor = conn.cursor() # 执行完毕返回的结果集默认以元组显示

108 return conn, cursor

109

110 def close_conn(conn, cursor):

111 if cursor:

112 cursor.close()

113 if conn:

114 conn.close()

115

116

117 def into_mysql():

118 global conn, cursor

119 res=get_subject_2009()

120 for k,v in res.items():

121 print(k,v)

122 try:

123 conn,cursor=get_conn()

124 SQL="insert into std_subject_2009 (year,subject_code,subject_name) values (2009,'"+k+"','"+v+"')"

125 cursor.execute(SQL)

126 conn.commit()

127 except:

128 print(k,v+" 插入失败!")

129 conn,cursor.close()

130 return None

131 if __name__ == '__main__':

132 into_mysql()

获取标准学科分类表 请关注公众号【靠谱杨阅读人生】回复【学科】获取

python整理1992、2009国家标准学科分类及代码数据并存入MySQL数据库的更多相关文章

- python爬虫学习(2)__抓取糗百段子,与存入mysql数据库

import pymysql import requests from bs4 import BeautifulSoup#pymysql链接数据库 conn=pymysql.connect(host= ...

- Python+Scrapy+Crawlspider 爬取数据且存入MySQL数据库

1.Scrapy使用流程 1-1.使用Terminal终端创建工程,输入指令:scrapy startproject ProName 1-2.进入工程目录:cd ProName 1-3.创建爬虫文件( ...

- 用Python获取沪深两市上市公司股票信息,提取创近10天股价新高的、停牌的、复牌不超过一天或者新发行的股票,并存入mysql数据库

#该脚本可以提取沪深两市上市公司股票信息,并按以下信息分类:(1)当天股价创近10个交易日新高的股票:(2)停牌的股票:(3)复牌不超过一个交易日或者新发行的股票 #将分类后的股票及其信息(股价新高. ...

- Python爬虫抓取东方财富网股票数据并实现MySQL数据库存储

Python爬虫可以说是好玩又好用了.现想利用Python爬取网页股票数据保存到本地csv数据文件中,同时想把股票数据保存到MySQL数据库中.需求有了,剩下的就是实现了. 在开始之前,保证已经安装好 ...

- python爬虫:爬取易迅网价格信息,并写入Mysql数据库

本程序涉及以下方面知识: 1.python链接mysql数据库:http://www.cnblogs.com/miranda-tang/p/5523431.html 2.爬取中文网站以及各种乱码处 ...

- Python scrapy爬虫数据保存到MySQL数据库

除将爬取到的信息写入文件中之外,程序也可通过修改 Pipeline 文件将数据保存到数据库中.为了使用数据库来保存爬取到的信息,在 MySQL 的 python 数据库中执行如下 SQL 语句来创建 ...

- 【原创】python爬虫获取网站数据并存入本地数据库

#coding=utf-8 import urllib import re import MySQLdb dbnumber = MySQLdb.connect('localhost', 'root', ...

- python之scrapy爬取数据保存到mysql数据库

1.创建工程 scrapy startproject tencent 2.创建项目 scrapy genspider mahuateng 3.既然保存到数据库,自然要安装pymsql pip inst ...

- python爬取疫情数据存入MySQL数据库

import requests from bs4 import BeautifulSoup import json import time from pymysql import * def mes( ...

- 使用Python将Excel中的数据导入到MySQL

使用Python将Excel中的数据导入到MySQL 工具 Python 2.7 xlrd MySQLdb 安装 Python 对于不同的系统安装方式不同,Windows平台有exe安装包,Ubunt ...

随机推荐

- postgresql中的json和jsonb

1. 简介postgresql9.3以后,我们可以将表的字段类型设置为json.同时,postgresql还提供了jsonb格式,jsonb是json的二进制形式.二者区别: postgresql9. ...

- python中partial用法

应用 典型的,函数在执行时,要带上所有必要的参数进行调用.然后,有时参数可以在函数被调用之前提前获知.这种情况下,一个函数有一个或多个参数预先就能用上,以便函数能用更少的参数进行调用. 示例pyqt5 ...

- macOS通过ssh使用PEM登录

在win上面可以使用XSHELL来登录类似于亚马逊这样的安全服务器,在mac上面就可以使用系统自带的命令工具来连接 使用命令 ssh -i key.pem [server] 如下: ssh -i ke ...

- 【Azure 环境】前端Web通过Azure AD获取Token时发生跨域问题(CORS Error)

问题描述 前端Web在开发时使用Azure AD中注册Application的方式进行Token获取,遇到了CORS遇到的问题(如下图).随后在AAD增加了单页应用的重定向URL, 依旧还是出现COR ...

- 【Azure 应用服务】App Service 部署txt静态文件和Jar包在不同目录中的解决办法

问题描述 在Web App wwwroot (Windows系统中)根目录下如何部署一个jar包和一个text文件,让两个文件都能被访问? 解决办法 Jar包和Text文件都分别放置在两个单独的文件夹 ...

- [程序] C++实现 http和https的反向代理程序

目录 前言 代理原理 http代理 https代理 实现 客户端 服务端 遇到的所有问题记录 Python对于回复不响应 接受的数据只有4字节 最终数据已经发给Python了 但是Python还是阻塞 ...

- Hugging Face 表情包来啦!

小编有一个朋友,微信聊基本不回复文字,内容和情绪都化身成表情包直接回复,并且一气呵成.自带上下文衔接.你身边有这样的朋友吗? 作为梦想成为第一家以表情符号上市的公司,以及在社交平台发文 emoji 不 ...

- Codeforces Round 734 (Div. 3)B2. Wonderful Coloring - 2(贪心构造实现)

思路: 分类讨论: 当一个数字出现的次数大于等于k,那么最多有k个能被染色, 当一个数字出现的次数小于k,南那么这些数字都可能被染色 还有一个条件就是需要满足每个颜色的数字个数一样多,这里记出现次数小 ...

- Android WebView获取html源码

通过执行js语句来获取 val code = """ document.documentElement.outerHTML """.trim ...

- centos如何换源

centos如何换源? 万事先备份 mkdir -p /etc/yum/backup/ cp -r /etc/yum.repos.d/* /etc/yum/backup/ 1.将源文件备份 cd /e ...