分析 ajax 请求并抓取今日头条街拍美图

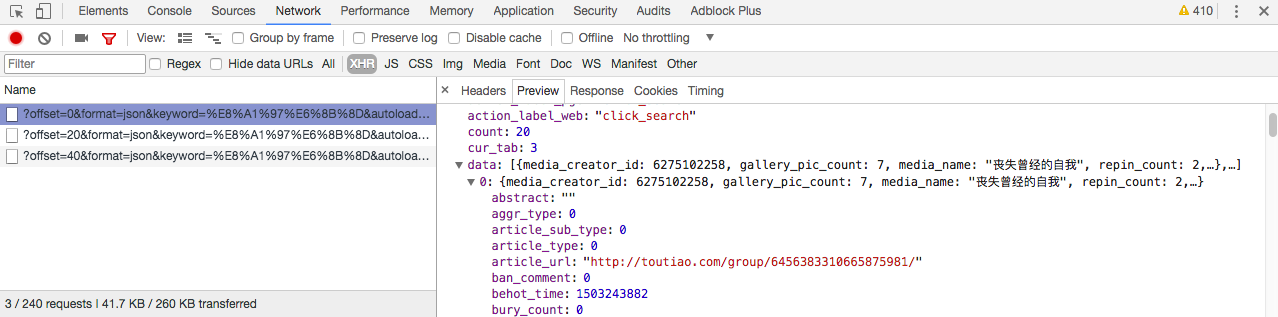

首先分析街拍图集的网页请求头部:

在 preview 选项卡我们可以找到 json 文件,分析 data 选项,找到我们要找到的图集地址 article_url:

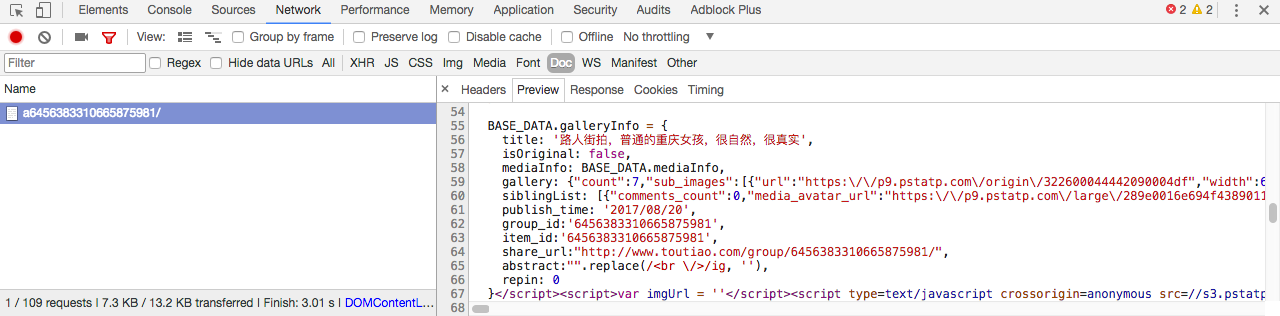

选中其中一张图片,分析 json 请求,可以找到图片地址在 gallery 一栏:

找到图片地址,接下来我们就可以来写代码了:

1.导入必要的库:

import requests

import json

import re

import pymongo

import os

from hashlib import md5

from multiprocessing import Pool

from json.decoder import JSONDecodeError

from requests.exceptions import RequestException

from urllib.parse import urlencode

from bs4 import BeautifulSoup

2.获取索引页并分析:

def get_page_index(offset, keyword):

data = {

'offset': offset,

'format': 'json',

'keyword': keyword,

'autoload': 'true',

'count': 20,

'cur_tab': 3

}

url = 'https://www.toutiao.com/search_content/?' + urlencode(data)

try:

response = requests.get(url)

if response.status_code == 200:

return response.text

return None

except RequestException:

print(' 请求索引页出错')

return None def parse_page_index(text):

try:

data = json.loads(text)

if data and 'data' in data.keys():

for item in data.get('data'):

yield item.get('article_url')

except JSONDecodeError:

pass

3.获取详情页并分析:

def get_page_detail(url):

try:

response = requests.get(url)

if response.status_code == 200:

return response.text

return None

except RequestException:

print(' 请求详情页出错')

return None def parse_page_detail(html, url):

soup = BeautifulSoup(html, 'lxml')

title = soup.select('title')[0].get_text()

images_pattern = re.compile('gallery: (.*?),\n', re.S)

result = re.search(images_pattern, html)

if result:

data = json.loads(result.group(1))

if data and 'sub_images' in data.keys():

sub_images = data.get('sub_images')

images = [item.get('url') for item in sub_images]

for image in images:

download_images(image)

return {

'title': title,

'url': url,

'images': images

}

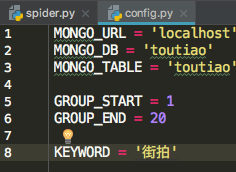

4.使用 MongoDB 数据库存储数据:

首先定义一个 config.py 文件,配置默认参数:

写入 MongoDB:

def save_to_mongo(result):

if db[MONGO_TABLE].insert(result):

print(' 存储到 MongoDB 成功', result)

return True

5.存储图片到本地:

def download_images(url):

print(' 正在下载', url)

try:

response = requests.get(url)

if response.status_code == 200:

save_images(response.content)

return None

except RequestException:

print(' 请求图片出错')

return None def save_images(content):

file_path = '{0}/{1}.{2}'.format(os.getcwd(), md5(content).hexdigest(), 'jpg')

if not os.path.exists(file_path):

with open(file_path, 'wb') as f:

f.write(content)

f.close()

6.最后定义 main()函数,并开启多线程抓取20页图集:

def save_images(content):

file_path = '{0}/{1}.{2}'.format(os.getcwd(), md5(content).hexdigest(), 'jpg')

if not os.path.exists(file_path):

with open(file_path, 'wb') as f:

f.write(content)

f.close() def main(offset):

text = get_page_index(offset, KEYWORD)

for url in parse_page_index(text):

html = get_page_detail(url)

if html:

result = parse_page_detail(html, url)

if result:

save_to_mongo(result) if __name__ == '__main__':

groups = [x * 20 for x in range(GROUP_START, GROUP_END + 1)]

pool = Pool()

pool.map(main, groups)

代码GitHub地址:https://github.com/weixuqin/PythonProjects/tree/master/jiepai

分析 ajax 请求并抓取今日头条街拍美图的更多相关文章

- 分析Ajax请求并抓取今日头条街拍美图

项目说明 本项目以今日头条为例,通过分析Ajax请求来抓取网页数据. 有些网页请求得到的HTML代码里面并没有我们在浏览器中看到的内容.这是因为这些信息是通过Ajax加载并且通过JavaScript渲 ...

- 2.分析Ajax请求并抓取今日头条街拍美图

import requests from urllib.parse import urlencode # 引入异常类 from requests.exceptions import RequestEx ...

- python爬虫知识点总结(十)分析Ajax请求并抓取今日头条街拍美图

一.流程框架

- 15-分析Ajax请求并抓取今日头条街拍美图

流程框架: 抓取索引页内容:利用requests请求目标站点,得到索引网页HTML代码,返回结果. 抓取详情页内容:解析返回结果,得到详情页的链接,并进一步抓取详情页的信息. 下载图片与保存数据库:将 ...

- Python爬虫系列-分析Ajax请求并抓取今日头条街拍图片

1.抓取索引页内容 利用requests请求目标站点,得到索引网页HTML代码,返回结果. 2.抓取详情页内容 解析返回结果,得到详情页的链接,并进一步抓取详情页的信息. 3.下载图片与保存数据库 将 ...

- 【Python爬虫案例学习】分析Ajax请求并抓取今日头条街拍图片

1.抓取索引页内容 利用requests请求目标站点,得到索引网页HTML代码,返回结果. from urllib.parse import urlencode from requests.excep ...

- python爬虫之分析Ajax请求抓取抓取今日头条街拍美图(七)

python爬虫之分析Ajax请求抓取抓取今日头条街拍美图 一.分析网站 1.进入浏览器,搜索今日头条,在搜索栏搜索街拍,然后选择图集这一栏. 2.按F12打开开发者工具,刷新网页,这时网页回弹到综合 ...

- Python Spider 抓取今日头条街拍美图

""" 抓取今日头条街拍美图 """ import os import time import requests from hashlib ...

- 爬虫(八):分析Ajax请求抓取今日头条街拍美图

(1):分析网页 分析ajax的请求网址,和需要的参数.通过不断向下拉动滚动条,发现请求的参数中offset一直在变化,所以每次请求通过offset来控制新的ajax请求. (2)上代码 a.通过aj ...

随机推荐

- 分享两个提高效率的AndroidStudio小技巧

这次分享两个 Android Studio 的小技巧,能够有效提高效率和减少犯错,尤其是在团队协作开发中. Getter 模板修改--自动处理 null 判断 格式化代码自动整理方法位置--广度 or ...

- drbd(三):drbd的状态说明

本文目录:1.drbd配置文件2.状态 2.1 连接状态(connect state,cs)和复制状态 2.2 角色状态(roles,ro) 2.3 磁盘状态(disk state,ds) 2.4 I ...

- 启动django应用报错 “Error: [WinError 10013] 以一种访问权限不允许的方式做了一个访问套接字的尝试。”

启动django应用时报如下错误 "Error: [WinError 10013] 以一种访问权限不允许的方式做了一个访问套接字的尝试." 网上查了一下,是8000端口被其他程序占 ...

- 关于如何在mac系统上安装Git并在码市上建立项目

对Git一窍不通,为了在mac系统上安装Git,查了很多资料,走了很多弯路,一切搞定后发现其实很简单. 1.在https://brew.sh上按要求安装Homebrew. 2.在电脑终端键入brew ...

- Beta冲刺NO.7

Beta冲刺 第七天 昨天的困难 昨天的困难在一些多表查询上,不熟悉hibernate的套路,走了很多弯路. 第一次使用图表插件,在图表的显示问题上花了一定的时间. 对于页面绑定和后台数据自动填充的理 ...

- 第14、15週PTA題目的處理

題目1 選擇法排序 1.實驗代碼 #include <stdio.h> #include <stdlib.h> int main() { int n,index,exchang ...

- Python 二分查找

(非递归实现) def binary_search(alist, item): first = 0 last = len(alist)-1 while first<=last: midpoint ...

- [知识梳理]课本3&9.1

函数:关键词:参数.返回值.函数返回类型.函数体. 函数按照返回类型,可以分为有参函数和无参函数. 函数根据是否有返回值,可以分为返回值函数和非返回值函数. 函数的定义:函数的定义可以放在任意 ...

- 爬虫系列(1)-----python爬取猫眼电影top100榜

对于Python初学者来说,爬虫技能是应该是最好入门,也是最能够有让自己有成就感的,今天在整理代码时,整理了一下之前自己学习爬虫的一些代码,今天先上一个简单的例子,手把手教你入门Python爬虫,爬取 ...

- Python机器学习—导入各种数据的N种办法

pandas 读取数据 一.导入一般的文件 1.read_csv(),用来读取CSV文件 官方文档是这么说的:Read CSV (comma-separated) file into DataFram ...