淘宝商品信息定向爬虫.py(亲测有效)

import requests

import re def getHTMLText(url):

try:

kv = {

'cookie': '', #要换成自己网页的cookie

'user-agent':'Mozilla/5.0' # 请求头;指定访问浏览器为Mozilla5.0版本的浏览器

}

r = requests.get(url,timeout=30,headers=kv)

r.encoding = r.apparent_encoding

return r.text

except:

return "" def parsePage(ilt,html):

try:

plt = re.findall(r'\"view_price\"\:\"[\d\.]*\"',html)

tlt = re.findall(r'\"raw_title\"\:\".*?\"',html)

for i in range(len(plt)):

price = eval(plt[i].split(':')[1]) # eval函数去掉最外层的单引号,双引号

title = eval(tlt[i].split(':')[1])

ilt.append([price,title])

except:

print("") def printGoodsList(ilt):

tplt = "{:4}\t{:8}\t{:16}"

print(tplt.format("序号","价格","商品名称"))

count = 0

for g in ilt:

count = count + 1

print(tplt.format(count,g[0],g[1])) def main():

goods = '书包'

depth = 2

start_url = 'https://s.taobao.com/search?q=' + goods infoList = []

for i in range(depth):

try:

url = start_url + '&s=' + str(44*i)

html = getHTMLText(url)

parsePage(infoList,html)

except:

continue

printGoodsList(infoList) main()

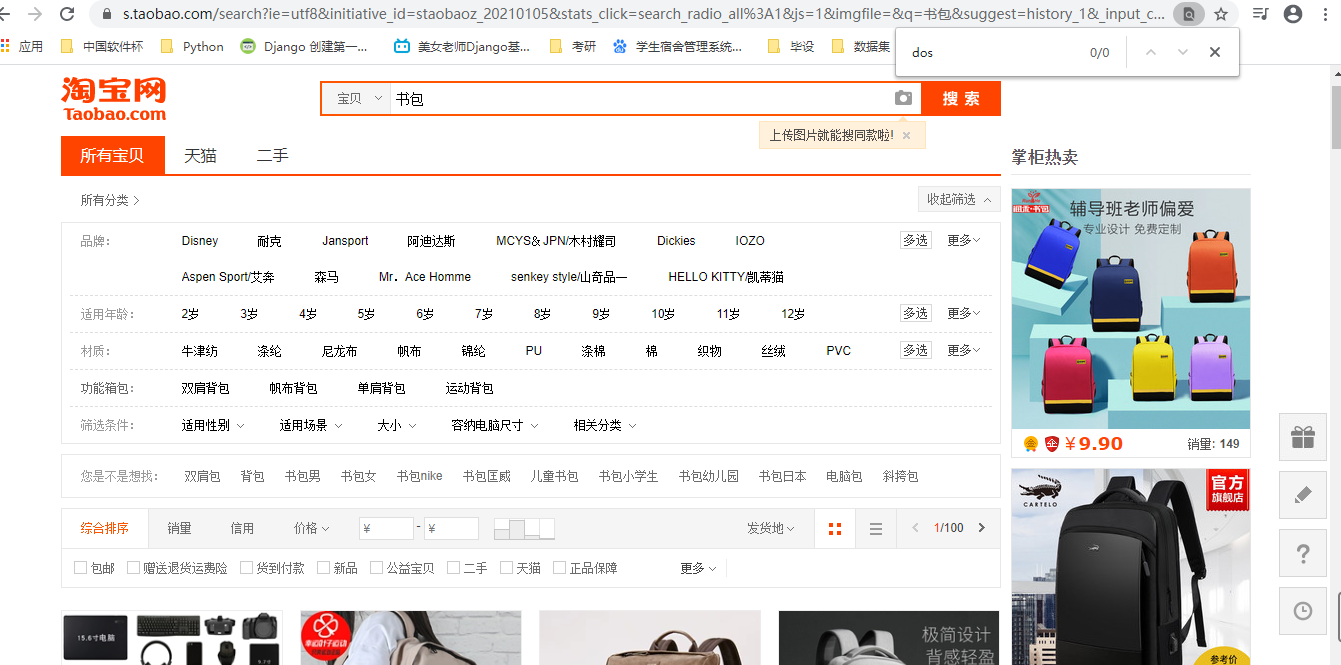

查找自己cookie的步骤如下:

(1)进入淘宝页面

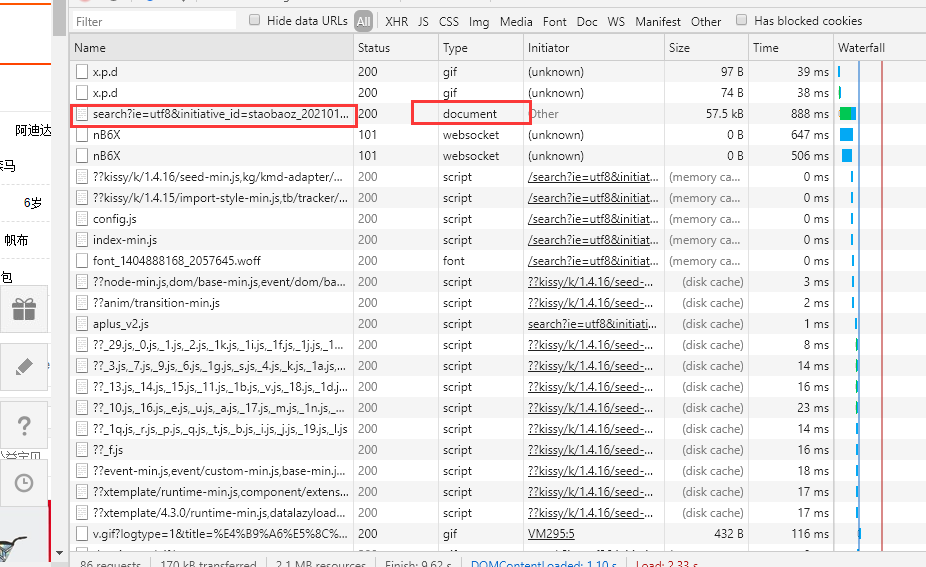

(2)按下F12,刷新页面,点击最上面的NetWork,找到下面文件

(3)找到RequestHeaders,找到里面的Cookie复制即可

淘宝商品信息定向爬虫.py(亲测有效)的更多相关文章

- python3编写网络爬虫16-使用selenium 爬取淘宝商品信息

一.使用selenium 模拟浏览器操作爬取淘宝商品信息 之前我们已经成功尝试分析Ajax来抓取相关数据,但是并不是所有页面都可以通过分析Ajax来完成抓取.比如,淘宝,它的整个页面数据确实也是通过A ...

- 利用Selenium爬取淘宝商品信息

一. Selenium和PhantomJS介绍 Selenium是一个用于Web应用程序测试的工具,Selenium直接运行在浏览器中,就像真正的用户在操作一样.由于这个性质,Selenium也是一 ...

- Selenium+Chrome/phantomJS模拟浏览器爬取淘宝商品信息

#使用selenium+Carome/phantomJS模拟浏览器爬取淘宝商品信息 # 思路: # 第一步:利用selenium驱动浏览器,搜索商品信息,得到商品列表 # 第二步:分析商品页数,驱动浏 ...

- python 获取淘宝商品信息

python cookie 获取淘宝商品信息 # //get_goods_from_taobao import requests import re import xlsxwriter cok='' ...

- <day003>登录+爬取淘宝商品信息+字典用json存储

任务1:利用cookie可以免去登录的烦恼(验证码) ''' 只需要有登录后的cookie,就可以绕过验证码 登录后的cookie可以通过Selenium用第三方(微博)进行登录,不需要进行淘宝的滑动 ...

- 爬取淘宝商品信息,放到html页面展示

爬取淘宝商品信息 import pymysql import requests import re def getHTMLText(url): kv = {'cookie':'thw=cn; hng= ...

- 使用Pyquery+selenium抓取淘宝商品信息

配置文件,配置好数据库名称,表名称,要搜索的产品类目,要爬取的页数 MONGO_URL = 'localhost' MONGO_DB = 'taobao' MONGO_TABLE = 'phone' ...

- 淘宝开放平台php-sdk测试 获取淘宝商品信息(转)

今天想使用淘宝开放平台的API获取商品详情,可是以前一直没使用过,看起来有点高深莫测,后然看开发入门,一步一步,还真有点感觉了,然后看示例,还真行了,记下来以后参考.其中遇到问题,后然解决了.因为我已 ...

- selenium+pyquery爬取淘宝商品信息

import re from selenium import webdriver from selenium.common.exceptions import TimeoutException fro ...

- selenium+phantomjs+pyquery 爬取淘宝商品信息

from selenium import webdriver from selenium.common.exceptions import TimeoutException from selenium ...

随机推荐

- 20192305 王梓全Python程序设计实验三报告

20192305 王梓全Python程序设计实验三报告 课程:<Python程序设计> 班级: 1923 姓名: 王梓全 学号:20192305 实验教师:王志强 实验日期:2021年5月 ...

- Luogu P2375 [NOI2014 D2]动物园 kmp

P2375 动物园 题目描述 近日,园长发现动物园中好吃懒做的动物越来越多了.例如企鹅,只会卖萌向游客要吃的.为了整治动物园的不良风气,让动物们凭自己的真才实学向游客要吃的,园长决定开设算法班,让动物 ...

- K Smallest In Unsorted Array

Find the K smallest numbers in an unsorted integer array A. The returned numbers should be in ascend ...

- Flink笔记

高可用(HA):直白来说就是系统不会因为某台机器,或某个实例挂了,就不能提供服务了.高可用需要做到分布式.负载均衡.自动侦查.自动切换.自动恢复等. 高吞吐: 单位时间内,能传输的数据量,对应指标就是 ...

- switch组件的使用

正常情况下,path和component是一一对应的关系 switch可以提高路由匹配效率(单一匹配)

- echarts属性大全

// 全图默认背景 // backgroundColor: 'rgba(0,0,0,0)', // 默认色板 color: ['#ff7f50','#87cefa','#da70d6','#32cd ...

- uc 小游戏接入经验

使用引擎,egret 相关资料: https://blog.csdn.net/weixin_42276579/article/details/107379544 https://minigame.uc ...

- vue项目启动报错问题解决. Module build failed: Error: Node Sass does not yet support your current environment

导入vue项目后,启动报错,异常如下: 1 error in ./src/pages/home.vue 2 Module build failed: Error: Node Sass does not ...

- Navicat 通过ssh链接远程数据库

首先需要下载一个Navicat数据库管理工具,有了Navicat工具需要完成一下步骤就可以实现本地链接远程数据库了 一.打开Navicat,点击连接按钮,找到MySQL并点击 二.点击"常规 ...

- [C#]接口Interface快速Demo

参考代码1: using System; namespace InterfaceDemo { /// <summary> /// 定义一个爬树接口 /// </summary> ...