【sparkStreaming】kafka作为数据源的生产和消费

1.建立生产者发送数据

(1)配置zookeeper属性信息props

(2)通过 new KafkaProducer[KeyType,ValueType](props) 建立producer

(3)通过 new ProducerRecord[KeyType,ValueType](topic,key,value) 封装消息message

(4)通过 producer.send(message) 发送消息

package SparkDemo import java.util

import org.apache.kafka.clients.producer.{KafkaProducer, ProducerConfig, ProducerRecord}

object KafkaProducer {

def main(args:Array[String]): Unit ={

if(args.length<4){

//参数

//<metadataBrokerList> broker地址

//<topic> topic名称

//<messagesPerSec> 每秒产生的消息

//<wordsPerMessage> 每条消息包括的单词数

System.err.println("Usage:KafkaProducer <metadataBrokerList> <topic> <messagesPerSec> <wordsPerMessage>")

System.exit(1)

}

val Array(brokers,topic,messagesPerSec,wordsPerMessage) = args

//zookeeper连接属性

val props = new util.HashMap[String,Object]();

props.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG,brokers)

props.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG,"org.apache.kafka.common.serialization.StringSerializer")

props.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG,"org.apache.kafka.common.serialization.StringSerializer")

//通过zookeeper建立kafka的producer

val producer = new KafkaProducer[String,String](props)

//通过producer发送一些消息

while(true){

(1 to messagesPerSec.toInt).foreach{//遍历[1, messagesPerSec.toInt]

messageNum =>

val str = (1 to wordsPerMessage.toInt).map(

x => scala.util.Random.nextInt(10).toString

).mkString(" ")//连成字符串用空格隔开

println(str)

//注意,我们这里发送的消息都是以键值对的形式发送的

//需要把消息内容和topic封装到ProducerRecord中再发送

//我们这里的topic为外部的传参,消息的键值对为<null,str>

val message = new ProducerRecord[String,String](topic,null,str)

//发送消息

producer.send(message)

}

Thread.sleep(1000)//休眠一秒钟

}

}

}

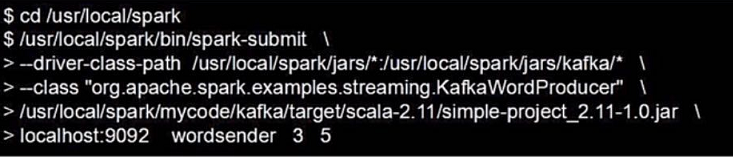

我们把程序打包好,提交到spark集群中执行

最后四个为我们要传入的程序参数

我们定义在localhost:9092的名字为wordsender的topic会以每秒3条,每条5个单词往外发送数据

2.建立消费者消费数据

(1)建立sparkStream ssc

(2)配置zookeeper地址 zkQuorum

(3)设置topic所在组名 group

(4)将topic配置成 Map<topicName,numThreads> 的 topicMap<topic名称,所需线程数> 的形式

(5)通过 KafkaUtils.createStream(ssc,zkQuorum,group,topicMap) 建立sparkStream-kafka的流通道

(6)sparkStream处理

package SparkDemo import org.apache.spark.SparkConf

import org.apache.spark.streaming.kafka.KafkaUtils

import org.apache.spark.streaming.{Seconds, StreamingContext} object KafkaConsumer {

def main(args:Array[String]): Unit ={

//设置日志等级

StreamingLoggingExample.setStreamingLogLevels()

//建立spark流

val conf = new SparkConf().setAppName("KafkaConsumerDemo").setMaster("local")

val ssc = new StreamingContext(conf,Seconds(10))

//设置检查点

ssc.checkpoint("file:/// or hdfs:///")

//zookeeper

val zkQuorum = "localhost:2181" //zookeeper服务器地址

//topic所发放的组名

val group = "1" //topic 所在的组名,可以设置为任意名字

//topic配置

val topics = "wordsender" //topic 名称,可以为多个topic,多个之间用逗号隔开 “topic1,topic2”

//建立topicMap<topicName,numThreads.toInt> key为topic名称,value为所需要的线程数

val topicMap = topics.split(",").map((_,1)).toMap //numThreads.toInt为所需线程数

//建立spark流

val lineMap = KafkaUtils.createStream(ssc,zkQuorum,group,topicMap)

//处理spark流

val lines = lineMap.map(_._2)//上面传过来的数据为<null,string>,我们去后边的value

val pair = lines.flatMap(_.split(" ")).map((_,1))

val wordCount = pair.reduceByKey(_+_)

wordCount.print

//启动spark流

ssc.start()

ssc.awaitTermination()

} }

然后我们将程序打包提交到集群上运行,就可以对上面我们建立的kafka生产的消息进行消费了。

【sparkStreaming】kafka作为数据源的生产和消费的更多相关文章

- kafka创建topic,生产和消费指定topic消息

启动zookeeper和Kafka之后,进入kafka目录(安装/启动kafka参考前面一章:https://www.cnblogs.com/cici20166/p/9425613.html) 1.创 ...

- c语言使用librdkafka库实现kafka的生产和消费实例(转)

关于librdkafka库的介绍,可以参考kafka的c/c++高性能客户端librdkafka简介,本文使用librdkafka库来进行kafka的简单的生产.消费 一.producer librd ...

- Python 基于Python结合pykafka实现kafka生产及消费速率&主题分区偏移实时监控

基于Python结合pykafka实现kafka生产及消费速率&主题分区偏移实时监控 By: 授客 QQ:1033553122 1.测试环境 python 3.4 zookeeper- ...

- 【SparkStreaming学习之四】 SparkStreaming+kafka管理消费offset

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk1.8 scala-2.10.4(依赖jdk1.8) spark ...

- Kafka 使用Java实现数据的生产和消费demo

前言 在上一篇中讲述如何搭建kafka集群,本篇则讲述如何简单的使用 kafka .不过在使用kafka的时候,还是应该简单的了解下kafka. Kafka的介绍 Kafka是一种高吞吐量的分布式发布 ...

- c# .net 使用Confluent.Kafka针对kafka进行生产和消费

首先说明一点,像Confluent.Kafka这种开源的组件,三天两头的更新.在搜索引擎搜索到的结果往往用不了,浪费时间.建议以后遇到类似的情况直接看官网给的Demo. 因为搜索引擎搜到的文章,作者基 ...

- 【Spark篇】---SparkStreaming+Kafka的两种模式receiver模式和Direct模式

一.前述 SparkStreamin是流式问题的解决的代表,一般结合kafka使用,所以本文着重讲解sparkStreaming+kafka两种模式. 二.具体 1.Receiver模式 原理图 ...

- SparkStreaming+Kafka 处理实时WIFI数据

业务背景 技术选型 Kafka Producer SparkStreaming 接收Kafka数据流 基于Receiver接收数据 直连方式读取kafka数据 Direct连接示例 使用Zookeep ...

- kafka集群的错误处理--kafka一个节点挂了,导致消费失败

今天由于kafka集群搭建时的配置不当,由于一台主消费者挂掉(服务器崩了,需要维修),导致了所有新版消费者(新版的offset存储在kafka)都无法拉取消息. 由于是线上问题,所以是绝对不能影响用户 ...

随机推荐

- Json反序列化Map的key不能是Object

使用json作为数据传输格式,碰到一个问题.我希望传输的是一个Map<Target, TargetInfo>其中Target是一个对象,作为map的一个key public class T ...

- 利用Django中间件middleware解决用户未登录问题(转)

add by zhj: Django的中间件一般用于处理通用性的问题,分为五种,按处理顺序为request_middleware,view_middleware,exception_middlewar ...

- LRU经典算法的原理与实现

LRU least recently used.顾名思义,是根据数据的活跃度进行更新的缓存算法. LRU Cache的LinkedHashMap实现: LinkedHashMap自身已经实现了顺序存 ...

- python DES3 加密解密

背景:想给公司的进件流程写一套进件脚本,首先遇到的就是加密解密.公司用的 DES3 + base64 加密解密 一.安装 pycrypto模块,推荐用pycrypto编译文件,直接下载安装就行 ht ...

- django settings相关配置

settings """ Django settings for mysite project. Generated by 'django-admin startproj ...

- MySQL数据库Date型数据插入问题

MySQL数据库中,Date型数据插入问题,总是提示如下错误: “java.util.Date cannot be cast to java.sql.Date” 解决办法: 1.首先,获取Date型数 ...

- php RFC兼容的电子邮件地址验证

php中,进行RFC兼容的电子邮件地址验证的方法,有需要的朋友参考下吧. 分享一个可以验证RFC兼容的电子邮件地址的代码,支持RFC1123,2396,3696,4291,4343,5321等的验证. ...

- Delphi 正则表达式语法(2): 或者与重复

Delphi 正则表达式语法(2): 或者与重复 // | 号的使用, | 是或者的意思 var reg: TPerlRegEx; begin reg := TPerlRegEx.Create ...

- Linux知识点总结

- Loadrunner场景设计篇——负载生成器

1 简介 当执行一个场景时,Controller把场景中的每个用户配到负载生成器(Load generator). 所谓的负载生成器(Load Generator)就是执行Vuser脚本,运行Vus ...