Python3 urllib.request库的基本使用

Python3 urllib.request库的基本使用

所谓网页抓取,就是把URL地址中指定的网络资源从网络流中读取出来,保存到本地。 在Python中有很多库可以用来抓取网页,我们先学习urllib.request库。

urllib.request库 是 Python3 自带的模块(不需要下载,导入即可使用)

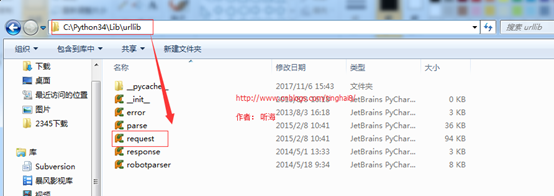

urllib.request库在windows下的路径(C:\Python34\Lib\urllib)

备注:python 自带的模块库文件都是在C:\Python34\Lib目录下(C:\Python34是我Python的安装目录),python第三方模块库都是在C:\Python34\Lib\site-packages 下。

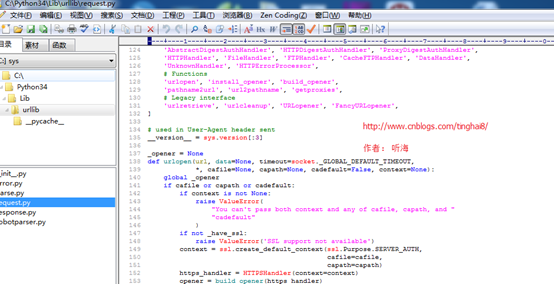

可以通过EditPlus工具或者其他代码查看工具看urllib.request库的相关方法实现的源码。

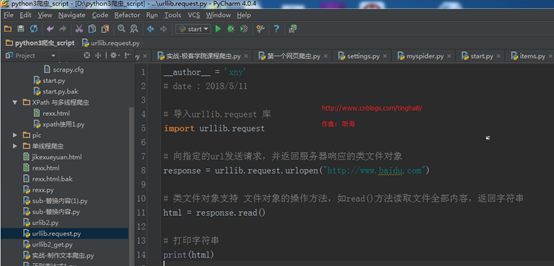

入门的例子一:用urllib.request 里的urlopen()方法发送一个请求

# 导入urllib.request 库

import urllib.request

# 向指定的url发送请求,并返回服务器响应的类文件对象

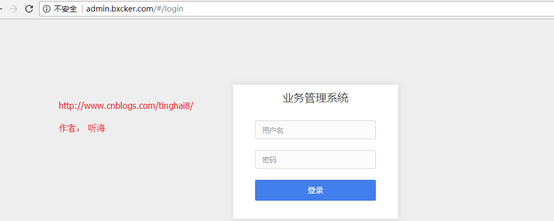

response = urllib.request.urlopen("http://admin.bxcker.com")

# 服务器返回的类文件对象支持Python文件对象的操作方法,如read()方法读取文件全部内容,返回字符串

html = response.read()

# 打印响应的内容

print(html)

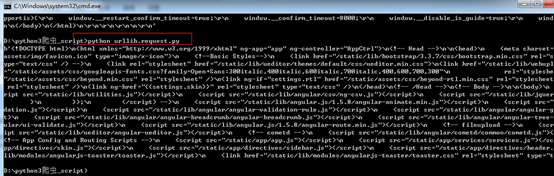

运行结果:

在PyChram下运行的结果:

在DOS下运行的结果:

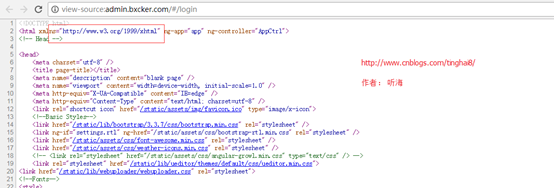

在网页查看源码核实:

在浏览器上打开http://admin.bxcker.com, 右键选择“查看源代码”,你会发现,跟我们刚才打印出来的是一模一样。也就是说,上面的例子把登陆首页的全部代码爬了下来。

一个基本的url请求对应的python代码是非常的简单,通过例子,说明是可以通过发送请求,获取响应的内容,然后输出显示响应的内容。

备注:urllib.request 里的 urlopen()不支持构造HTTP请求,不能给编写的请求添加head,无法模拟真实的浏览器发送请求。

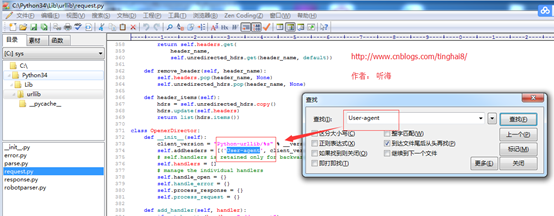

通过查看urllib.request库的源码文件,查看“User-agent”默认的是client_version

而client_version = "Python-urllib/%s" % __version__

通过查urllib.request库的源码文件,__version__= sys.version[:3]

在Dos下执行sys.version[:3],显示的是3.4。

通过验证得出结论:urllib.request库的urlopen()方法默认的“User-agent”是本机Python的版本(User-agent:Python-urllib/3.4),对于服务器而言,一下就能识别出这是爬虫。

在我们第一个入门例子里,urlopen()的参数就是一个url地址;但是如果需要执行更复杂的操作,比如增加HTTP报头,必须创建一个 Request 实例来作为urlopen()的参数;而需要访问的url地址则作为 Request 实例的参数。

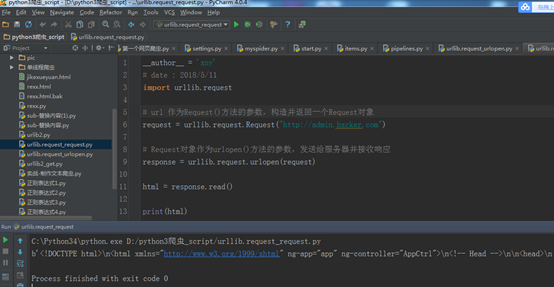

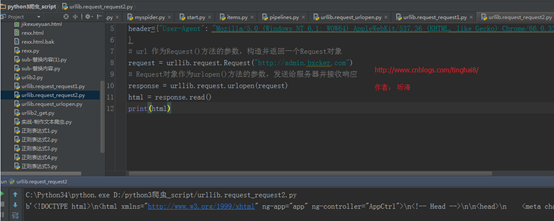

例子二:用urllib.request 里的request ()方法发送一个请求

import urllib.request

# url 作为Request()方法的参数,构造并返回一个Request对象

request = urllib.request.Request("http://admin.bxcker.com")

# Request对象作为urlopen()方法的参数,发送给服务器并接收响应

response = urllib.request.urlopen(request)

html = response.read()

print(html)

运行结果:跟例子一是一样。

Request实例,除了必须要有 url 参数之外,还可以设置另外两个参数:

data:如果是GET请求,data(默认空),如果是POST请求,需要加上data参数,伴随 url 提交的数据。

headers(默认空):是一个字典,包含了需要发送的HTTP报头的键值对。

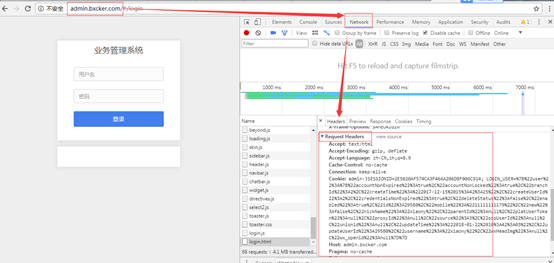

通过抓包可以抓到http://admin.bxcker.com 请求的head信息

Accept: text/html

Accept-Encoding: gzip, deflate

Accept-Language: zh-CN,zh;q=0.9

Cache-Control: no-cache

Connection: keep-alive

Cookie:admin-JSESSIONID=2E5020AF574CA3F466A206D8F006C914; LOGIN_USER=%7B%22user%22%3A%7B%22accountNonExpired%22%3Atrue%2C%22accountNonLocked%22%3Atrue%2C%22branchId%22%3A2%2C%22createTime%22%3A%222017-12-15%2015%3A42%3A25%22%2C%22createUserId%22%3A2%2C%22credentialsNonExpired%22%3Atrue%2C%22deleteStatus%22%3Afalse%2C%22enabled%22%3Atrue%2C%22id%22%3A29580%2C%22mobile%22%3A%2211111111179%22%2C%22new%22%3Afalse%2C%22nickName%22%3A%22xiaony%22%2C%22parentId%22%3Anull%2C%22platUserToken%22%3Anull%2C%22proxyId%22%3Anull%2C%22source%22%3A3%2C%22ssoUserId%22%3Anull%2C%22unionid%22%3Anull%2C%22updateTime%22%3A%222018-01-22%2010%3A42%3A03%22%2C%22updateUserId%22%3A29580%2C%22username%22%3A%22xiaony%22%2C%22wxHeadImg%22%3Anull%2C%22wx_openid%22%3Anull%7D%7D

Host: admin.bxcker.com

Pragma: no-cache

Referer: http://admin.bxcker.com/

User-Agent: Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.139 Safari/537.36

【Host】:主域 (发请求时,可以不写)

【Connection: keep-alive】:保持登录后的长连接

【User-Agent】:最重要的参数

【Accept】:接受数据的格式,例如:text文本、json等

【Accept-Encoding】:数据的压缩方式 (爬虫不是服务器,没有解压方法,不能写)

【Accept-Language】:支持的语言 (可以不写)

【Cookie】:缓存,Cookie在爬虫里主要获取登录后的状态,跟登录相关的可以用Cookie处理,如果只是获取一个静态页面的数据,就不需要用Cookie。

web项目通过都是通过浏览器去访问,要想真实模拟一个用户用浏览器去访问web项目,在发送请求的时候,会有不同的User-Agent头。 urllib2默认的User-Agent头为:Python-urllib/x.y,所以就需要我们在发request请求的时候添加一个head信息

例子三:用urllib.request 里的request ()方法里加上head信息

import urllib.request

header={"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.139 Safari/537.36"

}

# url 作为Request()方法的参数,构造并返回一个Request对象

request = urllib.request.Request("http://admin.bxcker.com")

# Request对象作为urlopen()方法的参数,发送给服务器并接收响应

response = urllib.request.urlopen(request)

html = response.read()

print(html)

运行结果:

为了验证我们爬虫发的请求,可以用抓包工具去抓我们爬虫发出去的请求,可以看到我们的头文件。

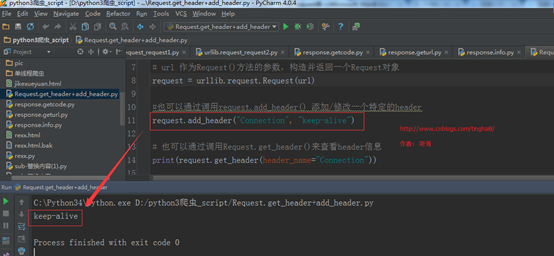

例子四:Request.get_header()与Request.add_header()

import urllib.request

url ="http://admin.bxcker.com"

header={"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.139 Safari/537.36"

}

# url 作为Request()方法的参数,构造并返回一个Request对象

request = urllib.request.Request(url)

#也可以通过调用request.add_header() 添加/修改一个特定的header

request.add_header("Connection", "keep-alive")

# 也可以通过调用Request.get_header()来查看header信息

print(request.get_header(header_name="Connection"))

# Request对象作为urlopen()方法的参数,发送给服务器并接收响应

response = urllib.request.urlopen(request)

html = response.read()

#print(html)

运行结果:

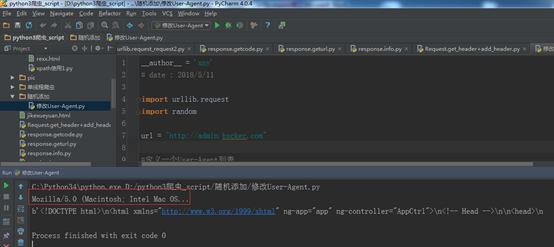

例子五:随机添加/修改User-Agent

import urllib.request

import random

url = "http://admin.bxcker.com"

#定义一个User-Agent列表

user_agent_list = [

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.139 Safari/537.36,",

"Mozilla/5.0 (X11; CrOS i686 2268.111.0)... ",

"Mozilla/5.0 (Macintosh; U; PPC Mac OS X.... ",

"Mozilla/5.0 (Macintosh; Intel Mac OS... "

]

#随机抽取一个User-Agent值

user_agent = random.choice(user_agent_list)

# url 作为Request()方法的参数,构造并返回一个Request对象

request = urllib.request.Request(url)

#通过调用Request.add_header() 添加一个特定的header

request.add_header("User-Agent", user_agent)

# 第一个字母大写,后面的全部小写

print(request.get_header("User-agent"))

# Request对象作为urlopen()方法的参数,发送给服务器并接收响应

response = urllib.request.urlopen(request)

html = response.read()

print(html)

运行结果:

Python3 urllib.request库的基本使用的更多相关文章

- 爬虫——urllib.request库的基本使用

所谓网页抓取,就是把URL地址中指定的网络资源从网络流中读取出来,保存到本地.在Python中有很多库可以用来抓取网页,我们先学习urllib.request.(在python2.x中为urllib2 ...

- 爬虫小探-Python3 urllib.request获取页面数据

使用Python3 urllib.request中的Requests()和urlopen()方法获取页面源码,并用re正则进行正则匹配查找需要的数据. #forex.py#coding:utf-8 ' ...

- 【转】python3 urllib.request 网络请求操作

python3 urllib.request 网络请求操作 基本的网络请求示例 ''' Created on 2014年4月22日 @author: dev.keke@gmail.com ''' im ...

- python3 urllib.request 网络请求操作

python3 urllib.request 网络请求操作 基本的网络请求示例 ''' Created on 2014年4月22日 @author: dev.keke@gmail.com ''' im ...

- python3.6 urllib.request库实现简单的网络爬虫、下载图片

#更新日志:#0418 爬取页面商品URL#0421 更新 添加爬取下载页面图片功能#0423 更新 添加发送邮件功能# 优化 爬虫异常处理.错误页面及空页面处理# 优化 爬虫关键字黑名单.白名单,提 ...

- 爬虫入门【1】urllib.request库用法简介

urlopen方法 打开指定的URL urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, ca ...

- (转)python3 urllib.request.urlopen() 错误UnicodeEncodeError: 'ascii' codec can't encode characters

代码内容: url = 'https://movie.douban.com/j/search_subjects?type=movie'+ str(tag) + '&sort=recommend ...

- 通过python的urllib.request库来爬取一只猫

我们实验的网站很简单,就是一个关于猫的图片的网站:http://placekitten.com 代码如下: import urllib.request respond = urllib.request ...

- python3 urllib.request.urlopen() 地址打开错误

错误内容:UnicodeEncodeError: 'ascii' codec can't encode characters in position 28-29: ordinal not in ran ...

随机推荐

- MyEclipse 报错:Errors running builder 'DeploymentBuilder' on project '工程名'

并没有更换MyEclipse版本,只是重新卸载了下,然后就报错误,参考了网上的文章 解决版本 .就是删除工程下部署文件

- LeetCode之“链表”:Intersection of Two Linked Lists

此题扩展:链表有环,如何判断相交? 参考资料: 编程判断两个链表是否相交 面试精选:链表问题集锦 题目链接 题目要求: Write a program to find the node at whic ...

- RedHat系列软件管理(第二版) --脚本安装

RedHat系列软件管理 --脚本安装 一.解压缩 tar -zxvf webmin-1.700.tar.gz 二.进入相关目录 cd webmin-1.700 三.如果此时执行./configure ...

- 【57】android图片印刻,阳刻,素描图效果处理

介绍我参与开发的妙趣剪纸app使用的图片处理相关的技术 关于妙趣剪纸,各大android商店都可以下载,下面贴出小米商店的链接 妙趣剪纸下载 软件效果截图 如何实现上面的图片处理效果呢 1.初始化高斯 ...

- Zip操作的工具类

/** * Copyright 2002-2010 the original author is huanghe. */package com.ucap.web.cm.webapp.util; ...

- MakeFile 文件的作用

makefile文件保存了编译器和连接器的参数选项,还表述了所有源文件之间的关系(源代码文件需要的特定的包含文件,可执行文件要求包含的目标文件模块及库等).创建程序(make程序)首先读取makefi ...

- OpenLayers3的轨迹回放

OpenLayers3实现轨迹回放需要动画操作,官网上的例子用的是postcompose,但是还可以使用javascript中setInterval和setTime. 我的例子是按官网上来的http: ...

- Mybatis解决jdbc编程的问题

1.1.1 Mybatis解决jdbc编程的问题 1. 数据库链接创建.释放频繁造成系统资源浪费从而影响系统性能,如果使用数据库链接池可解决此问题. 解决:在SqlMapConfig.xml中配置 ...

- JVM terminated. Exit code=8096

http://www-01.ibm.com/support/docview.wss?uid=swg21303648 Technote (troubleshooting) Problem(Abstrac ...

- jQuery选择器面试题

$("#myELement") 选择id值等于myElement的元素,id值不能重复在文档中只能有一个id值是myElement所以得到的是唯一的元素 $("di ...