BGD(批量梯度下降)--学习笔记

函数凸凹性:

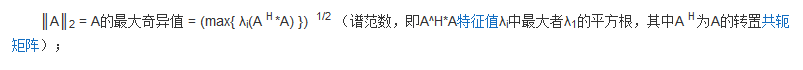

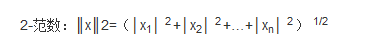

用到的范数知识:

详细解释:每一个元素的平方再开方。

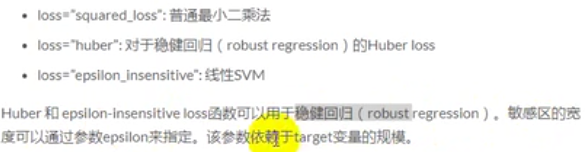

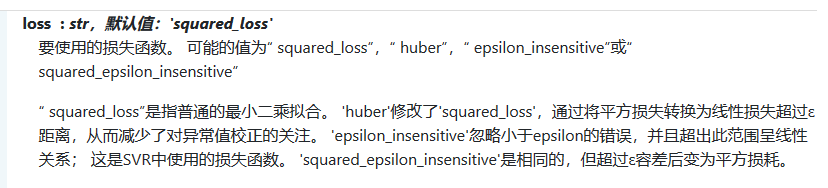

补充损失函数: Huber Loss知识点

loss函数可以通过loss参数进行设置。SGDRegressor支持以下的loss函数:

SGD:随机梯度下降四个损失函数:

事例代码:

import numpy as np

import matplotlib.pyplot as plt

np.random.seed(0) #随机数种子

#构造训练数据,这个数据不包括x0;

x=np.arange(0,10,0.2) #生成50个样本

#训练样本的个数

m=len(x)

#构造x0

x0=np.full(m,1.0) #50个1

#将x0和x拼接起来,组成完整的训练数据

input_data=np.vstack([x0,x]).T #将偏置b作为权向量的第一个分量

featureNum=input_data.shape[1] #维度

print(input_data)

#y_train生成y,其实就是input_data对应的标签

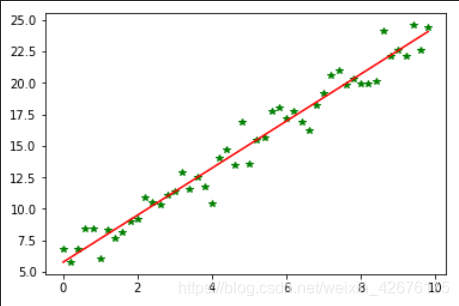

target_data=2*x+5+np.random.randn(m) #最后一项是偏差m=5就行了,x是50的向量 #两种终止条件

loop_max=1000000 #最大迭代次数,防止死循环

epsilon=1e-5 #阈值 #初始化权值

theta=np.random.randn(featureNum)

alpha=0.00001 #步长(注意取值过大会导致震荡即不收敛,过小收敛速度变慢)

#记录误差变量

error=np.zeros(featureNum)

count=0 #循环次数

#全部用向量表示,theta的维度和error维度一样。 while count < loop_max:

count += 1

sum_m=np.zeros(2)

for i in range(m):

diff = (np.dot(theta,input_data[i])-target_data[i])*input_data[i]

sum_m=sum_m+diff #当alpha取值过大时,sum_m会在迭代过程中溢出 theta = theta-alpha*sum_m #注意步长alpha(0.005的时候会震荡)的取值,过大会导致震荡

#判断是否已经收敛

if np.linalg.norm(theta-error)<epsilon: #norm()范数:error是之前的theta,theta是更新后的,相减是求距离,也就是求相关性:距离很小的时候,相当于theta值没有更新

break

else:

error=theta

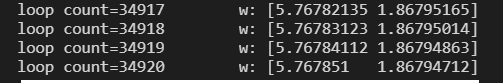

print('loop count=%d'%count,'\tw:',theta)

print('loop count=%d'%count,'\tw:',theta) plt.plot(x,target_data,'g*')

plt.plot(x,theta[1]*x+theta[0],'r')

plt.show()

输出:

省略···

BGD(批量梯度下降)--学习笔记的更多相关文章

- 批量梯度下降(BGD)、随机梯度下降(SGD)以及小批量梯度下降(MBGD)的理解

梯度下降法作为机器学习中较常使用的优化算法,其有着三种不同的形式:批量梯度下降(Batch Gradient Descent).随机梯度下降(Stochastic Gradient Descent ...

- online learning,batch learning&批量梯度下降,随机梯度下降

以上几个概念之前没有完全弄清其含义及区别,容易混淆概念,在本文浅析一下: 一.online learning vs batch learning online learning强调的是学习是实时的,流 ...

- 随机梯度下降(Stochastic gradient descent)和 批量梯度下降(Batch gradient descent )的公式对比、实现对比[转]

梯度下降(GD)是最小化风险函数.损失函数的一种常用方法,随机梯度下降和批量梯度下降是两种迭代求解思路,下面从公式和实现的角度对两者进行分析,如有哪个方面写的不对,希望网友纠正. 下面的h(x)是要拟 ...

- 【转】 随机梯度下降(Stochastic gradient descent)和 批量梯度下降(Batch gradient descent )的公式对比、实现对比

梯度下降(GD)是最小化风险函数.损失函数的一种常用方法,随机梯度下降和批量梯度下降是两种迭代求解思路,下面从公式和实现的角度对两者进行分析,如有哪个方面写的不对,希望网友纠正. 下面的h(x)是要拟 ...

- batch gradient descent(批量梯度下降) 和 stochastic gradient descent(随机梯度下降)

批量梯度下降是一种对参数的update进行累积,然后批量更新的一种方式.用于在已知整个训练集时的一种训练方式,但对于大规模数据并不合适. 随机梯度下降是一种对参数随着样本训练,一个一个的及时updat ...

- NN优化方法对照:梯度下降、随机梯度下降和批量梯度下降

1.前言 这几种方法呢都是在求最优解中常常出现的方法,主要是应用迭代的思想来逼近.在梯度下降算法中.都是环绕下面这个式子展开: 当中在上面的式子中hθ(x)代表.输入为x的时候的其当时θ參数下的输出值 ...

- 机器学习-随机梯度下降(Stochastic gradient descent)和 批量梯度下降(Batch gradient descent )

梯度下降(GD)是最小化风险函数.损失函数的一种常用方法,随机梯度下降和批量梯度下降是两种迭代求解思路,下面从公式和实现的角度对两者进行分析,如有哪个方面写的不对,希望网友纠正. 下面的h(x)是要拟 ...

- Tensorflow细节-P84-梯度下降与批量梯度下降

1.批量梯度下降 批量梯度下降法是最原始的形式,它是指在每一次迭代时使用所有样本来进行梯度的更新.从数学上理解如下: 对应的目标函数(代价函数)即为: (1)对目标函数求偏导: (2)每次迭代对参数进 ...

- 【Python】机器学习之单变量线性回归 利用批量梯度下降找到合适的参数值

[Python]机器学习之单变量线性回归 利用批量梯度下降找到合适的参数值 本题目来自吴恩达机器学习视频. 题目: 你是一个餐厅的老板,你想在其他城市开分店,所以你得到了一些数据(数据在本文最下方), ...

随机推荐

- C# 重载运算符--不合理设计,只支持静态

什么叫做重载运算符 比如:int x=1; int y=2; int total=x+y; 我们比较喜欢看上面这种写法,而不是这种, int x=1; int y=1; int total=int.a ...

- mysql索引技术名词1-5

目录 索引技术名词 1.回表 2.覆盖索引 3.最左匹配原则 4.索引下推 5.谓词下推 索引技术名词 1.回表 注意: 1.如果依靠主键查询,叶子结点直接存储数据----主键B+树 2.如果依靠其他 ...

- xsd文件生成cs文件命令

C:\Windows\System32>xsd.exe c:/Createst.xsd -c C:\Windows\System32>xsd.exe c:/Creauest.xsd /c ...

- Lesson A puma at large

新概念三 Lesson 1 A puma at large 词汇: 1. spot 易混淆: recognize v. [认出], identify v. [识别sb/sth的身份] v. 看出,发现 ...

- LeetCode-007-整数反转

整数反转 题目描述:给你一个 32 位的有符号整数 x ,返回将 x 中的数字部分反转后的结果. 如果反转后整数超过 32 位的有符号整数的范围 [\(−2^{31}\), \(2^{31}\) − ...

- 矩池云上使用nohup和&让任务后台运行

1.nohup 用途:不挂断地运行命令. 语法:nohup Command [ Arg - ] [ & ] 无论是否将 nohup 命令的输出重定向到终端,输出都将附加到当前目录的 nohup ...

- 在 Debian 和 Ubuntu 上安装 Cutefish 可爱鱼

版权声明:原创文章,未经博主允许不得转载 CutefishOS 是一个可爱好看的新 Linux 发行版,当前最新版本为 0.8beta .这是一个基于 Debian 的发行版,从其镜像源配置就可以明显 ...

- 【AIA】培训感悟

最主要一个感悟,有钱了一定要买香港的保险.存个100万,年薪30就行,先把这个做目标.

- [JS基础] 带你深入了解JS原型

简介 下面这张图大家应该很很熟悉了,各位大佬讲原型及原型链的时候是大部分都会用到下面这张图片的 我想以自己的方式来讲述一遍,一是帮助我自己更好的复习,二是希望能够帮助到想要复习或者学习原型的同学 在讲 ...

- mysql学习笔记-底层原理详解

前言 我相信每一个程序员都避免不了和数据库打交道,其中Mysql以其轻量.开源成为当下最流行的关系型数据库.Mysql5.0以前以MyISAM作为默认存储引擎,在5.5版本以后,以InnoDB作为默认 ...