ubuntu18.04搭建hive

hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的sql查询功能,可以将sql语句转换为MapReduce任务进行运行。 其优点是学习成本低,可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

0 hadoop搭建

在搭建hive之前,要保证hadoop搭建完成,hadoop教程可以参考这篇文章 ubuntu18.04下hadoop搭建https://blog.csdn.net/qq_41822647/article/details/84451416

1 下载并配置Hive

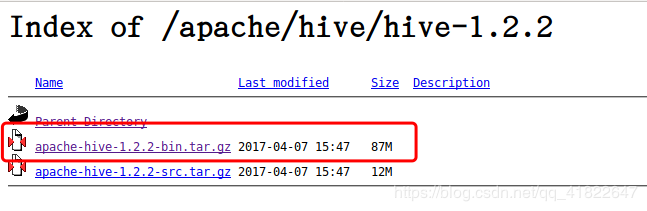

1.1 下载Hive

在apache官网下载hive包,这里下载的是hive-1.2.2版本 https://mirrors.tuna.tsinghua.edu.cn/apache/hive/

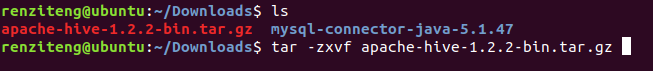

下载好后解压hive包

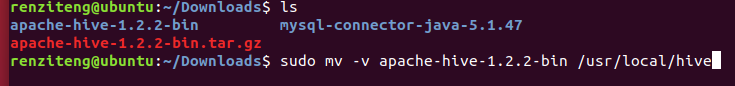

然后将解压包移动到/usr/local/hive下,移之前首先在/usr/local下创建名为hive文件夹

$ sudo mkdir /usr/local/hive

移动hive包到/usr/local/hive目录下

1.2 配置环境变量

$ sudo vi /etc/profile

增加如下配置:

export HIVE_HOME=/usr/local/hive/apache-hive-1.2.2-bin

export PATH=$PATH:$HIVE_HOME/bin

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib:/usr/local/hive/apahe-hive-1.2.2-bin/lib

更新环境变量

$ source /etc/profile

1.3 配置hive-env.s h

进入目录下,

/usr/local/hive/apache-hive-1.2.1-bin/conf

首先新建一个空文件hive-env.sh:

$ touch hive-env.sh

接着

$ cp hive-env.sh.template hive-env.sh

$ vi hive-env.sh

添加hadoop的路径,如下:

HADOOP_HOME=/usr/local/hadoop/hadoop-2.9.2

(以下所有配置均在该路径下。)

1.4 配置hive-site.xml

仍然,首先新建文件hive-site.xml

$ touch hive-site.xml

接着

$ cp hive-default.xml.template hive-site.xml

$ vi hive-site.xml

增加mysql数据库的连接配置:

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://master:3306/hive?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>hive</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>hive</value>

<description>password to use against metastore database</description>

</property>

修改临时文件夹的路径,找到以下两个位置,并修改为正确路径:

<property>

<name>hive.exec.local.scratchdir</name>

<value>/home/renziteng/iotmp</value>

<description>Local scratch space for Hive jobs</description>

</property>

<property>

<name>hive.downloaded.resources.dir</name>

<value>/home/renziteng/iotmp</value>

<description>Temporary local directory for added resources in the remote file system.</description>

</property>

我的用户名是renziteng,所以在该路径下,新建了iotmp文件夹,并授权:

$ mkdir -p /home/renziteng/iotmp

$ chmod -R 775 /home/renziteng/iotmp

1.5 修改hive-config.sh

进入目录:/usr/local/hive/apache-hive-1.2.2-bin/bin

sudo vi hive-config.sh

在该文件的最前面添加以下内容:

export JAVA_HOME=/usr/local/java/jdk1.8.0_191

export HADOOP_HOME=/usr/local/hadoop/hadoop-2.9.2

export HIVE_HOME=/usr/local/hive/apache-hive-1.2.2-bin

2 安装并配置mysql

2.1 安装MySQL Server

在命令行输入sudo apt-get install mysql-server即可安装。

2.2 下载MySQL JDBC驱动器

去mysql官网找GA version下载

下载完后解压

tar -zxvf mysql-connector-java-5.1.47.tar.gz

然后进入解压后的目录,把jar包复制到/usr/local/hive/apache-hive-1.2.2-bin/lib/下

$ cp mysql-connector-java-5.1.40-bin.jar /usr/local/hive/apache-hive-1.2.2-bin/lib

2.3 在HDFS中创建目录和设置权限

启动hadoop,在hadoop中创建hive需要用到的目录并设置权限。

$ start-all.sh #启动hadoop

$ hadoop fs -mkdir /tmp

$ hadoop fs -mkdir -p /user/hive/warehouse

$ hadoop fs -chmod g+w /tmp

$ hadoop fs -chmod g+w /user/hive/warehouse

2.4 初始化meta数据库

进入/usr/local/hive/apache-hive-1.2.2-bin/lib目录,初始化Hive元数据对应的MySQL数据库:

schematool -initSchema -dbType mysql

2.5 启动Hive

启动hive前,确保hadoop集群启动

$ start-all.sh

$ hive

这样就成功了!!

from:https://blog.csdn.net/qq_41822647/article/details/84503869

ubuntu18.04搭建hive的更多相关文章

- ubuntu18.04搭建NFS服务器

系统环境: NFS服务器操作系统: ubuntu18.04 server lts NFS服务器IP: 192.168.1.164 注: NFS服务器 指的是 待安装 NFS服务 的机器(物理机或者虚 ...

- ubuntu18.04 搭建scrapy环境(连环踩坑+解决办法)

---恢复内容开始--- 预期需求: 打算搭建scrapy环境,基于python3.x的 环境描述: ubuntu18.04自带了python3.6,打算在虚拟环境vlenv中跑scrapy,装好虚拟 ...

- ubuntu18.04搭建 kubernetes(k8s)集群

下面使用kubeadm来创建k8s cluster1. 所有主机节点上都需要安装docker # sudo apt-get update # sudo apt-get install \ apt-tr ...

- Ubuntu18.04搭建测试环境

前言 说一下我的情况,之前由于我的云服务器数据库的root账号密码123456太简单,而在之前的博客中也泄露出了我的云服务器的IP地址,导致有人远程连接我的数据库,删除了项目数据库里的数据只剩下WAR ...

- ubuntu18.04搭建nfs

1.服务端安装 #apt-get update -y #apt-get install -y nfs-kernel-server #apt-get enable nfs-kernel-server 2 ...

- Ubuntu18.04搭建nodejs环境

首先安装sudo apt install curl 然后安装命令(当前最新版本是0.33.2,最新版本可以在https://github.com/creationix/nvm查看): curl -o- ...

- Ubuntu18.04 搭建zookeeper单机版集群

一台电脑启动三个虚拟机比较折腾,这里就用一台虚拟机模拟一下zk集群. 1.后台下载安装包到 /opt目录 sudo wget -b http://archive.apache.org/dist/zoo ...

- 虚拟机VMware15 Ubuntu18.04 搭建FTP服务器

1.安装vsftpd sudo apt install vsftpd 2.查看是否安装成功,出现版本等信息即成功 sudo vsftpd -v 3.添加ftp用户 sudo useradd -m su ...

- Ubuntu18.04下搭建LAMP环境

一.Apache2 web 服务器的安装 : 可以先更新一下服务器 1.sudo apt-get update # 获取最新资源包 2.sudo apt-get upgrade ...

随机推荐

- MongoDB Export & Import

在使用MongoDB数据库的过程中,避免不了需要将数据进行导入和导出的工作,下面为具体的用法.注意 不同的数据库版本可能存在略微的差异,所以在使用时,先查看 --help 来进行确认.下面的为3.6版 ...

- Chapter 5 Blood Type——14

"You're wrong." His voice was almost inaudible. “你错了.” 他的声音几乎听不见 He looked down, stealing ...

- 环境与工具2:建立高效的mac环境

你的工作与生活离不开电脑,电脑是一个工具,也是一个环境.环境是不是绿水青山,是不是得心应手,这是很重要的事情.小程平时使用macbook来学习跟娱乐,最近重装了系统,很多环境与工具都需要重新组建. 那 ...

- XSS Reflected 测试

由于最近在做XSS方面的测试,于是找到了DVWA平台进行实验测试,通过这三篇文章让大家了解XSS方面的大概内容,这三篇文章只是把你领进XSS的大门,要想真正深入的学习XSS,你还需要去学习很多东西来提 ...

- mybatis和hibernate的区别

1. hibernate是全自动,而mybatis是半自动 hibernate完全可以通过对象关系模型实现对数据库的操作,拥有完整的JavaBean对象与数据库的映射结构来自动生成sql.而mybat ...

- Ruby Enumerator的各种迭代

Enumerator迭代 Mix-in Enumerator获得的迭代方法: each_cons: each_slice: each_with_index: with_index: each_with ...

- IOS中armv7,armv7s,arm64以及i386和x86_64讲解

一.前言问题 在iOS 开发过程中,估计比较少的人会在意armv7,armv7s,arm64这些概念,如果在意可能也是项目中出现了像下面的问题,才会想起来解决这些问题,但还是不是特别的理解,这些概念, ...

- 第8章 概述 - Identity Server 4 中文文档(v1.0.0)

快速入门提供了各种常见IdentityServer方案的分步说明.他们从基础到复杂 - 建议您按顺序完成它们. 将IdentityServer添加到ASP.NET Core应用程序 配置Identit ...

- [Go] golang的竞争状态

1.goroutine在逻辑处理器的线程上进行交换 2.竞争状态:两个或者多个goroutine在没有互相同步的情况下,访问某个共享的资源,并试图同时读和写这个资源,就处于互相竞争的状态对共享资源的读 ...

- PHP 脚本不报错

场景 当运行PHP脚本,访问数组中不存在的key时,脚本不报错,如下: <?php $arr = [1,2,3]; // 不报错,返回null var_dump($arr['abc']); 解决 ...