PYTHON 爬虫笔记九:利用Ajax+正则表达式+BeautifulSoup爬取今日头条街拍图集(实战项目二)

利用Ajax+正则表达式+BeautifulSoup爬取今日头条街拍图集

目标站点分析

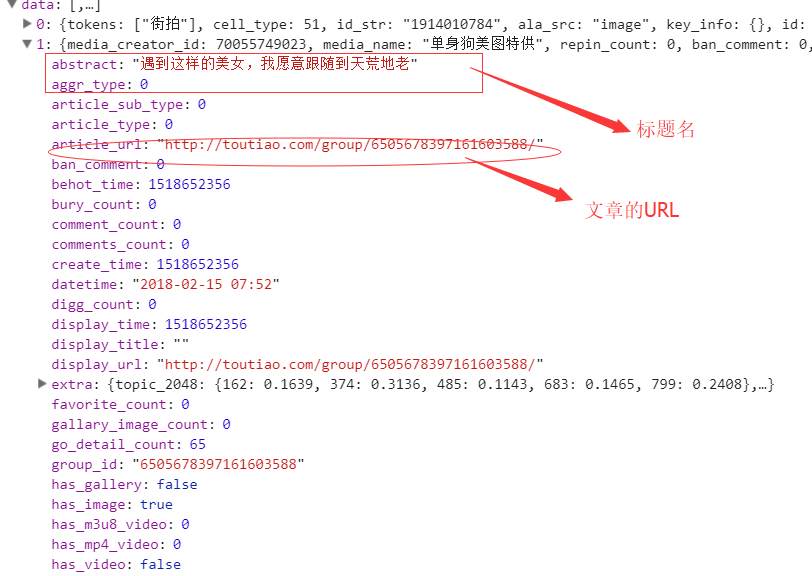

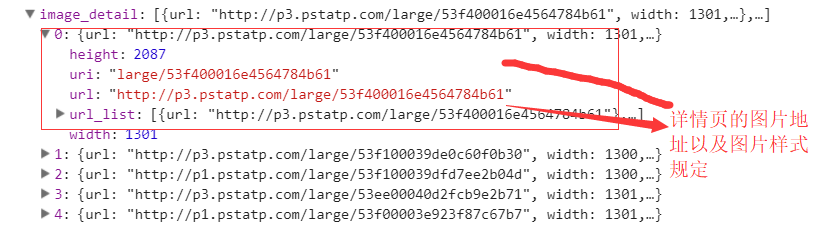

今日头条这类的网站制作,从数据形式,CSS样式都是通过数据接口的样式来决定的,所以它的抓取方法和其他网页的抓取方法不太一样,对它的抓取需要抓取后台传来的JSON数据,

先来看一下今日头条的源码结构:我们抓取文章的标题,详情页的图片链接试一下:

看到上面的源码了吧,抓取下来没有用,那么我看下它的后台数据:‘

所有的数据都在后台的JSON展示中,所以我们需要通过接口对数据进行抓取

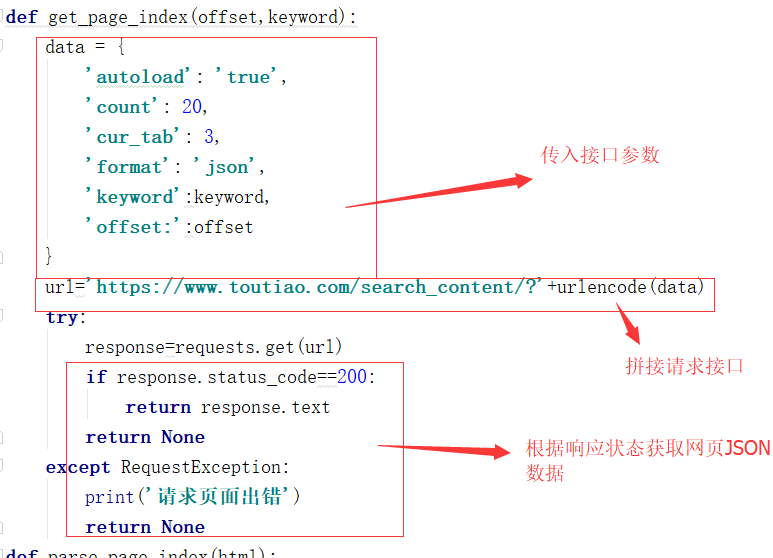

提取网页JSON数据

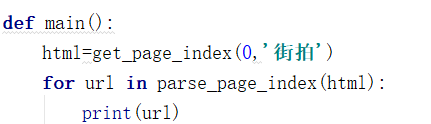

执行函数结果,如果你想大量抓取记得开启多进程并且存入数据库:

看下结果:

总结一下:网上好多抓取今日头条的案例都是先抓去指定主页,获取文章的URL再通过详情页,接着在详情页上抓取,但是现在的今日头条的网站是这样的,在主页的接口数据中就带有详情页的数据,通过点击跳转携带数据的方式将数据传给详情页的页面模板,这样开发起来方便节省了不少时间并且减少代码量

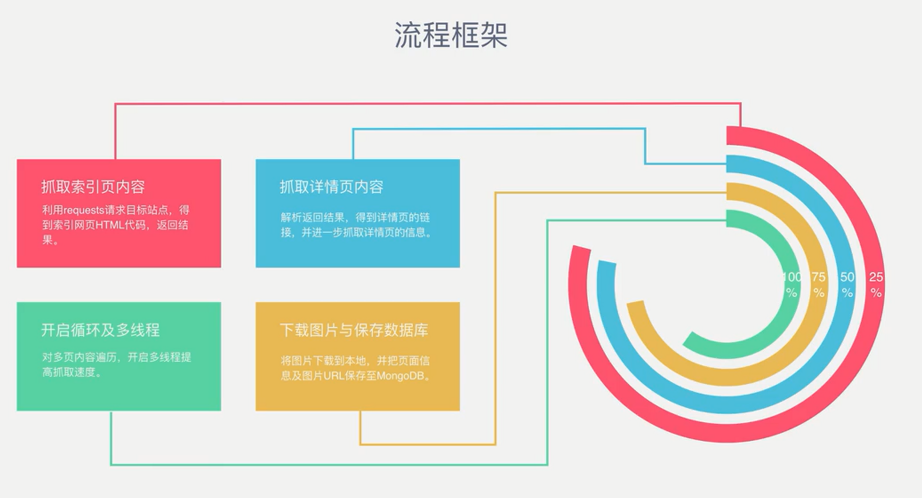

流程框架

爬虫实战

spider详情页

import json

import os

from hashlib import md5

from json import JSONDecodeError import pymongo

import re

from urllib.parse import urlencode

from multiprocessing import Pool import requests

from bs4 import BeautifulSoup

from config import * client = pymongo.MongoClient(MONOGO_URL, connect=False)

db = client[MONOGO_DB] def get_page_index(offset,keyword): #请求首页页面html

data = {

'offset': offset,

'format': 'json',

'keyword': keyword,

'autoload': 'true',

'count': 20,

'cur_tab': 3,

'from': 'search_tab'

}

url ='https://www.toutiao.com/search_content/?' + urlencode(data)

try:

response = requests.get(url)

if response.status_code == 200:

return response.text

return None

except Exception:

print('请求首页出错')

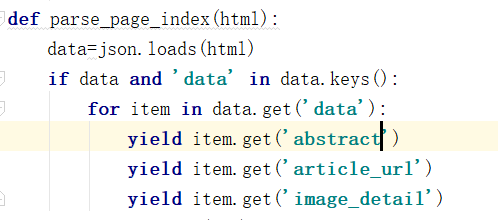

return None def parse_page_index(html): #解析首页获得的html

data = json.loads(html)

if data and 'data' in data.keys():

for item in data.get('data'):

yield item.get('article_url') def get_page_detalil(url): #请求详情页面html

headers = {'user-agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36'} try:

response = requests.get(url,headers = headers)

if response.status_code == 200:

return response.text

return None

except Exception:

print('请求详情页出错',url)

return None def parse_page_detail(html,url): #解析每个详情页内容

soup = BeautifulSoup(html,'lxml')

title = soup.select('title')[0].get_text()

image_pattern = re.compile('gallery: JSON.parse\("(.*)"\)',re.S)

result = re.search(image_pattern,html)

if result:

try:

data = json.loads(result.group(1).replace('\\',''))

if data and 'sub_images' in data.keys():

sub_images = data.get("sub_images")

images = [item.get('url') for item in sub_images]

for image in images:download_image(image)

return {

'title':title,

'url':url,

'images':images

}

except JSONDecodeError:

pass def save_to_mongo(result): #把信息存储导Mongodb

try:

if db[MONOGO_TABLE].insert(result):

print('存储成功',result)

return False

return True

except TypeError:

pass def download_image(url): #查看图片链接是否正常获取

headers = {

'user-agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36'}

print('正在下载:',url)

try:

response = requests.get(url, headers=headers)

if response.status_code == 200:

save_image(response.content)

return None

except ConnectionError:

print('请求图片出错', url)

return None def save_image(content): #下载图片到指定位置 #file_path = '{}/{}.{}'.format(os.getcwd(),md5(content).hexdigest(),'jpg')

file_path = '{}/{}.{}'.format('/Users/darwin/Desktop/aaa',md5(content).hexdigest(),'jpg')

if not os.path.exists(file_path):

with open(file_path,'wb') as f:

f.write(content)

f.close() def main(offset):

html = get_page_index(offset,KEYWORD)

for url in parse_page_index(html):

html = get_page_detalil(url)

if html:

result = parse_page_detail(html,url)

save_to_mongo(result) if __name__ == '__main__':

groups = [x*20 for x in range(GROUP_START,GROUP_END+1)]

pool = Pool() pool.map(main,groups)config配置页

MONOGO_URL='localhost'

MONOGO_DB = 'toutiao'

MONOGO_TABLE = 'toutiao' GROUP_START=1

GROUP_END=2 KEYWORD='街拍'

PYTHON 爬虫笔记九:利用Ajax+正则表达式+BeautifulSoup爬取今日头条街拍图集(实战项目二)的更多相关文章

- 15-分析Ajax请求并抓取今日头条街拍美图

流程框架: 抓取索引页内容:利用requests请求目标站点,得到索引网页HTML代码,返回结果. 抓取详情页内容:解析返回结果,得到详情页的链接,并进一步抓取详情页的信息. 下载图片与保存数据库:将 ...

- Python 爬虫爬取今日头条街拍上的图片

# 今日头条--街拍 import requests from urllib.parse import urlencode import os from hashlib import md5 from ...

- 爬虫七之分析Ajax请求并爬取今日头条

爬取今日头条图片 这里只讨论出现的一些问题,代码在最下面github链接里. 首先,今日头条取消了"图集"这一选项,因此对于爬虫来说效率降低了很多: 在所有代码都完成后,也许是爬取 ...

- 分析 ajax 请求并抓取今日头条街拍美图

首先分析街拍图集的网页请求头部: 在 preview 选项卡我们可以找到 json 文件,分析 data 选项,找到我们要找到的图集地址 article_url: 选中其中一张图片,分析 json 请 ...

- 【Python爬虫案例学习】分析Ajax请求并抓取今日头条街拍图片

1.抓取索引页内容 利用requests请求目标站点,得到索引网页HTML代码,返回结果. from urllib.parse import urlencode from requests.excep ...

- Python爬虫系列-分析Ajax请求并抓取今日头条街拍图片

1.抓取索引页内容 利用requests请求目标站点,得到索引网页HTML代码,返回结果. 2.抓取详情页内容 解析返回结果,得到详情页的链接,并进一步抓取详情页的信息. 3.下载图片与保存数据库 将 ...

- 【Python3网络爬虫开发实战】6.4-分析Ajax爬取今日头条街拍美图【华为云技术分享】

[摘要] 本节中,我们以今日头条为例来尝试通过分析Ajax请求来抓取网页数据的方法.这次要抓取的目标是今日头条的街拍美图,抓取完成之后,将每组图片分文件夹下载到本地并保存下来. 1. 准备工作 在本节 ...

- 【Python3网络爬虫开发实战】 分析Ajax爬取今日头条街拍美图

前言本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理.作者:haoxuan10 本节中,我们以今日头条为例来尝试通过分析Ajax请求 ...

- 转:【Python3网络爬虫开发实战】6.4-分析Ajax爬取今日头条街拍美图

[摘要] 本节中,我们以今日头条为例来尝试通过分析Ajax请求来抓取网页数据的方法.这次要抓取的目标是今日头条的街拍美图,抓取完成之后,将每组图片分文件夹下载到本地并保存下来. 1. 准备工作 在本节 ...

随机推荐

- JavaScript中给二维数组动态添加元素的质朴方法

var myData = new Array(); for(var i=0;i<tableDatas.length;i++){ var arr=tableDatas[i]; ...... /// ...

- [转载]UDP丢包率提升

UDP丢包及无序问题 转载自:http://hi.baidu.com/gamedot/item/96cb9bf1a717eb14d6ff8cd5 最近在做一个项目,在这之前,做了个验证程序. 发现客户 ...

- 转:十六进制颜色与RGB颜色对照表

http://www.vis.cc/html/ppyj/zscs/1090.html 十六进制颜色查询 颜 色 英文代码 形象描述 十六进制 RGB LightPink 浅粉红 #FFB6C1 255 ...

- vs调试,监控变量

- UVA LIVE-4642 - Malfatti Circles

给出三角形三个顶点,求出三个互切的圆的半径 尽管大白鼠说能够推出公式,但是这个公式仅仅怕没那么easy推--我左看右看上看下看也推不出. 应该是要做辅助线什么的,那也-- 因为非常easy就推出了关于 ...

- 王立平--android out of memory(OOM)产生原因

开发图片视频应用常遇到这个错误. android 内存由 dalvik 和 native 2部分组成.dalvik 也就是 java 堆,创建的对象就是在这里分配的, 而 native 是通过 c/c ...

- Spring 小记

本作品由Man_华创作,采用知识共享署名-非商业性使用-相同方式共享 4.0 国际许可协议进行许可.基于http://www.cnblogs.com/manhua/上的作品创作. 使用STS新建spr ...

- Oracle 修改带数据的字段类型

http://www.cnblogs.com/LDaqiang/articles/1157998.html由于需求变动,现要将一个类型NUMBER(8,2)的字段类型改为 char.大体思路如下: ...

- (四)DOM对象和jQuery对象

学习jQuery,需要搞清楚DOM对象和jQuery对象的关系与区别,因为两者的方法并不共用,如果搞不清楚对象类型就会导致调用错误的方法. DOM(Document Object Model)称为文档 ...

- 利用DataSet部分功能实现网站登录

using System; using System.Collections.Generic; using System.Linq; using System.Web; using System.We ...