python爬虫(八) requests库之 get请求

requests库比urllib库更加方便,包含了很多功能。

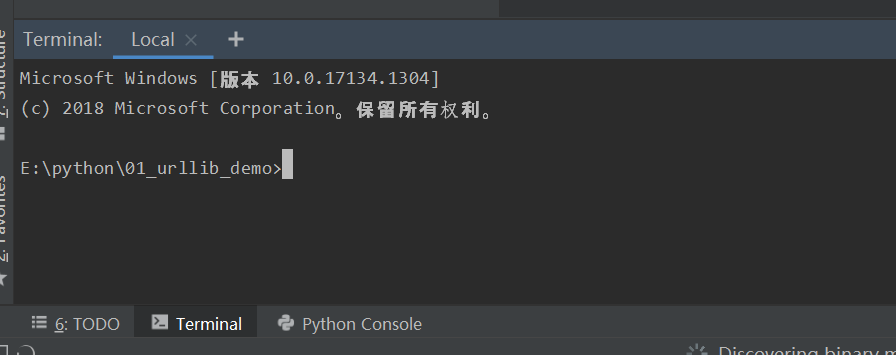

1、在使用之前需要先安装pip,在pycharm中打开:

写入pip install requests命令,即可下载

在github中有关于requests库的介绍,网址:https://github.com/requests/requests

2、Get请求

response=requests.get("https://www.baidu.com/")

我们要完成在百度的页面获取中国的相关信息,相当于

输入中国:

用爬虫代码实验实现:

import requests # wd是在网址中后面的一段

params={

'wd':'中国'

} headers={

'User-Agent':"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36"

}

# 这时我们要在这个网址中加入S

response=requests.get("http://www.baidu.com/s",params=params,headers=headers) with open('baidu.html','w',encoding='utf-8') as fp:

fp.write(response.content.decode('utf-8'))

打开后就是中国的相关信息:

3、response.txt和response.content的区别

response.txt是 requests是经response.content解码的字符串,requests会根据自己的猜测来进行解码,有时候会猜测错误,导致乱码。

response.content是直接从网上爬取的数据,没有经过经过任何解码,是bytes类型。

所以最常用的就是:response.content.decode('utf-8')

python爬虫(八) requests库之 get请求的更多相关文章

- Python爬虫之requests库介绍(一)

一:Requests: 让 HTTP 服务人类 虽然Python的标准库中 urllib2 模块已经包含了平常我们使用的大多数功能,但是它的 API 使用起来让人感觉不太好,而 Requests 自称 ...

- Python爬虫:requests 库详解,cookie操作与实战

原文 第三方库 requests是基于urllib编写的.比urllib库强大,非常适合爬虫的编写. 安装: pip install requests 简单的爬百度首页的例子: response.te ...

- python爬虫之requests库

在python爬虫中,要想获取url的原网页,就要用到众所周知的强大好用的requests库,在2018年python文档年度总结中,requests库使用率排行第一,接下来就开始简单的使用reque ...

- Python爬虫之requests库的使用

requests库 虽然Python的标准库中 urllib模块已经包含了平常我们使用的大多数功能,但是它的 API 使用起来让人感觉不太好,而 Requests宣传是 "HTTP for ...

- 【Python爬虫】Requests库的基本使用

Requests库的基本使用 阅读目录 基本的GET请求 带参数的GET请求 解析Json 获取二进制数据 添加headers 基本的POST请求 response属性 文件上传 获取cookie 会 ...

- python爬虫(1)requests库

在pycharm中安装requests库的一种方法 首先找到设置 搜索然后安装,蓝色代表已经安装 requests库中的get请求 与HTTP协议相对应,requests库也有七种请求方式. 获取ur ...

- python爬虫之requests库介绍(二)

一.requests基于cookie操作 引言:有些时候,我们在使用爬虫程序去爬取一些用户相关信息的数据(爬取张三“人人网”个人主页数据)时,如果使用之前requests模块常规操作时,往往达不到我们 ...

- Python爬虫之Requests库的基本使用

import requests response = requests.get('http://www.baidu.com/') print(type(response)) print(respons ...

- Python爬虫系列-Requests库详解

Requests基于urllib,比urllib更加方便,可以节约我们大量的工作,完全满足HTTP测试需求. 实例引入 import requests response = requests.get( ...

- python 爬虫 基于requests模块的get请求

需求:爬取搜狗首页的页面数据 import requests # 1.指定url url = 'https://www.sogou.com/' # 2.发起get请求:get方法会返回请求成功的响应对 ...

随机推荐

- 【C语言】请输入一个n(n<=10)并输出一个n行n列的杨辉三角

应用二维数组的知识 杨辉三角特点: 1.第一列和对角线的元素全部为1 2.其他元素等于上一行的当前列的值和上一行中当前列前边一列的值之和 #include<stdio.h> #define ...

- 【做题笔记】洛谷P1955[NOI2015]程序自动分析

第一道蓝题祭- 注意到本题中判断的是下标,即,并不是真的判断 \(i\) 是否等于 \(j\) 显然考虑并查集,把所有标记为"相等"的数放在一个集合里,然后最后扫一遍每个数,如果有 ...

- vue 无法热替换/热更新

参考了小伙伴的解决办法: 1.https://blog.csdn.net/win7583362/article/details/65443291 虽然我并不是用对方的方法解决的. 依然还是建议大家打开 ...

- codeforces A. Zoning Restrictions Again

A. Zoning Restrictions Again ou are planning to build housing on a street. There are n spots availab ...

- js实现左右自动滚动

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- springboot10(docker)

一 Docker 1 what's the Docker? Docker是一个开源的应用容器引擎,轻量级容器技术. Docker 可以让开发者打包他们的应用以及依赖包到一个轻量级.可移植的容器 ...

- springboot08(springmvc自动配置原理)

MVC WebMvcAutoConfiguration.java @ConditionalOnMissingBean(name = "viewResolver", value = ...

- 「模板」AC自动机

目录 说明 普通版本 询问更改版 拓扑优化版本 说明 这篇博客只挂模板,具体分析请膜拜大佬 hyfhaha 大佬. 普通版本 题目传送门 #include<cstdio> #include ...

- [LEETCODE] 初级算法/数组 1.1删除排序数组中的重复项

题目: 给定一个排序数组,你需要在原地删除重复出现的元素,使得每个元素只出现一次,返回移除后数组的新长度. 不要使用额外的数组空间,你必须在原地修改输入数组并在使用 O(1) 额外空间的条件下完成. ...

- 自己常用的Linux命令和Hadoop命令

记录自己常用的Linux命令: ss的启动命令:ssserver -c /etc/shadowsocks.json jupyter notebook的启动命令:jupyter notebook --a ...