022 Spark shuffle过程

1.官网

http://spark.apache.org/docs/1.6.1/configuration.html#shuffle-behavior

Spark数据进行重新分区的操作就叫做shuffle过程

2.介绍

SparkStage划分的时候,将最后一个Stage称为ResultStage(ResultTask),其它Stage叫做ShuffleMapStage(ShuffleMapTask)

3.SparkShuffle实现

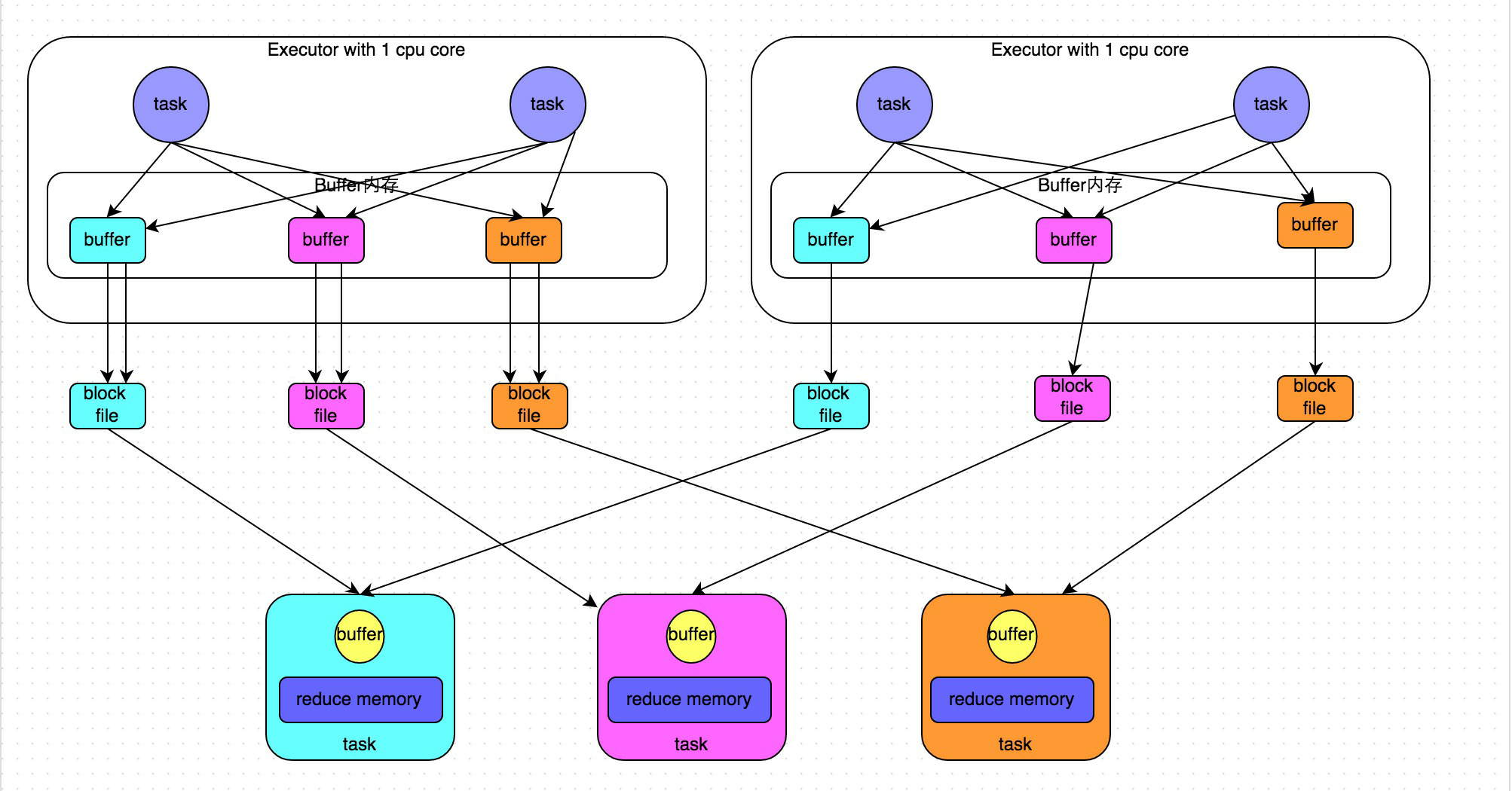

基于ShuffleManager来实现,1.6.1版本中存在两种实现:HashShuffleManager和SortShuffleManager(默认);

由参数spark.shuffle.manager决定(sort or hash)

其中,sort:类似MR的shuffle,如下:

4.hash shuffle

在Spark1.2.x版本之前,只有一个ShuffleManager,就是hash

hash shuffle在以前的版本中存在一个问题:

会产生大量的磁盘问题

优化:

将一个Executor上的所有Task的执行结果合并到一起,减少文件的数量

spark.shuffle.consoldateFiles=true

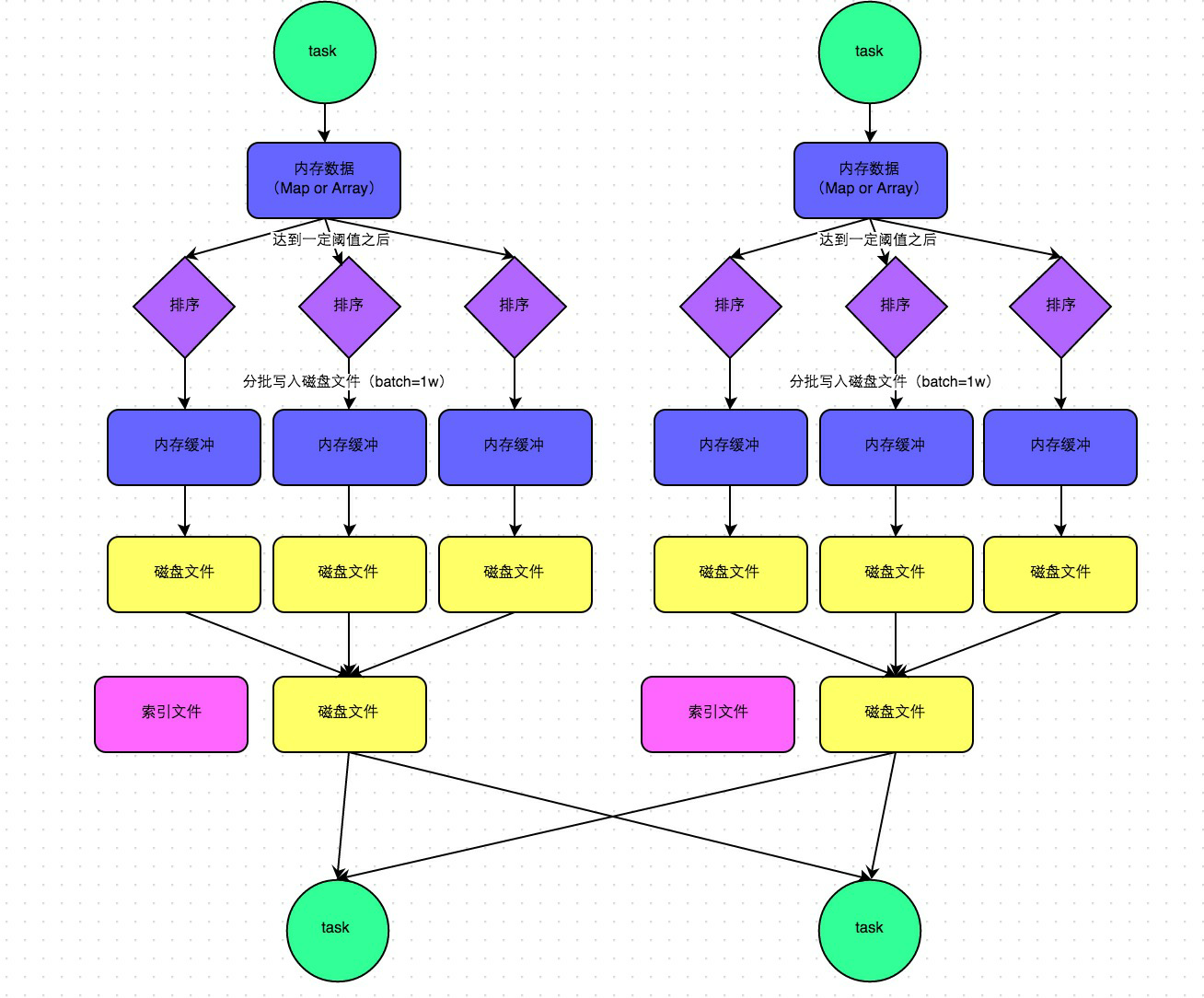

原hash下的原理:

优化原理:

5.sort shuffle

在1.2版本之后,默认是SortManager,就是sort

小问题:所有的情况都进行排序(不管数据量的大小)<通过bypass运行模式可以解决>

两种运行:

普通运行模式:

中间会涉及到sort操作

bypass运行模式:

针对小数据量的情况下,不进行排序,类似于优化后的HashManager(性能没有HashManager<优化后>高)

下面是两个条件,就会走bypass模式,小数据量不排序:

-1. 当RDD的task数量小于spark.shuffle.sort.bypassMergeThreshold(默认200)的时候启用

-2. 不是聚合类shuffle算子(比如:不能是reduceByKey,可以是join)

二:shuffle与依赖的关系

1.说明

在后面补充一下知识点

2.关系

022 Spark shuffle过程的更多相关文章

- Spark Shuffle 过程

本文参考:http://www.cnblogs.com/cenyuhai/p/3826227.html 在数据流动的整个过程中,最复杂最影响性能的环节,就是 Shuffle 过程,本文将参考大神的博客 ...

- 浅析 Spark Shuffle 内存使用

在使用 Spark 进行计算时,我们经常会碰到作业 (Job) Out Of Memory(OOM) 的情况,而且很大一部分情况是发生在 Shuffle 阶段.那么在 Spark Shuffle 中具 ...

- Spark Shuffle数据处理过程与部分调优(源码阅读七)

shuffle...相当重要,为什么咩,因为shuffle的性能优劣直接决定了整个计算引擎的性能和吞吐量.相比于Hadoop的MapReduce,可以看到Spark提供多种计算结果处理方式,对shuf ...

- Spark shuffle详细过程

有许多场景下,我们需要进行跨服务器的数据整合,比如两个表之间,通过Id进行join操作,你必须确保所有具有相同id的数据整合到相同的块文件中.那么我们先说一下mapreduce的shuffle过程. ...

- 彻底搞懂spark的shuffle过程(shuffle write)

什么时候需要 shuffle writer 假如我们有个 spark job 依赖关系如下 我们抽象出来其中的rdd和依赖关系: E <-------n------, ...

- Spark 的 Shuffle过程介绍`

Spark的Shuffle过程介绍 Shuffle Writer Spark丰富了任务类型,有些任务之间数据流转不需要通过Shuffle,但是有些任务之间还是需要通过Shuffle来传递数据,比如wi ...

- 剖析Hadoop和Spark的Shuffle过程差异

一.前言 对于基于MapReduce编程范式的分布式计算来说,本质上而言,就是在计算数据的交.并.差.聚合.排序等过程.而分布式计算分而治之的思想,让每个节点只计算部分数据,也就是只处理一个分片,那么 ...

- 剖析Hadoop和Spark的Shuffle过程差异(一)

一.前言 对于基于MapReduce编程范式的分布式计算来说,本质上而言,就是在计算数据的交.并.差.聚合.排序等过程.而分布式计算分而治之的思想,让每个节点只计算部分数据,也就是只处理一个分片,那么 ...

- Spark的Shuffle过程介绍

Spark的Shuffle过程介绍 Shuffle Writer Spark丰富了任务类型,有些任务之间数据流转不需要通过Shuffle,但是有些任务之间还是需要通过Shuffle来传递数据,比如wi ...

随机推荐

- JavaScript之浏览器兼容问题与IE(神经病一样的浏览器)

IE是最讨厌的浏览器,没有之一.----题记 废话不说,粘上大图~

- [C++]栈区(栈)与堆区(类链表)[转/摘]

一.预备知识—程序的内存分配 一个由C/C++编译的程序占用的内存分为以下几个部分 1.栈区(stack)— 由编译器自动分配释放 ,存放函数的参数值,局部变量的值等.其 操 ...

- tidb 架构 ~Tidb学习系列(5)

一 简介:今天我们继续学习tidb的增量传输 二 说明: tidb高度兼容mysql,可以仿照mysql的主从同步复制机制实现mysql->tidb的增量传输 三 实验: 1 下载tidb官方工 ...

- mysql 原理 ~ double write

一 简介:今天来聊聊double write 二 细节 1 Double write 是InnoDB在 tablespace(ibdata1)上的128个页(2个区)是2MB: 2 何谓页断裂 所谓页 ...

- img格式镜像转ISO格式

在做汇编学习时,需要用比较老的Windows XP来进行调试学习,因此找了最老的Windows XP(CN_WINXP_PRO_ISO,无SP版本 ),下载后发现镜像文件格式是img的,而virtua ...

- Spring 注解<context:annotation-config> 和 <context:component-scan>的作用与区别

<context:annotation-config> 是用于激活那些已经在spring容器里注册过的bean(无论是通过xml的方式还是通过packagesanning的方式)上面的注解 ...

- 解决Ubuntu的root账号无法登录SSH问题-Permission denied, please try again.

http://www.cnblogs.com/yixius/articles/6971054.html

- 配置使用OpenCV静态链接库

配置opencv静态链接库需要用到:staticlib 在配置链接器->附加库目录时应该为staticlib的路径.同理若是利用动态链接库则只需要lib的路径: 动态链接库则使用lib,然而在使 ...

- android camera(一):camera模组CMM介绍【转】

转自:https://blog.csdn.net/kevinx_xu/article/details/8821818 androidcmm图像处理工作手机三星 关键词:android camera ...

- 【转】使用SevenZipSharp压缩、解压文件

引用 下载之后引用“SevenZipSharp.dll”至项目中,然后将“7z.dll”放到bin目录下,或者这样引用:SevenZipCompressor.SetLibraryPath(" ...