11-hdfs-NameNode-HA-wtihQJM解决单点故障问题

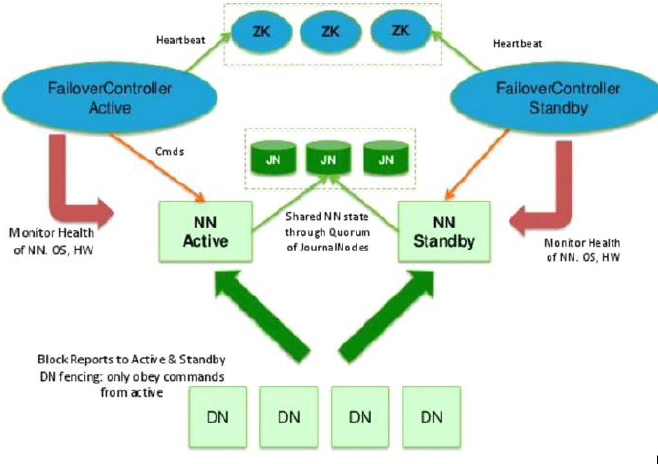

在hdfs中, NN只有一个, 但其中保存的数据尤其重要, 所以需要将元数据保存, 其中源数据有2个形式, fsimage 和 edit文件, 最简单的解决方法就是复制fsimage, 并在文件修改时同时修改 NNActive 和 NNStandby 中的edit, 保存在第三方的QJM中, 所以多个NN除了active接受用户请求外, 无其他区别

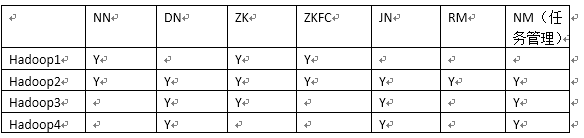

首先是, 集群规划:

可以看到NN是有1和2组成active和standby的, 之前说过NN需要有DNN免密登录的权限, 所以, 两台分别设置其他三台的免密登录

1, 多台NN间切换, 通过zookeeper来实现的

1) 安装zookeeper.3.4.6.tar.gz, 并创建 conf/zoo.cfg文件

tickTime=

dataDir=/var/lib/zookeeper

clientPort=

initLimit=

syncLimit=

server.=192.168.208.106::

server.=192.168.208.107::

server.=192.168.208.108::

2), 创建data目录和log目录(mkdir -p)

3), 在 ${dataDir}/下面 配置节点信息 myid, 跟上面的server.x保持一致

4), 启动, cd /usr/opt/zookeeper3.4.6/bin

zkServer.sh start

5), 链接内存数据库, 通过get 和ls 等命令可查看数据库中的内容

zkCli.sh

zookeeper启动后, 就不要关闭了...

zk启动脚本:

脚本启动不管用的, 把环境变量配置在 ~/.bashrc下, 因为ssh分为登陆和非登陆, 读取配置文件的顺序不同

#!/bin/bash

host=(node2 node3 node4) start() {

for i in ${host[@]}

do

echo start $i

ssh -o StrictHostKeyChecking=no root@$i "/usr/local/zookeeper-3.4.11/bin/zkServer.sh start"

ssh -o StrictHostKeyChecking=no root@$i "jps"

echo start $i done

done

} stop() {

for i in ${host[@]}

do

echo stop $i

ssh -o StrictHostKeyChecking=no root@$i "/usr/local/zookeeper-3.4.11/bin/zkServer.sh stop"

ssh -o StrictHostKeyChecking=no root@$i "jps"

echo stop $i done

done

} case "$1" in start)

start

;; stop)

stop

;; *)

echo "Usage: start|stop"

;; esac

2, 修改hdfs的配置文件

2.1), 删除masters, 不需要SNN了

rm -rf /usr/opt/hadoop-2.5./etc/hadoop

2.2) 删除原集群中的数据文件

rm -rf /opt/hadoop

2.3) hdfs-site.xml

servername, zookeeper 使用

<property>

<name>dfs.nameservices</name>

<value>hdfscluster</value>

</property>

节点协议( 有几个nameNode定义几个)

<property>

<name>dfs.ha.namenodes.hdfscluster</name>

<value>nn1,nn2</value>

</property>

rpc协议( 文件上传下载使用)

<property>

<name>dfs.namenode.rpc-address.hdfscluster.nn1</name>

<value>192.168.208.106:</value>

</property>

<property>

<name>dfs.namenode.rpc-address.hdfscluster.nn2</name>

<value>192.168.208.107:</value>

</property>

http协议

<property>

<name>dfs.namenode.http-address.hdfscluster.nn1</name>

<value>192.168.208.:</value>

</property>

<property>

<name>dfs.namenode.http-address.hdfscluster.nn2</name>

<value>192.168.208.:</value>

</property>

qjm节点, journalNodes节点, 用于缓存edits文件, uri, 分号隔开

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://192.168.208.107:8485;192.168.208.108:8485;192.168.208.109:8485/hdfscluster</value>

</property>

帮助客户端获得activeNameNode

<property>

<name>dfs.client.failover.proxy.provider.hdfscluster</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

远程登陆, 需要ssh密钥文件

<property>

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property> <property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/root/.ssh/id_dsa</value>

</property>

journalNode 数据存放的目录

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/opt/journalNode/data</value>

</property>

2.4) core-site.xml, 修改下入口即可

<property>

<name>fs.defaultFS</name>

<value>hdfs://hdfscluster</value>

</property>

3, 启用自动切换

3.1), hdfs-site.xml

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

3.2), core-site.xml, 更改一个配置即可, hadoop.tmp.dir仍然保留

<property>

<name>ha.zookeeper.quorum</name>

<value>192.168.208.106:,192.168.208.107:,192.168.208.108:</value>

</property>

4, 启动journalNode

hadoop-daemon.sh start journalnode

查看日志检查是否成功启动

停止: hadoop-daemon.sh stop journalnode

lgos/hadoop-root-journalnode-node4.log

5, 格式化其中一个NN

hdfs namenode -format

6, 拷贝fsimage 到另一台 NN上, 或者手动拷贝过去也可以

#启动刚刚格式化的NN

hadoop-daemon.sh start namenode

#在没有格式化的NN上执行

hdfs namenode -bootstrapStandby

#启动第二个NN

hadoop-daemon.sh start namenode

7, 初始化zookeeper, 在active的NN上执行

hdfs zkfc -formatZK

8, 启动

start-dfs.sh

排错时, 可用jps命令查看集群端口号, 然后kill -9, 或者 killall java

ps: 记得上个博客的配置, slaves等

以后启动时, 先启动3台zookeeper, 然后 start-dfs.sh 即可以了

非常坑, 因为私钥文件root前面没有加 / 表明根目录, 卡了一个小时!!!!

系列来自尚学堂

11-hdfs-NameNode-HA-wtihQJM解决单点故障问题的更多相关文章

- HDFS NameNode HA 部署文档

简介: HDFS High Availability Using the Quorum Journal Manager Hadoop 2.x 中,HDFS 组件有三个角色:NameNode.DataN ...

- Apache hadoop namenode ha和yarn ha ---HDFS高可用性

HDFS高可用性Hadoop HDFS 的两大问题:NameNode单点:虽然有StandbyNameNode,但是冷备方案,达不到高可用--阶段性的合并edits和fsimage,以缩短集群启动的时 ...

- HDFS namenode 高可用(HA)搭建指南 QJM方式 ——本质是多个namenode选举master,用paxos实现一致性

一.HDFS的高可用性 1.概述 本指南提供了一个HDFS的高可用性(HA)功能的概述,以及如何配置和管理HDFS高可用性(HA)集群.本文档假定读者具有对HDFS集群的组件和节点类型具有一定理解.有 ...

- HDFS的HA(高可用)

HDFS的HA(高可用) 概述 (1)实现高可用最关键的策略是[消除单点故障].HA 严格来说应该分成各个组件的 HA 机制:HDFS 的 HA 和 YARN 的 HA. (2)Hadoop2.0 之 ...

- hadoop2—namenode—HA原理详解

在hadoop1中NameNode存在一个单点故障问题,也就是说如果NameNode所在的机器发生故障,那么整个集群就将不可用(hadoop1中有个SecorndaryNameNode,但是它并不是N ...

- CDH4.1基于Quorum-based Journaling的NameNode HA

几个星期前, Cloudera发布了CDH 4.1最新的更新版本,这是第一个真正意义上的独立高可用性HDFS NameNode的hadoop版本,不依赖于特殊的硬件或外部软件.这篇文章从开发者的角度来 ...

- Hadoop2.0 Namenode HA实现方案

Hadoop2.0 Namenode HA实现方案介绍及汇总 基于社区最新release的Hadoop2.2.0版本,调研了hadoop HA方面的内容.hadoop2.0主要的新特性(Hadoop2 ...

- Hadoop2之NameNode HA详解

在Hadoop1中NameNode存在一个单点故障问题,如果NameNode所在的机器发生故障,整个集群就将不可用(Hadoop1中虽然有个SecorndaryNameNode,但是它并不是NameN ...

- 通过tarball形式安装HBASE Cluster(CDH5.0.2)——Hadoop NameNode HA 切换引起的Hbase错误,以及Hbase如何基于NameNode的HA进行配置

通过tarball形式安装HBASE Cluster(CDH5.0.2)——Hadoop NameNode HA 切换引起的Hbase错误,以及Hbase如何基于NameNode的HA进行配置 配置H ...

随机推荐

- 给ubuntu系统的root设置密码:

首先输入:sudo passwd root 然后输入当前用户的密码,例如xiaomeige这个用户的密码为xiaomeige 然后输入希望给root账户设置的密码,例如密码也为root

- codevs 1160

这道题还是和蛇形填数有关,因为要不停的去转圈圈去判断是否到了最中间的那个位置,所以用到了递归的思想. #include<stdio.h> int n,a[100][100]; void r ...

- 深入理解BS结构应用程序

随着学习的深入,和编程经验的丰富,对BS应用程序有一些认识. 在一些讨论软件技术的QQ群里,或一些社区.BBS中,经常会有一些初学者会犯一些认知性的错误.比如经常会有一些朋友提这样的一些问题:“我怎么 ...

- C# Timer类

C# 有三种不同的Timer类 1.Threading.Timer 2.Timer.Timer 3.Forms.Timer using System; using System.Collections ...

- 与数据库连接的页面增删改查 的easyui实现(主要是前端实现)

一.首先看一下最终实现的效果,上图 二.思路,主要是分两个文件实现,一个是页面显示文件:代码如下: <html> <head> <title>示例管理</ti ...

- 【Win2D】【译】Win2D 快速入门

原文链接:http://microsoft.github.io/Win2D/html/QuickStart.htm 快速入门 这是 Win2D 的快速入门教程,将会介绍 Win2D 中的基本功能.你将 ...

- Python学习-32.Python中os模块的一些方法

首先肯定是要引入os模块了. import os getcwd方法: print(os.getcwd()) 上面的语句将会输出当前的工作目录,相当于C#中的Environment.CurrentDir ...

- Metronic-最优秀的基于Bootstrap的响应式网站模版

在所有我看到过的基于Bootstrap的网站模版中,Metronic是我认为最优秀的,其外观之友好.功能之全面让人惊叹.Metronic 是一个自适应的HTML模版,提供后台管理模版和前端内容网页模版 ...

- leetcode 最后一个单词的长度

给定一个仅包含大小写字母和空格 ' ' 的字符串,返回其最后一个单词的长度. 如果不存在最后一个单词,请返回 0 . 说明:一个单词是指由字母组成,但不包含任何空格的字符串. 示例: 输入: &quo ...

- python寻找list中最大值、最小值并返回其所在位置

c = [-10,-5,0,5,3,10,15,-20,25] print c.index(min(c)) # 返回最小值 print c.index(max(c)) # 返回最大值