(原)torch和caffe中的BatchNorm层

转载请注明出处:

http://www.cnblogs.com/darkknightzh/p/6015990.html

BatchNorm具体网上搜索。

caffe中batchNorm层是通过BatchNorm+Scale实现的,但是默认没有bias。torch中的BatchNorm层使用函数SpatialBatchNormalization实现,该函数中有weight和bias。

如下代码:

local net = nn.Sequential()

net:add(nn.SpatialBatchNormalization())

net:add(nn.SpatialBatchNormalization(, 1e-5, 0.1, false))

print(net.modules)

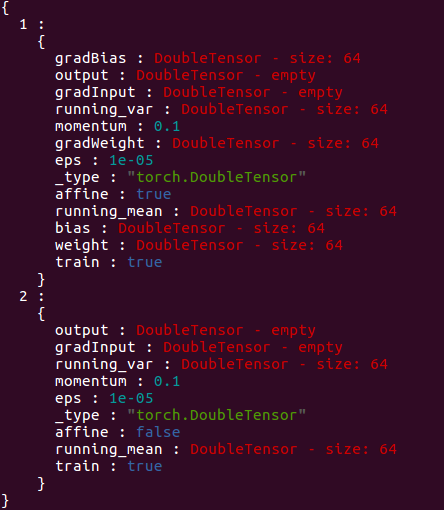

输出如下:

其中第一个为nn.SpatialBatchNormalization(64),第二个为nn.SpatialBatchNormalization(64, 1e-5, 0.1, false)。

SpatialBatchNormalization 参数如下:

nn.SpatialBatchNormalization(N [,eps] [, momentum] [,affine])

默认情况下,eps=1e-5,momentum =0.1,affine=true。因而若要和caffe中的BatchNorm一样,均没有weight和bias,则需要将affine设置为false。若affine为默认值,有如下两种方法可以使torch和caffe参数一致(不太确定):

1. 手动将bias设置为0,此时能和caffe中BatchNorm+Scale(默认的)一样。

2. caffe中ScaleParameter的bias_term(equivalent to a ScaleLayer+BiasLayer)设置为true(该值默认为false)。

========================================================================

161110更新(可能有不对的地方):

对于Caffe:

在使用BatchNorm时,Batch层共3个参数,1个存储均值向量,一个存储方差向量,第三个存储缩放的值。最终的均值向量=均值向量/缩放;最终的方差向量=方差向量/缩放。

Scale层共2个参数,一个存储的是γ向量,一个存储的是β向量。

假设caffe中BatchNorm层输入为1(batch size)*64(channel)*128(height)*128(width)(输出和输入一样),则BatchNorm层共3个参数:mean(64维的向量),variance(64维的向量),scalefactor(1维的向量)。其中mean存储了每一channel的均值,variance存储了每一channel的方差,scalefactor看着caffe的参数,好像都是999.982361(没有过多测试,不太确定)。

在TEST阶段,当输入一个数,如0.001932,对应的mean= -5122.504395,variance=385844.062500,scale= 999.982361时,

缩放后的mean:-5122.504395/999.982361=-5.1225947524488384450613324368429

缩放后的variance:385844.062500/999.982361=385.85086852346988548531007538442

标准差:(385.85086852346988548531007538442+1e(-5))^0.5=

19.643087296132191385983152758013

缩放后的值:

(0.001932-(-5.1225947524488384450613324368429))/ 19.643087296132191385983152758013= 0.26088194158042966422836995726056

实际上得到的为0.260882。在精度范围内一致。

总结起来就是,对每个维度使用对应的均值和方差。不同batch使用对应的参数。

在TRAIN阶段,则是首先计算每个batch不同channel的均值及方差,而后通过论文中公式得到对应的输出。

${{\hat{x_i}}}=\frac{{{x}_{i}}-{{\mu }_{B}}}{\sqrt{\sigma _{B}^{2}+\varepsilon }}$

$E\left[ x \right]={{E}_{B}}\left[ {{\mu }_{B}} \right]$

$Var\left[ x \right]=\frac{m}{m-1}{{E}_{B}}\left[ \sigma _{B}^{2} \right]$

实际中感觉caffe中,即便在训练阶段,依旧使用上面的var来计算方差。

caffe中scale层,得到的scale_param包括weight和bias,均为channel维的向量(如64)。之后对于输入,通过下式计算输出。注意的是,不同channel使用各自的weight和bias,同一个channel的weight和bias都一样。

${{y}_{i}}=\gamma {{\hat{x_i}}}+\beta $

对于torch:

torch中SpatialBatchNormalization是跟在conv层之后,其输入为4D数据(应该是batch_size*channel*height*width),另一个BatchNormalization层是跟在一般的层后面(这样说不太准确吧),其输入为2D数据(应该是batch_size*channel)。SpatialBatchNormalization继承自BatchNormalization。

SpatialBatchNormalization和BatchNormalization的第一个参数N代表特征的维数(channel)。

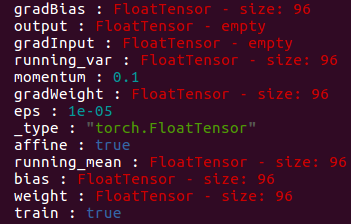

当affine=true时,SpatialBatchNormalization中结构:

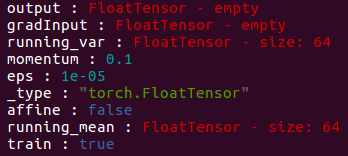

当affine=false时,SpatialBatchNormalization中结构:

当net:evaluate()时,上两图中最后一个参数train为false。

其中,running_mean存储的是特征的mean(对应于caffe中最终的均指向量),running_var存储的是特征的方差(对应于caffe中最终的方差向量)。weight存储的是缩放时特征的γ,bias存储的是缩放时特征的β。

BatchNorm的论文为:Batch Normalization Accelerating Deep Network Training by Reducing Internal Covariate Shift。

161110更新结束

161121更新

今天使用cudnn的BatchNormalization时,提示Only CUDA tensors are supported for cudnn.BatchNormalization,而后程序崩溃。网上搜索了一下,https://github.com/soumith/cudnn.torch/issues/219遇到了类似的问题。具体原因可能不太一样吧。我这边是使用BatchNormalization(或者SpatialBatchNormalization)的问题。该层affine=true时,会使用仿射(有weight和bias),affine=false时,无weight和bias。而cudnn实际上只支持affine=true的情况(目前是这样),我这边程序有affine=false的时候,此时使用cudnn的BatchNormalization(SpatialBatchNormalization继承自BatchNormalization,下面不在说明SpatialBatchNormalization)就会直接assert错误了。

cudnn的BatchNormalization的部分初始化代码如下(位置:/home/XXX/torch/install/share/lua/5.1/cudnn/BatchNormalization.lua):

function BatchNormalization:__init(nFeature, eps, momentum, affine)

parent.__init(self)

assert(nFeature and type(nFeature) == 'number',

'Missing argument #1: Number of feature planes. ')

assert(nFeature ~= , 'To set affine=false call BatchNormalization'

.. '(nFeature, eps, momentum, false) ')

assert(affine == true or affine == nil, 'only affine supported')

实际上assert错误的地方是下面代码的最后一行:

function BatchNormalization:createIODescriptors(input)

assert(input:dim() == self.nDim)

assert(torch.typename(self.weight) == 'torch.CudaTensor' and torch.typename(self.bias) == 'torch.CudaTensor',

'Only CUDA tensors are supported for cudnn.BatchNormalization!')

从初始化代码可以看出,cudnn的BatchNormalization只支持affine=true的情况。

该网页也提供了解决方法:byronwwang在第5层的回复中注释的代码就是解决方法。在使用cudnn.convert时,可以通过第三个参数,不转换某些层。https://github.com/soumith/cudnn.torch里面也给出了不转换层时的代码(Conversion between cudnn and nn这部分):

cudnn.convert(net, cudnn, function(module)

return torch.type(module):find('BatchNormalization')

end)

此时BatchNormalization会使用nn模块中的BatchNormalization。

161121更新结束

========================================================================

(原)torch和caffe中的BatchNorm层的更多相关文章

- caffe中的BatchNorm层

在训练一个小的分类网络时,发现加上BatchNorm层之后的检索效果相对于之前,效果会有提升,因此将该网络结构记录在这里,供以后查阅使用: 添加该层之前: layer { name: "co ...

- caffe 中 python 数据层

caffe中大多数层用C++写成. 但是对于自己数据的输入要写对应的输入层,比如你要去图像中的一部分,不能用LMDB,或者你的label 需要特殊的标记. 这时候就需要用python 写一个输入层. ...

- caffe中全卷积层和全连接层训练参数如何确定

今天来仔细讲一下卷基层和全连接层训练参数个数如何确定的问题.我们以Mnist为例,首先贴出网络配置文件: name: "LeNet" layer { name: "mni ...

- caffe中添加local层

下载caffe-local,解压缩; 修改makefile.config:我是将cuudn注释掉,去掉cpu_only的注释; make all make test(其中local_test出错,将文 ...

- 转载:caffe中的Reshape层

http://blog.csdn.net/terrenceyuu/article/details/76228317 #作用:在不改变数据的情况下,改变输入的维度 layer { name: " ...

- 深度学习中 batchnorm 层是咋回事?

作者:Double_V_ 来源:CSDN 原文:https://blog.csdn.net/qq_25737169/article/details/79048516 版权声明:本文为博主原创文章,转载 ...

- caffe中各层的作用:

关于caffe中的solver: cafffe中的sover的方法都有: Stochastic Gradient Descent (type: "SGD"), AdaDelta ( ...

- caffe中ConvolutionLayer的前向和反向传播解析及源码阅读

一.前向传播 在caffe中,卷积层做卷积的过程被转化成了由卷积核的参数组成的权重矩阵weights(简记为W)和feature map中的元素组成的输入矩阵(简记为Cin)的矩阵乘积W * Cin. ...

- caffe中batch norm源码阅读

1. batch norm 输入batch norm层的数据为[N, C, H, W], 该层计算得到均值为C个,方差为C个,输出数据为[N, C, H, W]. <1> 形象点说,均值的 ...

随机推荐

- destoon实现调用当前栏目分类及子分类和三级分类的方法

调用当前栏目分类及子分类和三级分类是程序设计里常用的方法,本文就来详细讲述destoon实现调用当前栏目分类及子分类和三级分类的方法.具体操作如下: 在destoon中提供了如下的调用语句: 一级分类 ...

- C 语言字符 和字符串输出

int main(void){ char ch; char str[80]; printf("Input a string: "); //先输入字符串 gets(str);/ ...

- 【Beta】Phylab2.0: Postmortem

设想和目标 1. 我们的软件要解决什么问题?是否定义得很清楚?是否对典型用户和典型场景有清晰的描述? 主要解决同学们写物理实验报告时,处理数据的困难--巨大的计算量和不规范的物理报告数据处理格式.典型 ...

- KEIL的混合编程操作

http://hi.baidu.com/txz01/item/21ad9d75913a7b28d7a89c12 这一篇来讲讲混合编程的问题,在网上找了一下,讲混合编程的文件章也有不少,但进行实例操作讲 ...

- FILTER 哪里没展开改哪里

SELECT * FROM F_PTY_INDIV_TMP O WHERE EXISTS (SELECT 1 FROM F_PTY_INDIV F WHERE O.PTY_ID = F.PTY_ID ...

- Linux企业级项目实践之网络爬虫(11)——处理http请求头

http请求头,HTTP客户程序(例如浏览器),向服务器发送请求的时候必须指明请求类型(一般是GET或者POST).如有必要,客户程序还可以选择发送其他的请求头.HTTP客户程序(例如浏览器),向服务 ...

- FROM CSDN TO CNBLOGS

做出了一个愉快的决定,以后会将博客从CSDN迁移到CNBLOGS 旧地址:http://blog.csdn.net/fifa0329,文章并不多 原因如下: 我再次出现了该博客违反了网站规则被关闭的问 ...

- java 内存区域中的栈

有人说栈区存放引用,这种说法并不准确. public void Method1() { int i = 4; int y = 2; class1 cls1 = new class1(); } java ...

- 支持多文件上传,预览,拖拽,基于bootstra的上传插件fileinput 的ajax异步上传

首先需要导入一些js和css文件 <link href="__PUBLIC__/CSS/bootstrap.css" rel="stylesheet"&g ...

- awk实践积累

#cat iii |awk '{max=$2;min=$2;for (i=2;i<=NF;i++) if ($i>max) max=$i fi} {for (i=2;i<=NF;i+ ...