解决项目迁移至Kubernetes集群中的代理问题

解决项目迁移至Kubernetes集群中的代理问题

随着Kubernetes技术的日益成熟,越来越多的企业选择用Kubernetes集群来管理项目。新项目还好,可以选择合适的集群规模从零开始构建项目;旧项目迁移进Kubernetes集群就需要考虑很多因素,毕竟项目不能中断时间过久。

问题来源

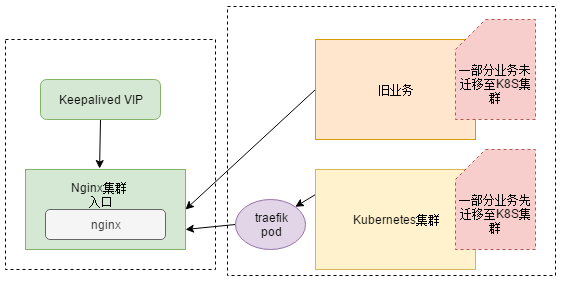

近日在做项目迁移至Kubernetes集群时,遇到了一件有意思的问题:因为开发用的dubbo版本过低,在zookeeper注册不上,需要开发升级dobbo,然后在打包成镜像,所以要先把nodejs迁移进Kubernets集群。因为是部分业务迁移进Kubernets集群,所以要在traefik 前面还得加一层代理Nginx(Nginx为旧业务的入口,反向代理后面的微服务,阿里云的slb指向nginx,等到业务全部迁移完毕,slb就指向traefik)。此种架构为双层代理,即Slb-->Nginx-->Traefik-->Service 。

图解

解决方案:

- 迁移至k8s集群的业务走Nodeport,Nginx --> Nodeport。业务应用直接Nodeport,不好管理,1万台机器的时候 不能也Nodeport吧,端口自己要规划,机器多了 每个机器还都暴露端口,想想都不现实

- 迁移至k8s集群的业务走Clusterip,Nginx --> Traefik --> Service。这种方式合理。

解决问题

总不能拿生产环境来写博文吧,用虚机讲明。其实把虚机和生产机也就网络环境存在差别。

思路分析

- 部署k8s集群

- 部署nginx

- 部署traefik

- 部署应用

- 联调联试

部署k8s集群

使用我之前的博文部署方法:https://www.cnblogs.com/zisefeizhu/p/12505117.html

部署nginx

下载必要的组件

# hostname -I

20.0.0.101

# cat /etc/redhat-release

CentOS Linux release 7.6.1810 (Core)

# uname -a

Linux fuxi-node02-101 4.4.186-1.el7.elrepo.x86_64 #1 SMP Sun Jul 21 04:06:52 EDT 2019 x86_64 x86_64 x86_64 GNU/Linux

# wget http://nginx.org/download/nginx-1.10.2.tar.gz

# wget http://www.openssl.org/source/openssl-fips-2.0.10.tar.gz

# wget http://zlib.net/zlib-1.2.11.tar.gz

# wget https://ftp.pcre.org/pub/pcre/pcre-8.40.tar.gz

# yum install gcc-c++

配置-编译-安装软件

# tar zxvf openssl-fips-2.0.10.tar.gz

# cd openssl-fips-2.0.10/

# ./config && make && make install

# cd ..

# ll

tar zxvf pcre-8.40.tar.gz

# cd pcre-8.40/

# ./configure && make && make install

# tar zxvf zlib-1.2.11.tar.gz

# cd zlib-1.2.11/

# ./configure && make && make install

# tar zxvf nginx-1.10.2.tar.gz

# cd nginx-1.10.2/

#./configure --with-http_stub_status_module --prefix=/opt/nginx

# make && make install

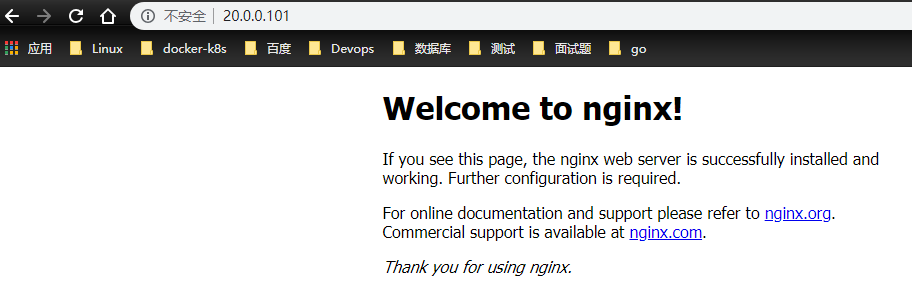

启动Nginx

# pwd

/opt/nginx

# ll

总用量 4

drwx------ 2 nobody root 6 4月 22 11:30 client_body_temp

drwxr-xr-x 2 root root 4096 4月 22 12:53 conf

drwx------ 2 nobody root 6 4月 22 11:30 fastcgi_temp

drwxr-xr-x 2 root root 40 4月 22 11:29 html

drwxr-xr-x 2 root root 41 4月 22 14:24 logs

drwx------ 2 nobody root 6 4月 22 11:30 proxy_temp

drwxr-xr-x 2 root root 19 4月 22 11:29 sbin

drwx------ 2 nobody root 6 4月 22 11:30 scgi_temp

drwx------ 2 nobody root 6 4月 22 11:30 uwsgi_temp

# sbin/nginx

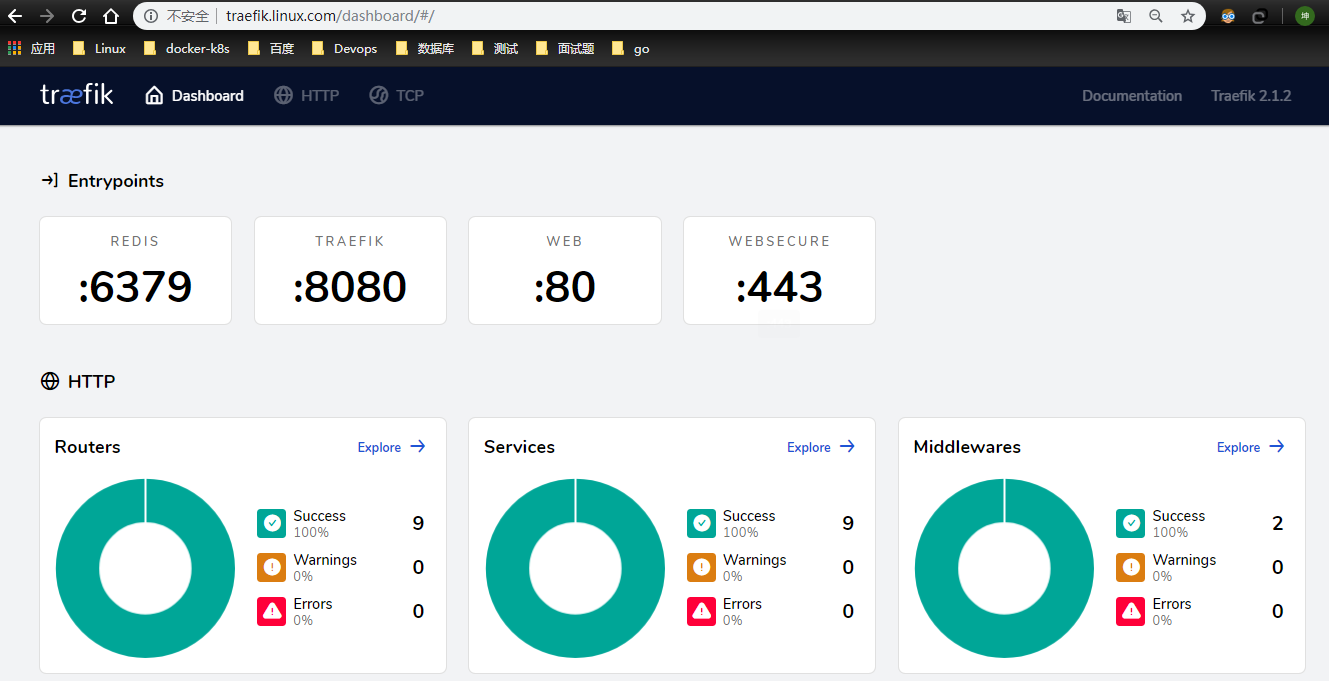

traefik 部署

https://www.cnblogs.com/zisefeizhu/p/12692979.html

环境检查

# kubectl get pods,svc -A | grep traefik

kube-system pod/traefik-ingress-controller-z5qd7 1/1 Running 0 136m

kube-system service/traefik ClusterIP 10.68.251.132 <none> 80/TCP,443/TCP,8080/TCP 4h14m

浏览器访问

部署应用

这里的测试应用选择containous/whoami镜像

测试应用部署

# cat whoami.yaml

##########################################################################

#Author: zisefeizhu

#QQ: 2********0

#Date: 2020-04-22

#FileName: whoami.yaml

#URL: https://www.cnblogs.com/zisefeizhu/

#Description: The test script

#Copyright (C): 2020 All rights reserved

###########################################################################

apiVersion: v1

kind: Service

metadata:

name: whoami

spec:

ports:

- protocol: TCP

name: web

port: 80

selector:

app: whoami

---

kind: Deployment

apiVersion: apps/v1

metadata:

name: whoami

labels:

app: whoami

spec:

replicas: 2

selector:

matchLabels:

app: whoami

template:

metadata:

labels:

app: whoami

spec:

containers:

- name: whoami

image: containous/whoami

ports:

- name: web

containerPort: 80

# kubectl get svc,pod

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/whoami ClusterIP 10.68.109.151 <none> 80/TCP 3h30m

NAME READY STATUS RESTARTS AGE

pod/whoami-bd6b677dc-jvqc2 1/1 Running 0 3h30m

pod/whoami-bd6b677dc-lvcxp 1/1 Running 0 3h30m

联调联试

因为选择的解决问题的方案是:nginx --> traefik --> service

- traefik -->service

- nginx --> traefik

- nginx --> service

traefik --> service

使用traefik 代理测试应用的资源清单:

# cat traefik-whoami.yaml

##########################################################################

#Author: zisefeizhu

#QQ: 2********0

#Date: 2020-04-22

#FileName: traefik-whoami.yaml

#URL: https://www.cnblogs.com/zisefeizhu/

#Description: The test script

#Copyright (C): 2020 All rights reserved

###########################################################################

apiVersion: traefik.containo.us/v1alpha1

kind: IngressRoute

metadata:

name: simpleingressroute

spec:

entryPoints:

- web

routes:

- match: Host(`who.linux.com`) && PathPrefix(`/notls`)

kind: Rule

services:

- name: whoami

port: 80

本地hosts解析

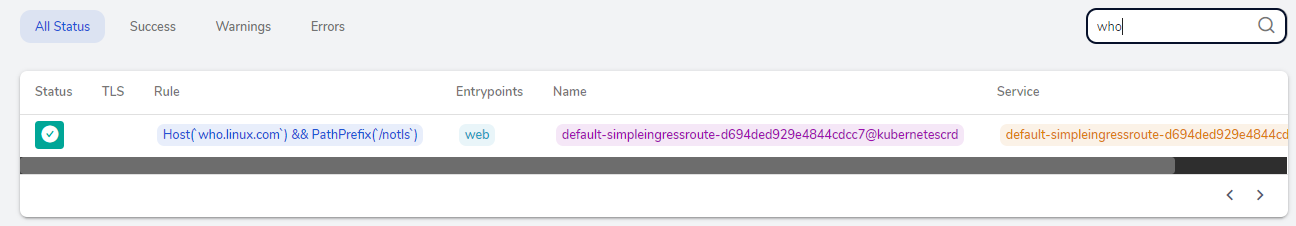

traefik界面观察是代理成功:

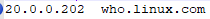

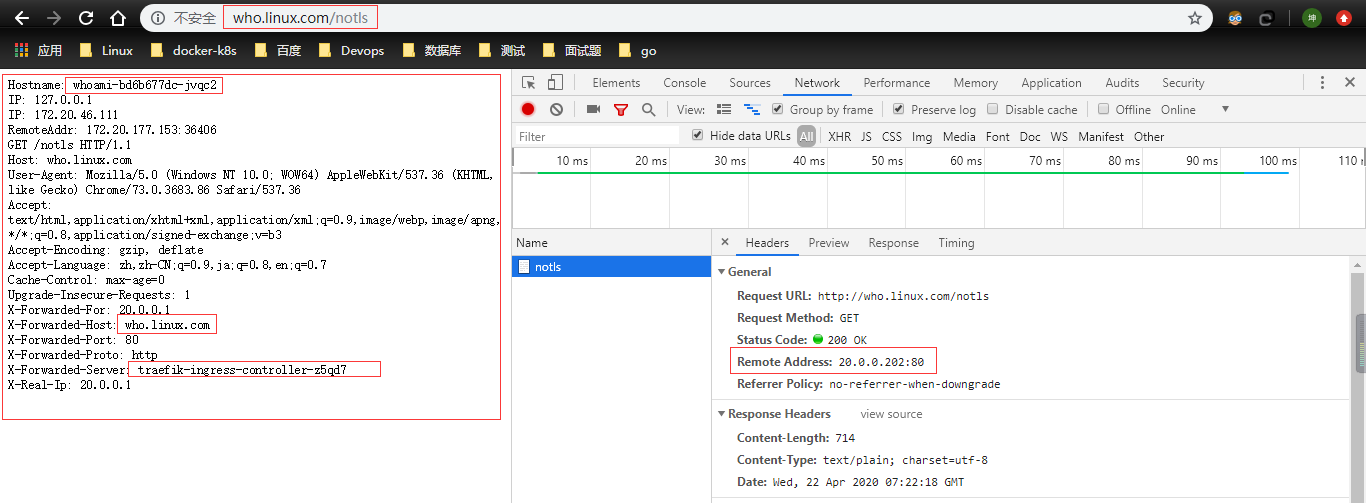

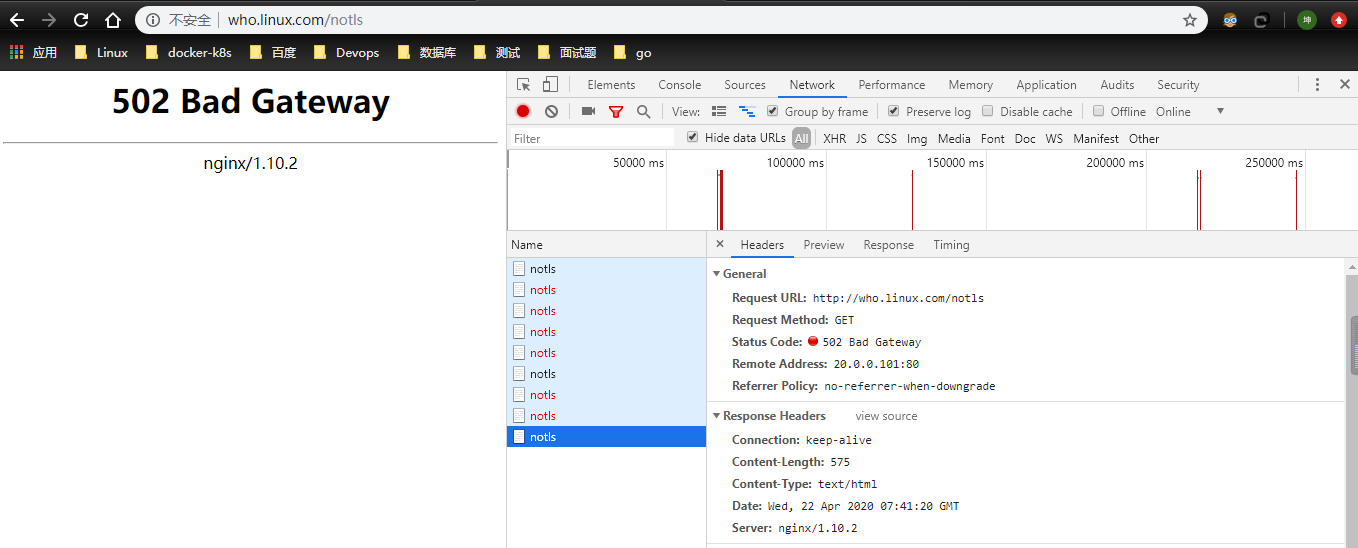

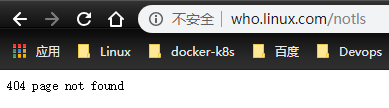

访问who.linux.com/notls

nginx --> traefik

# cat conf/nginx.conf

user nobody;

worker_processes 4;

events {

use epoll;

worker_connections 2048;

}

http {

upstream app {

server 20.0.0.202;

}

server {

listen 80;

# server_name who2.linux.com;

access_log logs/access.log;

error_log logs/error.log;

location / {

proxy_set_header X-Forwarded-For $remote_addr;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header Host $host;

proxy_headers_hash_max_size 51200;

proxy_headers_hash_bucket_size 6400;

proxy_redirect off;

proxy_read_timeout 600;

proxy_connect_timeout 600;

proxy_pass http://app;

}

}

}

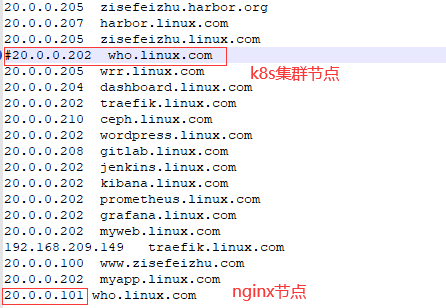

# cat /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

20.0.0.202 who.linux.com //k8s集群traefik所落节点,其实K8s任意节点都随便拉

# curl -iL who.linux.com/notls

HTTP/1.1 200 OK

Content-Length: 388

Content-Type: text/plain; charset=utf-8

Date: Wed, 22 Apr 2020 07:33:52 GMT

Hostname: whoami-bd6b677dc-lvcxp

IP: 127.0.0.1

IP: 172.20.46.67

RemoteAddr: 172.20.177.153:58168

GET /notls HTTP/1.1

Host: who.linux.com

User-Agent: curl/7.29.0

Accept: */*

Accept-Encoding: gzip

X-Forwarded-For: 20.0.0.101

X-Forwarded-Host: who.linux.com

X-Forwarded-Port: 80

X-Forwarded-Proto: http

X-Forwarded-Server: traefik-ingress-controller-z5qd7

X-Real-Ip: 20.0.0.101

nginx要是不熟悉就看这大佬的博文吧:https://www.cnblogs.com/kevingrace/p/6095027.html

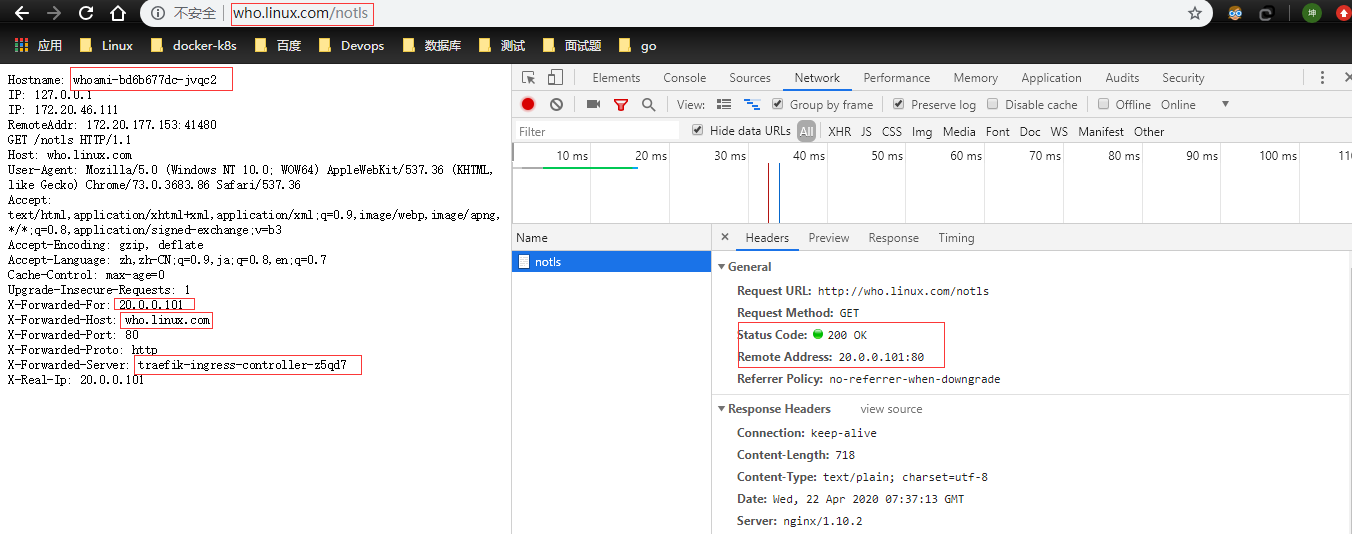

nginx --> service

# cat /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

20.0.0.101 who.linux.com

# curl -iL who.linux.com/notls

HTTP/1.1 200 OK //响应信息

Server: nginx/1.10.2 //响应服务

Date: Wed, 22 Apr 2020 07:27:46 GMT

Content-Type: text/plain; charset=utf-8

Content-Length: 389

Connection: keep-alive

Hostname: whoami-bd6b677dc-jvqc2

IP: 127.0.0.1

IP: 172.20.46.111

RemoteAddr: 172.20.177.153:38298

GET /notls HTTP/1.1

Host: who.linux.com

User-Agent: curl/7.29.0

Accept: */*

Accept-Encoding: gzip

X-Forwarded-For: 20.0.0.101

X-Forwarded-Host: who.linux.com

X-Forwarded-Port: 80

X-Forwarded-Proto: http

X-Forwarded-Server: traefik-ingress-controller-z5qd7

X-Real-Ip: 20.0.0.101

nginx日志

# tail -f access.log

20.0.0.101 - - [22/Apr/2020:15:28:28 +0800] "GET /notls HTTP/1.1" 200 389 "-" "curl/7.29.0"

浏览器测试

继续测试

把traefik应用给关了,然后再测试

# kubectl delete -f .

configmap "traefik-config" deleted

customresourcedefinition.apiextensions.k8s.io "ingressroutes.traefik.containo.us" deleted

customresourcedefinition.apiextensions.k8s.io "ingressroutetcps.traefik.containo.us" deleted

customresourcedefinition.apiextensions.k8s.io "middlewares.traefik.containo.us" deleted

customresourcedefinition.apiextensions.k8s.io "tlsoptions.traefik.containo.us" deleted

customresourcedefinition.apiextensions.k8s.io "traefikservices.traefik.containo.us" deleted

ingressroute.traefik.containo.us "traefik-dashboard-route" deleted

service "traefik" deleted

daemonset.apps "traefik-ingress-controller" deleted

serviceaccount "traefik-ingress-controller" deleted

clusterrole.rbac.authorization.k8s.io "traefik-ingress-controller" deleted

clusterrolebinding.rbac.authorization.k8s.io "traefik-ingress-controller" deleted

# kubectl delete -f traefik-whoami.yaml //关闭whoami traefik代理

ingressroute.traefik.containo.us "simpleingressroute" deleted

没得说了 测试结果很明确了:访问who.linux.com 流量走向:nginx-->traefik --> service 。

解决项目迁移至Kubernetes集群中的代理问题的更多相关文章

- 【转载】浅析从外部访问 Kubernetes 集群中应用的几种方式

一般情况下,Kubernetes 的 Cluster Network 是属于私有网络,只能在 Cluster Network 内部才能访问部署的应用.那么如何才能将 Kubernetes 集群中的应用 ...

- ingress-nginx 的使用 =》 部署在 Kubernetes 集群中的应用暴露给外部的用户使用

文章转载自:https://mp.weixin.qq.com/s?__biz=MzU4MjQ0MTU4Ng==&mid=2247488189&idx=1&sn=8175f067 ...

- 初试 Kubernetes 集群中使用 Traefik 反向代理

初试 Kubernetes 集群中使用 Traefik 反向代理 2017年11月17日 09:47:20 哎_小羊_168 阅读数:12308 版权声明:本文为博主原创文章,未经博主允许不得转 ...

- 在kubernetes集群中创建redis主从多实例

分类 > 正文 在kubernetes集群中创建redis主从多实例 redis-slave镜像制作 redis-master镜像制作 创建kube的配置文件yaml 继续使用上次实验环境 ht ...

- 如何在 Kubernetes 集群中玩转 Fluid + JuiceFS

作者简介: 吕冬冬,云知声超算平台架构师, 负责大规模分布式机器学习平台架构设计与功能研发,负责深度学习算法应用的优化与 AI 模型加速.研究领域包括高性能计算.分布式文件存储.分布式缓存等. 朱唯唯 ...

- 在Kubernetes集群中使用calico做网络驱动的配置方法

参考calico官网:http://docs.projectcalico.org/v2.0/getting-started/kubernetes/installation/hosted/kubeadm ...

- Kubernetes集群中Service的滚动更新

Kubernetes集群中Service的滚动更新 二月 9, 2017 0 条评论 在移动互联网时代,消费者的消费行为已经“全天候化”,为此,商家的业务系统也要保持7×24小时不间断地提供服务以满足 ...

- Kubernetes集群中Jmeter对公司演示的压力测试

6分钟阅读 背景 压力测试是评估Web应用程序性能的有效方法.此外,越来越多的Web应用程序被分解为几个微服务,每个微服务的性能可能会有所不同,因为有些是计算密集型的,而有些是IO密集型的. 基于微服 ...

- (转)在Kubernetes集群中使用JMeter对Company示例进行压力测试

背景 压力测试是评估应用性能的一种有效手段.此外,越来越多的应用被拆分为多个微服务而每个微服务的性能不一,有的微服务是计算密集型,有的是IO密集型. 因此,压力测试在基于微服务架构的网络应用中扮演着越 ...

随机推荐

- 四则运算APP版

(一)四则运算APP版 这这个Demo的目的就是强化一下本周学习的Android的Jetpack里的新内容,接下来我将通过这个Demo来展示我所学到的新知识. 先列出新学到的知识:ViewModel, ...

- 贪心-谷歌-857. 雇佣 K 名工人的最低成本

2020-03-15 22:00:39 问题描述: 有 N 名工人. 第 i 名工人的工作质量为 quality[i] ,其最低期望工资为 wage[i] . 现在我们想雇佣 K 名工人组成一个工资组 ...

- vs编译器中不允许使用scanf()的情况

问题1描述: vs编译器中,不允许使用scanf()函数. error C4996: 'scanf': This function or variable may be unsafe. Conside ...

- Spring中的设计模式:模板模式

导读 模板模式在是Spring底层被广泛的应用,比如事务管理器的实现,JDBC模板的实现. 文章首发于作者的微信公众号[码猿技术专栏] 今天就来谈谈「什么是模板模式」.「模板模式的优缺点」.「模板模式 ...

- Otb_000_ElementUI 的 Drawer组件无法上下滚动没有滚动条

场景:当导航为侧边栏的时候,鼠标滚轮滑动的时候,以及移动端,均不可上下拖动,如果展开全部将影响操作. 解决办法: /*1.显示滚动条:当内容超出容器的时候,可以拖动:*/ .el-drawer__bo ...

- Java HashMap源码详解

Java数据结构-HashMap 目录 Java数据结构-HashMap 1. HashMap 1.1 HashMap介绍 1.1.1 HashMap介绍 1.1.2 HashMap继承图 1.2 H ...

- .NET Core项目部署到Linux(Centos7)(一)前言

目录 1.前言 2.环境和软件的准备 3.创建.NET Core API项目 4.VMware Workstation虚拟机及Centos 7安装 5.Centos 7安装.NET Core环境 6. ...

- 从String 聊源码解读

@ 目录 源码实现 构造方法 equals 其他方法 常见面试题 你真的了解String吗?之前一篇博客写jvm时,就觉得String可以单独拎出来写一篇博客,毕竟几乎所有的面试都是以String开始 ...

- Linux 磁盘管理篇,开机挂载

设置开机挂载需要到 /etc/fstab 里设置 第一列:磁盘设备文件名或该设备的label 第二列:挂载点 第三列:磁盘分区文件系统 第四列:文件系统参数 第五列:能否被dump备份命令作用 第六列 ...

- redis 非关系型数据库

redis 类型,数据存在磁盘里面,所以存储速度比较快,其他数据类型还是存储在数据库所以比较慢些 链接redis数据库: r=redis.Redis(host="%%%%%%%", ...