Hadoop、Spark 集群环境搭建问题汇总

Hadoop

问题1:

Hadoop Slave节点 NodeManager 无法启动

解决方法:

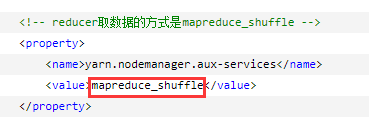

yarn-site.xml

reducer取数据的方式是mapreduce_shuffle

问题2:

启动hadoop,报错Error JAVA_HOME is not set and could not be found

解决方法:

因为JAVA_HOME环境没配置正确,还有一种情况是即使各结点都正确地配置了JAVA_HOME,但在集群环境下还是报该错误。

解决方法是 在 hadoop-env.sh中 显示地重新声明一遍JAVA_HOME。

问题3:

hadoop 执行start-dfs.sh后,datenode没有启动

解决方法:

上网查了下,有些文章说的解决办法是删掉数据文件,格式化,重启集群,但这办法实在太暴力,根本无法在生产环境实施,所以还是参考另一类文章的解决办法,修改clusterID:

step1:

查看hdfs-site.xml,找到存namenode元数据和datanode元数据的路径:

step2:

打开namenode路径下的current/VERSION文件

打开datanode路径下的current/VERSION文件

step3:

将data节点的 clusterID 修改成和 name 节点的 clusterID 一致,重启集群即可。

Spark

问题1:

Spark 集群启动后,Slave节点 Worker 进程一段时间后自动结束

解决方法:

修改各节点 /etc/hostname 文件中的主机名:

与 /etc/sysconfig/network 中的主机名保持一致。

重启机器。

问题2:

Spark只启动了Master,Worker没启动

解决方法:

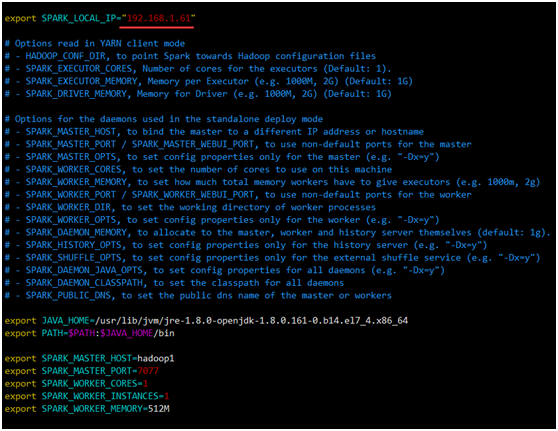

各节点 /home/hadoop/spark-2.2.1/conf/ spark-env.sh 中的 SPARK_LOCAL_IP 改为该节点自己的 IP。

问题3:

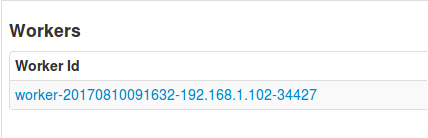

Spark集群启动后,Slave节点上有Worker进程,但打开webui,Workers列表却只显示有Master节点

解决方法:

关闭机器的防火墙

CentOS 7 默认采用新防火墙firewall,不再用iptables(service iptables status 查看防火墙状态 ,chkconfig iptables off 关闭防火墙)

systemctl stop firewalld.service #停止firewall systemctl disable firewalld.service #禁止firewall开机启动 firewall-cmd --state #查看默认防火墙状态(关闭后显示notrunning,开启后显示running)

问题4:

Spark shell退出操作以及出现问题的解决方法

解决方法:

退出的正确操作是:

:quit

Hadoop、Spark 集群环境搭建问题汇总的更多相关文章

- Hadoop+Spark:集群环境搭建

环境准备: 在虚拟机下,大家三台Linux ubuntu 14.04 server x64 系统(下载地址:http://releases.ubuntu.com/14.04.2/ubuntu-14.0 ...

- Spark集群环境搭建——Hadoop集群环境搭建

Spark其实是Hadoop生态圈的一部分,需要用到Hadoop的HDFS.YARN等组件. 为了方便我们的使用,Spark官方已经为我们将Hadoop与scala组件集成到spark里的安装包,解压 ...

- Spark 集群环境搭建

思路: ①先在主机s0上安装Scala和Spark,然后复制到其它两台主机s1.s2 ②分别配置三台主机环境变量,并使用source命令使之立即生效 主机映射信息如下: 192.168.32.100 ...

- Spark集群环境搭建——部署Spark集群

在前面我们已经准备了三台服务器,并做好初始化,配置好jdk与免密登录等.并且已经安装好了hadoop集群. 如果还没有配置好的,参考我前面两篇博客: Spark集群环境搭建--服务器环境初始化:htt ...

- Spark集群环境搭建——服务器环境初始化

Spark也是属于Hadoop生态圈的一部分,需要用到Hadoop框架里的HDFS存储和YARN调度,可以用Spark来替换MR做分布式计算引擎. 接下来,讲解一下spark集群环境的搭建部署. 一. ...

- Hadoop、Spark 集群环境搭建

1.基础环境搭建 1.1运行环境说明 1.1.1硬软件环境 主机操作系统:Windows 64位,四核8线程,主频3.2G,8G内存 虚拟软件:VMware Workstation Pro 虚拟机操作 ...

- Hadoop,HBase集群环境搭建的问题集锦(四)

21.Schema.xml和solrconfig.xml配置文件里參数说明: 參考资料:http://www.hipony.com/post-610.html 22.执行时报错: 23., /comm ...

- hadoop分布式集群环境搭建

参考 http://www.cnblogs.com/zhijianliutang/p/5736103.html 1 wget http://mirrors.shu.edu.cn/apache/hado ...

- Hadoop,HBase集群环境搭建的问题集锦(二)

10.艾玛, Datanode也启动不了了? 找到log: Caused by: java.net.UnknownHostException: Invalid host name: local hos ...

随机推荐

- 上海交大ACM总教头俞勇讲述“最聪明人的故事”

这是一场世界大学生之间"最强大脑"的较量:这是拥有数十年历史的ACM国际大学生计算机程序设计大赛的赛场:斯坦福.加州理工.麻省理工.哈佛--当一个又一个在计算机科学领域拥有世界顶尖 ...

- BZOJ5207 : [Jsoi2017]隧道

若$\min(n,m)<\min(n+1,m-1)$,则考虑计算左边与右边不连通的概率,然后用$1$减去它得到答案. 若$\min(n,m)\geq \min(n+1,m-1)$,则考虑计算对偶 ...

- java.lang.NoSuchMethodException: .<init>()

严重: Servlet.service() for servlet [springmvc] in context with path [/SpringMvc-1] threw exception [R ...

- UE4入门(三)

- vmware提示请卸载干净再重新安装的解决办法

结论:删掉 HKEY_LOCAL_MACHINE\\SOFTWARE\Wow6432Node\VMware, Inc. 就可以了. ----------------------------- ...

- jmeter接口测试实例5-文件上传

Jmeter实例5:文件上传 添加http协议.添加IP.路径.方法.选择files upload文件名称tab,输入绝对路径,参数名称,运行: 上传成功

- Linux内存管理学习资料

下面是Linux内存管理学习的一些资料. 博客 mlock() and mlockall() system calls. All about Linux swap space 逆向映射的演进 Linu ...

- Spring quartz 单机、集群+websocket集群实现文本、图片、声音、文件下载及推送、接收及显示

相关环境 Nginx,Spring5.x当前(要选择4.0+),tomcat9.x或8.x都可以,Quartz 2.x集群(实际运用是Quartz的集群模式和单机模式共存的) 测试面页:http:// ...

- x264阅读记录-3

14. x264_macroblock_encode函数-1 这个函数主要根据已经选定的模式来对宏块残差进行编码. )如果是P_SKIP模式,那么调用x264_macroblock_encode_ ...

- Android的Databinding-数据、Map绑定

本节主要说Collection的字符串数组.List.SparseArray.Map的绑定.先看看xml的布局. <layout xmlns:android="http://schem ...