R语言-Kindle特价书爬榜示例 & 输出HTML小技巧

20170209更新:

根据回复提示,rvest包更新,原用函数html作废,需改用read_html

并后续amazon网页改版等

因此此文章代码失效!各位可看评论内容了解详情

等以后有空再重写一遍代码,抱歉。果然代码还是放在github上好啊。。。。

----------------------------------

博客总目录:http://www.cnblogs.com/weibaar/p/4507801.html

----

自从买了kindle以后,总是想要定期刷有没有便宜的书,amazon经常有些1元/2元的书打特价,但是每次都去刷那些榜单太麻烦了,而且榜单又不能按照价格排名,捞书有点累

所以自己用R语言的rvest包简单写了一个小程序,让它自动按照不同价格区间把特价书给分出来。

主要看的是kindle新品排行榜和最快畅销榜。

销售爬升最快榜: http://www.amazon.cn/gp/movers-and-shakers/digital-text/

新品榜: http://www.amazon.cn/gp/new-releases/digital-text/

不在博客园上阅读时才会看到的,这篇博文归http://www.cnblogs.com/weibaar 所有

仅保证在博客园博客上的排版干净利索还有代码块与图片正确显示,他站请保留作者信息尊重版权啊

需要预先安装data.table / dplyr / rvest包。

代码如下

install.packages("rvest")

install.packages("data.table")

install.packages("dplyr")

主要分享点是:

1、Rvest的简单应用实例

2、如何把数据框(data.frame or table) 输出为html文件,即添加html脚本的方法

library(rvest)

library(data.table)

library(dplyr)

#这里是导入网址。研究一下amazon的顺序,直接导入就好

id<-1:5

url_increase_fast<-paste0(

"http://www.amazon.cn/gp/movers-and-shakers/digital-text/ref=zg_bsms_digital-text_pg_",

id,

"?ie=UTF8&pg=",

id)

url_newest<-paste0(

"http://www.amazon.cn/gp/new-releases/digital-text/ref=zg_bsnr_digital-text_pg_",

id,

"?ie=UTF8&pg=",

id)

url<-c(url_increase_fast,url_newest)

#这里编写readdata函数,读取网页内容。里面有些不常用的字段,为了最后导出效果好看,我没全部都导。

#有额外需要的可以自己改编,譬如分类啊,好评率啊等等。对我来说,知道价格、书名就够了

readdata<-function(i){

web<-html(url[i],encoding="UTF-8")

title<-web %>% html_nodes("div.zg_title") %>% html_text()

title_short<-substr(title,1,20)

price<-as.numeric(gsub("¥ ","",web %>% html_nodes("div.zg_itemPriceBlock_normal strong.price") %>% html_text()))

ranking_movement<-web %>% html_nodes("span.zg_salesMovement") %>% html_text()

rank_number<-as.numeric(gsub("\\.","",web %>% html_nodes("span.zg_rankNumber") %>% html_text()))

#新书榜里没有销售变动记录,所以记为NA

if (length(ranking_movement)==0) {ranking_movement=rep(NA,20)

rank_number=rep(NA,20)}

link<-gsub("\\\n","",web %>% html_nodes("div.zg_title a") %>% html_attr("href"))

ASIN<-sapply(strsplit(link,split = "/dp/"),function(e)e[2])

img<-web %>% html_nodes("div.zg_itemImage_normal img") %>% html_attr("src")

#这里加上html代码

img_link<-paste0("<img src='",img,"'>")

title_link<-paste0("<a href='",link,"'>",title_short,"</a>")

#合并数据

combine<-data.table(img_link,title_link,price,ranking_movement)

setnames(combine,c("图像","书名","价格","销售变动"))

#以防被封IP,设为5秒跑一次数据。

Sys.sleep(5)

combine

} #做一个循坏开始跑数

final<-data.table()

for (i in 1:10){

final<-rbind(final,readdata(i))

print(i)

} #这里编写一个函数,把data.table转化为html_table#要点请查看w3school,table页,以<table>开始,表头是<th>,行与行之间是<tr>#主要就是sapply, apply,paste的应用啦……就是把数据框先加<td>,再加<tr>,最后外面套一层<table>

transfer_html_table<-function(rawdata){

title<-paste0("<th>",names(rawdata),"</th>")

content<-sapply(rawdata,function(e)paste0("<td>",e,"</td>"))

content<-apply(content,1,function(e) paste0(e,collapse = ""))

content<-paste0("<tr>",content,"</tr>")

bbb<-c("<table border=1><tr>",title,"</tr>",content,"</table>")

bbb

}

#这里应用transfer_html_table函数,把榜单输出为html表格

final_less1<-transfer_html_table(rawdata=final %>% filter(价格<=1))

write(final_less1,"~//Kindle-低于1元特价书.html") final_1_2<-transfer_html_table(rawdata=final %>% filter(价格>1 & 价格<=2))

write(final_1_2,"~//Kindle_1-2元特价书.html") final_2_5<-transfer_html_table(rawdata=final %>% filter(价格>2 & 价格<=5))

write(final_2_5,"~//Kindle_2-5元特价书.html")

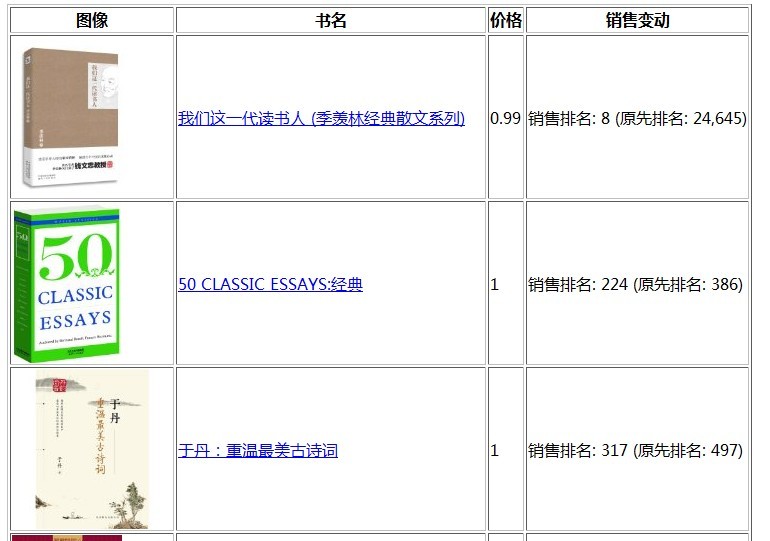

最后在我的文档("~//"表示定位到我的文档那里)会找到三个HTML文件,打开来,大概长下面这个样子,于是就可以很愉悦得选书了。Kindle时不时会把一些好书1元贱卖的~~所以有了kindle经常手贱,有这个小脚本之后我觉得我会更加手贱买书了。。。

如果大家有兴趣,还可以去搜一下R语言批处理、自动运行等文章来看,把这个代码设为定期跑一下,然后让结果能够累计保存。那么以后就知道kindle商城在什么时候调价最多了。 amazon还是比较容易爬虫的,它html页面内代码很规范整洁,除了在产品详情页里,产品描述(product description)总是被脚本保护起来,比较难爬。

不在博客园上阅读时才会看到的,这篇博文归http://www.cnblogs.com/weibaar 所有

仅保证在博客园博客上的排版干净利索还有代码块与图片正确显示,他站请保留作者信息尊重版权啊

以及最近开始学python了!

大牛分享了一个很好用的python IDE,叫做ANACONDA,里面那个spyder的IDE真的做的很棒~~跟rstudio有的一拼~ 而且ANACONDA集成了python 2.7,都不用单独下python了~~

然后github上有两个教程写的还蛮不错的

1、 python入门

https://github.com/qiwsir/StarterLearningPython

2、python爬虫101个示例(基于python 3)

https://github.com/compjour/search-script-scrape

R语言-Kindle特价书爬榜示例 & 输出HTML小技巧的更多相关文章

- R语言-Kindle特价书爬榜示例 & 输出HTML小技巧(转)

自从买了kindle以后,总是想要定期刷有没有便宜的书,amazon经常有些1元/2元的书打特价,但是每次都去刷那些榜单太麻烦了,而且榜单又不能按照价格排名,捞书有点累 所以自己用R语言的rvest包 ...

- 【Scrapy(四)】scrapy 分页爬取以及xapth使用小技巧

scrapy 分页爬取以及xapth使用小技巧 这里以爬取www.javaquan.com为例: 1.构建出下一页的url: 很显然通过dom树,可以发现下一页所在的a标签 2.使用scrapy的 ...

- R语言进行文件夹操作示例(转)

rm(list=ls())path = 'J:/lab/EX29 --在R语言中进行文件(夹)操作'setwd(path)cat("file A\n", file="A& ...

- 【R语言系列】作图入门示例一

假设有如下数据,我们使用plot函数作图 月龄 体重 月龄 体重 1 4.4 9 7.3 3 5.3 3 6.0 5 7.2 9 10.4 2 5.2 12 10.2 11 8.5 3 6.1 R语 ...

- R语言爬虫:爬取百度百科词条

抓取目标:抓取花儿与少年的百度百科中成员信息 url <- "http://baike.baidu.com/item/%E8%8A%B1%E5%84%BF%E4%B8%8E%E5%B0 ...

- R语言爬虫:爬取包含所有R包的名称及介绍

第一种方法 library("rvest") page <- read_html("https://cran.rstudio.com/web/packages/av ...

- R语言重要数据集分析研究—— 数据集本身的分析技巧

数据集本身的分析技巧 作者:王立敏 文章来源:网络 1.数据集 数据集,又称为资料集.数据集合或资料集合,是一种由数据所组成的集合. Data set(或dat ...

- windows核心编程 第5章job lab示例程序 解决小技巧

看到windows核心编程 第5章的最后一节,发现job lab例子程序不能在我的系统(win8下)正常运行,总是提示“进程在一个作业里” 用process explorer程序查看 ...

- R语言:用简单的文本处理方法优化我们的读书体验

博客总目录:http://www.cnblogs.com/weibaar/p/4507801.html 前言 延续之前的用R语言读琅琊榜小说,继续讲一下利用R语言做一些简单的文本处理.分词的事情.其实 ...

随机推荐

- 跨云应用部署第一步:使用IPSEC VPN连接AWS中国版和Windows Azure中国版

随着公有云的普及,越来越多的客户将关键应用迁移到云端.但是事实证明,没有哪家云服务提供商可以提供100%的SLA,无论是例行维护还是意外中断服务,对于客户的关键应用而言,都会受到不同程度的影响.此外, ...

- js获取键盘按下的键值event.keyCode,event.charCode,event.which的兼容性

js获取键盘按下的键值有event.keyCode,event.charCode和event.which 其中: 谷歌浏览器对event.keyCode,event.charCode和event.wh ...

- Android UI控件----ExpandableListView的基本用法

ExpandableListView介绍 ExpandableListView的引入 ExpandableListView可以显示一个视图垂直滚动显示两级列表中的条目,这不同于列表视图(ListVie ...

- Intellij IDEA 自动生成 serialVersionUID

转 Intellij IDEA 自动生成 serialVersionUID 收藏 tonycody 发表于 2年前 阅读 18399 收藏 5 点赞 2 评论 0 使用 Eclipse 或 MyEcl ...

- angular学习笔记(二十九)-$q服务

angular中的$q是用来处理异步的(主要当然是http交互啦~). $q采用的是promise式的异步编程.什么是promise异步编程呢? 异步编程最重要的核心就是回调,因为有回调函数,所以才构 ...

- linux 下 sudo 指令不需要输入密码的配置

sudo的配置文件位于 /etc/sudoers 里面.具体操作如下: 打开sudoers文件. bo@engineer ~/ $ sudo nano /etc/sudoers 假定你的用户名为 m ...

- sql server 导出表结构到 word

------导出表结构语句1.执行以下查询 SELECT 表名 = case when a.colorder=1 then d.name else '' end, 表说明 ...

- 基于xml的Spring多数据源配置和使用

上一篇讲了<基于注解的Spring多数据源配置和使用>,通过在类或者方法上添加@DataSource注解就可以指定某个数据源.这种方式的优点是控制粒度细,也更灵活. 但是当有些时候项目分模 ...

- 最新版CentOS6.5上安装部署ASP.NET MVC4和WebApi

最新版CentOS6.5上安装部署ASP.NET MVC4和WebApi 使用Jexus5.8.1独立版 http://www.linuxdot.net/ ps:该“独立版”支持64位的CentOS ...

- 网站哀悼变灰代码集合 兼容所有浏览器的CSS变暗代码

下面这些CSS代码可以把网站的网页变为黑白,只需将代码加到CSS文件或网页最顶端就可以实现素装.建议全国站长动起来.为遇难的同胞哀悼. 如何将网站变成灰色调呢,网站变灰色方法是什么?有哪些?为了方便大 ...