mapreduce 实现矩阵乘法

import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.input.FileSplit;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class MatrixMultiply {

/** mapper和reducer需要的三个必要变量,由conf.get()方法得到 **/

public static int rowM = 0;

public static int columnM = 0;

public static int columnN = 0; public static class MatrixMapper extends Mapper<Object, Text, Text, Text> {

private Text map_key = new Text();

private Text map_value = new Text(); /**

* 执行map()函数前先由conf.get()得到main函数中提供的必要变量, 这也是MapReduce中共享变量的一种方式

*/

public void setup(Context context) throws IOException {

Configuration conf = context.getConfiguration();

columnN = Integer.parseInt(conf.get("columnN"));

rowM = Integer.parseInt(conf.get("rowM"));

} public void map(Object key, Text value, Context context)

throws IOException, InterruptedException {

/** 得到输入文件名,从而区分输入矩阵M和N **/

FileSplit fileSplit = (FileSplit) context.getInputSplit();

String fileName = fileSplit.getPath().getName(); if (fileName.contains("M")) {

String[] tuple = value.toString().split(",");

int i = Integer.parseInt(tuple[0]);

String[] tuples = tuple[1].split("\t");

int j = Integer.parseInt(tuples[0]);

int Mij = Integer.parseInt(tuples[1]); for (int k = 1; k < columnN + 1; k++) {

map_key.set(i + "," + k);

map_value.set("M" + "," + j + "," + Mij);

context.write(map_key, map_value);

}

} else if (fileName.contains("N")) {

String[] tuple = value.toString().split(",");

int j = Integer.parseInt(tuple[0]);

String[] tuples = tuple[1].split("\t");

int k = Integer.parseInt(tuples[0]);

int Njk = Integer.parseInt(tuples[1]); for (int i = 1; i < rowM + 1; i++) {

map_key.set(i + "," + k);

map_value.set("N" + "," + j + "," + Njk);

context.write(map_key, map_value);

}

}

}

} public static class MatrixReducer extends Reducer<Text, Text, Text, Text> {

private int sum = 0; public void setup(Context context) throws IOException {

Configuration conf = context.getConfiguration();

columnM = Integer.parseInt(conf.get("columnM"));

} public void reduce(Text key, Iterable<Text> values, Context context)

throws IOException, InterruptedException {

int[] M = new int[columnM + 1];

int[] N = new int[columnM + 1]; for (Text val : values) {

String[] tuple = val.toString().split(",");

if (tuple[0].equals("M")) {

M[Integer.parseInt(tuple[1])] = Integer.parseInt(tuple[2]);

} else

N[Integer.parseInt(tuple[1])] = Integer.parseInt(tuple[2]);

} /** 根据j值,对M[j]和N[j]进行相乘累加得到乘积矩阵的数据 **/

for (int j = 1; j < columnM + 1; j++) {

sum += M[j] * N[j];

}

context.write(key, new Text(Integer.toString(sum)));

sum = 0;

}

} /**

* main函数

* <p>

* Usage:

*

* <p>

* <code>MatrixMultiply inputPathM inputPathN outputPath</code>

*

* <p>

* 从输入文件名称中得到矩阵M的行数和列数,以及矩阵N的列数,作为重要参数传递给mapper和reducer

*

* @param args 输入文件目录地址M和N以及输出目录地址

*

* @throws Exception

*/ public static void main(String[] args) throws Exception { if (args.length != 3) {

System.err

.println("Usage: MatrixMultiply <inputPathM> <inputPathN> <outputPath>");

System.exit(2);

} else {

String[] infoTupleM = args[0].split("_");

rowM = Integer.parseInt(infoTupleM[1]);

columnM = Integer.parseInt(infoTupleM[2]);

String[] infoTupleN = args[1].split("_");

columnN = Integer.parseInt(infoTupleN[2]);

} Configuration conf = new Configuration();

/** 设置三个全局共享变量 **/

conf.setInt("rowM", rowM);

conf.setInt("columnM", columnM);

conf.setInt("columnN", columnN); Job job = new Job(conf, "MatrixMultiply");

job.setJarByClass(MatrixMultiply.class);

job.setMapperClass(MatrixMapper.class);

job.setReducerClass(MatrixReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(Text.class);

FileInputFormat.setInputPaths(job, new Path(args[0]), new Path(args[1]));

FileOutputFormat.setOutputPath(job, new Path(args[2]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

mapreduce 实现矩阵乘法的更多相关文章

- 【甘道夫】MapReduce实现矩阵乘法--实现代码

之前写了一篇分析MapReduce实现矩阵乘法算法的文章: [甘道夫]Mapreduce实现矩阵乘法的算法思路 为了让大家更直观的了解程序运行,今天编写了实现代码供大家參考. 编程环境: java v ...

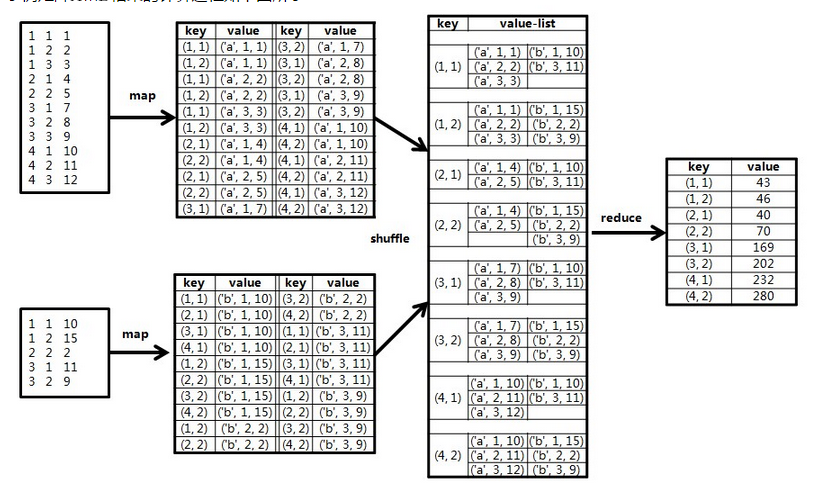

- MapReduce实现矩阵乘法

简单回想一下矩阵乘法: 矩阵乘法要求左矩阵的列数与右矩阵的行数相等.m×n的矩阵A,与n×p的矩阵B相乘,结果为m×p的矩阵C.具体内容能够查看:矩阵乘法. 为了方便描写叙述,先进行如果: 矩阵A的行 ...

- 基于MapReduce的矩阵乘法

参考:http://blog.csdn.net/xyilu/article/details/9066973文章 文字未得及得总结,明天再写文字,先贴代码 package matrix; import ...

- Python+MapReduce实现矩阵相乘

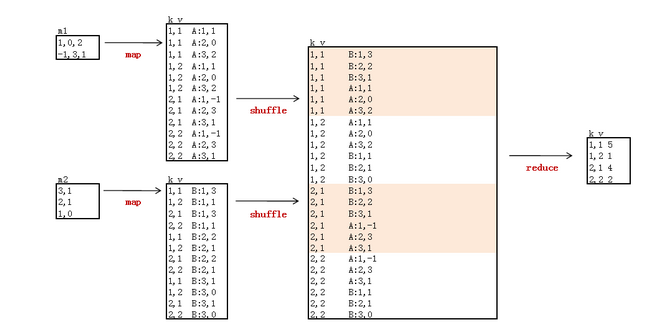

算法原理 map阶段 在map阶段,需要做的是进行数据准备.把来自矩阵A的元素aij,标识成p条<key, value>的形式,key="i,k",(其中k=1,2,. ...

- 矩阵乘法的MapReduce实现

对于任意矩阵M和N,若矩阵M的列数等于矩阵N的行数,则记M和N的乘积为P=M*N,其中mik 记做矩阵M的第i行和第k列,nkj记做矩阵N的第k行和第j列,则矩阵P中,第i行第j列的元素可表示为公式( ...

- MapReduce实现大矩阵乘法

来自:http://blog.csdn.net/xyilu/article/details/9066973 引言 何 为大矩阵?Excel.SPSS,甚至SAS处理不了或者处理起来非常困难,需要设计巧 ...

- MapReduce的矩阵相乘

一.单个mapreduce的实现 转自:http://blog.sina.com.cn/s/blog_62186b460101ai1x.html 王斌_ICTIR老师的<大数据:互联网大规模数据 ...

- *HDU2254 矩阵乘法

奥运 Time Limit: 1000/1000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others)Total Submissi ...

- *HDU 1757 矩阵乘法

A Simple Math Problem Time Limit: 3000/1000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Ot ...

随机推荐

- BI中PowerDesigner建模

PowerDesigner下载: http://pan.baidu.com/share/link?shareid=296749&uk=1479845243

- MSP下载方式

MSP430无论是仿真还是烧写程序,一般可以通过:JTAG.SBW.BSL接口进行. 1.JTAG是利用边界扫描技术,在430内部有逻辑接口给JTAG使用,内部有若干个寄存器连接到了430内部数据地址 ...

- Table of Contents - HttpClient

HttpClient 4.3.5 Getting Started HttpClient 简单示例 Fundamentals Request Execution HTTP Request & H ...

- 每天一道LeetCode--409 .Longest Palindrome

Given a string which consists of lowercase or uppercase letters, find the length of the longest pali ...

- view, surfaceView, invalidate, postInvalidate, 刷新屏幕

http://blog.csdn.net/linghu_java/article/details/9985489 1.view view在api中的结构 Java.lang.Object Androi ...

- 第六十八篇、OC_按照某一字段对数值进行排序

代码中是根据"create_time_" 进行排序 ascending:决定的是升序还是降序排序 NSSortDescriptor *sortDescriptor = [[NS ...

- Swift 概述及Swift运算符和表达式

Swift 是用于设计 iOS 及 Mac OS X 应用的一门新 语言. Swift 特点 • Swift 保留了 C 与 Objective-C 的优点,并摒弃 其为了兼容 C 语言所 ...

- 对App数据库元素进行简单的设计

假如对<豆瓣>进行简单的数据库元素设计; 分析页面: 简单的豆瓣一共有以下页面{ 活动页面 活动详情页面 电影页面 电影详情页面 影院页面(一般不用到数据库,不及于数据库考虑) 我的{ 活 ...

- NSString字符操作

1.常用创建初始化方法 1.NSString *string0 = @"string"; 2.NSString *string1 = [NSString stringWithFor ...

- C# 谈Dictionary<TKey,TValue>,SortedDictionary<TKey,TValue>排序

使用过Dictionary的人都知道,当每一个Add里面的值都不会改变其顺序,所以需要需要对其排序的时候就用到SortedDictionary, 但SortedDictionary并不是那么理想,其默 ...