用python抓取求职网站信息

本次抓取的是智联招聘网站搜索“数据分析师”之后的信息。

python版本: python3.5。

我用的主要package是 Beautifulsoup + Requests+csv

另外,我将招聘内容的简单描述也抓取下来了。

文件输出到csv文件后,发现用excel打开时有些乱码,但用文件软件打开(如notepad++)是没有问题的。

为了能用Excel打开时正确显示,我用pandas转换了以下,并添加上列名。转化完后,就可以正确显示了。关于用pandas转化,可以参考我的博客:

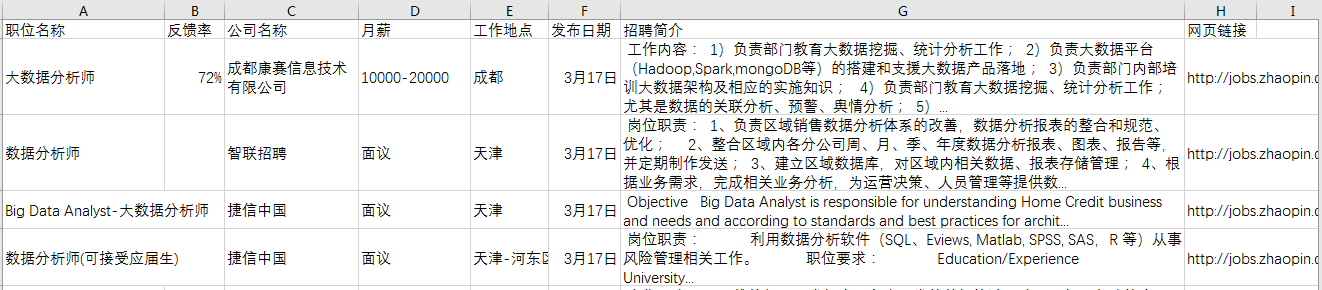

由于招聘内容的描述较多,最后将csv文件另存为excel文件,并调整下格式,以便于查看。

最后效果如下:

实现代码如下:信息爬取的代码如下:

# Code based on Python 3.x

# _*_ coding: utf-8 _*_

# __Author: "LEMON" from bs4 import BeautifulSoup

import requests

import csv def download(url):

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:51.0) Gecko/20100101 Firefox/51.0'}

req = requests.get(url, headers=headers)

return req.text def get_content(html):

soup = BeautifulSoup(html, 'lxml')

body = soup.body

data_main = body.find('div', {'class': 'newlist_list_content'})

tables = data_main.find_all('table') zw_list = []

for i,table in enumerate(tables):

if i == 0:

continue

temp = []

tds = table.find('tr').find_all('td')

zwmc = tds[0].find('a').get_text()

zw_link = tds[0].find('a').get('href')

fkl = tds[1].find('span').get_text()

gsmc = tds[2].find('a').get_text()

zwyx = tds[3].get_text()

gzdd = tds[4].get_text()

gbsj = tds[5].find('span').get_text() tr_brief = table.find('tr', {'class': 'newlist_tr_detail'})

brief = tr_brief.find('li', {'class': 'newlist_deatil_last'}).get_text() temp.append(zwmc)

temp.append(fkl)

temp.append(gsmc)

temp.append(zwyx)

temp.append(gzdd)

temp.append(gbsj)

temp.append(brief)

temp.append(zw_link) zw_list.append(temp)

return zw_list def write_data(data, name):

filename = name

with open(filename, 'a', newline='', encoding='utf-8') as f:

f_csv = csv.writer(f)

f_csv.writerows(data) if __name__ == '__main__': basic_url = 'http://sou.zhaopin.com/jobs/searchresult.ashx?jl=%E5%85%A8%E5%9B%BD&kw=%E6%95%B0%E6%8D%AE%E5%88%86%E6%9E%90%E5%B8%88&sm=0&p=' number_list = list(range(90)) # total number of page is 90

for number in number_list:

num = number + 1

url = basic_url + str(num)

filename = 'zhilian_DA.csv'

html = download(url)

# print(html)

data = get_content(html)

# print(data)

print('start saving page:', num)

write_data(data, filename)

用pandas转化的代码如下:

# Code based on Python 3.x

# _*_ coding: utf-8 _*_

# __Author: "LEMON" import pandas as pd df = pd.read_csv('zhilian_DA.csv', header=None) df.columns = ['职位名称', '反馈率', '公司名称', '月薪', '工作地点',

'发布日期', '招聘简介', '网页链接'] # 将调整后的dataframe文件输出到新的csv文件

df.to_csv('zhilian_DA_update.csv', index=False)

用python抓取求职网站信息的更多相关文章

- 使用python抓取美团商家信息

抓取美团商家信息 import requests from bs4 import BeautifulSoup import json url = 'http://bj.meituan.com/' ur ...

- Python抓取成都房价信息

Python里scrapy爬虫 scrapy爬虫,正好最近成都房价涨的厉害,于是想着去网上抓抓成都最近的房价情况,顺便了解一下,毕竟咱是成都人,得看看这成都的房子我以后买的起不~ 话不多说,进入正题: ...

- 无比强大!Python抓取cssmoban网站的模版并下载

Python实现抓取http://www.cssmoban.com/cssthemes网站的模版并下载 实现代码 # -*- coding: utf-8 -*- import urlparse imp ...

- python爬取电影网站信息

一.爬取前提1)本地安装了mysql数据库 5.6版本2)安装了Python 2.7 二.爬取内容 电影名称.电影简介.电影图片.电影下载链接 三.爬取逻辑1)进入电影网列表页, 针对列表的html内 ...

- python抓取贝壳房源信息

分析了贝壳的房源信息数据,发现地址链接的参数传递是有规律的 https://tj.ke.com/chengjiao/a3l4/ a3 实际表示的 l4 表示的是 然后 将复合条件拼成一个字符串,带过去 ...

- 抓取某网站信息时遇到的问题及解决 The character set provided in ContentType is invalid. Cannot read content as string using an invalid character set

var response = httpClient.SendAsync(requestMessage).Result; content = response.Content.ReadAsStringA ...

- Python爬虫实战---抓取图书馆借阅信息

Python爬虫实战---抓取图书馆借阅信息 原创作品,引用请表明出处:Python爬虫实战---抓取图书馆借阅信息 前段时间在图书馆借了很多书,借得多了就容易忘记每本书的应还日期,老是担心自己会违约 ...

- Python 抓取网页并提取信息(程序详解)

最近因项目需要用到python处理网页,因此学习相关知识.下面程序使用python抓取网页并提取信息,具体内容如下: #---------------------------------------- ...

- 用python抓取智联招聘信息并存入excel

用python抓取智联招聘信息并存入excel tags:python 智联招聘导出excel 引言:前一阵子是人们俗称的金三银四,跳槽的小朋友很多,我觉得每个人都应该给自己做一下规划,根据自己的进步 ...

随机推荐

- EFCore扩展:IQueryable(linq)或sql执行的查询缓存与清理

前言 上一篇讲述了执行sql和配置的一些功能,这篇说明IQueryable(linq)或执行sql的查询缓存与清理,包括扩展到将缓存存储到Redis中. 扩展类库源码: github:https:// ...

- 离职了,在家温故而知新----1 设计模式 & 开头

工作四年有余,编写的代码都是业务代码.不涉及低层. 目前离职在家,过年完了,准备找工作了. 决定温故而知新,复习也是学习. 本着随遇而安的原则,随便从之前设计的众多条目中选择了一条开始复习. 设计模式 ...

- (3)activiti流程的挂起和激活

有时候,我们需要对一个已经执行的流程进行暂停,而不是删除它,这个时候就需要我们调用activiti暂停和激活的api来操作他们 每启动一个流程实例,都会在该流程实例下产生相应的流程任务,处于1*多的关 ...

- R语言爬虫 rvest包 html_text()-html_nodes() 原理说明

library(rvest) 例子网页:http://search.51job.com/jobsearch/search_result.php?fromJs=1&jobarea=010000% ...

- 如何解决在chrome中自动完成表单后input出现黄色背景

可以对input:-webkit-autofill使用足够大的纯色内阴影来覆盖input输入框的黄色背景:如: 代码如下: input:-webkit-autofill { -webkit-box-s ...

- Javascript 闭包与高阶函数 ( 一 )

上个月,淡丶无欲 让我写一期关于 闭包 的随笔,其实惭愧,我对闭包也是略知一二 ,不能给出一个很好的解释,担心自己讲不出个所以然来. 所以带着学习的目的来写一写,如有错误,忘不吝赐教 . 为什么要有闭 ...

- 第一次AOP,附上使用DEMO,目前只供学习,不可用在生产环境

GIT代码地址:https://git.oschina.net/ruanjianfeng/Ruan.Framework.Core demo代码如下 public class ConsoleTimeAt ...

- js加密

在项目中,经常需要使用加密来保障数据的安全性,虽然可以通过在后台加密再传给前台,但这样无疑会增加后台的服务器的压力.所以在js中使用加密算法也就应运而生了. 一.base64加密 需要引入base64 ...

- 【图像浏览】FastStone Image Viewer——快速、小巧、功能强大

FastStone Image Viewer 是一款免费(非商业用途)且小巧的看图软件. 其在在appinn.com的我最喜爱的<图片/照片浏览查看工具>调查结果中排第6名(总提名 140 ...

- Javascript基本语句

1.单行语句是大家用的最多的,下面讲讲复合语句的用法. 用一对花括号括起来,处理的时候,可以用单句来对待.这样做的好处是避免复合语句中语句互相干扰执行. 语法如下: { var x=1111: var ...